李飞飞世界模型公司一年估值暴涨5倍!正洽谈新一轮5亿美元融资

李飞飞世界模型公司一年估值暴涨5倍!正洽谈新一轮5亿美元融资据彭博社消息:李飞飞创办的World Labs正在以约50亿美元估值进行新一轮融资,融资规模最高可达5亿美元。如果融资完成:World Labs的估值将从2024年的10亿美元,直接乘5到50亿美元。

据彭博社消息:李飞飞创办的World Labs正在以约50亿美元估值进行新一轮融资,融资规模最高可达5亿美元。如果融资完成:World Labs的估值将从2024年的10亿美元,直接乘5到50亿美元。

谷歌 DeepMind 发布 D4RT,彻底颠覆了动态 4D 重建范式。它抛弃了复杂的传统流水线,用一个统一的「时空查询」接口,同时搞定全像素追踪、深度估计与相机位姿。不仅精度屠榜,速度更比现有 SOTA 快出 300 倍。这是具身智能与自动驾驶以及 AR 的新基石,AI 终于能像人类一样,实时看懂这个流动的世界。

过去一年,AI圈的词语通货膨胀是不是有点太严重了?

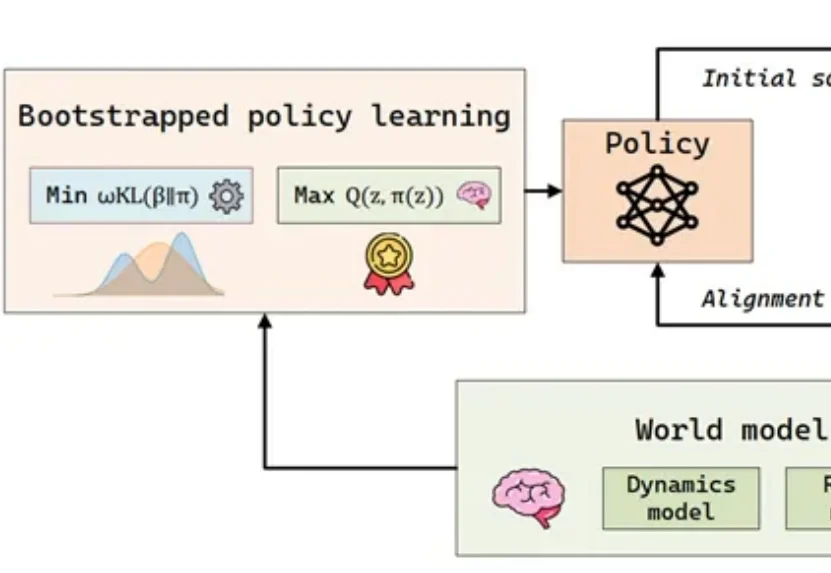

在具身智能(Embodied AI)的快速发展中,样本效率已成为制约智能体从实验室环境走向复杂开放世界的瓶颈问题。

最火世界模型,最火具身智能基建,联手了!

视频世界模型领域又迎来了新的突破!

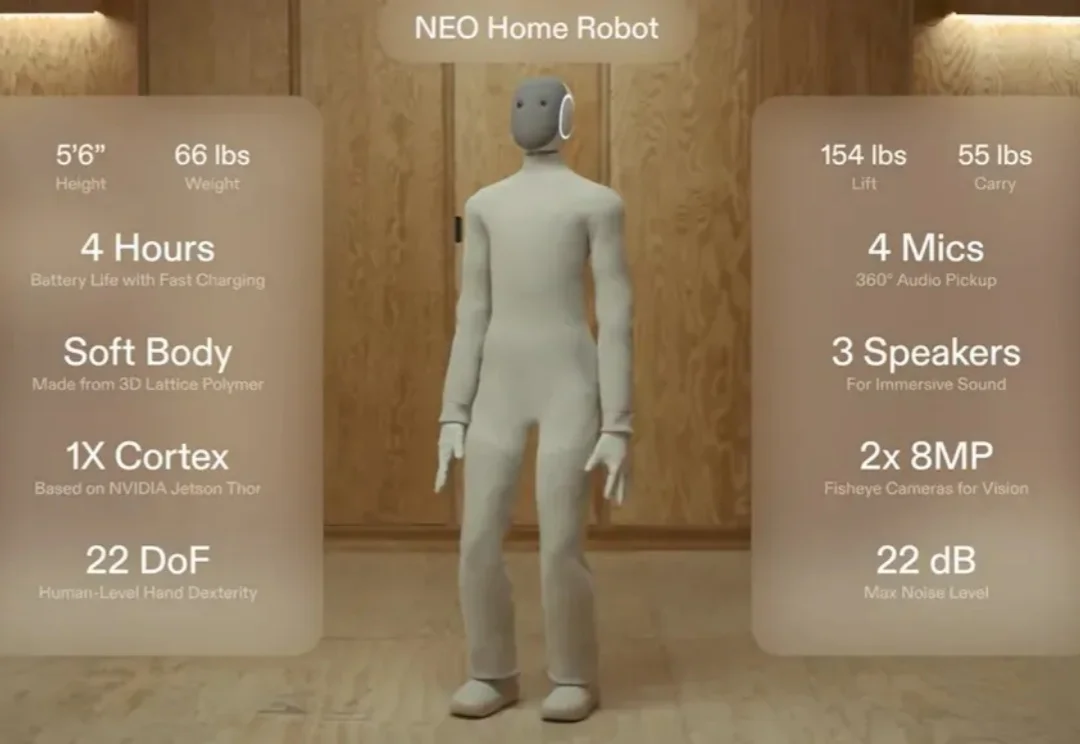

还记得那个穿着「Lululemon」紧身衣、主打温柔陪伴的家用人形机器人 NEO 吗?

昨晚夜里快12点,AI视频公司PixVerse毫无预兆的发了一个项目。PixVerse R1,下一代实时世界生成模型。这玩意你看文字,可能不是很好理解,我直接放一个官方的demo视频,大家的感觉应该会强一些。

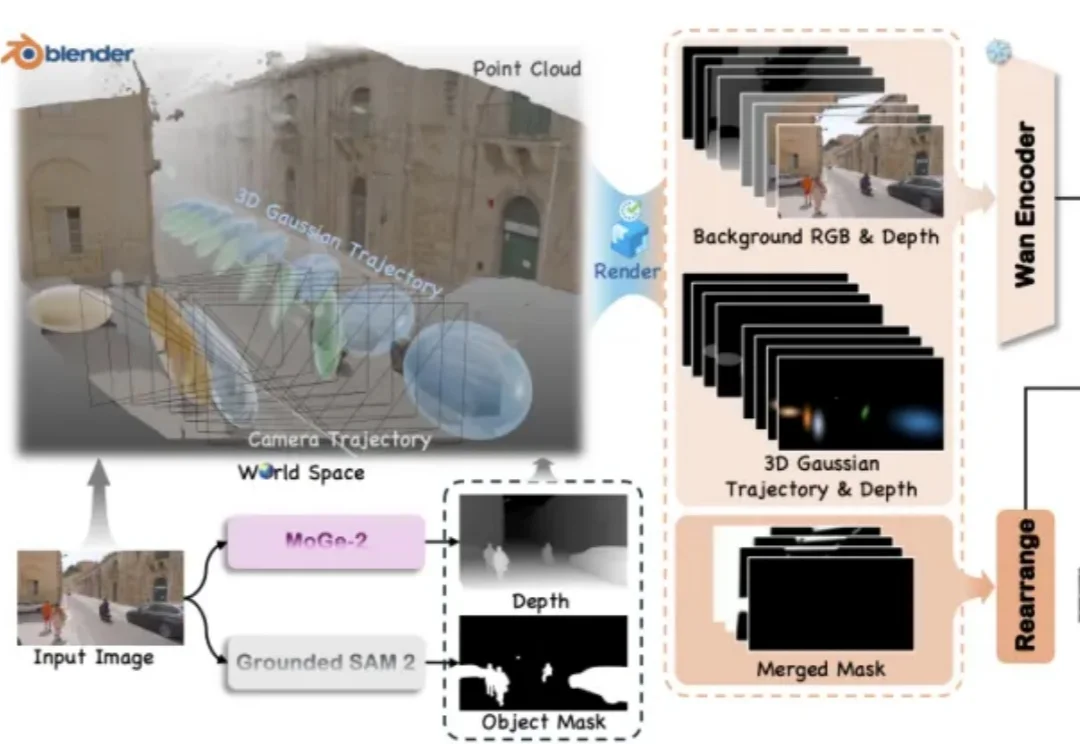

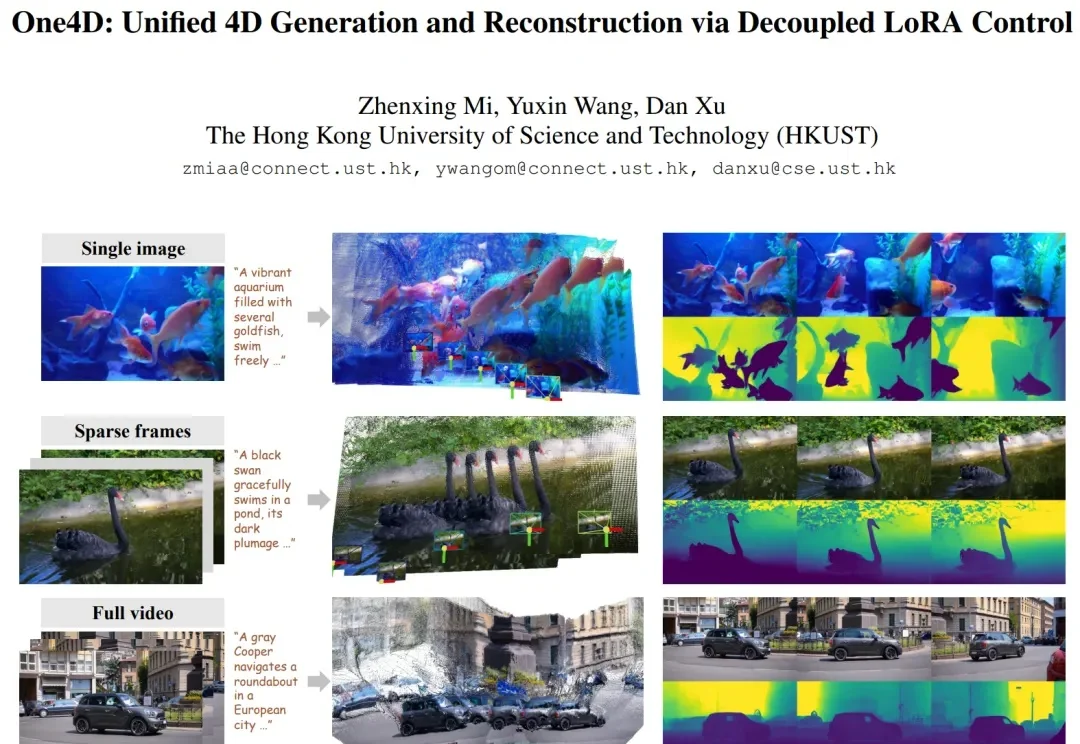

近年来,视频扩散模型在 “真实感、动态性、可控性” 上进展飞快,但它们大多仍停留在纯 RGB 空间。模型能生成好看的视频,却缺少对三维几何的显式建模。这让许多世界模型(world model)导向的应用(空间推理、具身智能、机器人、自动驾驶仿真等)难以落地,因为这些任务不仅需要像素,还需要完整地模拟 4D 世界。

英文达杰出科学家Jim Fan表示,我正全身心投入一个单一使命:为机器人解决「Physical Turing Test」(物理图灵测试)。 这是AI的下一个挑战,甚至可能是「终极挑战」。