谷歌DeepMind掌门人断言,2030年AGI必至!不过,在此之前,还差1-2个「Transformer级」核爆突破。恰在NeurIPS大会上,谷歌甩出下一代Transformer最强继任者——Titans架构。

2025年即将进入尾声,下一年AI将走向何方?

最近,谷歌DeepMind CEO Hassabis在一场访谈中,对未来12个月的「关键趋势」做出重磅预测。

划重点!!!主要有以下五大核心点——

Hassabis强调,我们应尽快Scaling现有的AI系统,至少它们会成为最终AGI的「关键部件」。

甚至,它可能会成为那个终极的AGI系统。

不过话说回来,我们至少还需要1-2个像Transformer、AlphaGo这样级别的突破才可以。

八年前,谷歌Transformer奠基之作出世,彻底改变了AI界。

如今,谷歌另一个极有潜力成为Transformer的全新架构——Titans,正式在NeurIPS 2025亮相。

它完美融合了「RNN极速响应+Transformer强大性能」,集两者之大成。

即便在200万token上下文中,Titans召回率和准确率最高。博客一出,在全网掀起了海啸级地震。

正如Hassabis所言,「颠覆性」AGI已近在眼前!

今年早些时候,Hassabis就曾预测,具备或超越人类能力的AGI,可能会在2030年之前实现。

在周四的公开对话中,Hassabis再度强调:

AGI很可能是人类历史上最具颠覆性的时刻之一,如今它正在加速逼近。

若要我给出一个时间,人类距离实现AGI仅剩下5到10年。

在谈及未来愿景时,Hassabis的声音饱含憧憬:

我一直以来最大的梦想、也是我奋斗一生的目标,是实现「丰饶时代」的理想社会。

一个人类面临的最大问题都已被解决的世界。

比如,免费的、可再生的清洁能源,也许人类解决了核聚变,或者造出了更优的电池、太阳能材料、半导体,在材料科学上取得突破;人类也攻克了许多疾病。

那样一来,人类将进入一个全新的时代,一个后稀缺时代,人类很可能繁荣发展,走向星空,将意识播撒到银河系。

但即使是那种乌托邦式的图景,也伴随着一些问题:如果这些技术能解决所有难题,那么我们人类存在的目的又是什么?还会剩下什么问题让我们去解决?

作为一个科学家,Hassabis为此感到担忧,甚至对科学方法本身也是如此。这是其一。

而通往AGI的道路注定不会一帆风顺。

Hassabis指出,恶人和错误使用AI的风险真实存在,甚至「灾难性后果」已开始显现。

比如,对能源或供水系统的网络攻击,这些都已经是显而易见的攻击目标。

也许,目前还没用上非常先进的AI,但这种事基本已经在发生了。

AI带来最严重的后果,可能是灭绝级风险。他强调,没人确切知道人类灭亡概率P(doom),但直言:

这个风险不是零。只要不是零,那就必须认真对待,投入资源应对。

Hassabis认为,最被低估的能力是Gemini能够「观看」视频并回答相关概念性问题。

他举例说,曾询问Gemini电影《搏击俱乐部》中的一个场景:

「打架前摘下了戒指,这个动作有什么象征意义?」

Gemini回答,这代表主角脱离日常生活的象征,是对社会规范的拒绝,是一种「放弃身份」的宣言。

Gemini的这类「抽象理解」能力出乎他的意料。Hassabis认为Gemini已经具备某种「元认知」。

还有另一个例子是Gemini Live功能。他认为,多模态AI的潜力,远比大多数人今天所理解的要大得多。

每次DeepMind推出新版模型时,Hassabis都会有种强烈的遗憾感:自己可能连这个系统的十分之一都没来得及深入测试,就已经要投入下一个版本的研发了。

而用户们往往会比Gemini开发人员更快地发掘新功能,把模型用到连他们都没想到的地方。

Hassabis最核心的观点可能是AGI的实现路径问题。

他认为,我们距离真正的AGI还有大约5到10年的时间。

DeepMind对AGI的定义要求很高:要称得上「通用」,AI系统必须全面具备人类的所有认知能力,其中包括「创造力」和「发明能力」。

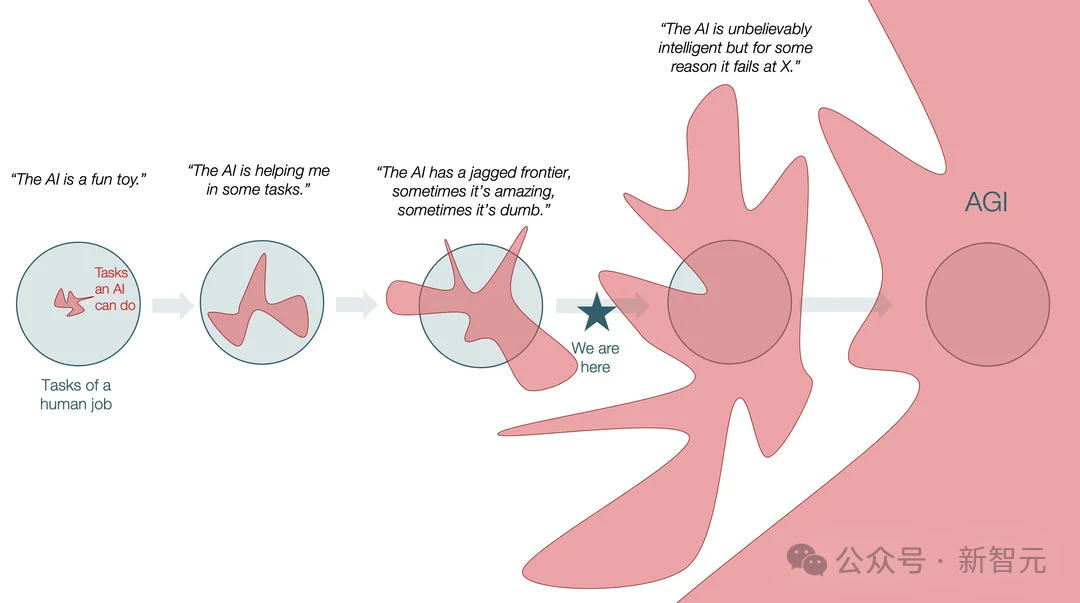

现在的LLM在某些领域已经非常惊艳,堪比博士水平,甚至能拿奥林匹克金牌;但在另外一些领域,它们仍然存在明显缺陷,呈现出「参差不齐」的智力表现。

真正的AGI应当拥有「各项能力均衡发展」的稳定智能。

这包括当前模型所缺失的几个关键能力:持续学习(continual learning)、在线学习(online learning)、长期规划和多步推理。

目前,大语言模型完全不具备这些能力。

他承认存在一种可能性,即规模扩展「可能就是AGI系统的全部」,尽管他认为这种情况可能性较小。

这需要我们必须将规模扩展推向绝对极限。

退一步说,规模扩展至少会成为最终AGI的「关键构件」。

Hassabis相信,它们未来会具备这些能力,但我们可能还需要一两个重大技术突破。

而谷歌似乎已经有了Transformer级的重大突破。

几天前,NeurIPS大会上一场对谈中,谷歌首席科学家Jeff Dean和AI教父Hinton同框。

关于LLM和研究路线,Hinton当场提出了一个尖锐的问题——

谷歌是否后悔发表Transformer论文?

Jeff Dean给出了干脆的回应:「不后悔!这项研究对世界产生了重大的影响」。

几乎同一时间,谷歌放出了全新的架构Titans,成为Transformer的最强继任者!

此外,还有一个全新的MIRAS框架。

两者的结合,可以让 AI模型在运行过程中动态更新核心记忆,跑得更快,也能处理超长规模的上下文。

众所周知,Transformer最大瓶颈在于,上下文无限扩展,会导致计算成本飙升。

除了业界迭代的RNN、Mamba-2等架构,谷歌也提出了新一代解决方案——

如上所述,Titans+MIRAS,就是一套把RNN速度和Transformer准确性,结合起来的架构与理论思路。

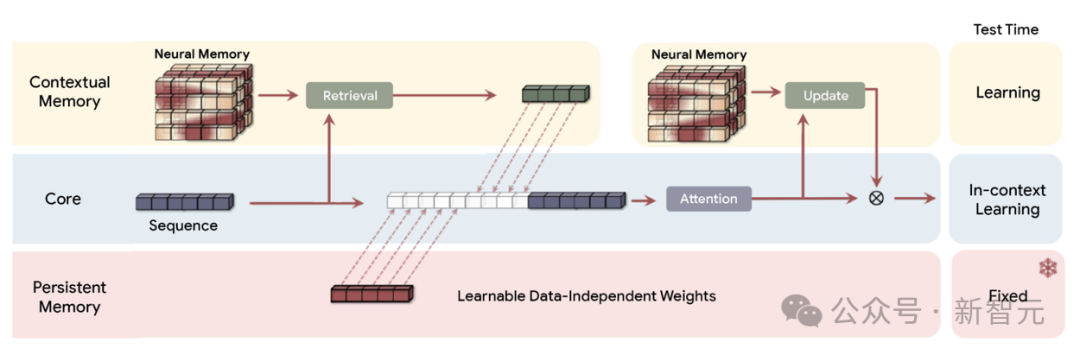

Titans(MAC)架构:通过一个长时记忆模块来压缩历史数据,并将生成的摘要加入当前上下文,再交由注意力机制处理

Titans是具体的模型架构(工具),而MIRAS 是用于泛化这些方法的理论框架(蓝图)。

它们合起来,实现了一种「测试时」记忆的能力。

在运行时,模型不再只是把信息压成一段静态状态,而是在数据不断输入时主动学习,即时更新自己的参数。

这个关键机制,可以让模型立刻把新的、具体的信息加入到核心知识里。

值得一提的是,清华姚班校友钟沛林参与了两项工作。他博士毕业于哥伦比亚大学,2021年起加入谷歌任研究科学家。

一个高效的学习系统,需要既独立又互相关联的「记忆模块」。

这一机制,就像人脑会将短期记忆和长期记忆区分开来一样。

为此,Titans引入了一种全新的神经长期记忆模块,本质上是一个深层神经网络(一个多层感知机MLP)。

它拥有更强的表达能力,在不丢失关键信息的同时,总结海量内容。

有了Titans,LLM不只是记笔记,而是在真正理解并串联整个故事。

论文地址:https://arxiv.org/pdf/2501.00663

更重要的是,Titans并非被动存储数据,而会主动学习如何识别并保留贯穿整个输入的重要关系和概念主题。

衡量这一能力的核心指标之一,谷歌将其称之为「惊奇度」(surprise metric)。

假设遇到「高惊奇」度的信息时,会被优先写入长期记忆。而且,会随着不断学习,自适应管理权重,主动遗忘不再需要的信息。

序列建模的每一次重大突破,本质上都在使用同一种底层机制:高度复杂的联想记忆模块。

MIRAS独到之处和实用价值在于,它看待AI建模的方式——

把各种架构视为解决同一个核心问题的「不同手段」。

如何在融合新信息与旧记忆的同时,不让关键概念被遗忘。

MIRAS框架

MIRAS通过四个关键设计维度,来定义序列模型:

以MIRAS框架的视角审视近期序列模型

几乎所有现行成功的序列模型,在处理偏置和保留机制时,都依赖于均方误差(MSE) 或点积相似度。这种依赖导致模型对异常值(outliers)过于敏感,并限制了其表达能力。

MIRAS突破了这一局限。

借鉴优化理论与统计学文献,它构建了一个生成式框架,开拓了更丰富的设计空间。

基于MIRAS,谷歌构建了三款独特的无注意力(Attention-free)模型:

在语言建模和常识推理任务中,Titans架构在同等规模下,优于最先进的线性循环模型(如Mamba-2和Gated DeltaNet)以及Transformer++基线模型。

新颖的MIRAS变体(MONETA、YAAD、MEMORA)相比这些基线模型也提升了性能,验证了探索稳健的非MSE优化机制的优势。

重要的是,这些模型保持了高效的并行化训练和快速的线性推理速度。

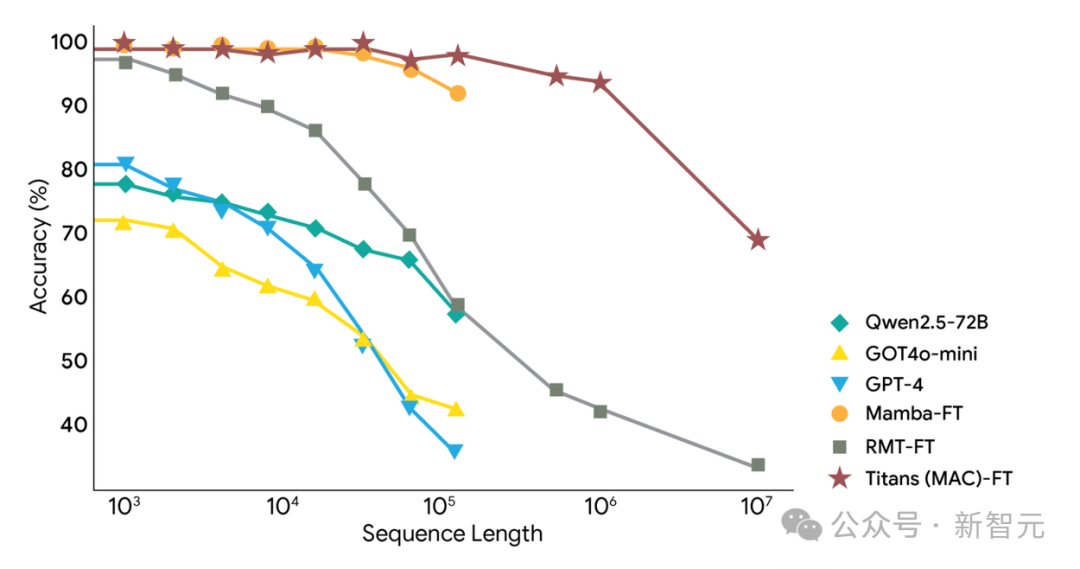

这些新架构最显著的优势在于其处理超长上下文的能力。

这在BABILong基准测试中得到突出体现,该任务需要对分布在超长文档中的事实进行推理。

在BABILong基准上,Titans以更少的参数量,表现优于包括GPT-4等超大型模型在内的所有基线模型。

Titans进一步展示了可有效扩展到超过200万token上下文窗口的能力。

Titans在超长上下文推理任务上的性能表现

有Reddit网友预测,或许我们在明天,就可以看到采用Titans架构的Gemini 4。

正如网友所言,这可能是谷歌继Transformer之后,首个重大突破!

在架构层面,Titans+MIRAS补上了「记忆与持续学习」。

而在多模态能力层面,Gemini显露「元认知」的边缘形态。

也许,AGI正加速到来。

参考资料:

https://www.youtube.com/watch?v=tDSDR7QILLg&t=11s

https://x.com/kimmonismus/status/1997026763353022647

https://x.com/DataChaz/status/1997211176422482341?s=20

https://research.google/blog/titans-miras-helping-ai-have-long-term-memory/

https://www.axios.com/2025/12/05/ai-deepmind-gemini-agi

文章来自于“新智元”,作者 “KingHZ 桃子”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】DeepBI是一款AI原生的数据分析平台。DeepBI充分利用大语言模型的能力来探索、查询、可视化和共享来自任何数据源的数据。用户可以使用DeepBI洞察数据并做出数据驱动的决策。

项目地址:https://github.com/DeepInsight-AI/DeepBI?tab=readme-ov-file

本地安装:https://www.deepbi.com/

【开源免费】airda(Air Data Agent)是面向数据分析的AI智能体,能够理解数据开发和数据分析需求、根据用户需要让数据可视化。

项目地址:https://github.com/hitsz-ids/airda

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI