翻车是真的,希望也是真的。

香港中文大学的一处山间小道,流水小桥,树影斑驳,青苔攀附在陡峭连绵的石梯上。

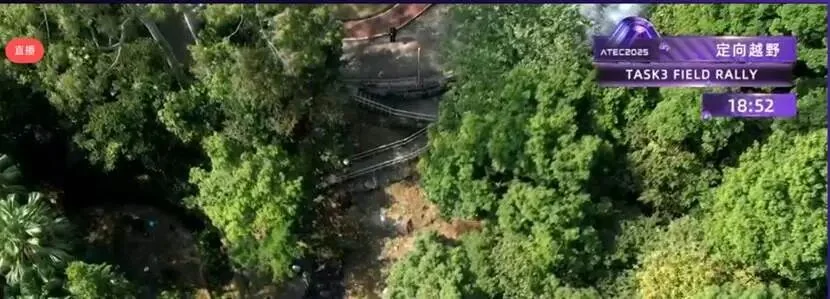

无人机视野下500 米的定向越野路线。

一只人形机器人跨过三十度的小桥,走上一段石路,迈过两段台阶。好不容易来到一个九十度的弯,重心一歪,仰面倒下。

全程 500 米的定向越野,它只能走完开头。

到了90度分叉路口,就躺平罢工。

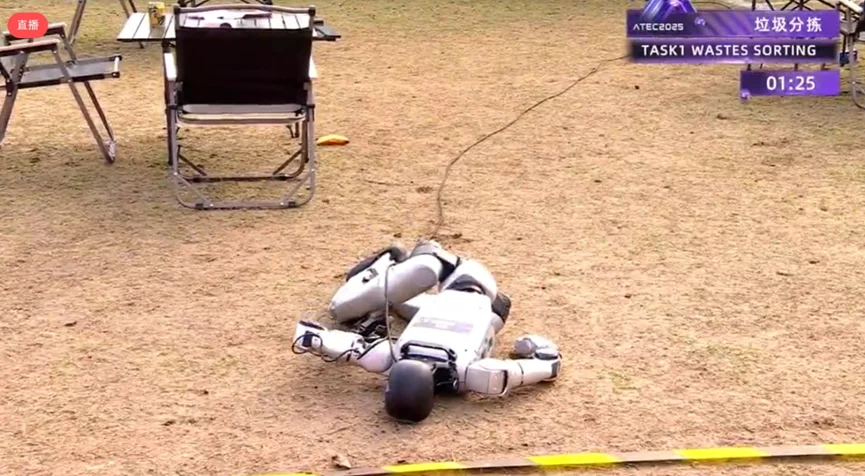

第二天,它又出现在大学的岭南体育场,尝试户外分拣垃圾。

草地秃噜,每一步都像踩进人生陷阱,还没碰到桌上的垃圾,就扑通倒地。

在第五届 ATEC 科技精英赛——全球首个全自主、全真实户外场景的机器人竞技场上,类似画面不断上演。离开遥控器、走到户外,机器人还能不能工作?

其实,跳舞、空翻、端咖啡,这些「展台神迹」从来不是真实水平。离开温室和遥控器,一块秃草地、一只普通水壶就能瞬间「放倒」它们。

1X NEO,别说让它亲手洗碗了,就连把干干净净的锅碗瓢盆放进洗碗机里,都挺艰难。

过去两三年,人们普遍高估了人形机器人的通用能力。很多人喊着,它们将走进家庭,承担家务,「这个事情绝对是高估的。」 ATEC 2025 专家委员会主席、香港工程院院士刘云辉认为,「五年之内实现都相当困难。」

但「丢掉遥控器」并不是未来加分项,而是具身智能能否真正落地的必选项。

一些选手表示,机器人应该去做「人做不了或不该做的事」,在这些场景里,没人能用遥控器替机器人做判断。

必须丢掉遥控器,也不是太难。刘云辉认为,从技术路径上看,感知与决策是关键。机器人能不能正确看到世界?能不能自己决定下一步怎么做?

刘云辉院士(左)在观看自主浇花的比赛。

为了理解并与三维世界沟通、互动,人类花费 5.4 亿年进化出感知智能。如今,它正困扰着具身智能。在岭南体育场,阳光成了机器人频繁翻车的罪魁祸首。

早上七点场地还笼罩在阴影中,一小时后光照明显增强,到了中午,阳光直射,连人类选手都看不清电脑屏幕。

深度相机(如 RealSense)的主动光结构在强光下几乎失效:透明的矿泉水瓶在机器人眼里宛隐身,机械臂照常伸过去,结果直接把水瓶撞掉。

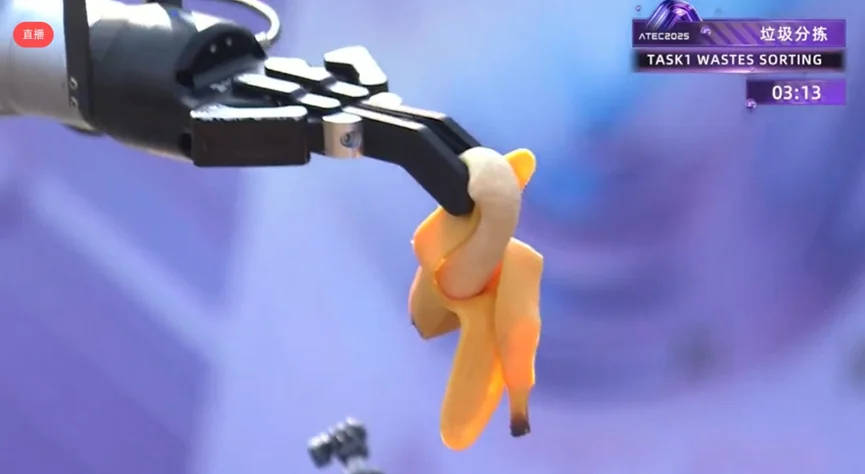

终于抓住啦。

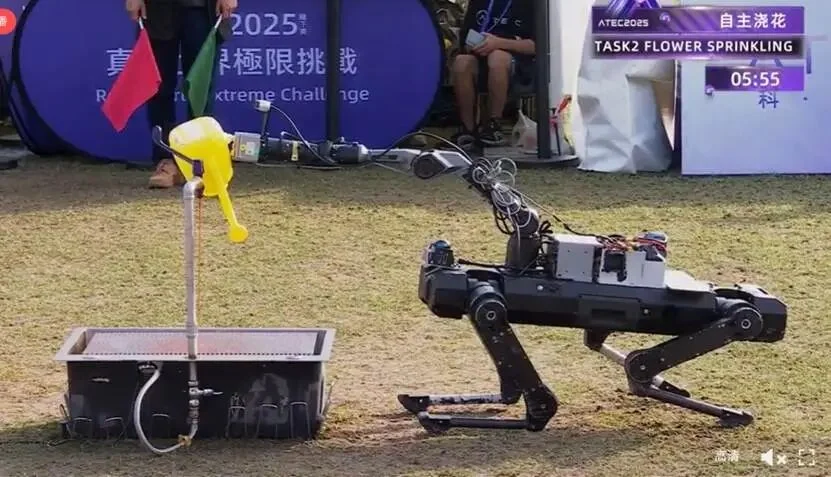

浇花任务同样困难重重。黄色水壶被晒得发白,白色桌面又强烈反光,导致点云严重散射,抓取动作屡屡失败。而在 3D 识别中,那 6 朵形状不规则的白色假花,本身就是高难度目标。原本规划自主完成的队伍,无奈选择遥操。

选手遥操人形机器人拿水壶。

吊桥穿越也不省心。视觉定位被阳光带偏,机器人一步步靠近吊桥边沿,踩空跌落。

机器人走偏后,踩空,掉下桥。

如今,机器人的移动、视觉和导航都令人惊叹,但操作能力依然相对原始。英国皇家工程院院士、意大利技术研究院(IIT)创始人、IEEE会士 Darwin Caldwell 说。

为什么操作如此难?因为,移动的底层难题,本质上就是「站稳 + 迈步」。涉及的物理变量较为固定,也能在仿真中完整构建,大规模强化学习因此收敛迅速,进展飞快。

操作任务涉及的变量,却极其复杂——

透明与反光、材质差异、颜色变化、光照波动,哪怕只是抓香蕉和抓矿泉水瓶,对机器人来说都是完全不同的任务。

更关键的是,机器人目前缺乏真实的物理信息,触觉反馈几乎为零。而在人类操作行为中,触觉和视觉同样重要。

这也是为何 ATEC 会在垃圾分拣任务中选择玩具香蕉:软、可变形,但不会被机器人捏烂。

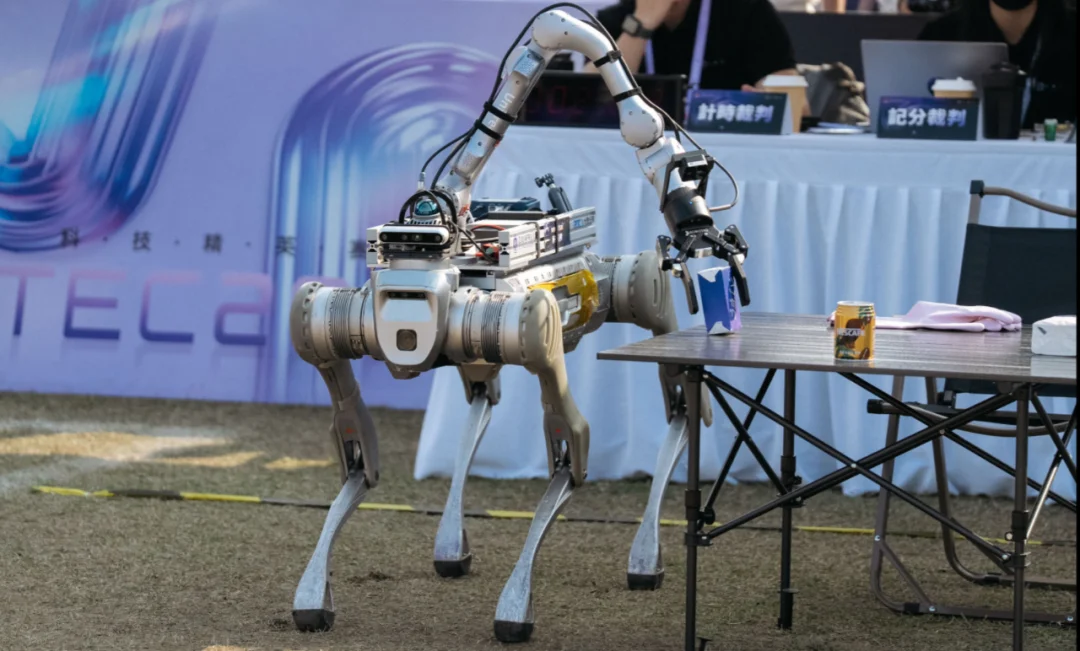

尽管如此,仍有两支四足机器人队伍像是开了挂,全自主「通关」垃圾分拣与吊桥穿越。

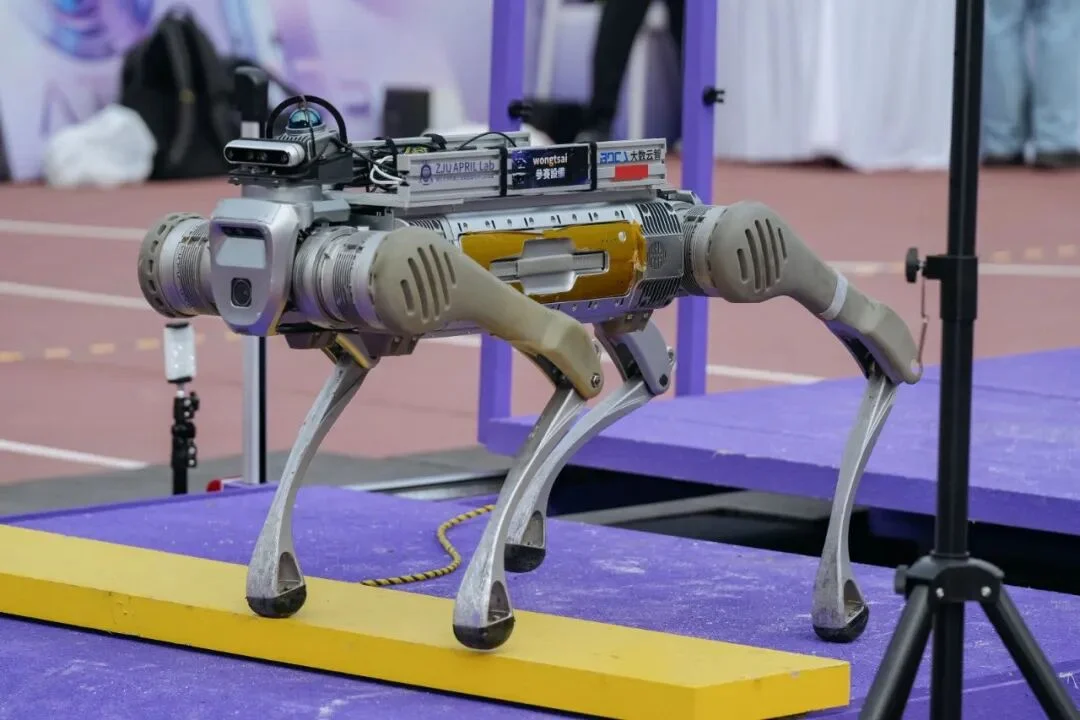

分拣任务中,浙江大学 wongtsai 赛队没有依赖大模型,而是回到 「传统视觉 + 几何」的老牌路线,并打磨到极致。

吊桥穿越之前,他们就在模拟器里高度还原真实场景:不仅复刻吊桥结构,还模拟了 RealSense 在户外可能遇到的各类噪声(视差误差、散斑点云、纹理缺失等),sim2real 部署很顺利。

不少机器人从业者都说过类似扎心的真话。

在开放环境下,让机器人自主从桌上拿瓶水都很难。稍微复杂一点的操作,全靠遥操或同构臂。

但我们想外包出去的家务,哪一件不是长链任务 + 工具使用的组合?做早餐不是煎个鸡蛋,而是一套流程:找锅 → 开火 → 备料 → 下锅 → 装盘 → 洗碗……

要让机器人做这件事,它必须要有一个能规划、会决策、有记忆的大脑。但多数机器人现在只有「20 岁身体,3 岁智商」。

ATEC2025 赛事组专家、松灵机器人具身智能部门负责人谢志强在直播里举了个例子:扫地机。它能自主移动,但一旦被卡住,只会等待人类救援。

这也是为什么自主浇花会难倒一溜儿机器人,因为任务链实在太长了——

找到水壶 → 拿起 → 开水龙头 → 接水 → 关龙头 → 找花盆 → 浇花 → 放回原处

相比单步抓取、视觉分类,它考验的是机器人是否真正具备长程任务的能力。结果,没有机器人可以做到全自主。

浙江大学 wongtsai 赛队告诉我们,实验室里还能泛化的 VLA(视觉-语言-动作)模型,一旦到真实场景就不行了。

大模型能听懂图像和指令,但无法真正理解物理世界的细节,抓水壶、浇花,精度完全不够。他们选择了遥操。

浙江大学wongtsai赛队通过遥操的方式完成了自主浇花的大部分子任务。

有的队伍尝试混合模式。先用遥控器把机器人挪到最佳位置,再让机械臂自主完成抓壶、接水、浇花。

即便如此,一旦流程中某个环节出现异常,机器人的脑子就转不过来了。

例如,手拿水壶打开水龙头,万一卡住,就会一直停在那里。

垃圾分拣里的道具香蕉,暴晒后会发生不可逆的形变,有的机器人明明已经夹住,却仍坚持判定为失败。

各出奇招,用水壶撞开水龙头。

成绩一度领先的机器人,也在定向越野最后一段失控:反复掉入同一处排水沟,无法自主调整,最终只能切回遥操。

最有意思的是,吊桥穿越。

机器人先跨过 5cm、10cm 的缝隙,最后迎面撞上一道 50cm 的间隙。

「机器人要自己做思考、做决策,比如拿起板来填充,从而改变环境,适应自己的运动。」 刘云辉解释说,这不再是简单的行走,而是包含了环境评估、工具使用、任务规划的高级智能行为。

结果,四足机器人根本不考虑这些复杂操作,直接跳过去。

双足机器人先靠物理外挂撑过前两个小缝。到了 50cm 大间隙,多半会把拉绳碰掉,原地等救援。

各种物理外挂登场

这台双足机器人成功拿住了绳子,移动木板,迈过去了。

和如今的主流路线一样,今年参赛队伍的系统架构大多采用 「大模型 + 小模型」协同范式:

大模型负责高层语义理解、任务拆解与策略规划;小模型面向前端感知、运动控制等即时执行;两者再通过管线化与反馈回路完成闭环。

但随之而来的现实问题是——

一台机器人身上同时挂着 CPU、GPU、NPU 等一堆异构算力,怎么把它们挤进一块体积足够小、功耗足够低的板子里,还能高效协同?

浙江大学 wongtsai 赛队以全自主方式,出色完成了三项任务(包括定向越野)。其端侧配置堪称豪华。

他们给机器人挂了三台小电脑,一台 Intel NUC 当主控,两块英伟达算力板(一大一小)跑不同规模的神经网络,比如用 Segment Anything 做图像分割。

但要支撑更大规模模型推理,算力还是明显不够,延迟高、耗电大。

浙江大学wongtsai赛队接受采访,谈到 15 万美金奖金,队长一句话总结:先还债,补贴昂贵设备成本。

队伍成员也提到,要真正走向现实世界,机器人必须拥有顺势而为的自适应能力。定向越野时,脚和石头不会硬碰硬;浇花时,身体会随着水壶重量变化,实时调整重心。

这些都考验着整机的力控能力与自适应控制。而想在复杂场景中做这种高质量感知和控制,目前的算力和本体都还差了一截。

「我们现在有一个巨大的问题,漂亮的算法无法在机器人内部运行。」ATEC2025 赛事组专家、卡里法大学(Khalifa University)自主机器人系统教授、机器人感知研究负责人 Jorge Manuel Miranda Dias 指出。要让机器人的身体能承载其大脑的智能,低功耗、高性能的专用芯片和轻量化模型是关键。

有一件趣事。在比赛前,不少人认为机器人要全自主跑完定向越野,几乎不可能。ATEC2025 赛事组专家、香港中文大学机械与自动化工程学系教授兼系主任、新加坡工程院院士陈本美甚至放下「豪言」,如果真有人做到,香港的餐厅任对方挑,他请客。

结果比赛第一天,就有两台四足机器人完成了全自主定向越野。

500 米级自然地形导航,信号差、多窄梯、多弯道、强光扰动……在成熟RL控制器支撑下,只依靠自身传感器去构建地图、完成定位、稳定前行。

刘云辉认为,机器人要真正进入人类世界,必须同时具备三大能力:能走、能操作、能改造环境。过去十年,四足机器人在「能走」这一维度已经有了质变。但「能操作、能改造环境」仍有巨大的研究空间。

相比四足机器人,双足机器人和人形机器人还有更长的路要走。双足形态重心高、支撑面小,平衡、力控、地形适应都远比四足困难,更不用说在行走中完成操作。

它们面对的,是一个更陡峭、但也更贴近未来生活场景的技术坡度。

双足、人形机器人面临的挑战,比四足机器人多得多。

翻车很正常,翻车也是一种进步。刘云辉说。没有失败,也就永远没有成功的可能。

也正因如此,ATEC 组委才会让机器人面对真实世界的扰动。设计的每一道题,都不是为了让它完成得好看,而是对这三大能力的系统级验收,让它在碰撞中暴露真正的弱点。

毕竟,只有真问题,才能让行业知道下一步要突破什么。

AGI 的未来,注定是机器智能与物理世界的深度融合。作为赛事发起单位之一,蚂蚁集团技术战略部负责人表示,AI 必须从数据认知走向环境交互和行动执行,大家正期待下一次真正意义上的技术突破。

文章来自于“机器之心”,作者 “吴昕”。

【开源免费】VideoChat是一个开源数字人实时对话,该项目支持支持语音输入和实时对话,数字人形象可自定义等功能,首次对话延迟低至3s。

项目地址:https://github.com/Henry-23/VideoChat

在线体验:https://www.modelscope.cn/studios/AI-ModelScope/video_chat

【开源免费】Streamer-Sales 销冠是一个AI直播卖货大模型。该模型具备AI生成直播文案,生成数字人形象进行直播,并通过RAG技术对现有数据进行寻找后实时回答用户问题等AI直播卖货的所有功能。

项目地址:https://github.com/PeterH0323/Streamer-Sales