如何让针对静态场景训练的3D基础模型(3D Foundation Models),在不增加训练成本的前提下,具备处理动态4D场景的能力?

来自香港科技大学(广州)与地平线(Horizon Robotics)的研究团队提出了VGGT4D。该工作通过深入分析Visual Geometry Transformer(VGGT)的内部机制,发现并利用了隐藏在注意力层中的运动线索。

作为一种无需训练(Training-free)的框架,VGGT4D在动态物体分割、相机位姿估计及长序列4D重建等任务上均取得了优异性能。

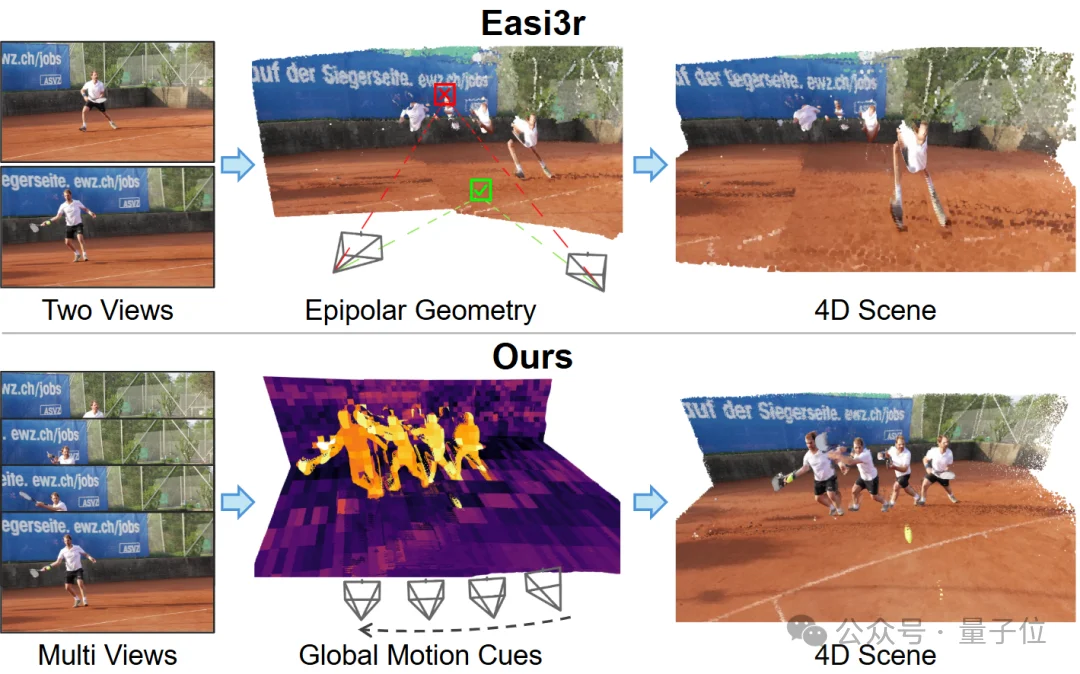

近年来,以VGGT、DUSt3R为代表的3D基础模型在静态场景重建中表现出色。然而,面对包含移动物体(如行人、车辆)的动态4D场景时,这些模型的性能往往显著下降。动态物体的运动不仅干扰背景几何建模,还会导致严重的相机位姿漂移。

现有的解决方案通常面临两类挑战:

依赖繁重的测试时优化(Test-time Optimization)或需要在大规模4D数据集上进行微调。

通常需要引入光流、深度估计或语义分割等额外模块,增加了系统的复杂性。

VGGT4D的核心设想:能否在不进行额外训练的前提下,直接从预训练的3D基础模型中挖掘出4D感知能力?

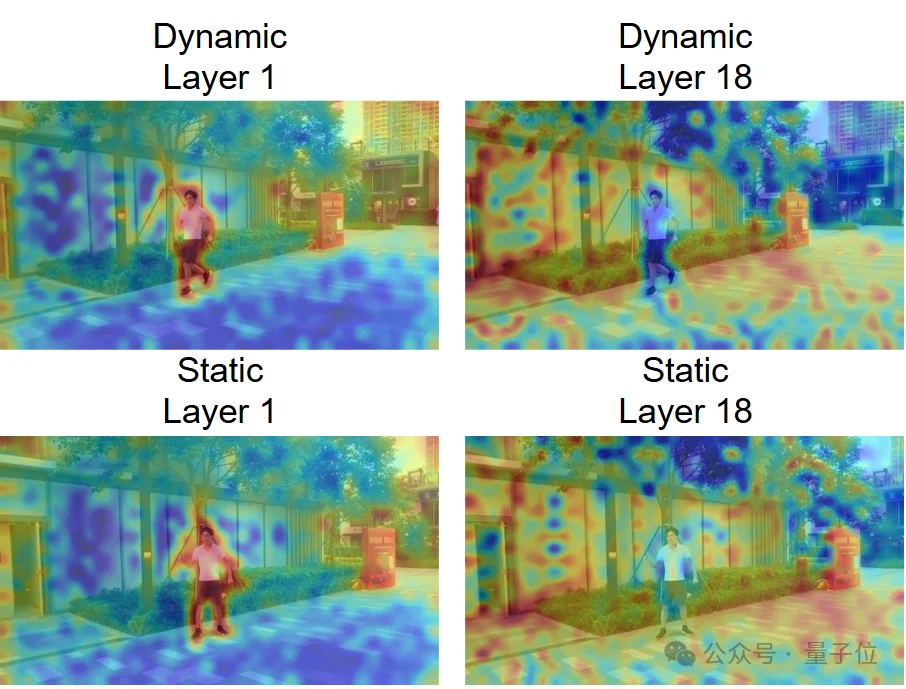

研究人员对VGGT的注意力机制进行了可视化分析,观察到一个关键现象:VGGT的不同网络层对动态区域表现出截然不同的响应模式。

倾向于捕捉语义上显著的动态物体。

则逐渐抑制几何不一致的区域。

这一发现表明,VGGT虽然是基于静态假设训练的,但其内部实际上已经隐式编码了丰富的动态线索。

然而,直接利用标准的注意力图(QKT)效果并不理想,因为它混合了纹理、语义和运动信息,导致信噪比低,使得Easi3R等基于Epipolar假设的方法在VGGT架构上失效。

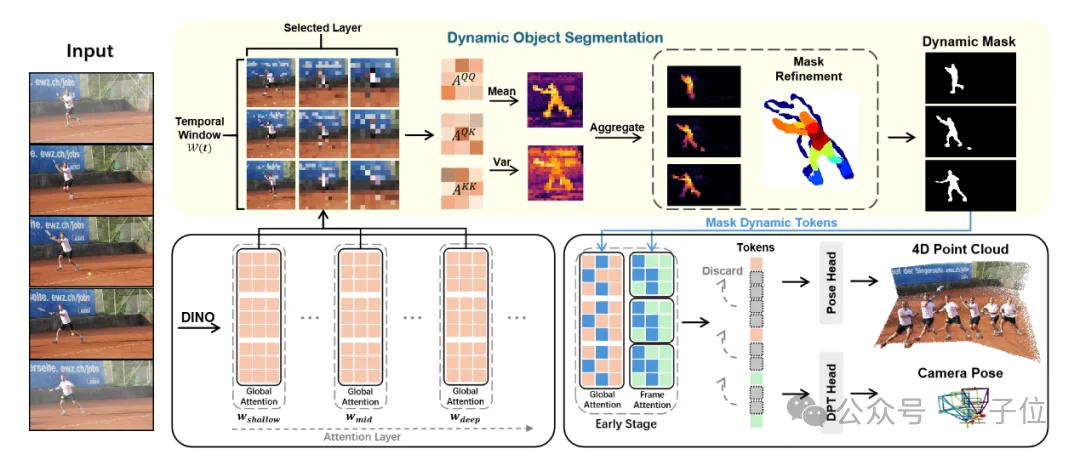

VGGT4D提出了一套无需训练的注意力特征挖掘与掩膜精修机制。该方法深入特征流形内部,利用Gram矩阵和梯度流实现了高精度的动静分离。

研究团队首先分析了标准注意力图AQK=QKT/√C的局限性。由于Q(Query)和K(Key)向量来自异构的投影头,其特征分布存在天然的分布间隙(Distributional Gap),导致Cross-Attention主要响应语义对齐,而运动引起的微小特征扰动容易被掩盖。

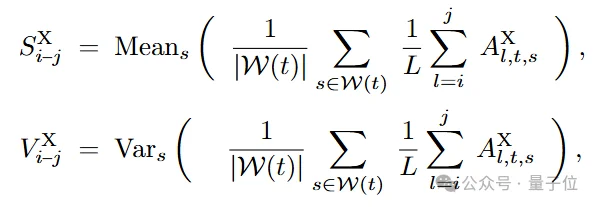

为解决此问题,VGGT4D引入了自相似性Gram矩阵来替代。通过在同构潜在分布内计算相似度,运动引起的方差成为了主导信号。模型通过在时间窗口W(t)内聚合不同层级的统计矩(均值S与方差V),构建了动态显著性场:

为了解决Attention Map分辨率不足导致的边界模糊问题,VGGT4D引入了投影梯度感知精修(Projection Gradient-aware Refinement)。

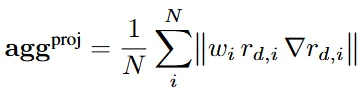

定义3D点在视点i下的几何投影残差rd,i,该残差关于3D坐标的梯度∇rd,i包含了极强的边界信息。由于该梯度依赖于投影雅可比矩阵(Projection Jacobians)和深度图的空间梯度,在动态物体边缘处会呈现显著的高频响应。聚合后的梯度能量函数如下所示,结合光度残差项,实现了对动态掩膜的亚像素级锐化:

在推理阶段,直接的全层掩膜(Full Masking)会将模型推向分布外(OOD)状态,导致性能下降。

VGGT4D提出了一种早期阶段干预策略:仅在浅层抑制动态Token的Key向量。这种设计既在早期切断了动态信息对深层几何推理的影响,又保证了深层Transformer Block依然在其预训练的特征流形上运行,从而保证了位姿估计的鲁棒性。

研究团队针对动态物体分割、相机位姿估计和4D点云重建三大核心任务,在六个基准数据集上进行了详尽的定量和定性评估:

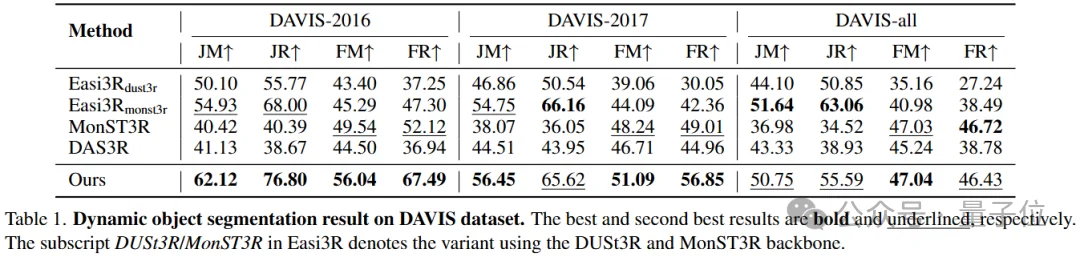

实验首先评估了该方法的核心组件:动态物体分割。

定量分析:VGGT4D显著优于其他所有变体,在DAVIS-2016和DAVIS-2017数据集上均达到了最优性能。值得强调的是,即使没有经过任何4D特定的训练,该方法仅基于预训练的VGGT模型即可取得优异结果。虽然Easi3Rmonst3r在DAVIS-all数据集上表现出具有竞争力的召回率,但这主要得益于MonST3R在光流上的后训练,而VGGT4D无需训练。

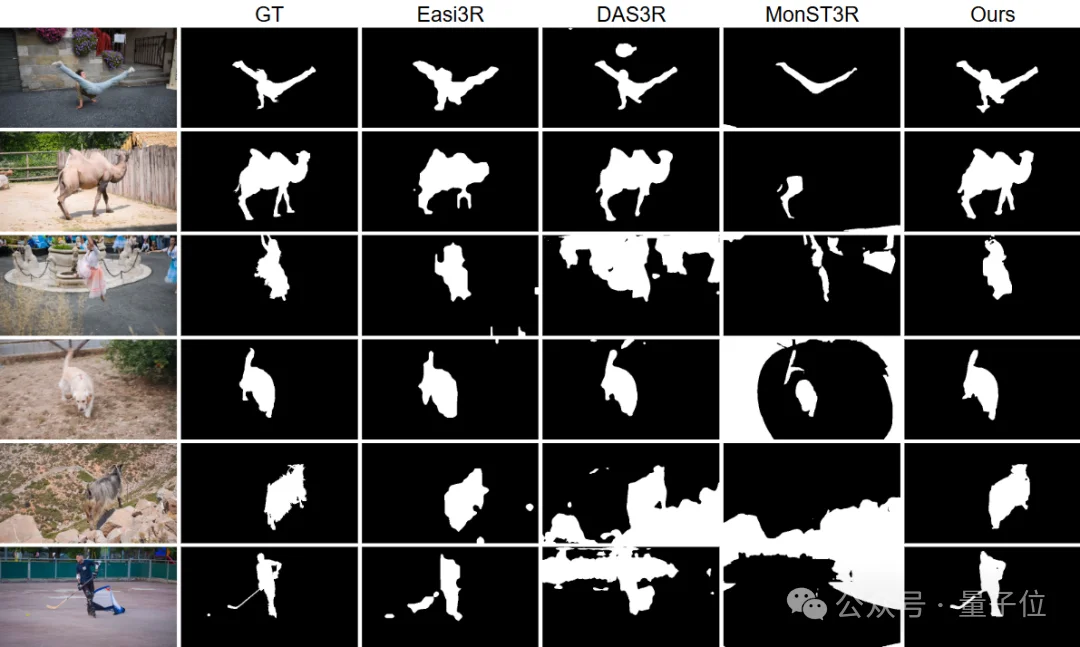

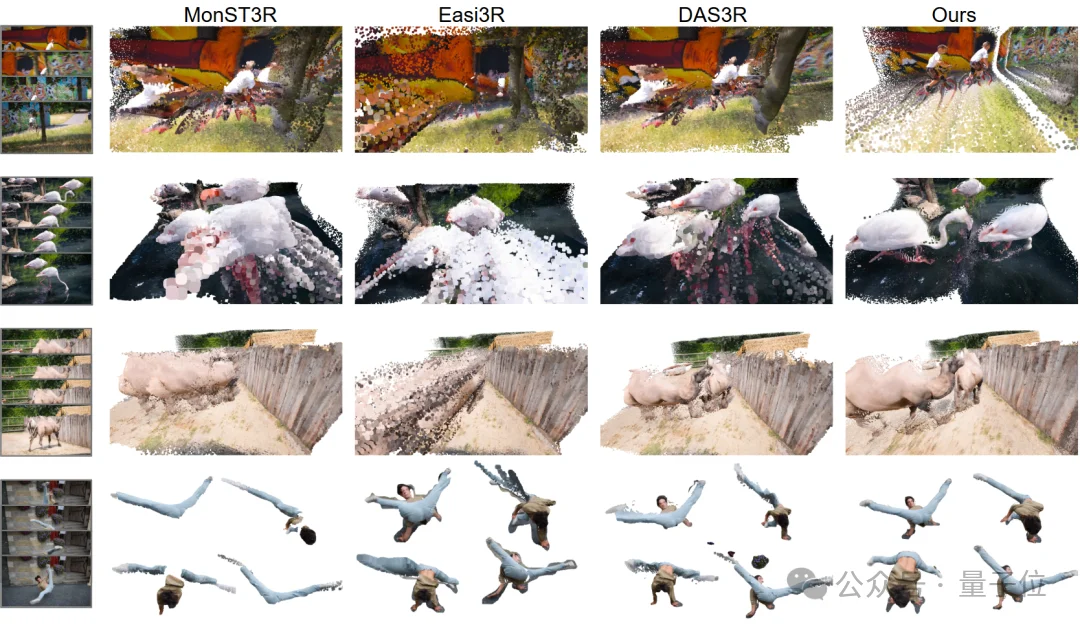

定性分析:定性结果清晰地展示了基线方法的不足:Easi3R的掩码较为粗糙且遗漏细节;DAS3R倾向于过度分割并渗入静态背景;MonST3R则常常分割不足。相比之下,VGGT4D生成的掩码更加准确,且边界更加清晰。这些结果有力地验证了研究团队的假设:VGGT的Gram相似度统计信息中嵌入了丰富的、可提取的运动线索。

强大的基线与持续改进:数据表明,原始VGGT已经是一个非常强大的基线,其自身就优于MonST3R、DAS3R等许多专门的4D重建方法。这表明VGGT的预训练隐式地使其对动态物体具有一定的鲁棒性。然而,这种鲁棒性并不完美。VGGT4D在所有数据集上均持续改进了这一强大的VGGT基线。例如在VKITTI数据集上,VGGT4D的ATE仅为0.164,而MonST3R高达2.272。

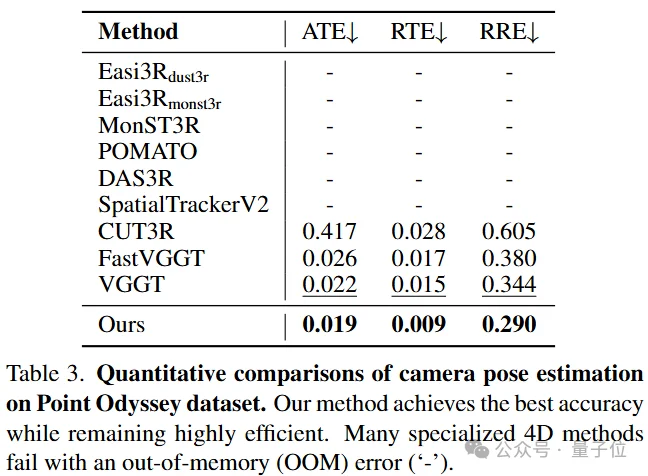

长序列鲁棒性突破:在极具挑战性的长序列Point Odyssey基准测试中,VGGT4D在所有指标上均取得了最佳结果,同时保持了高度效率。许多其他4D方法由于内存不足(OOM)错误甚至无法在该500帧序列上运行。这表明VGGT4D提出的显式、无需训练的动态-静态分离方法成功地识别并消除了由运动引起的残余位姿不一致性,从而实现了更稳定、更准确的相机轨迹,尤其是在长且复杂的序列上。

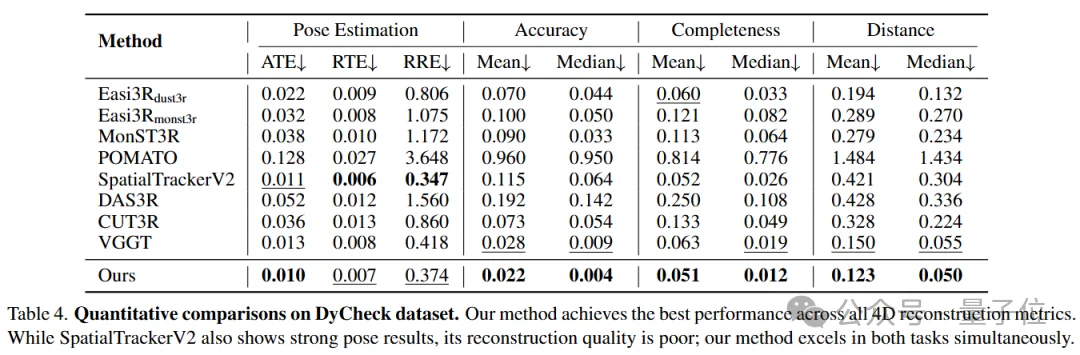

在DyCheck数据集上的评估显示,VGGT4D在所有重建指标(准确度、完整度和距离)上均取得了最佳性能。与VGGT基线相比,中位准确度误差从0.009降低到0.004,平均距离从0.150降低到0.123。这证明了该方法不仅实现了精准的动静分离,更能实质性提升几何重建质量。

VGGT4D提出了一种无需训练的新范式,成功将3D基础模型的能力扩展至4D动态场景。该工作证明了通过合理挖掘模型内部的Gram相似度统计特性,可以有效解耦动态与静态信息。这不仅为低成本的4D重建提供了新思路,也展示了基础模型在零样本迁移任务中的潜力。

项目主页:https://3dagentworld.github.io/vggt4d/

代码链接:https://github.com/3DAgentWorld/VGGT4D

论文标题:VGGT4D: Mining Motion Cues in Visual Geometry Transformers for 4D Scene Reconstruction

文章来自于“量子位”,作者 “VGGT4D团队”。

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner