在近一年里,Agentic System(代理系统/智能体系统)正变得无处不在。从Open AI的Deep Research到Claude Code,我们看到越来越多的系统不再依赖单一模型,而是通过多模型协作来完成复杂的长窗口任务。

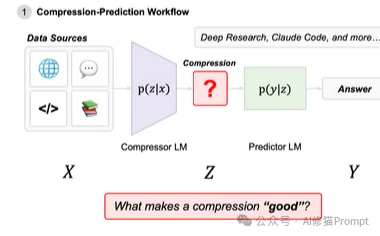

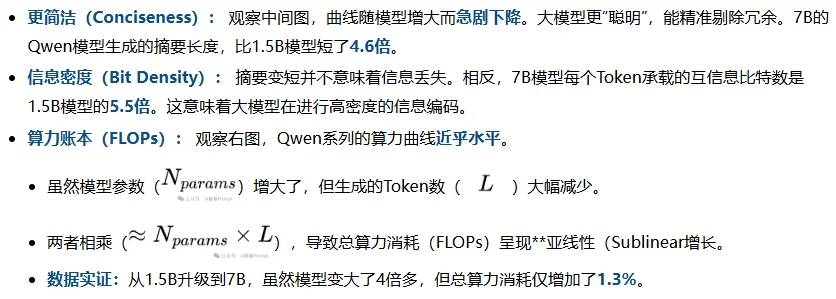

通常,这种协作模式被设计为「压缩器-预测器」(Compressor-Predictor)架构:

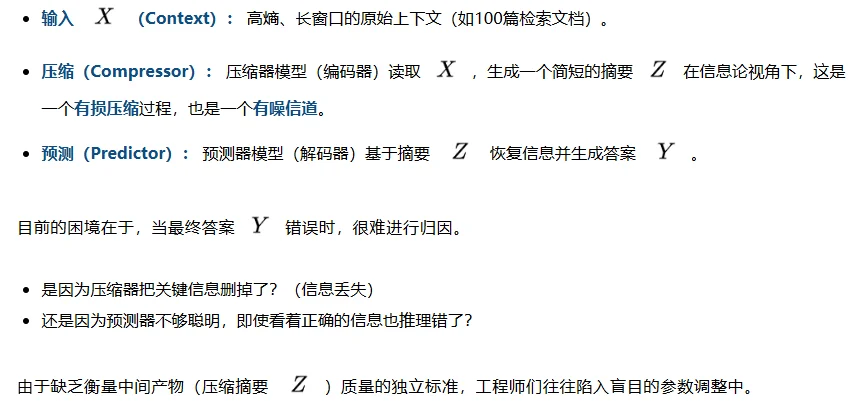

目前业界的痛点在于:我们该如何设计这两个组件的比例? 是应该用一个巨大的模型做压缩,还是把算力都留给最后的预测?如果系统回答错误,是压缩器漏掉了信息,还是预测器没推理出来?

一直以来,这些问题只能靠“试错法”来解决。

近期,来自斯坦福大学的研究者们发表了一篇题为《An Information Theoretic Perspective on Agentic System Design》的论文,他们引入了经典的香农信息论(Shannon Information Theory),为智能体设计提供了一套数学上严谨的指导原则。

本文将为您详细解读这项研究的核心发现。您会看到,许多直觉上的设计选择可能是错的。比如,更大的压缩模型反而能帮您省钱。

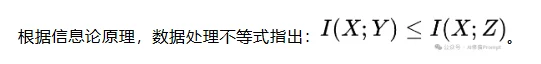

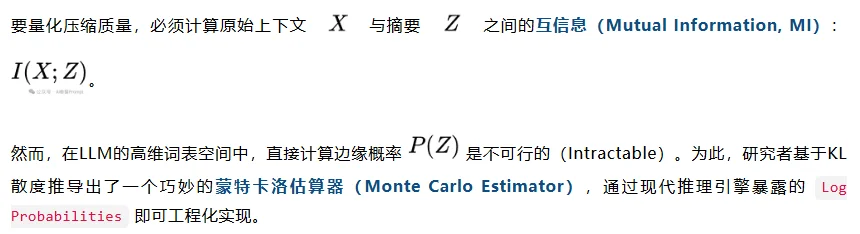

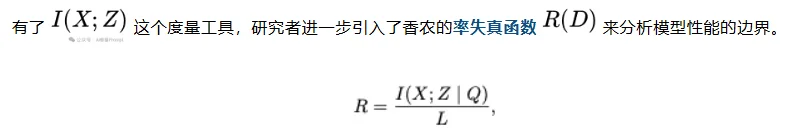

研究者将目前主流的「多模型协作」范式(如Deep Research)抽象为一个马尔可夫链:

这意味着,下游预测器(Predictor)性能的上限,被压缩器(Compressor)保留的互信息量死死锁住。如果压缩阶段丢失了关键比特,无论后端的GPT-4o多么强大,都无法“脑补”出原本不存在的信息。这就是为什么单纯升级预测器往往收益递减的理论根源。

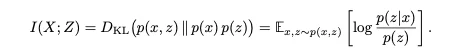

如果一个摘要是“正确的废话”(如“这份文档包含了重要的财务数据”),它在任何文档下生成的概率都很高,两项相减接近,互信息极低。只有当摘要高度特异性地依赖于特定文档时,互信息才会显著为正。

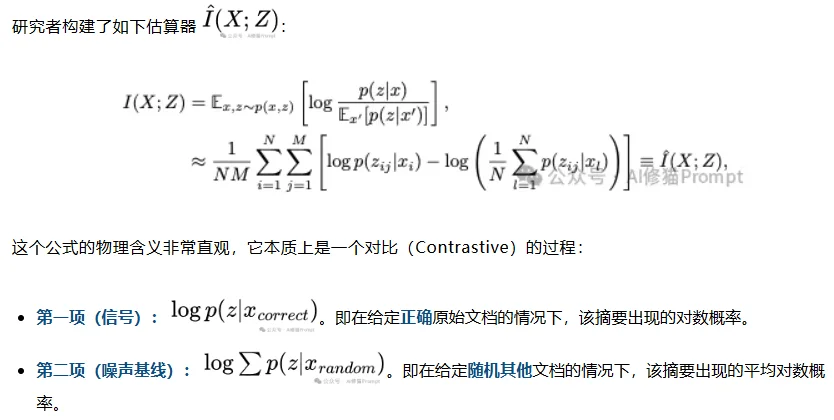

在实际计算中,研究者发现了一个棘手的问题:小参数模型(如1B-3B)往往校准(Calibration)很差,它们可能会对胡言乱语给出极高的置信度概率。

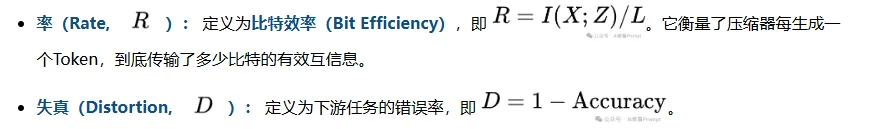

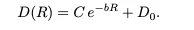

研究者发现,不同模型家族的性能完美符合率失真函数的指数衰减形式:

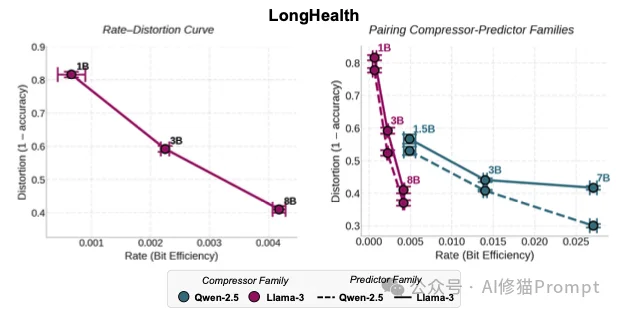

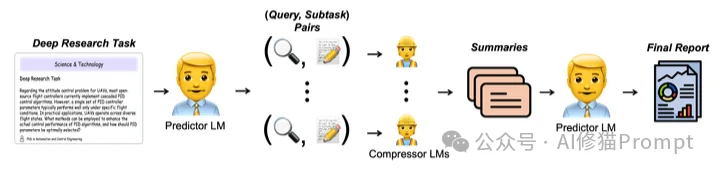

通过绘制R-D曲线(Figure6),研究揭示了两个深层机制:

另外,研究者发现预测器并不在乎压缩器是不是它的“亲兄弟”。一个Llama-3的预测器,完全可以搭配一个Qwen-2.5的压缩器。事实上,由于Qwen的高压缩率,这种组合往往能达到更好的性价比。这就引出了一个非常实用的工程建议:不必迷信“全家桶”。

基于上述理论框架,论文在5个数据集(涵盖医疗、金融、代码、网页)上进行了大规模实验,得出了一些颠覆传统认知的Scaling现象。

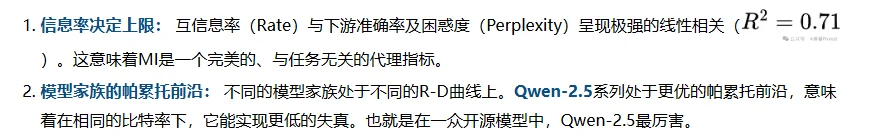

实验表明,增加压缩器参数带来的收益远超预测器。

这张图展示了不同算力分配下的性能轨迹。

核心结论: 系统的性能天花板由输入的“纯净度”决定,而非后端的“推理力”。设计原则应从“后端重型转向算力前置”(Front-load Compute)。

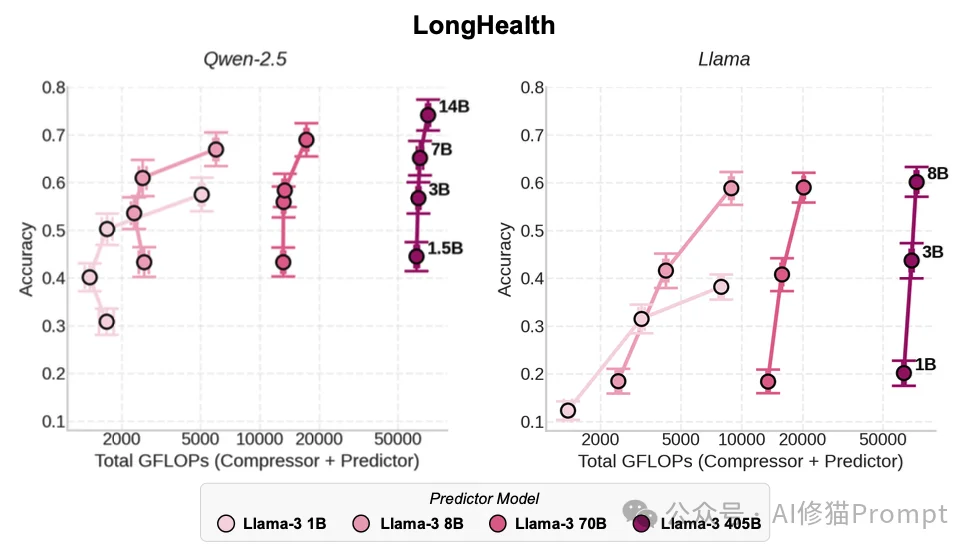

通常认为,模型越大,推理越慢,成本越高。但在“压缩”这个特定任务中,更大的模型反而实现了更高的Token效率,导致总计算成本几乎没有增加。

这张三联图揭示了压缩任务中独特的“亚线性Scaling”规律,解释了为什么大模型反而更省资源。

这就是压缩任务中的“免费午餐”:可以用几乎相同的计算成本,换取更高的准确率和更短的上下文。

研究者将上述理论应用于一个现实世界的Deep Research Pipeline。

基于详尽的实证分析与信息论推导,研究者为未来的Agent系统设计提炼了四条核心原则。这些原则不仅是理论总结,更是构建高效AI系统的实操手册。

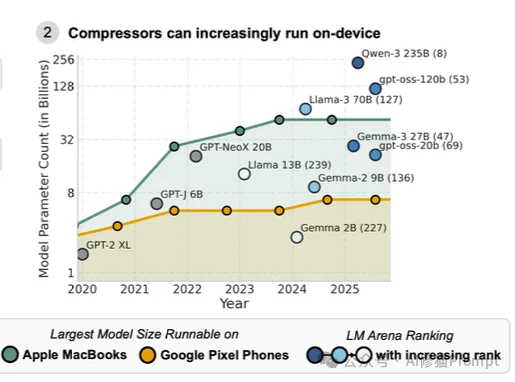

如上图所示,随着消费级硬件(如 MacBook 和 Pixel 手机)性能的飙升,当前的主流设备已经完全有能力运行7B甚至30B参数的高性能模型。

长久以来,我们对AI Agent的设计更多依赖于经验主义。这篇论文不仅为我们提供了一套清晰的数学工具(信息论),更用扎实的数据打破了“小模型做预处理,大模型做推理”的刻板印象。

在未来的系统设计中,一个运行在用户手机上的、沉默寡言但字字珠玑的 7B 模型,可能才是整个智能体系统中真正的幕后英雄。

希望这篇文章能为您优化自己的 AI 系统提供新的视角。如果您准备动手改进您的RAG或Agent架构,不妨先从换一个更大、更“话少”的压缩模型开始试试。

文章来自于“AI修猫Prompt”,作者 “AI修猫Prompt”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】LangGPT 是一个通过结构化和模板化的方法,编写高质量的AI提示词的开源项目。它可以让任何非专业的用户轻松创建高水平的提示词,进而高质量的帮助用户通过AI解决问题。

项目地址:https://github.com/langgptai/LangGPT/blob/main/README_zh.md

在线使用:https://kimi.moonshot.cn/kimiplus/conpg00t7lagbbsfqkq0