让模型真正 “能行动”,往往需要一个可执行、可验证的符号世界模型(Symbolic World Model):它不是抽象的文字描述,而是能被规划器或执行器直接调用的形式化定义 —— 例如 PDDL 领域 / 问题,或可运行的环境代码 / 模拟器。一旦世界被 “写成可运行的规则”,我们就能在同一套约束下进行推演、测试与复现:模型不再停留在 “会说”,而是能回答 “如果我这样做,会发生什么”,并用执行结果检验自己是否真的理解了这个世界。

问题在于,现有自动生成路线普遍陷入三重困局:脚本式工作流、知识边界封闭、表示覆盖单一。许多方法仍沿用固定的 “生成 — 修复” 脚本,并以解析 / 规则匹配 / 固定检查集等静态校验为主:它们或许能修语法与格式,却常常抓不住只有在交互执行中才暴露的行为级错误(例如状态更新不一致、目标不可达、奖励机制失效)。与此同时,当任务规格含糊、缺失关键规则或背景常识时,系统缺少主动检索与补全机制,只能依赖模型记忆 “猜”。更关键的是,既有研究往往只覆盖一种世界模型表示(只做 PDDL,或只做可执行代码),导致同一任务难以在不同符号表达之间共享验证闭环与改进经验,限制了方法的通用性与可扩展性。

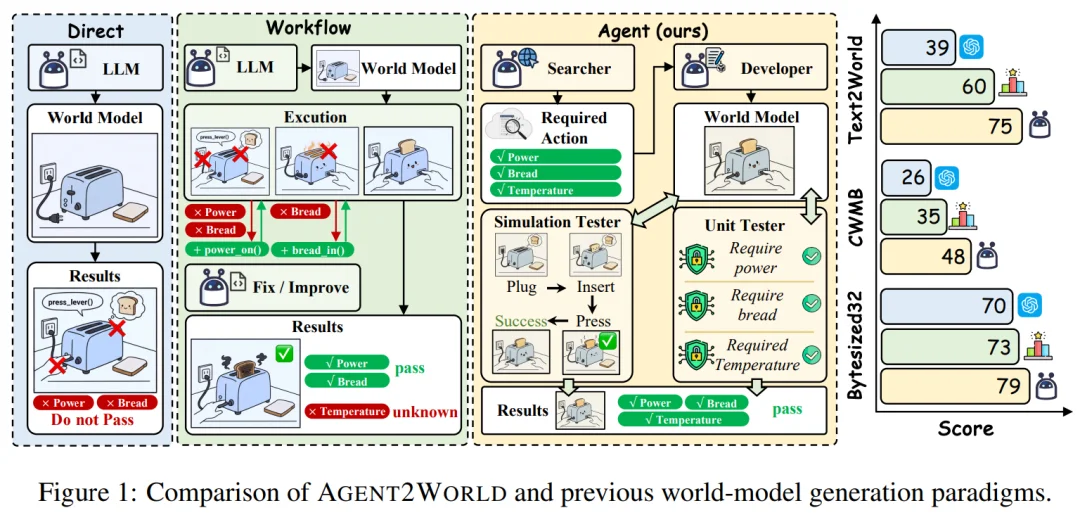

为攻克这一难题,研究团队提出 Agent2World:一个工具增强(tool-augmented)的多智能体框架,用 “知识合成(Knowledge Synthesis)→ 世界模型实现(World Model Generation)→ 评估驱动精炼(Evaluation-Driven Refinement)” 的三阶段闭环,把 “查资料补规格 + 写实现 + 交互测试纠错” 内化为可复用的生成范式,从而稳定产出高可执行、可验证的符号世界模型。

实验结果显示,Agent2World 在 Text2World (PDDL)、CWMB (MuJoCo) 和 ByteSized32 (文本游戏) 三大基准上均实现了 SOTA 性能。更关键的是,该框架展现了可持续改进潜力:基于 Agent2World 生成的高质量轨迹进行微调(SFT)后,模型性能显著跃升 —— 与训练前的同一模型相比,平均相对性能提升了 30.95%,有力证明了其作为高质量世界模型数据合成引擎的工程与研究价值。

在 Agent2World 之前,自动生成世界模型的主流方案常采用固定的 “草稿 — 修复(Draft-Repair)” 脚本:生成代码 → 跑错 → 看报错改代码。它能修语法,但很难保证 "跑起来" 的世界是对的。

归根结底,难点不只是 “写出代码”,而是要在真实约束下稳定产出可执行、可复现、可迭代的世界模型;而 “脚本式流程 + 单一表示覆盖” 的组合,正是阻碍这一目标的核心瓶颈之一。

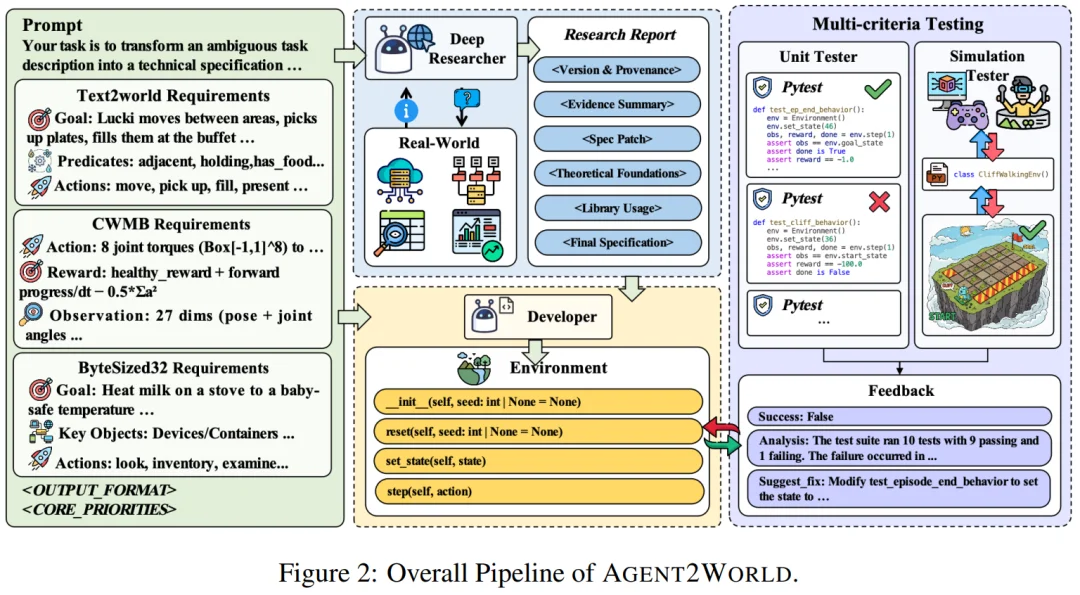

Agent2World 的核心不是 "多拉几个 agent 聊天",而是把世界模型生成拆成软件工程式三阶段:Researcher 补规格、Developer 做实现、Testing Team 用单测 + 仿真交互做行为级验收,并把验收反馈反哺修复。

1. Deep Researcher:主动打破知识壁垒

现实任务往往信息不完备:目标相对清晰,但规则边界、参数范围、动作约束与接口细节并不完整,在不确定性与知识缺口的叠加下,极易导致事实性错误与幻觉。Deep Researcher 首先将任务描述分析并拆成一组待澄清问题(例如:允许的动作集合、状态变量定义、终止条件、异常情况与边界输入等),它配备了网络搜索和检索工具,能够迭代地从互联网检索构建世界模型所需的知识,并最终输出一个结构化的中间表示,其中缺失的信息已得到补充。

2. Model Developer:统一跨模态表达

在获得补全后的规格后,Model Developer 负责生成目标世界模型(例如 PDDL 域 / 问题,或可执行的环境代码)。这一阶段不以 “写得像” 为目标,而以 “能执行、接口连通、与规格一致” 为硬约束。

因此 Developer 会在受控沙盒中进行基础运行检查与增量修复:一方面保证文件组织、函数签名、依赖与调用链正确;另一方面确保状态转移、动作前置条件与效果、终止判定等核心逻辑与规格对齐。该阶段的输出是一个可以被执行器 / 规划器直接调用的环境实例。

3. Testing Team:双重防线杜绝幻觉

这是框架中的关键组成部分。不同于以往依赖静态验证器的方法,Testing Team 引入了动态的、行为级的双重验证机制,专门捕捉只有在交互中才会暴露的逻辑错误。

一旦发现问题,Testing Team 会输出包含错误分析(Analysis)和修复建议(Suggest Fix)的结构化报告,驱动 Developer 进行针对性修复,直到通过所有测试或达到收敛条件。

进阶:从推理到训练,构建 "自进化" 的数据飞轮

Agent2World 的价值远不止于一个推理框架,它本质上是一个全自动的高质量数据合成引擎。研究团队通过 “任务合成 — 轨迹筛选 — 经验蒸馏” 的严密流程,将多智能体协作中的有效修复策略蒸馏为单体模型的生成与修复偏好。

Agent2World 在 Text2World(PDDL)/ CWMB(MuJoCo 可执行模拟器)/ ByteSized32(文本游戏环境)三大基准上都拿到领先表现。

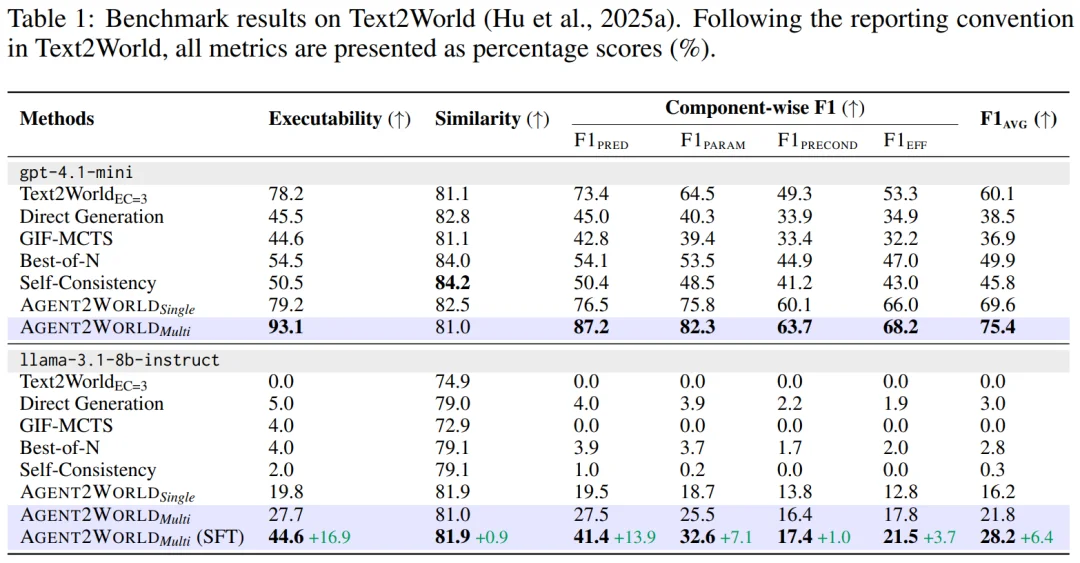

1. Text2World (PDDL):

从 “能跑” 到 “懂逻辑” 的显著提升。以 GPT-4.1-mini 为底座,在衡量 PDDL 代码生成的基准中,Agent2World Multi 明显降低了代码 “跑不通” 的失败率,实现了 93.1% 的代码可执行率(Executability),相比强基线 Text2World ($EC=3$) 提升了 14.9 个百分点。更重要的是,它在衡量语义正确性的 Component-wise F1 指标上达到了 75.4(基线仅为 60.1),提升幅度达 15.3 分。这表明模型不再只是机械地模仿 PDDL 语法,而是更加理解了谓词约束与逻辑门控,生成了既符合语法又具备可解性的高质量规划域。

2. CWMB (MuJoCo)

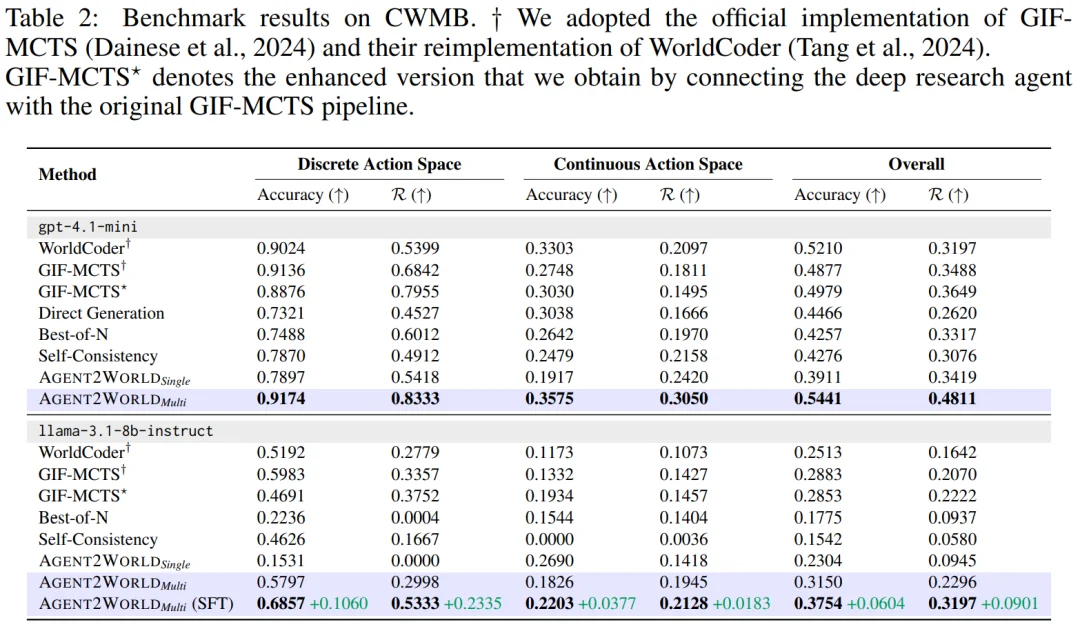

不仅预测得准,更要 “好用” 。CWMB 同时评估 “仿真代码是否能预测动力学”(Accuracy)与 “作为世界模型能否支撑下游规划 / 控制”(Overall Normalized Return, R)。 在 GPT-4o-mini 上,Agent2World Multi 的 Overall R 达到 0.4811,相比此前最强基线 GIF-MCTS 的 0.3488 提升了 +0.132;并且在离散动作空间的预测准确率上与强基线持平(0.917 vs 0.914)。这说明,性能的提升并非来自单纯的下一帧预测相似度,而是源于模型实现了 “可用于规划的行为级一致性”,真正支撑起了下游控制任务。

3. ByteSized32 (Text Games)

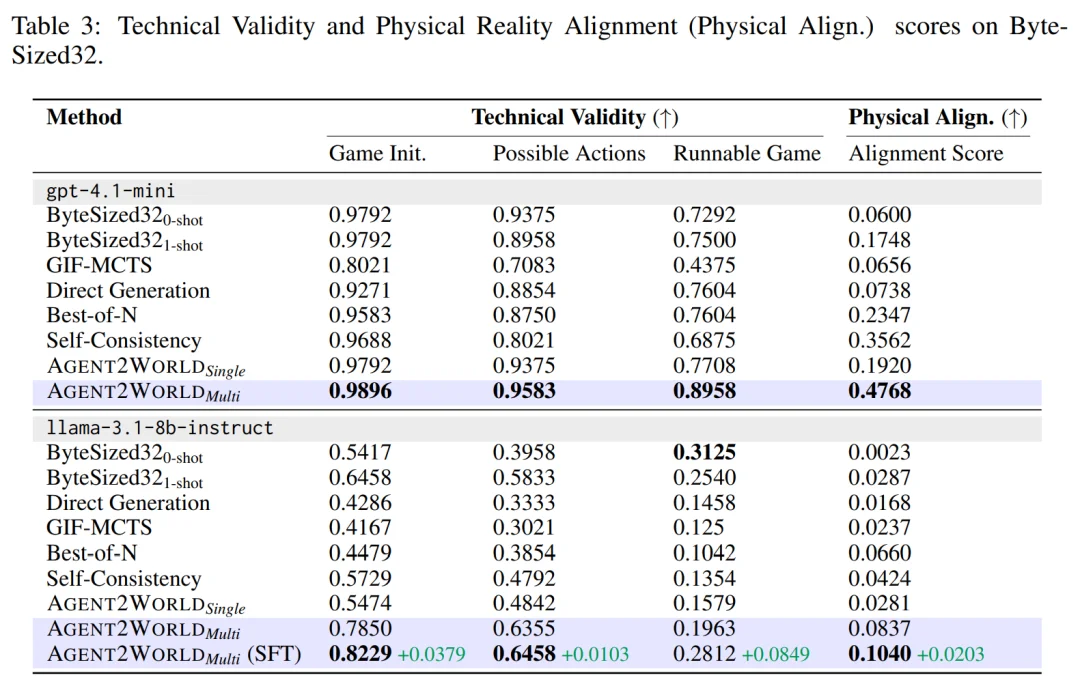

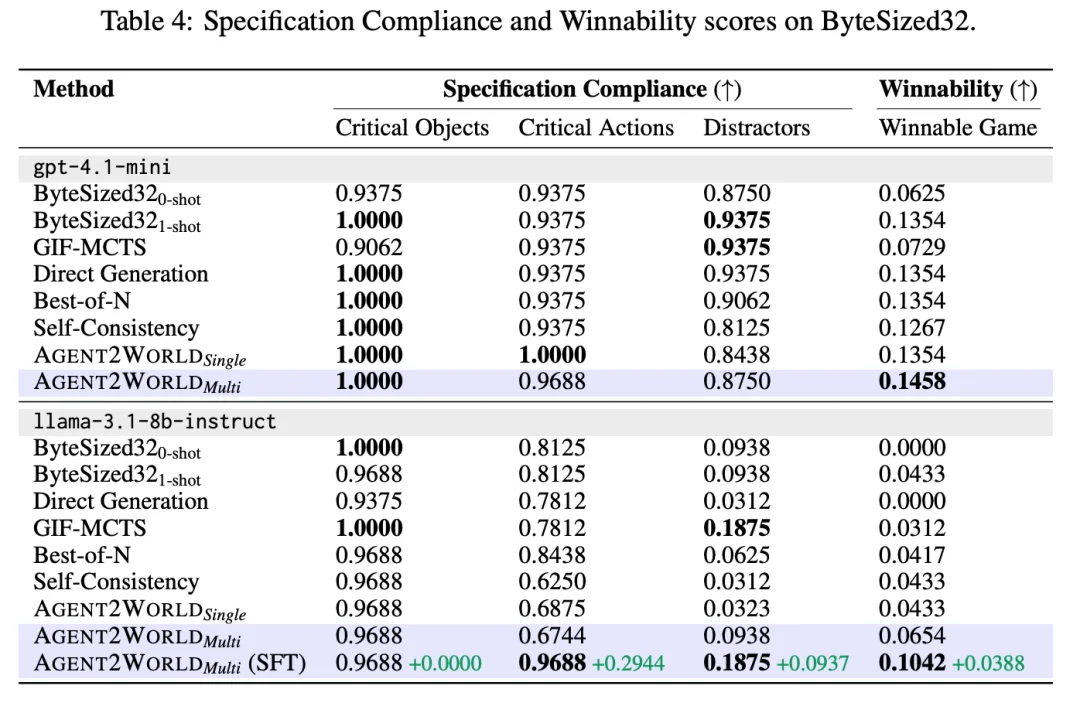

常识推理与物理现实的高度一致性。在极度依赖常识推理的文本游戏中,Deep Researcher 的主动知识检索发挥了很大的作用。Agent2World Multi 在核心指标 “物理现实对齐度(Physical Reality Alignment)” 上取得了 0.4768 的高分,相比单智能体版本(Single Agent)大幅提升了 0.2848 。 此外,在技术有效性(Technical Validity)上,模型生成的游戏代码初始化成功率接近 99% 。这些数据表明,通过引入外部知识与多轮测试,模型成功消除了大量违反常识的 “物理幻觉”(如错误的状态转移或不合逻辑的物品交互),生成了逻辑严密且更稳定的文本环境。

基于自主合成的高质量轨迹数据(训练仅使用 Model Developer 轨迹),团队对 Llama-3.1-8b-instruct 进行了监督微调。实验表明,这种 “以 Agent 养 Model” 的策略带来了显著的泛化能力提升:微调后的模型在未见过的测试任务(Unseen Tasks)上,平均相对性能提升了 30.95%。特别是在 Text2World 任务中,模型生成的代码可执行率(Executability)提升高达 16.9%。这有力证明了,无需依赖昂贵的超大模型,仅凭小参数模型配合优质的 “自我修正” 合成数据,也能实现向高性能世界模型构建者的跨越。

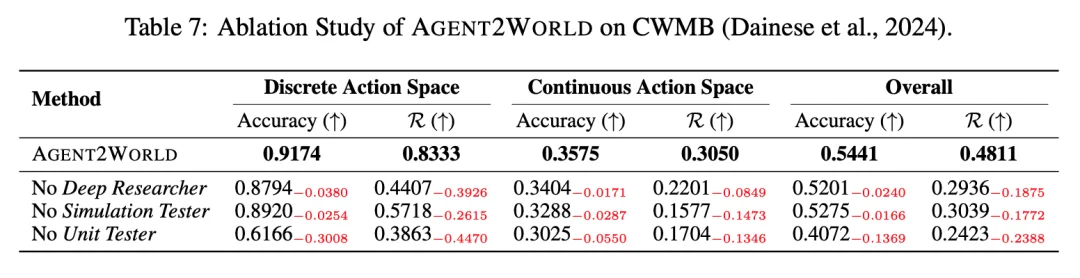

缺一不可的双引擎(基于 CWMB 验证) 为了探究 Agent2World 卓越性能的来源,团队在 CWMB(物理控制) 任务上进行了严苛的组件消融实验。结果证实,Deep Researcher 与 Testing Team 均是构建高可靠世界模型不可或缺的组件:

Agent2World 的提出,标志着统一多智能体框架在符号世界模型生成领域的成功应用。它不仅打破了 PDDL 规划与可执行代码之间的表征壁垒,更通过 "网络知识合成 - 迭代式模型开发 - 评估驱动仿真测试" 的精密闭环,在无需人工标注与人工验收的前提下,实现自动化的生成 — 测试 — 修复闭环,从而稳定产出可执行、可复现、可迭代的符号世界模型。这一突破不仅在三大基准测试中一致性地刷新了 SOTA,更为未来 AI 系统从自然语言中可靠地理解并形式化复杂的现实环境,开辟了全新的可能性。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【免费】ffa.chat是一个完全免费的GPT-4o镜像站点,无需魔法付费,即可无限制使用GPT-4o等多个海外模型产品。

在线使用:https://ffa.chat/

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner