核心速览:

在具身智能的浪潮中,我们已经见证了仿真训练的巨大成功。然而,当我们试图将智能带入真实世界时,却撞上了一堵看不见的墙:

真实世界的策略学习(Real-World Policy Learning),不仅是算法的挑战,更是系统的挑战。

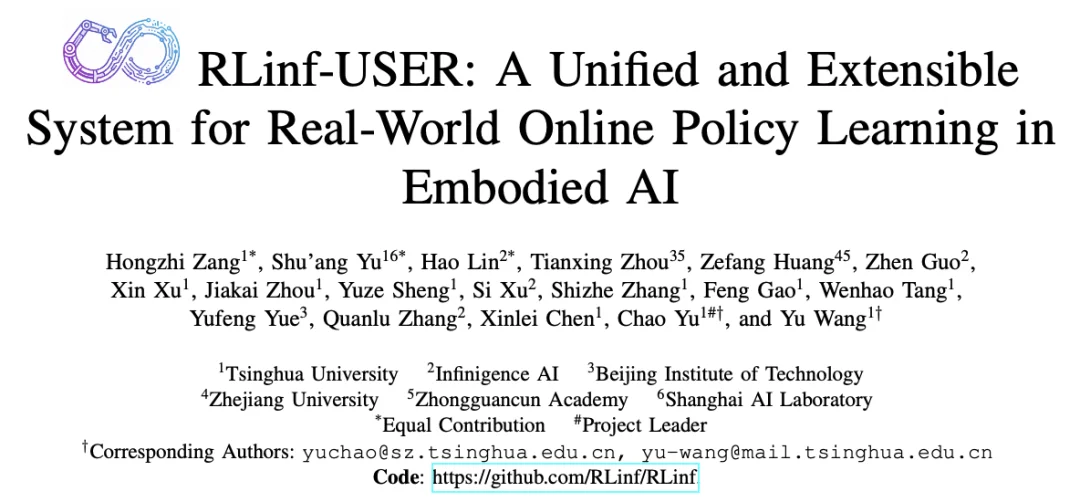

今天,我们正式介绍 RLinf-USER —— 一个专为真实世界在线策略学习打造的统一且可扩展的系统。它不只是一个训练框架,更是连接数字大脑与物理躯体的 “神经系统”,是实现千台机器人物理世界策略进化的关键一环。

RLinf-USER (Unified and Extensible SystEm for Real-World Online Policy Learning) 是基于 RLinf 基础设施构建的专用系统。它的核心理念只有一个:将物理世界的复杂性,封装为简洁的计算流。

图 1 RLinf-USER 是基于 RLinf 构建的真机强化学习专用系统

系统设计:

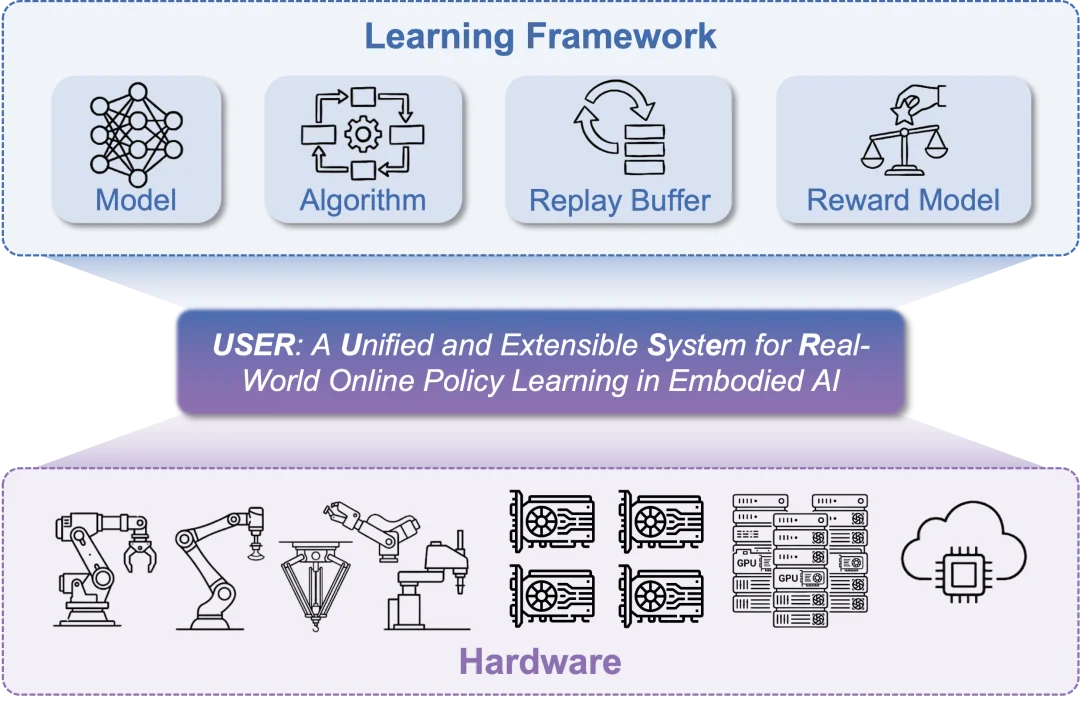

🤖 设计 1. 机器人即计算 (Robot as Compute)

RLinf 首次提出 “像使用 GPU 一样使用机器人” 的概念。在 RLinf-USER 中,机器人不再是游离于集群之外的 “设备”。通过统一硬件抽象层 (HAL),物理机器人被虚拟化为与 GPU/TPU 同等的可调度资源。

🌐 设计 2. 云边端无缝协同 (Adaptive Cloud-Edge Link)

大模型在云端,机器人在边缘。RLinf-USER 构建了一个自适应通信平面:

图 2 RLinf-USER 系统设计总览:统一硬件抽象层与自适应通信平面

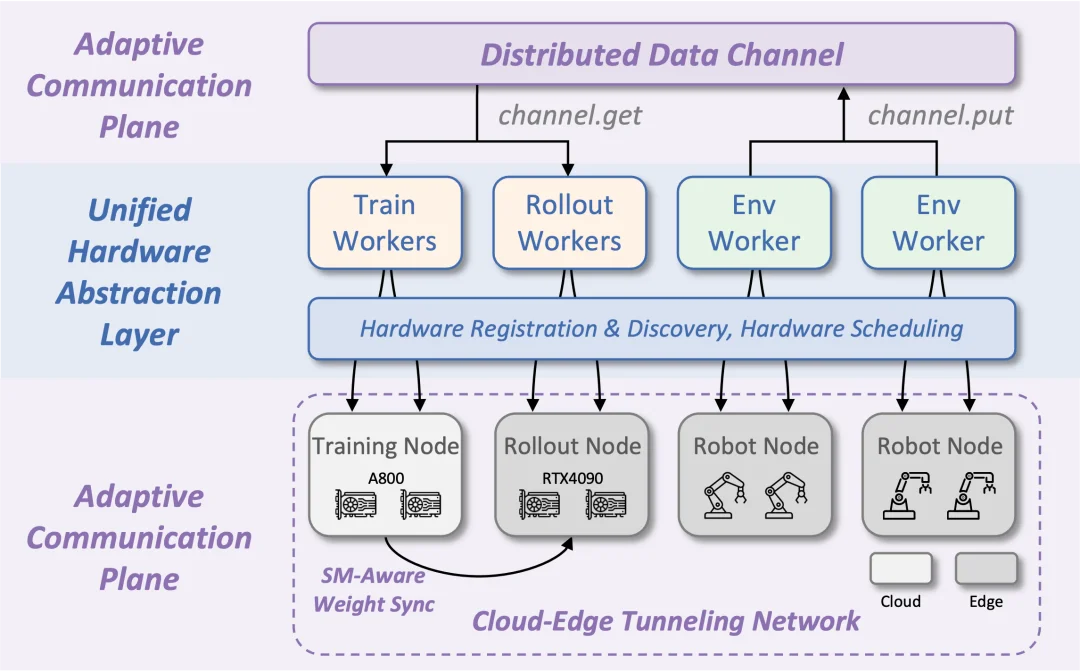

学习框架设计:

图 3 RLinf-USER 学习框架设计总览

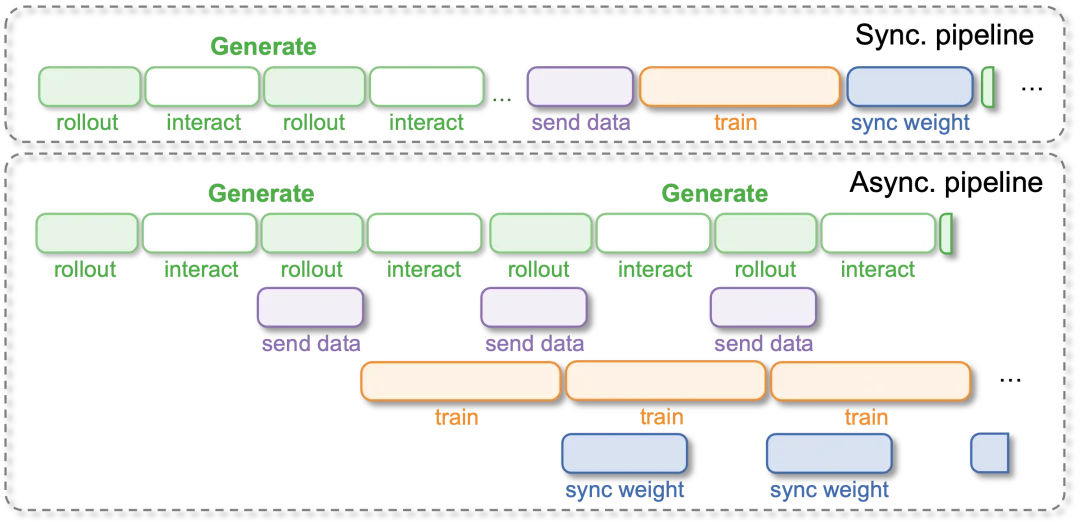

⚡️ 设计 3. 全异步进化引擎 (Fully Asynchronous Pipeline)

真实世界不能等待。传统的 “采集 - 训练” 同步循环会让机器人把大量时间浪费在等待计算上。

RLinf-USER 采用了全异步流水线设计:

图 4 全异步流水线

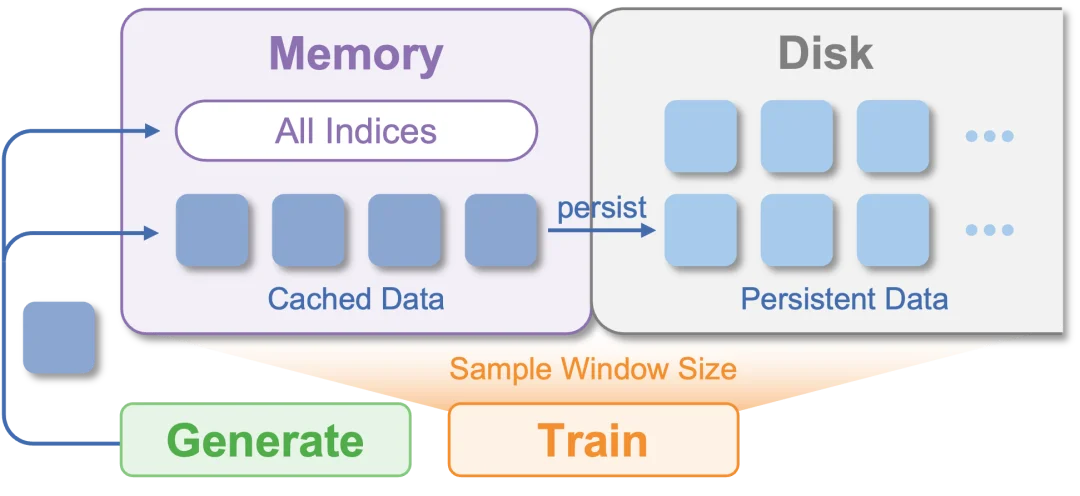

💾 设计 4. 数据的 “时光机” (Persistent-Cache-Aware Buffer)

我们设计了持久化缓存感知缓冲区:

图 5 持久化缓存感知 buffer

🧠 设计 5. 丰富的在线学习组件支持

USER 在统一的接口下,支持了多样的学习组件,模块化的设计易于二次开发:

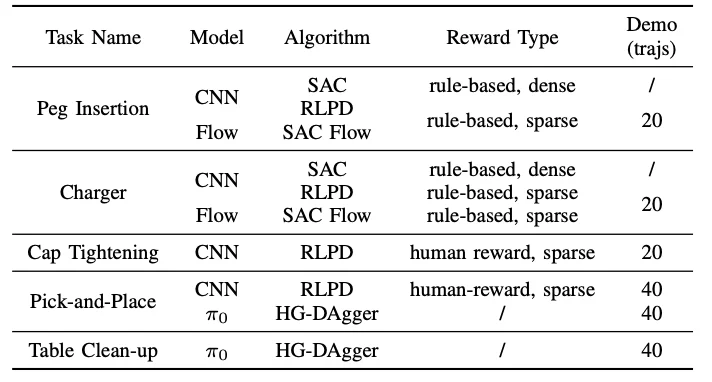

RLinf-USER 在 5 个真实任务中证明了效率和性能。

图 6 在 5 个真实世界任务上验证 USER,对应不同的 reward、算法、策略

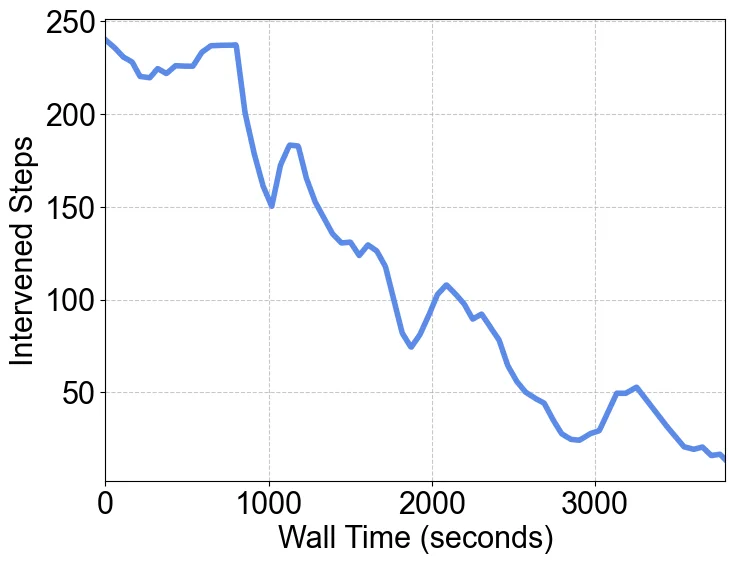

🏆 战绩一:VLA 大模型的在线进化

这是目前少有的支持 3B 参数 VLA 模型(PI0)在真实世界进行在线微调的系统。

图 7 USER 框架使用 HG-DAgger 算法微调 PI0 模型。人工干预次数显著下降,成功率从 45%->80%

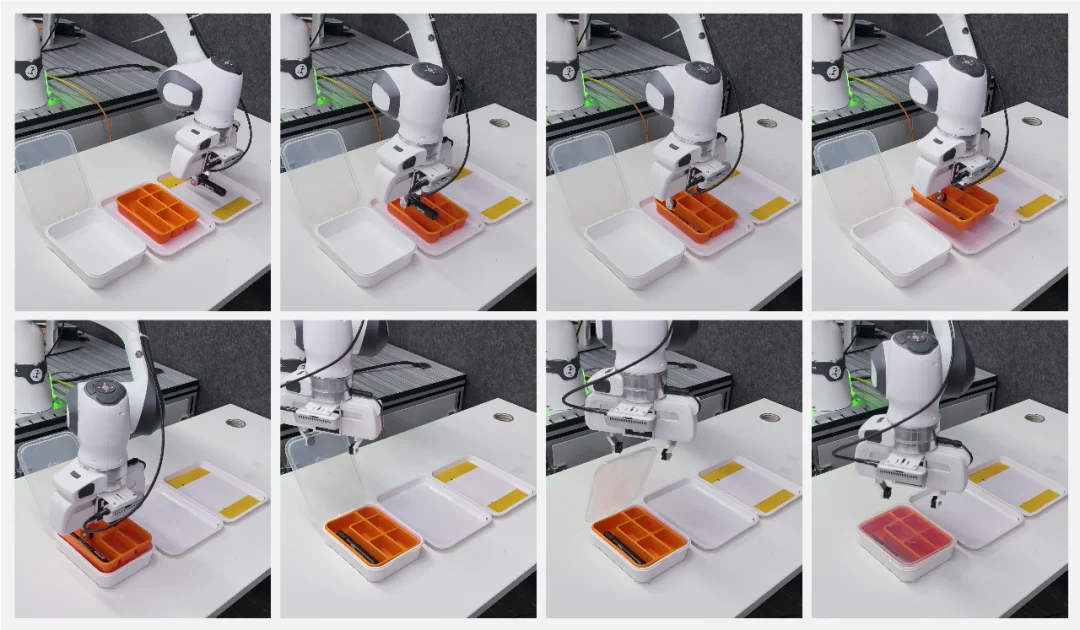

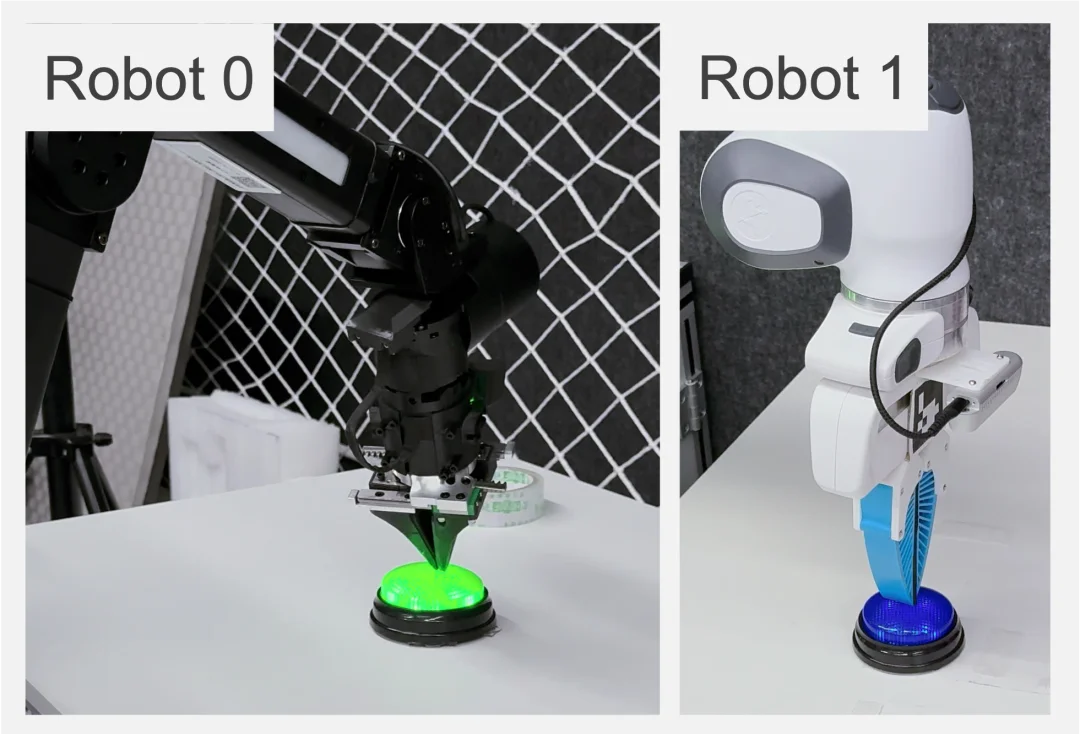

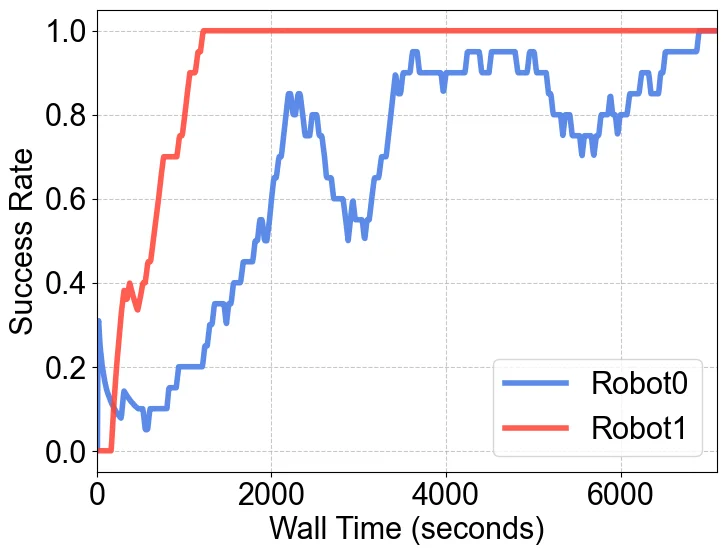

🤝 战绩二:异构机器人 “大一统”

RLinf-USER 完成了一项极具挑战的实验:让两种完全不同的机器人一起学习。

图 8 使用 USER 进行异构训练

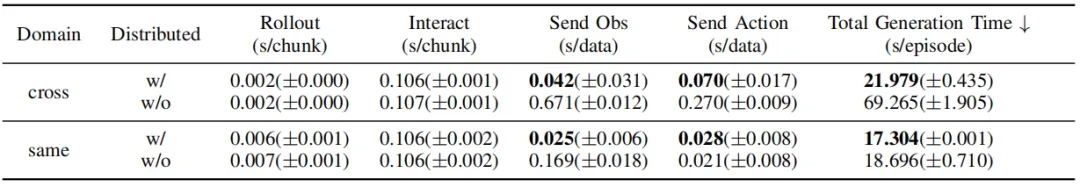

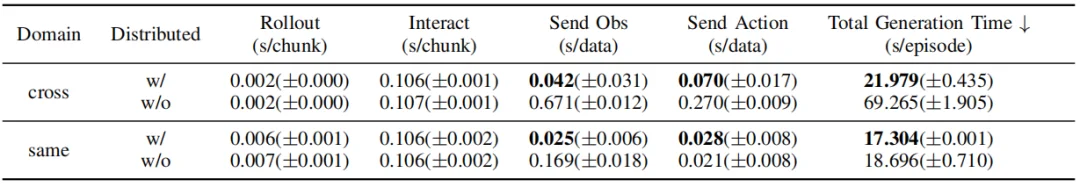

☁️ 战绩三:跨越千里的 “云 - 边” 协同

针对大模型训练算力在云端、机器人执行在边缘端的典型场景,RLinf-USER 克服了物理距离和网络隔离的障碍。

图 9 USER 自适应通信平面显著降低了跨域部署的通信延迟

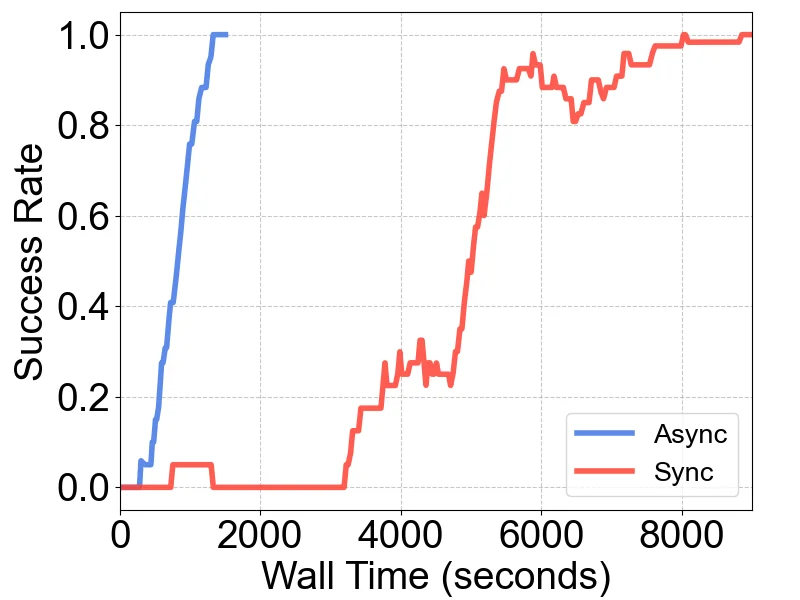

⏱️ 战绩四:异步 vs 同步架构速度的碾压

在经典的插孔(Peg Insertion)任务中:

效率提升超过 5 倍,让原本漫长的训练过程变得立等可取。

图 10 USER 的全异步工作流显著提升了物理世界中算法的收敛速度

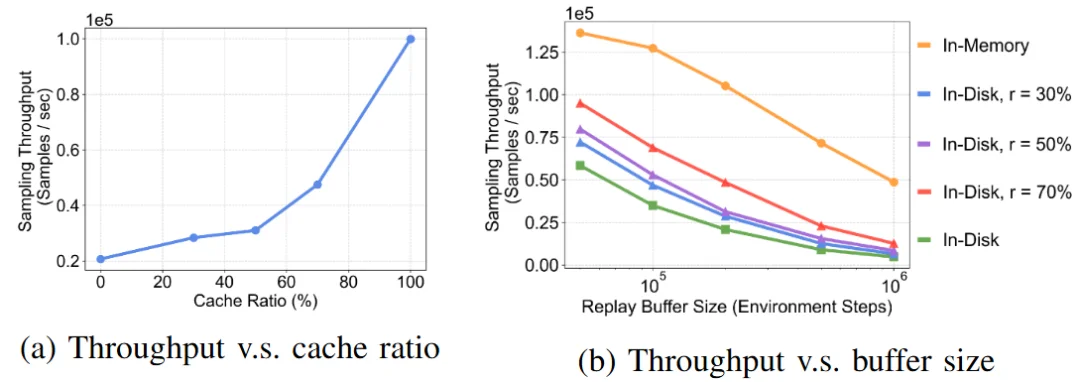

💾 战绩五:打破 “内存墙”,数据的无限记忆与极速吞吐

在真实世界长周期(Long-horizon)的训练中,数据是极其宝贵的资产。针对传统 Buffer “存不下” 或 “读得慢” 的痛点,RLinf-USER 拒绝妥协。

图 11 RLinf-USER 的 Buffer 在不同配置下的吞吐量性能测试,平衡了容量与效率

如果说 ChatGPT 是 AI 在数字世界的里程碑,那么 RLinf-USER 致力于成为具身智能在物理世界的基石。

✅ 如果你是研究者:它兼容 CNN、Flow-based policy、VLA 等多种策略,支持 RL、IL、Human-in-the-loop 等各种算法。它将模型、算法等模块解耦,简化开发难度。

✅ 如果你是工程师:它提供了工业级的稳定性(崩溃恢复)和扩展性(自动硬件发现),让大规模机器人集群管理变得像管理服务器一样简单。

此时此刻,机器人不再只是外设。RLinf-USER,让智能真正 “具身”。

RLinf 发布半年,Github Star 2.5k+,得到了学术界和工业界的广泛认可,达成了多项战略合作,包括英伟达 IssacLab、原力灵机 Dexbotic 等,更多家合作官宣也会尽快和大家见面。道阻且长,26 年 RLinf 仍在为搭建更好的具身智能基础设施而努力,并持续做好可复现生态。团队也开放招生和招聘,欢迎大家联系于超老师(邮件:zoeyuchao@gmail.com)

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner