时序大模型,参数规模突破十亿级别。

来自全球多只华人研究团队提出了一种基于混合专家架构(Mixture of Experts, MoE)的时间序列基础模型——Time-MoE。

据了解,该模型首次将时间序列预训练大模型的参数规模推向十亿级别。

Time-MoE模型通过MoE架构的独特优势,将模型参数成功扩展至24亿,不仅显著提升了预测精度,还在降低计算成本的同时超越了众多现有模型,全面达到了SOTA(State of the Art)水平。

与此同时,团队精心整理了预训练数据集Time-300B,这是目前时序领域最大的公开数据集,为各类时序任务提供了通用解决方案。

这篇文章主要有以下三点技术突破:

强大的混合专家架构:Time-MoE采用稀疏激活机制,在预测任务中仅激活部分网络节点,这不仅确保了高预测精度,还显著降低了计算负担,完美解决了时序大模型在推理阶段的计算瓶颈。

灵活的预测范围:Time-MoE支持任意长度的输入和输出范围,能够处理从短期到长期的各种时序预测任务,实现了真正的全域时序预测。

全球最大规模的开源时序数据集:团队开发了Time-300B数据集,涵盖9个领域的超过3000亿个时间点,为模型提供了丰富的多领域训练数据,确保其在多种任务中的卓越泛化能力。

在相同激活参数条件下,Time-MoE显著超越了现有的时序基础模型。在相同的FLOPs下,其稀疏架构展现出相较于密集模型的卓越精度优势。

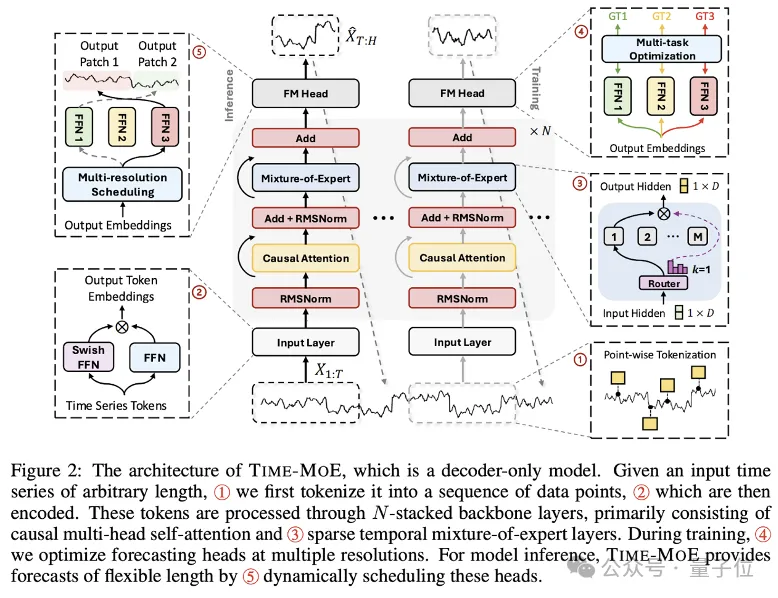

模型框架:

输入Token Embedding

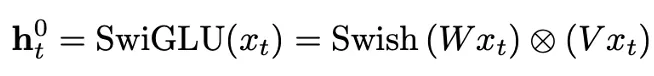

Time-MoE使用逐点分词方法以确保时间序列信息的完整性,提高了模型处理不同长度序列的灵活性与适用性,如模型框架图中①所示。在②中,SwiGLU激活函数对每个时间序列点进行嵌入,其中包括一个Feed-forward network (FFN) 和一个Swish FFN,从而增强模型对多维输入的处理能力:

MoE Transformer模块

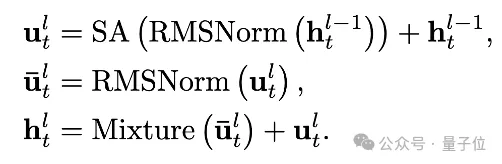

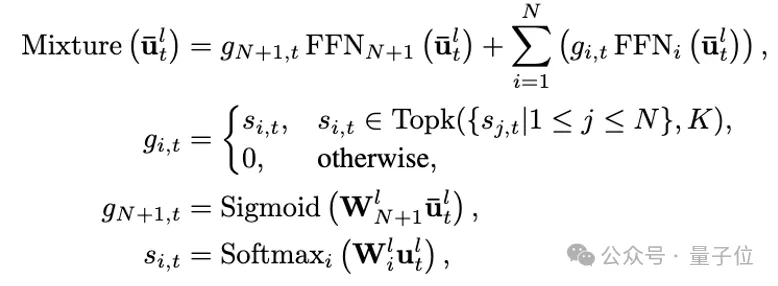

Time-MoE基于decoder-only Transformer,并结合了大规模语言模型中的最新技术。Transformer模块里, RMSNorm对每个子层输入进行了归一化处理,从而提升了训练的稳定性。同时,采用旋转位置编码代替绝对位置编码,使得模型在处理可变序列长度时具备更好的外推能力。此外,模型引入了稀疏激活的混合专家层来取代标准Transformer模块里的FFN。公式化概括如下:

其中Mixture代表混合专家层。如模型框架图中③所示,单个时间序列数据点可以被分配给一个或多个专家。通过选择部分专家网络来处理特定时间点的输入,模型的计算效率得到了提高。

多分辨率预测

如模型框架图中④和⑤所示,Time-MoE设计了一种多分辨率预测头,可以同时进行不同尺度的预测,突破了单一尺度预测的局限。在训练时,不同分辨率头会被联合优化。

在与推理时,模型采用贪心算法,利用不同尺度的输出组合成任意的预测长度。这种设计允许模型根据不同的预测范围进行灵活预测,并在训练过程中综合多个预测尺度的误差来优化模型的泛化能力,从而显著提升预测的准确性和鲁棒性。

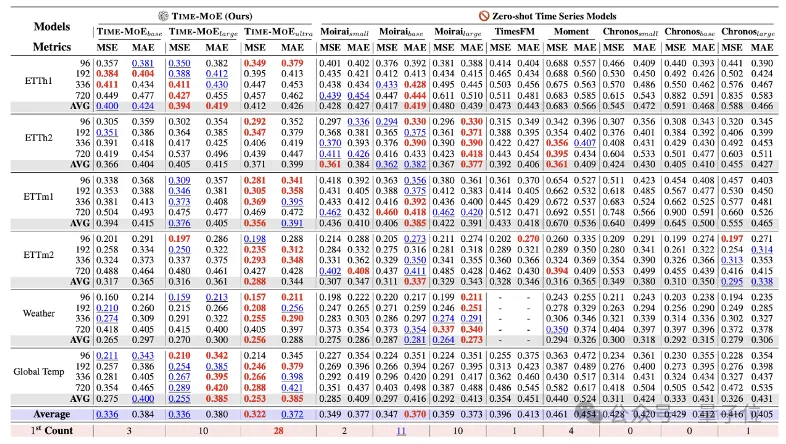

零样本Zero-shot预测

零样本预测能有效检验时序基础模型的泛化能力和通用性。实验表明,与现有的时序基础模型相比,Time-MoE达到了最好的预测效果,均方误差(MSE)降低了约20%。

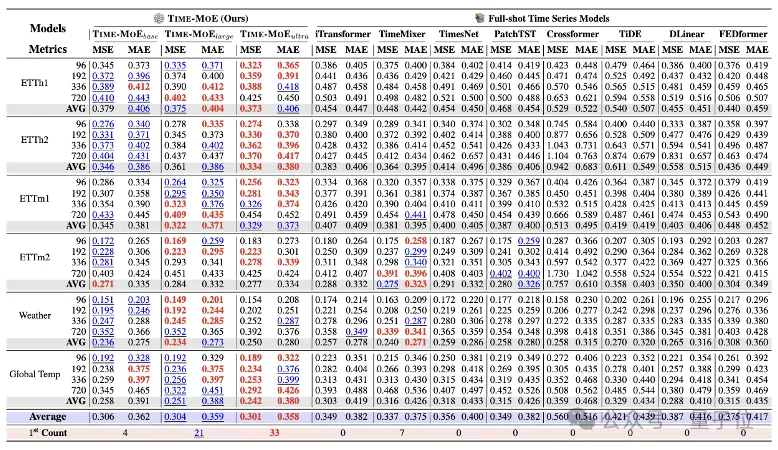

全样本Full-shot预测

在全样本预测中,预训练的Time-MoE会使用相应数据的训练集进行微调。

实验表明,与专门为全样本预测设计的时序模型相比,Time-MoE依然能达到最优的效果, MSE降低了约24%。这体现了模型对于不同领域数据的适用性,以及预训练基础模型对于下游任务帮助的有效性。

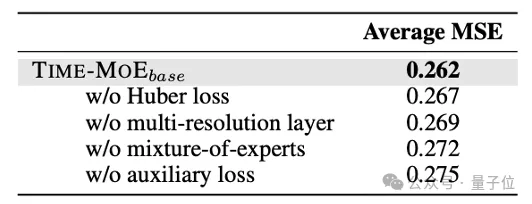

消融实验

文中进一步提供了一系列消融实验来验证模型框架设计的合理性。实验表明,Time-MoE的设计在提升模型精度上是有效的。特别地,在不使用混合专家的情况下,模型的MSE会有明显的退化。

Scalability 分析

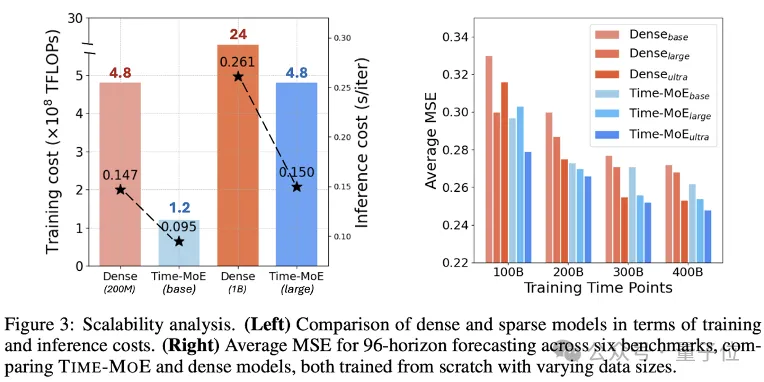

作者对于模型的规模化效果进行了详细分析,如下图所示。左图的实验表明,与稠密模型相比,稀疏模型减少了平均78%的训练成本和39%的推理成本。右图的结果表明,随着数据量和模型参数的增大,Time-MoE持续表现出稳定的性能提升,并且与同规模的稠密模型相比,总能达到更小的MSE和更好的预测性能。

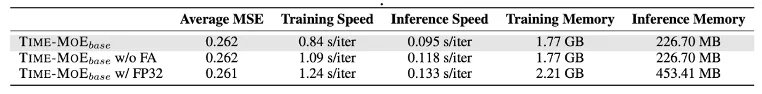

此外,作者还分析了训练精度的影响。如下表所示,与使用float32精度进行训练相比,使用bfloat16精度能得到相似的预测性能,但是bfloat16模型能在训练速度上获得12%的提升,内存占用上有 20%的减少。

此外,bfloat16还可以与flash-attention(表中简称为FA)无缝结合,从而进一步在训练和推理速度上带来23%和19%的提升。

Time-MoE不仅在性能上超越了现有模型实现SOTA,更为构建大规模、高效、通用的时序预测基础模型提供一个可行的范式。除此之外,Time-MoE在工业界的多种时序场景也很有应用潜力,比如在能源管理、金融预测、电商销量、气象预报等领域。

论文地址:

https://arxiv.org/pdf/2409.16040

Github地址:

https://github.com/Time-MoE/Time-MoE

文章来自于微信公众号“量子位”,作者“TimeMoE团队”