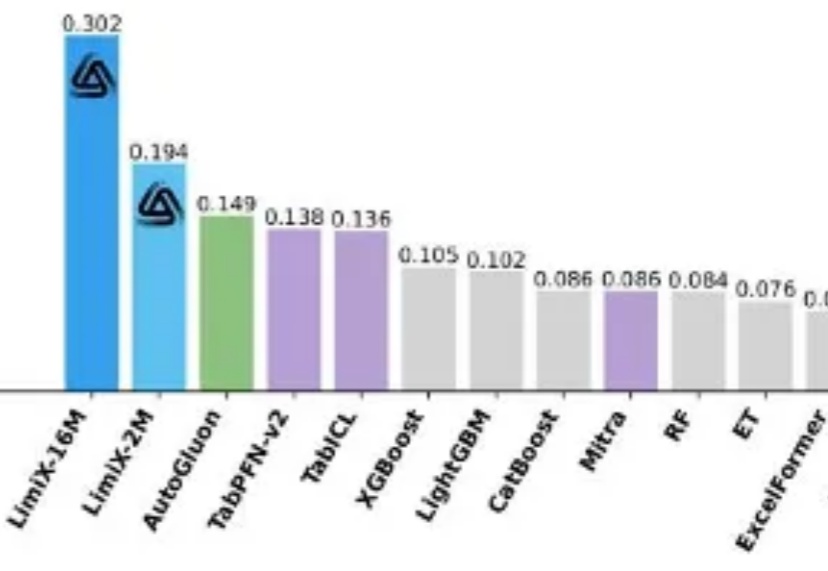

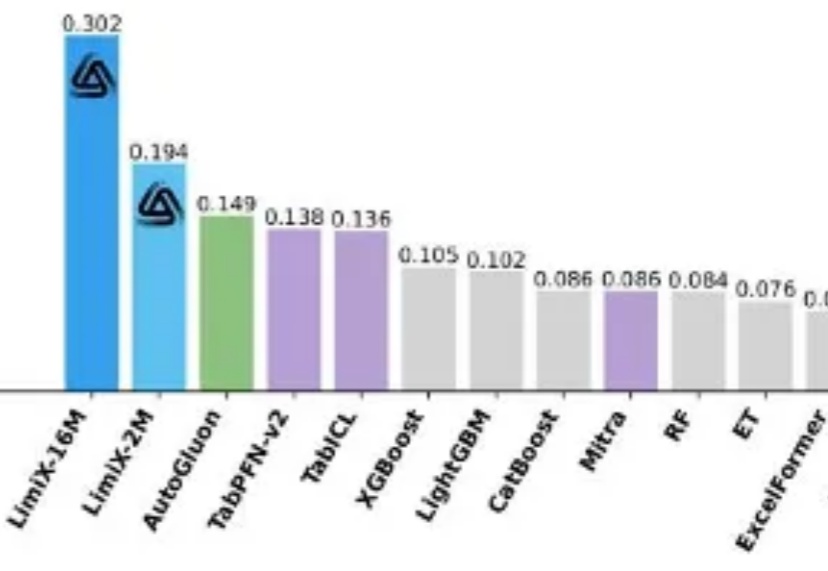

2M大小模型定义表格理解极限,清华大学崔鹏团队开源LimiX-2M

2M大小模型定义表格理解极限,清华大学崔鹏团队开源LimiX-2M提到 AI 的突破,人们首先想到的往往是大语言模型(LLM):写代码、生成文本、甚至推理多模态内容,几乎重塑了通用智能的边界。但在一个看似 “简单” 的领域 —— 结构化表格数据上,这些强大的模型却频频失手。

提到 AI 的突破,人们首先想到的往往是大语言模型(LLM):写代码、生成文本、甚至推理多模态内容,几乎重塑了通用智能的边界。但在一个看似 “简单” 的领域 —— 结构化表格数据上,这些强大的模型却频频失手。

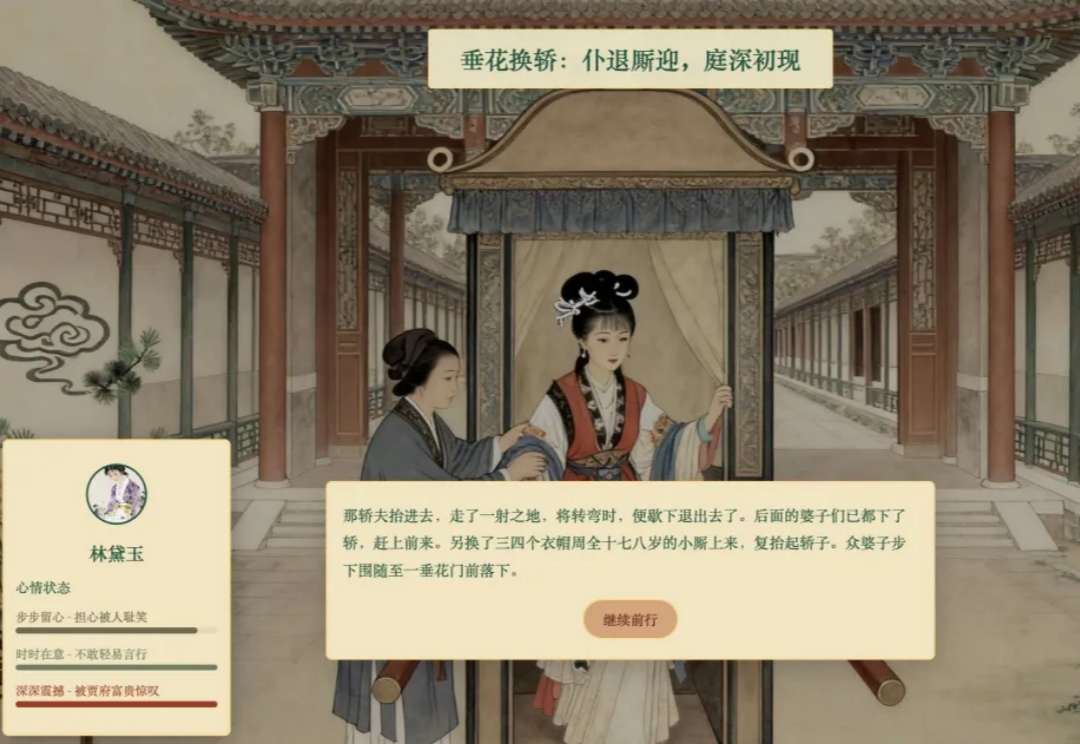

“一位老师,用 AI 做了个《林黛玉初进贾府》的互动游戏。”

本文档分析 CAMEL 项目中 hybrid_browser_toolkit 的技术实现,覆盖其架构设计、核心功能与通信协议。

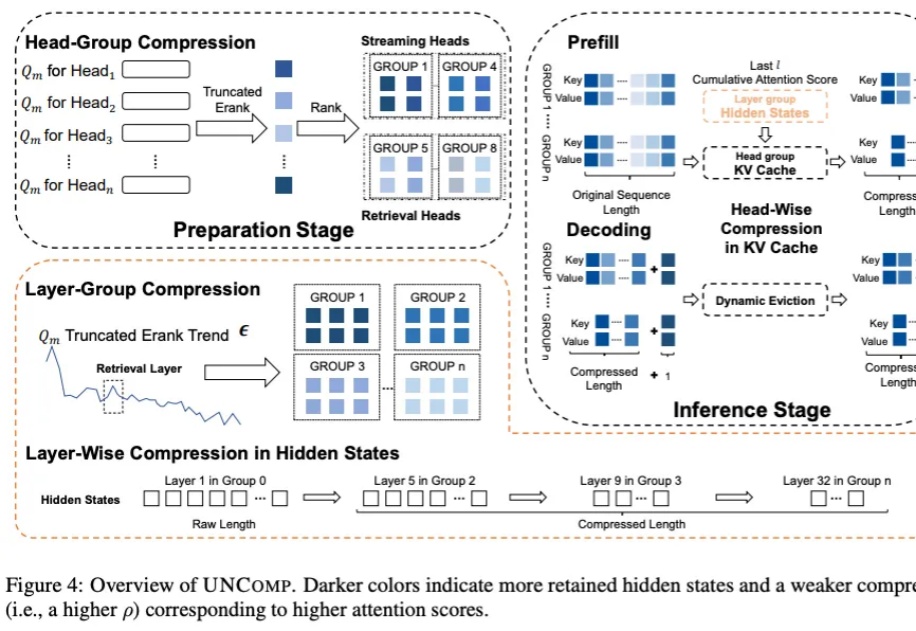

我们都知道 LLM 中存在结构化稀疏性,但其底层机制一直缺乏统一的理论解释。为什么模型越深,稀疏性越明显?为什么会出现所谓的「检索头」和「检索层」?

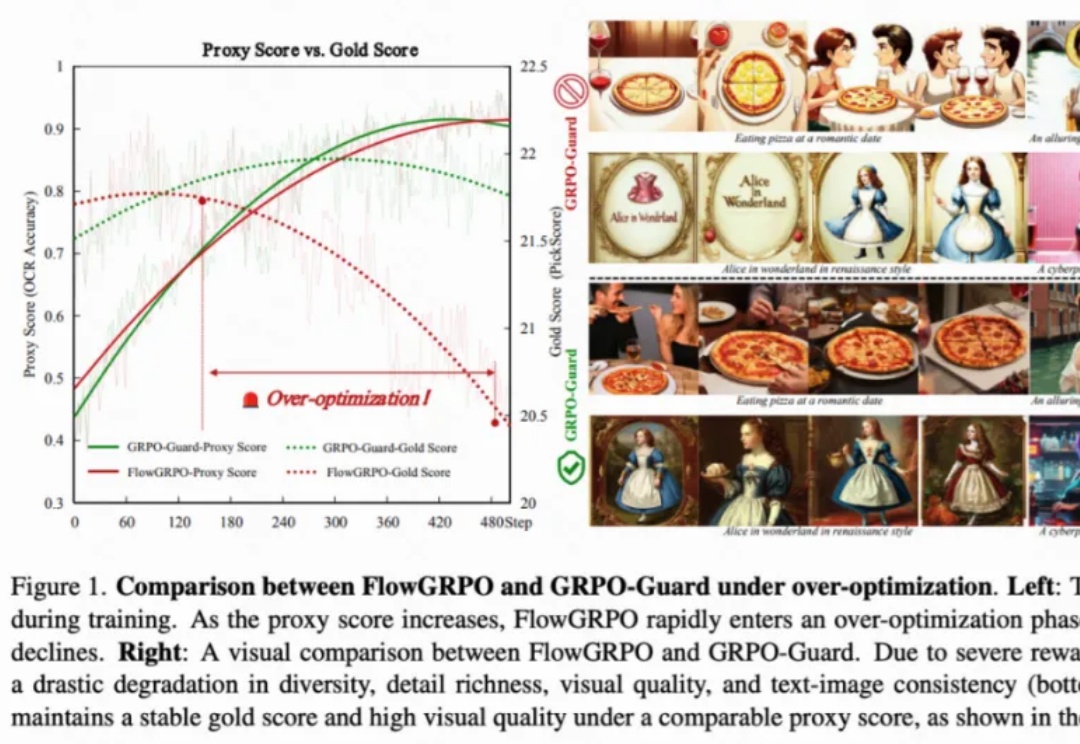

目前,GRPO 在图像和视频生成的流模型中取得了显著提升(如 FlowGRPO 和 DanceGRPO),已被证明在后训练阶段能够有效提升视觉生成式流模型的人类偏好对齐、文本渲染与指令遵循能力。

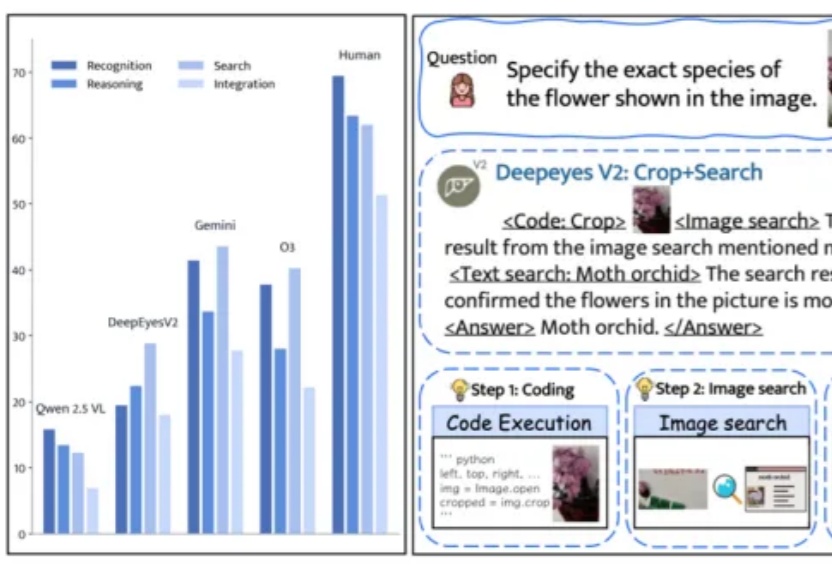

还记得今年上半年小红书团队推出的DeepEyes吗?

科学家用 AI 预测细胞未来的命运照进了现实——在虚拟世界中重塑生命系统,这对药物发现、早期筛选和疾病预防至关重要。

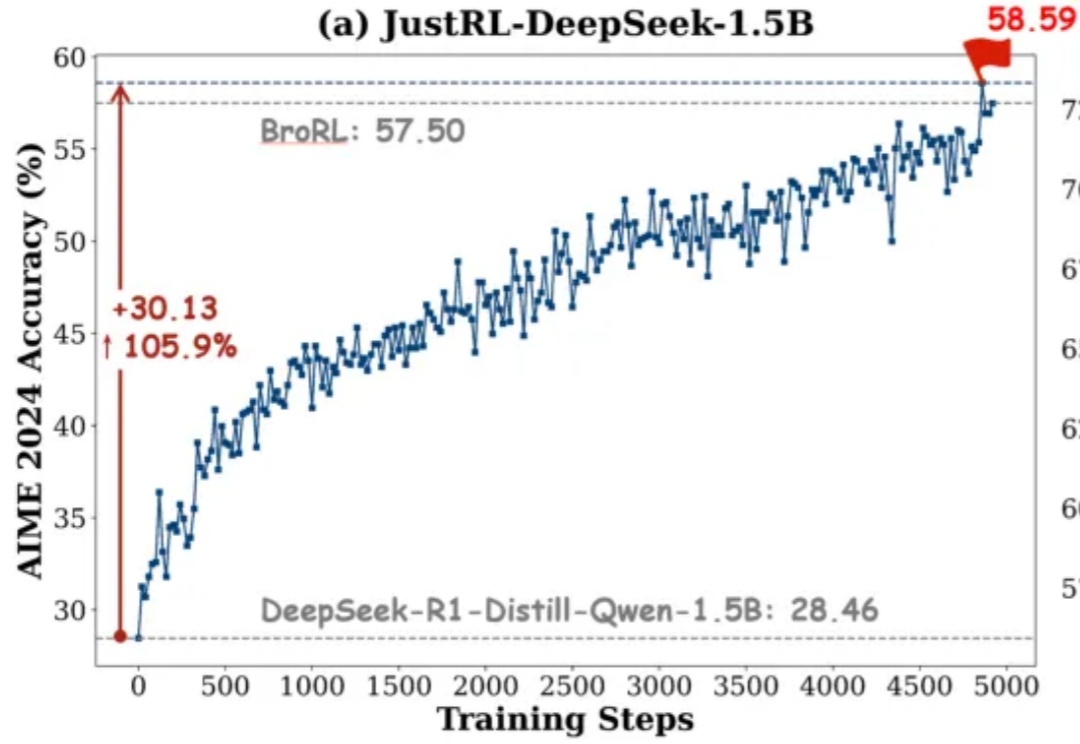

如果有人告诉你:不用分阶段做强化学习、不搞课程学习、不动态调参,只用最基础的 RL 配方就能达到小模型数学推理能力 SOTA,你信吗?

我们长期把LLM当成能独闯难关的“单兵”,在很多任务上,这确实有效。

华中科技大学团队推出首个水下多模态大模型NAUTILUS,支持8种水下场景理解任务,并开源145万图文对的NautData数据集。模型通过视觉特征增强模块解决水下图像模糊和颜色失真问题,性能超越现有模型,恶劣环境下表现更佳。

复杂的简历,AI也能读懂了。

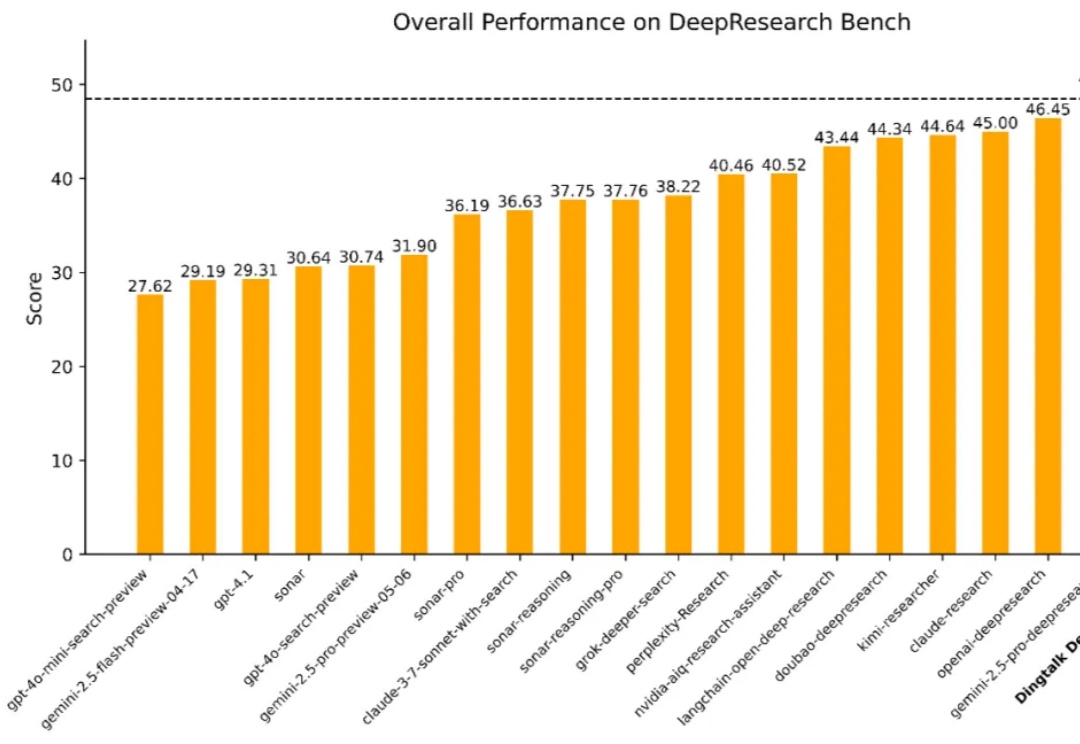

在数字经济浪潮中,企业对于高效、精准的信息获取与决策支持的需求日益迫切。从前沿科学探索到行业趋势分析,再到企业级决策支持,一个能够从海量异构数据源中提取关键知识、执行多步骤推理并生成结构化或多模态输出的「深度研究系统」正变得不可或缺。

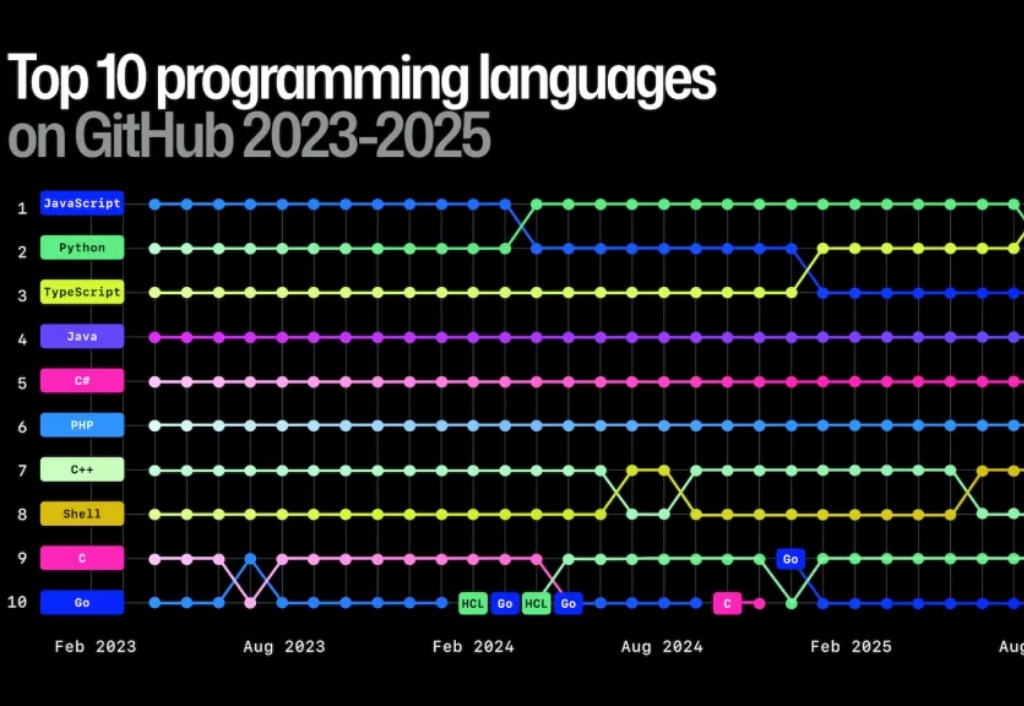

开发者最常使用的编程语言是什么?相信很多人都会不假思索地选择 Python。

浙江大学和新加坡南洋理工大学新研究旨在探索空间碳中和数据中心的可行性。太空环境具备两大独特优势:丰富的太阳能可为计算设备提供清洁稳定的电力;接近绝对零度的深空环境则为服务器废热提供了理想的散热条件。

麦肯锡刚刚发布了2025年AI最新报告,一组数据让人“破防”:88%的组织都在用AI,但只有39%的组织吃出了“真金白银”。这份《The state of AI in 2025》回答了AI时代大家都很关心的一个问题:

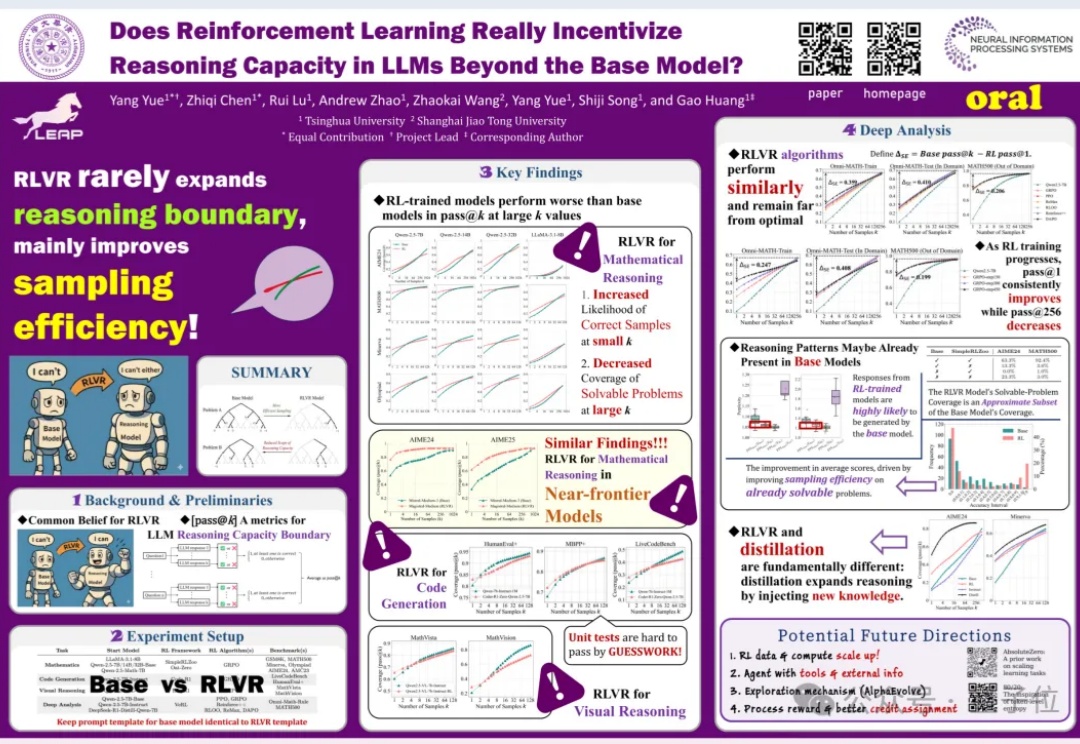

四个审稿人全给6分,NeurIPS唯一满分论文炸了!

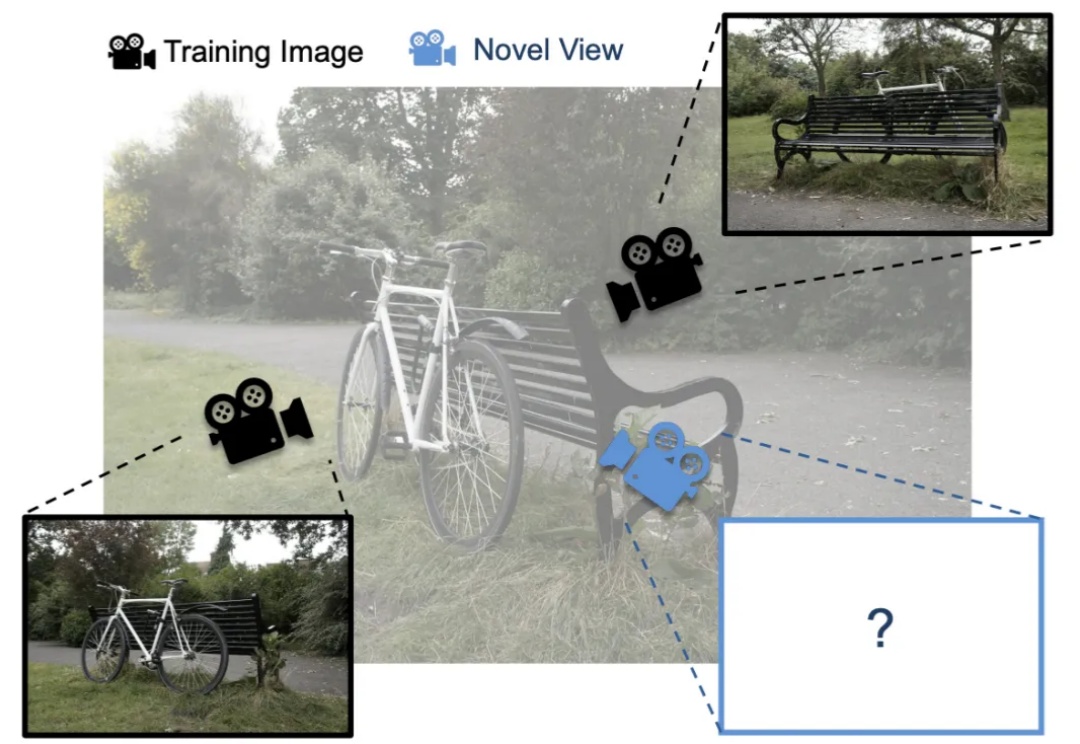

3D Gaussian Splatting (3DGS) 是一种日益流行的新视角合成方法,给定 3D 场景的一组带位姿的图像(即带有位置和方向的图像),3DGS 会迭代训练一个场景表示,该表示由大量各向异性 3D 高斯体组成,用以捕捉场景的外观和几何形状。

英伟达在聚光灯下狂飙,谷歌却在幕后悄悄造出自己的AI基建帝国系统。当别人还在抢GPU时,它早已自给自足、闭环生长——闷声干大事,从未如此谷歌。

临床诊断并非一次性的「快照」,而是一场动态交互、不断「探案」的推理过程。然而,当下的大模型大多基于静态数据训练,难以掌握真实诊疗中充满不确定性的多轮决策轨迹。如何让AI学会「追问」、选择检查,并一步步抽丝剥茧,迈向正确诊断?

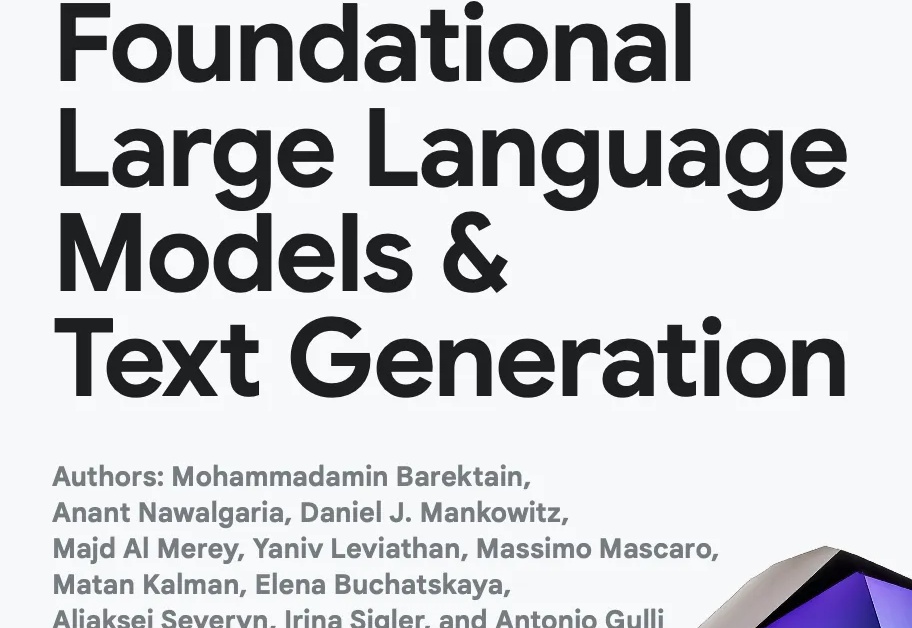

2025年末,谷歌通过Kaggle平台,以前所未有的力度,连续推出了两个为期五天的线上强化课程。这不仅仅是两次普通的线上分享,更像是一场由谷歌顶级机器学习(ML)研究员和工程师亲自引领的、深入探索生成式AI及其前沿应用——AI Agents(人工智能代理)的集训。

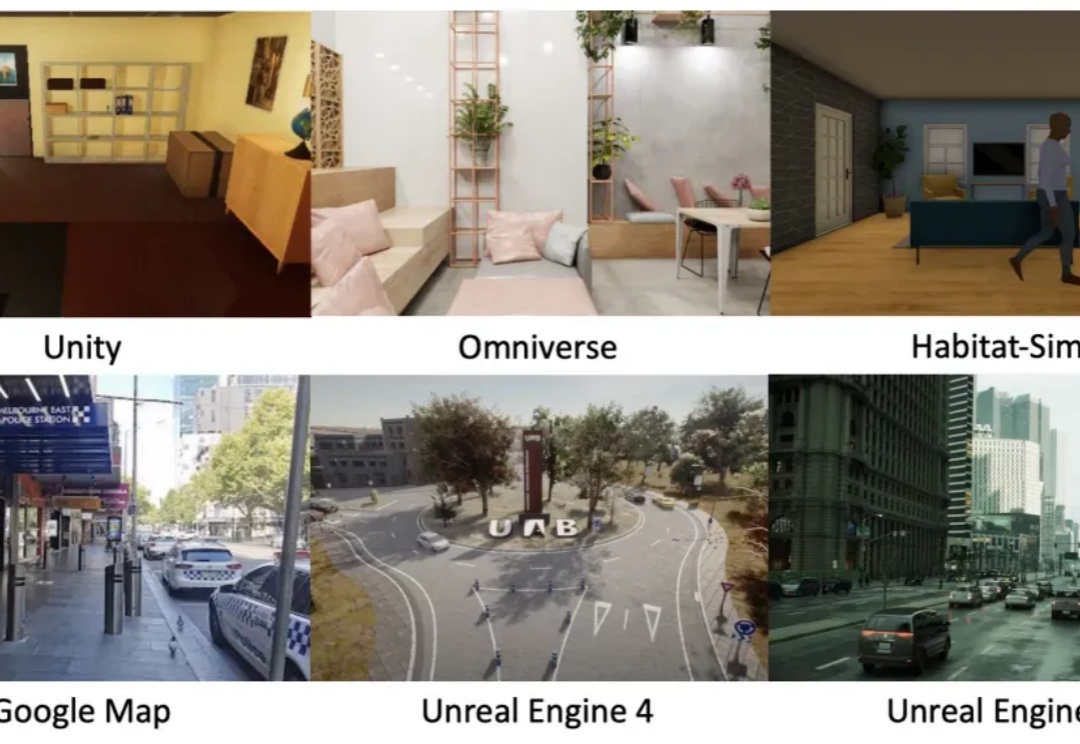

你是否曾为搭建具身仿真环境耗费数周学习却效果寥寥? 是否因人工采集海量交互数据需要高昂成本而望而却步? 又是否因找不到足够丰富真实的开放场景让你的智能体难以施展拳脚?

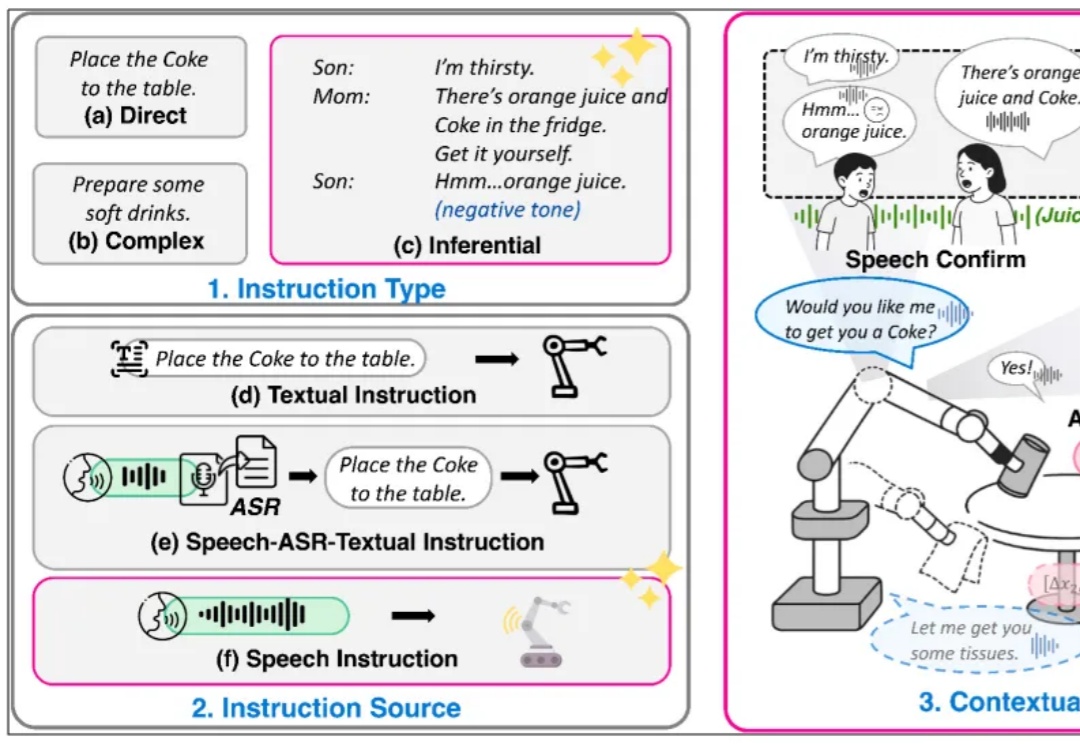

复旦⼤学、上海创智学院与新加坡国立⼤学联合推出全模态端到端操作⼤模型 RoboOmni,统⼀视觉、⽂本、听觉与动作模态,实现动作⽣成与语⾳交互的协同控制。开源 140K 条语⾳ - 视觉 - ⽂字「情境指令」真机操作数据,引领机器⼈从「被动执⾏⼈类指令」迈向「主动提供服务」新时代。

在一场矿难救援中,时间意味着生命。想象一台搜救机器人在部分坍塌的矿井中穿行:浓烟、碎石、扭曲的金属梁。它必须在险象环生的环境中迅速绘制地图,识别路径,并精准定位自己的位置。

我日常最常用的 AI,不是 ChatGPT,也不是 Gemini 官网。

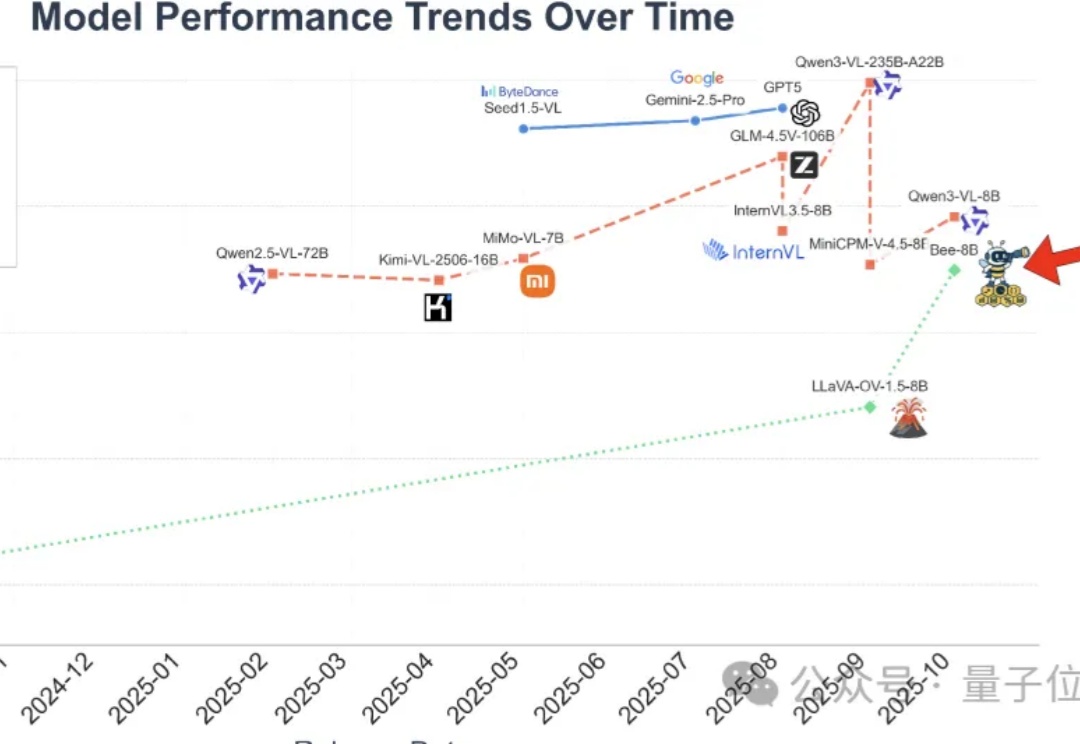

全开源多模态大模型(MLLM)的性能,长期被闭源和半开源模型“卡脖子”。

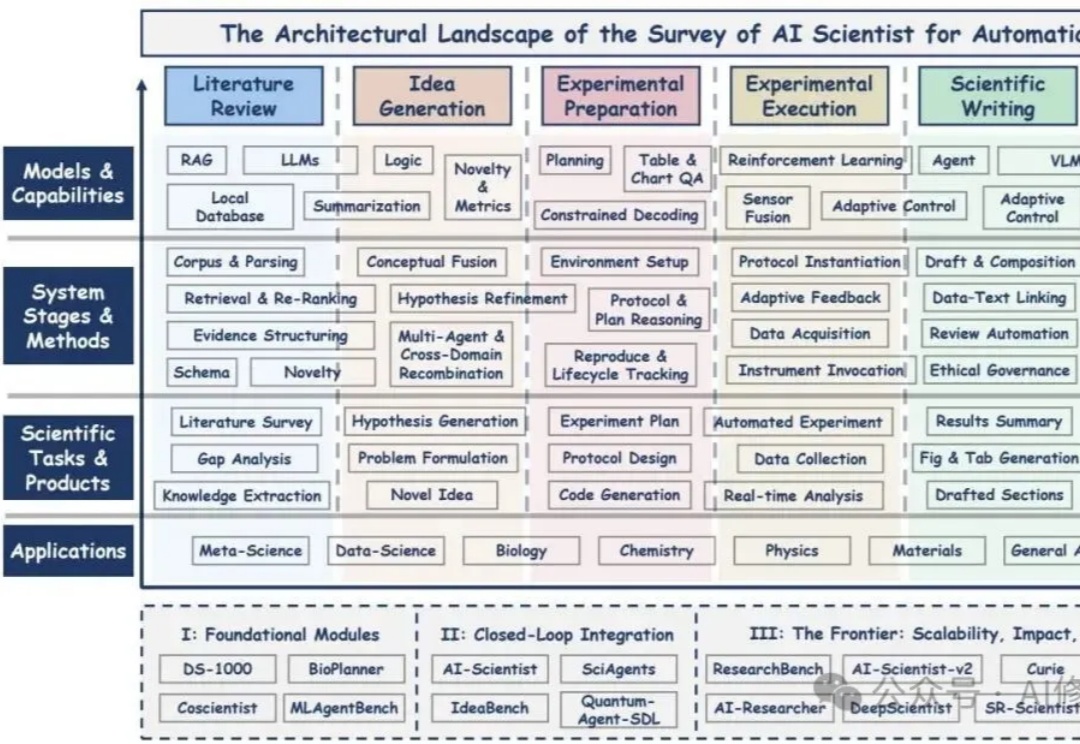

本文基于研究者的系统性综述,围绕“AI Scientist(AI科学家)”这一新的概念展开,核心线索是研究者的六阶段方法论与三阶段演进轨迹;您如果正搭建一个可验证、可协作、可扩展的研究自动化体系,这篇综述更像一张总路线图而非空洞口号,有不少思路可以借鉴。

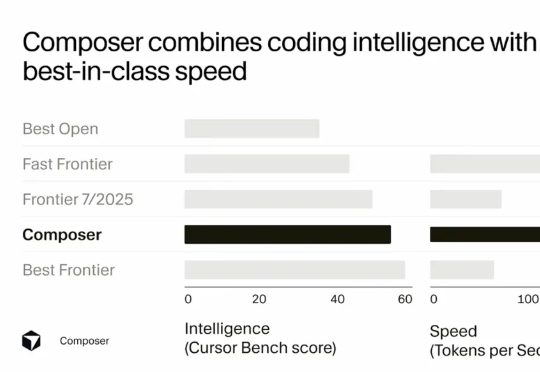

Sasha Rush 在分享开头就提到,Cursor Composer 在他们的内部 benchmark 上的表现几乎与最好的 Frontier 模型(前沿模型)持平,并且优于去年夏天发布的所有模型。它的表现明显好于最好的开源模型,以及那些被标榜为"快速"的模型。

面对“AI是否陷入泡沫”的热议,美国知名对冲基金Coatue深度研究了过去400年间30余次典型泡沫案例,从中提炼出共性特征,并据此发布了年度AI重磅报告。Coatue将这一框架应用于当前AI领域,得出的结论是:AI正处于早期“替代/普及”阶段,远未到达泡沫顶点。

当AI不再对着文字死记硬背,而是学会在视频里对人类世界进行超感知,这套全新范式会不会撬开AGI的大门?

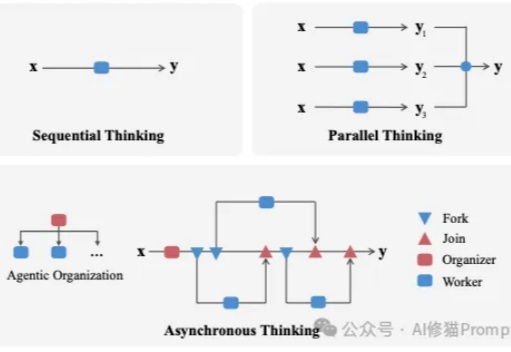

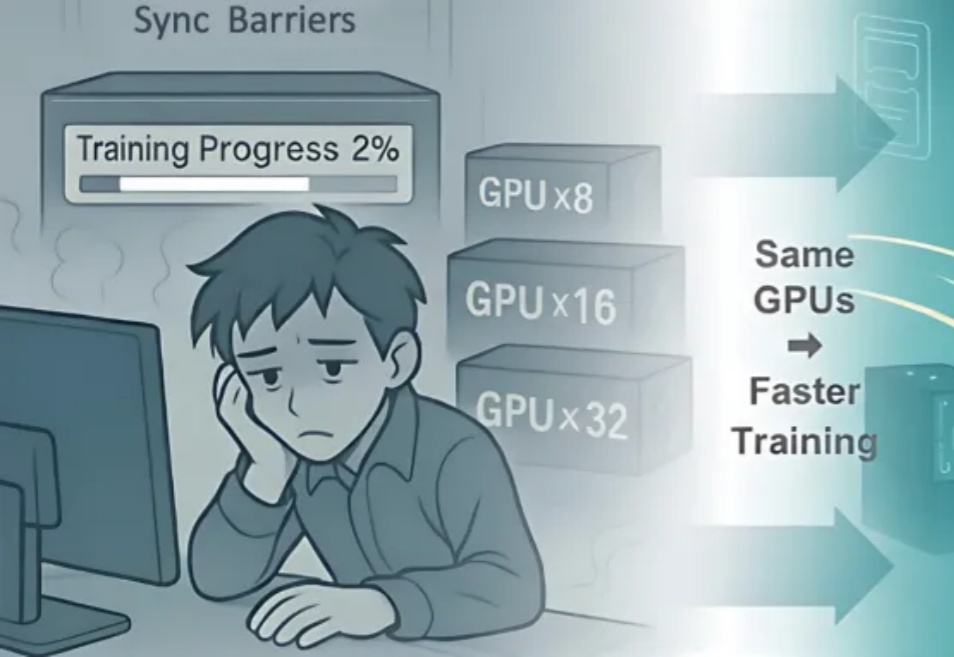

近期,阿里巴巴 ROLL 团队(淘天未来生活实验室与阿里巴巴智能引擎团队)联合上海交通大学、香港科技大学推出「3A」协同优化框架 ——Async 架构(Asynchronous Training)、Asymmetric PPO(AsyPPO)与 Attention 机制(Attention-based Reasoning Rhythm),