将大模型幻觉降低90%,一个神奇的写作Agent

将大模型幻觉降低90%,一个神奇的写作Agent为什么我们需要智能写作Agent?

为什么我们需要智能写作Agent?

DeepSeek最新论文深入剖析了V3/R1的开发历程,揭示了硬件与大语言模型架构协同设计的核心奥秘。论文展示了如何突破内存、计算和通信瓶颈,实现低成本、高效率的大规模AI训练与推理。不仅总结了实践经验,还为未来AI硬件与模型协同设计提出了建议。

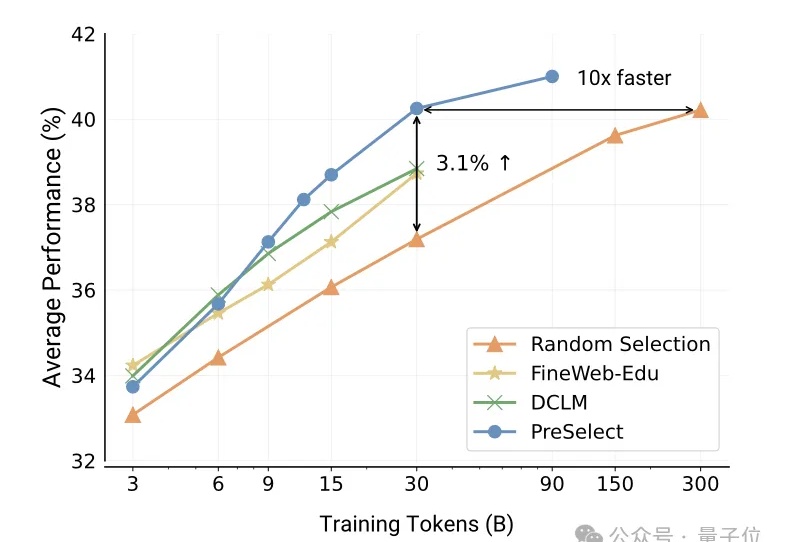

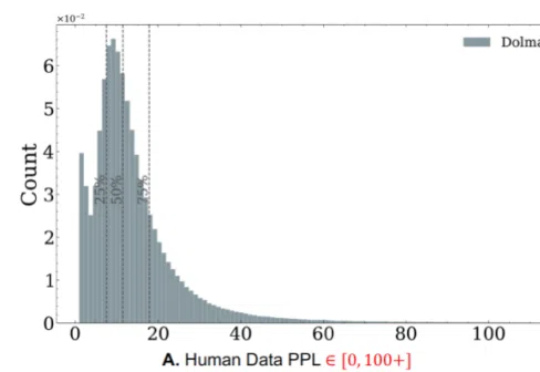

vivo自研大模型用的数据筛选方法,公开了。

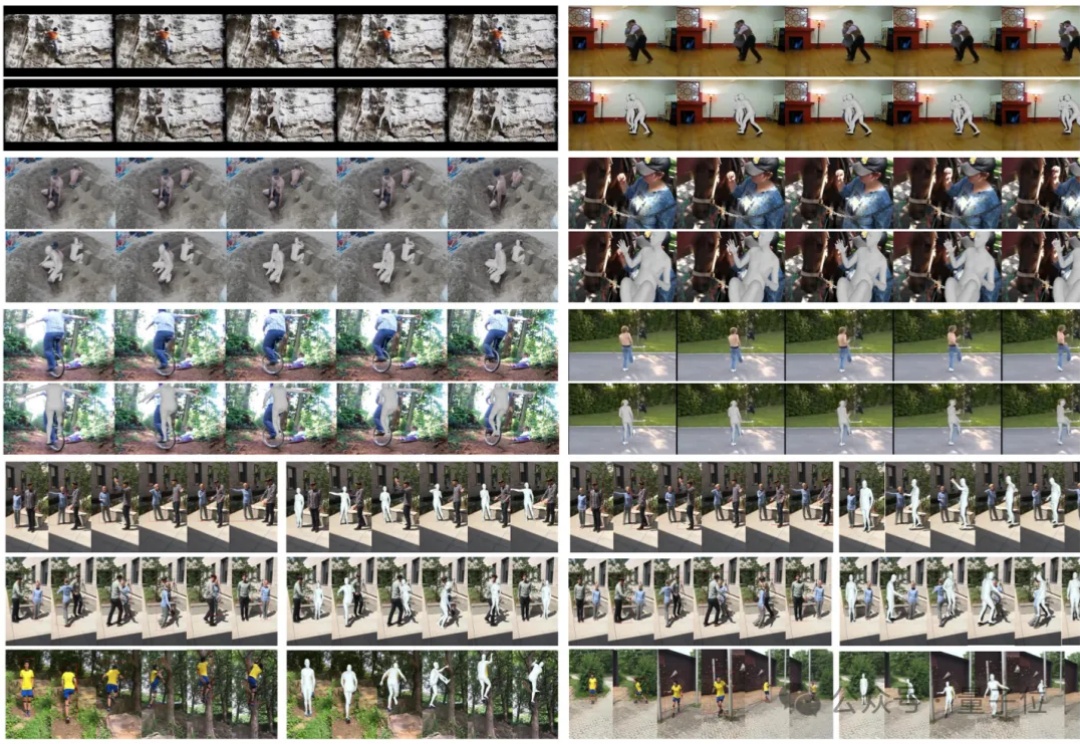

北大和人大团队在通用人形机器人动作生成领域取得重大突破!

搞RAG开发,一个被普遍忽视却又至关重要的痛点是:如何避免Token分块带来的语义割裂问题。SAT模型通过神经网络驱动的智能分段技术,巧妙解决了这一难题。它不是RAG的替代,而是RAG的强力前置增强层,通过确保每个文本块的语义完整性,显著降低下游生成的幻觉风险。

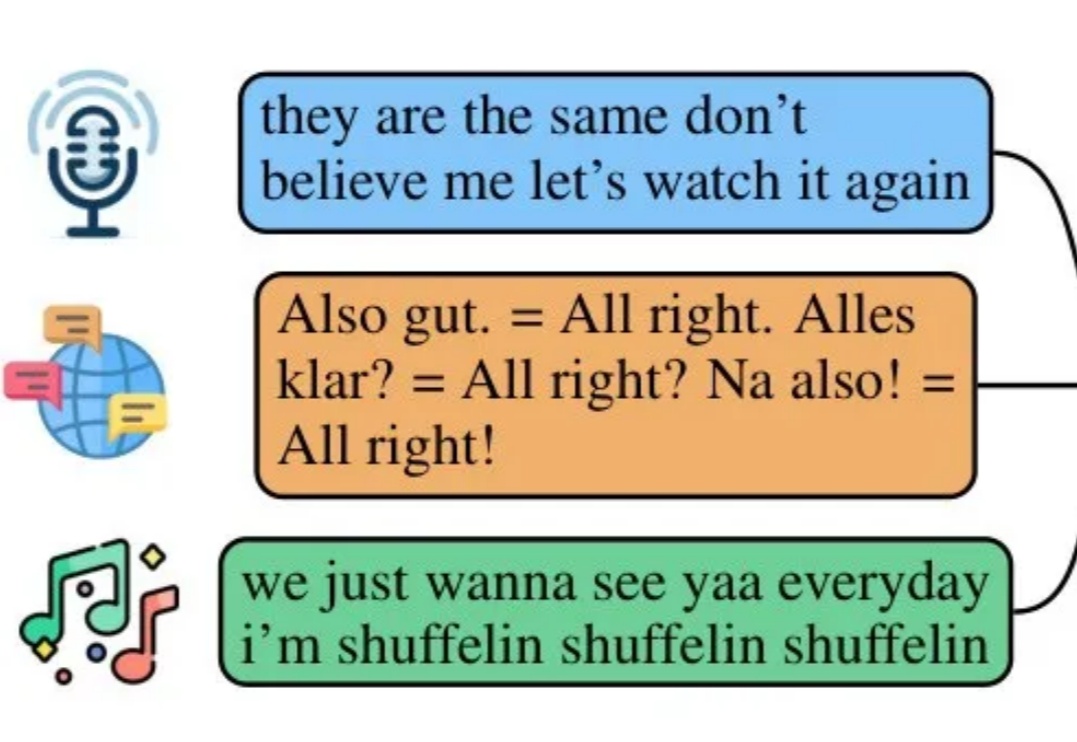

空间音频,作为一种能够模拟真实听觉环境的技术,正逐渐成为提升沉浸式体验的关键。

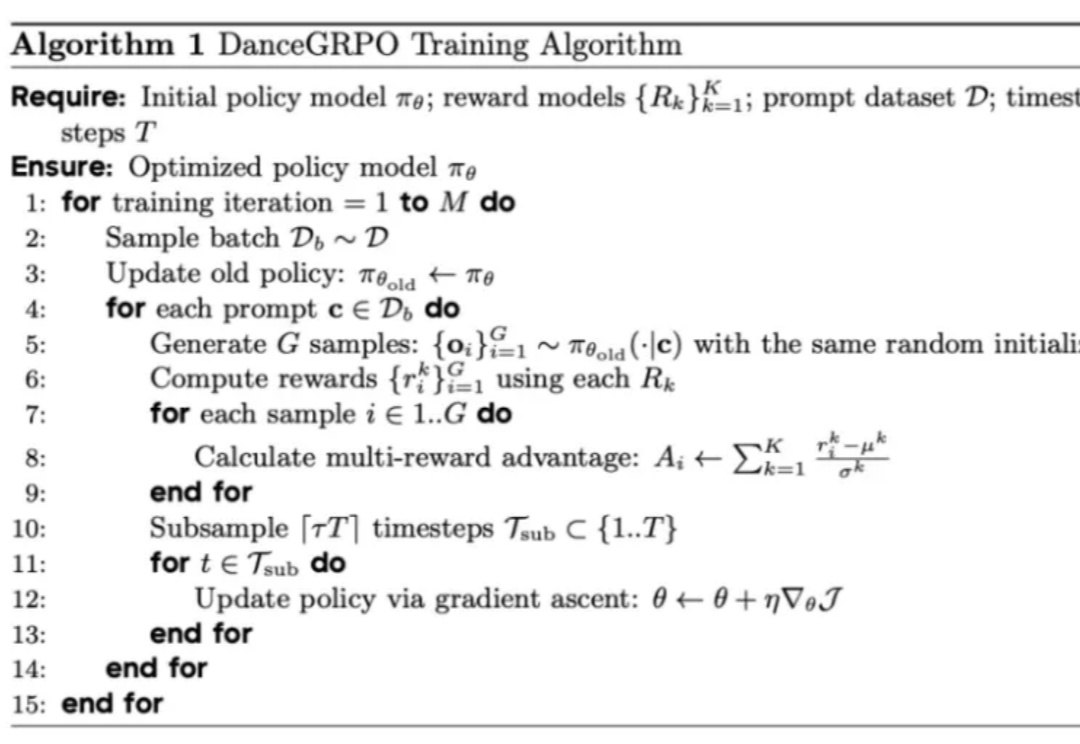

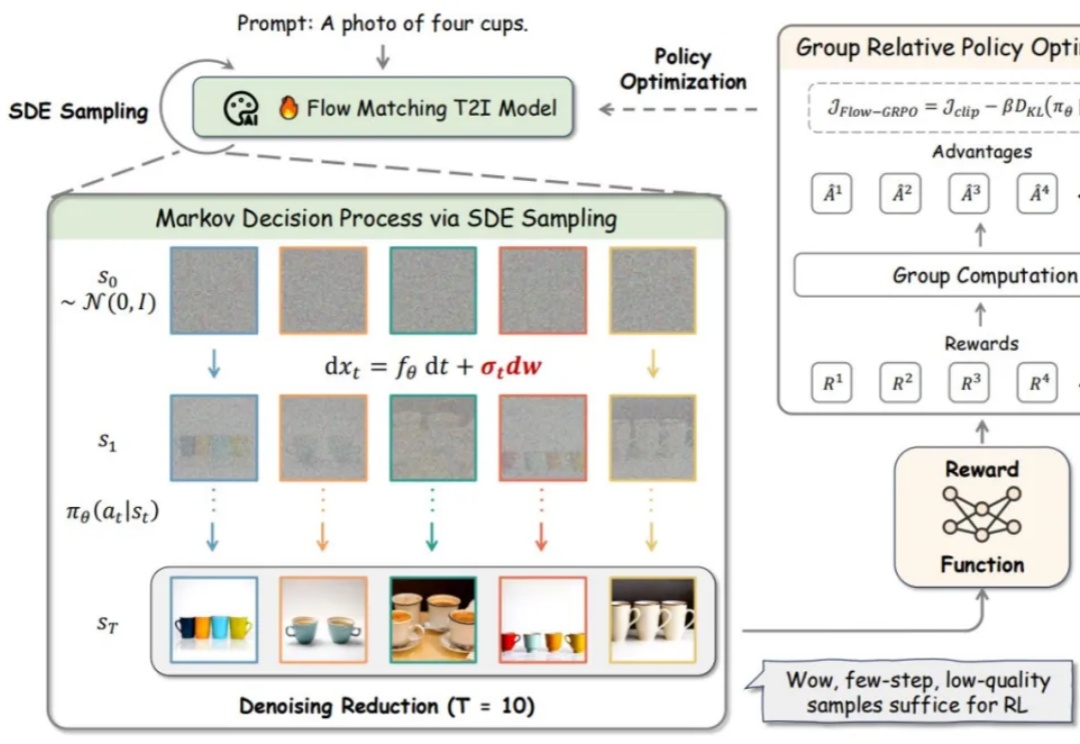

R1 横空出世,带火了 GRPO 算法,RL 也随之成为 2025 年的热门技术探索方向,近期,字节 Seed 团队就在图像生成方向进行了相关探索。

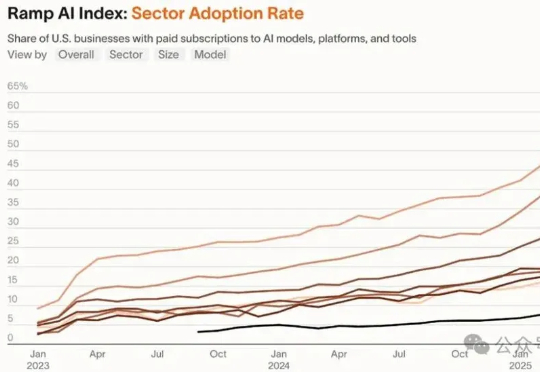

红杉资本连续三年关注AI应用的盈利压力,指出当前AI市场规模已达万亿美元但面临挑战:智能体技术受限于串行任务瓶颈,行业渗透率差异显著,初创企业需深耕垂直领域或整合人工环节。大模型厂商向下游扩张挤压初创空间,部分企业通过收购强化竞争力,AI应用需从工具转向交付结果以突破盈利困境。

比起此前对生成时长、模型参数的强调,大半年来,不提Sora的AI视频玩家将这场“军备竞赛”的重点放在了三个维度上——卷一致性、卷可用性、卷可玩性。所谓的“一致性”指的是视频生成过程中帧与帧之间的过渡性、动作的连续性和场景的真实性等。

看了Dia的系统提示词,真的是细节狂魔啊!(提示词放文末了)每个细节都在优化用户的使用体验,这就是产品级AI和玩具级AI的区别。提示词整体结构遵循了"总-分-总"的结构,开头设定整体角色身份的基本认知,然后分项设定规则,最终设定总体的安全策略。

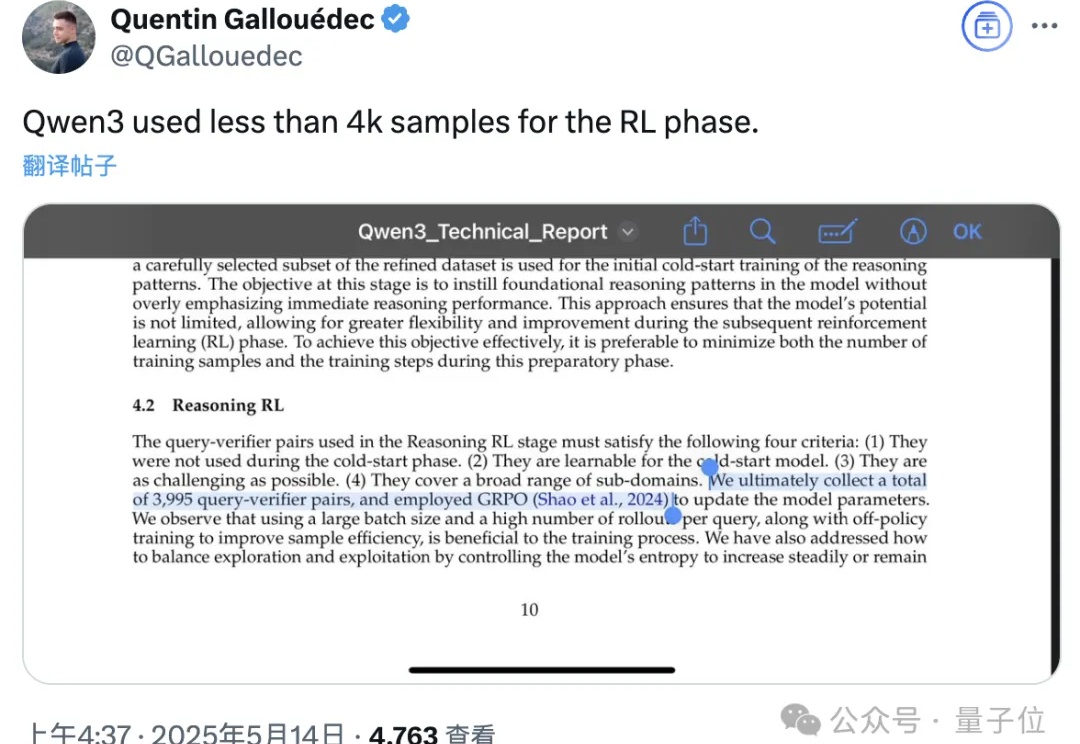

Qwen3技术报告新鲜出炉,8款模型背后的关键技术被揭晓!

最近ContextGem很火。它既不是RAG也不是Agent,而是专注于"结构化提取"的框架,它像一个"文档理解层",通过文档中心设计和神经网络技术(SAT)将非结构化文档转化为精确的结构化数据。它可作为RAG的前置处理器、Agent的感知模块,也可独立使用。

今年的两篇最佳论文一作均为华人。

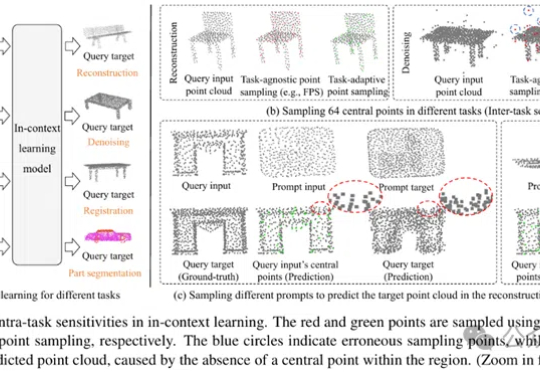

MICAS是一种专为3D点云上下文学习设计的多粒度采样方法,通过任务自适应点采样和查询特定提示采样,提升模型在点云重建、去噪、配准和分割等任务中的稳健性和适应性,显著优于现有技术。

随着生成式人工智能技术的飞速发展,合成数据正日益成为大模型训练的重要组成部分。未来的 GPT 系列语言模型不可避免地将依赖于由人工数据和合成数据混合构成的大规模语料。

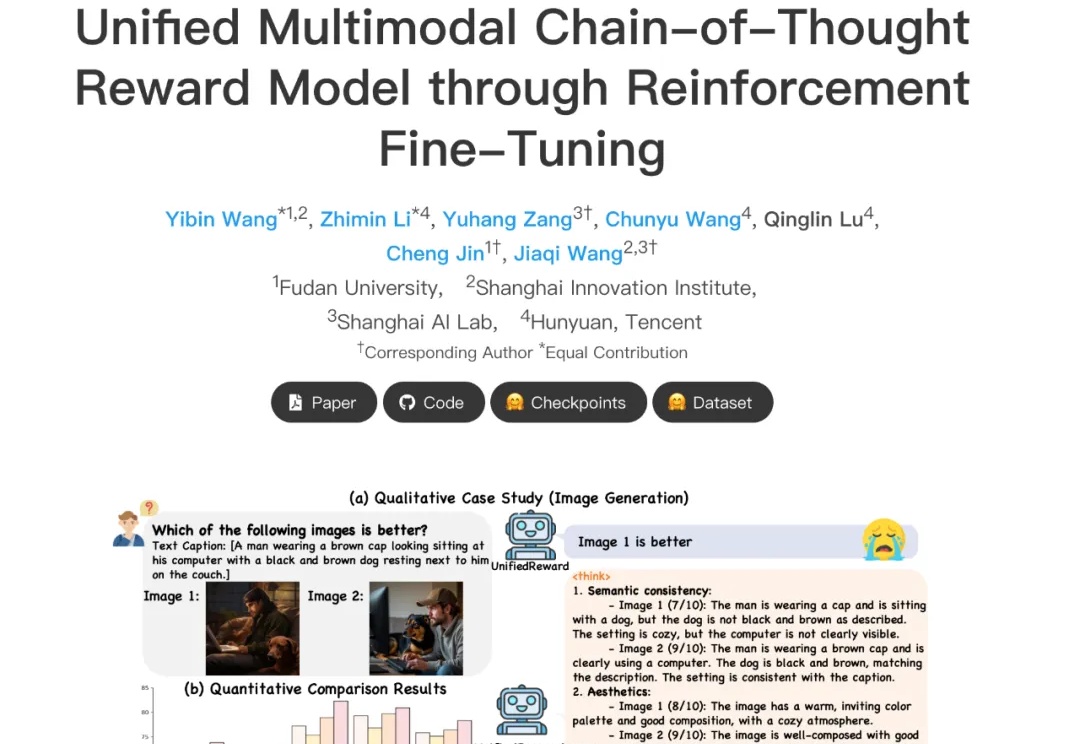

在多模态大模型快速发展的当下,如何精准评估其生成内容的质量,正成为多模态大模型与人类偏好对齐的核心挑战。然而,当前主流多模态奖励模型往往只能直接给出评分决策,或仅具备浅层推理能力,缺乏对复杂奖励任务的深入理解与解释能力,在高复杂度场景中常出现 “失真失准”。

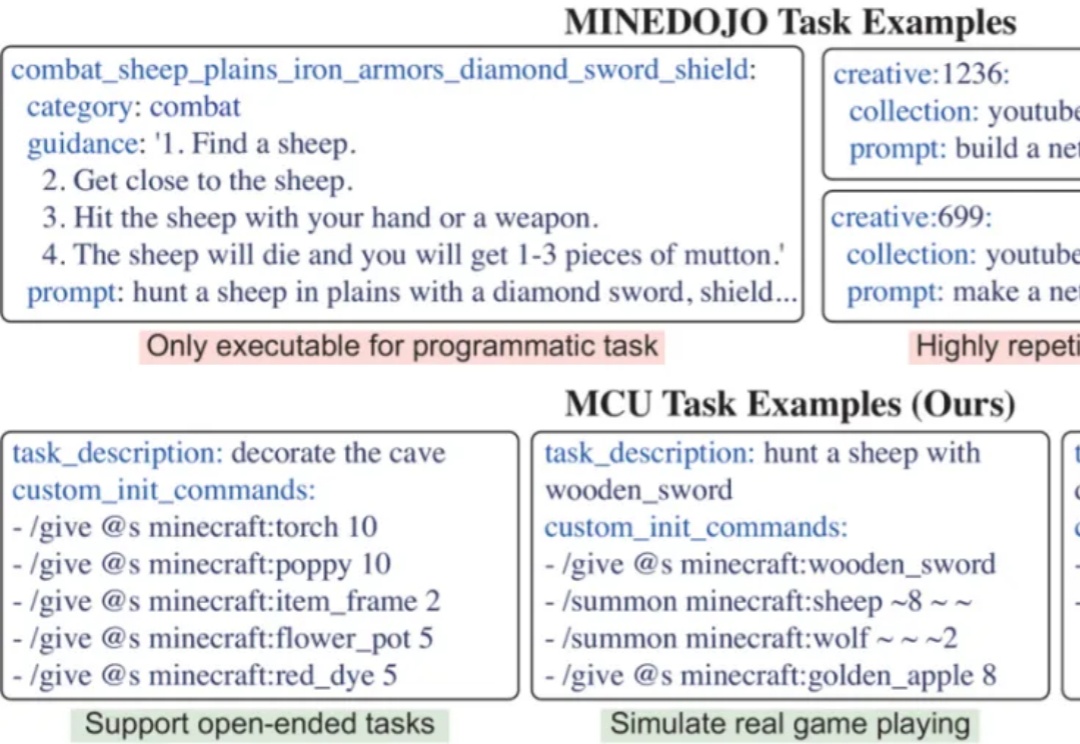

开发能在开放世界中完成多样任务的通用智能体,是AI领域的核心挑战。开放世界强调环境的动态性及任务的非预设性,智能体必须具备真正的泛化能力才能稳健应对。然而,现有评测体系多受限于任务多样化不足、任务数量有限以及环境单一等因素,难以准确衡量智能体是否真正「理解」任务,或仅是「记住」了特定解法。

流匹配模型因其坚实的理论基础和在生成高质量图像方面的优异性能,已成为图像生成(Stable Diffusion, Flux)和视频生成(可灵,WanX,Hunyuan)领域最先进模型的训练方法。然而,这些最先进的模型在处理包含多个物体、属性与关系的复杂场景,以及文本渲染任务时仍存在较大困难。

世界模型的进度条,最近坐上了火箭。

一夜之间,老黄天塌了(doge)。

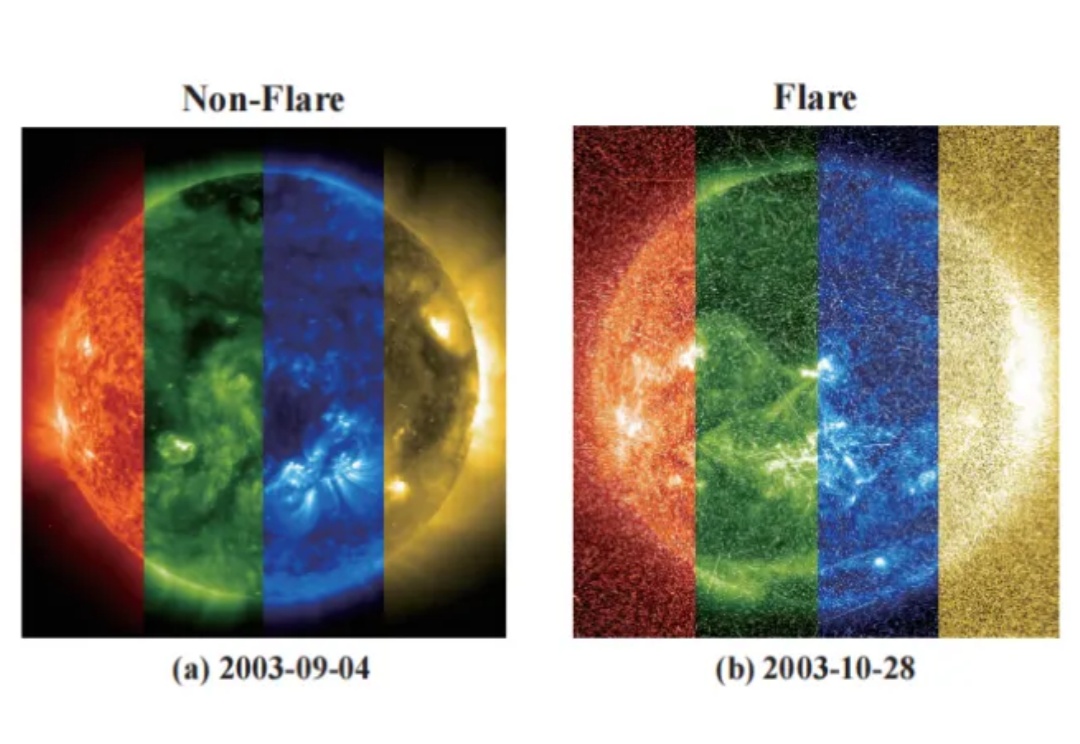

还记得刘慈欣在《全频带阻塞干扰》中描绘的耀斑爆发吗?

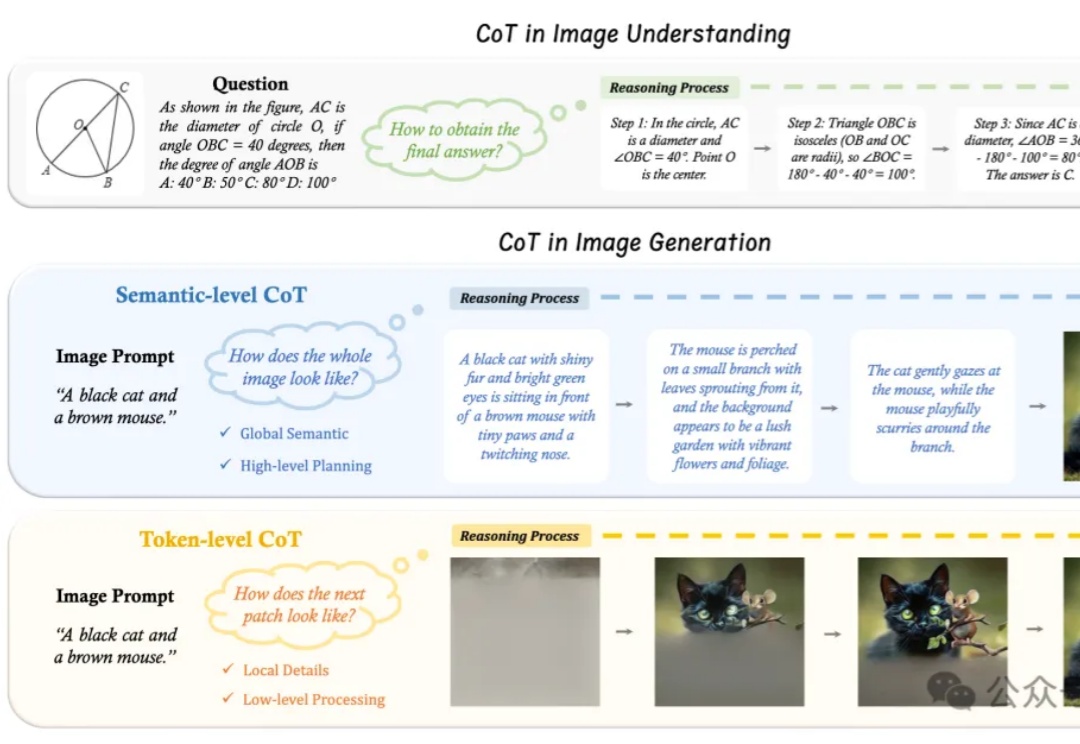

“先推理、再作答”,语言大模型的Thinking模式,现在已经被拓展到了图片领域。

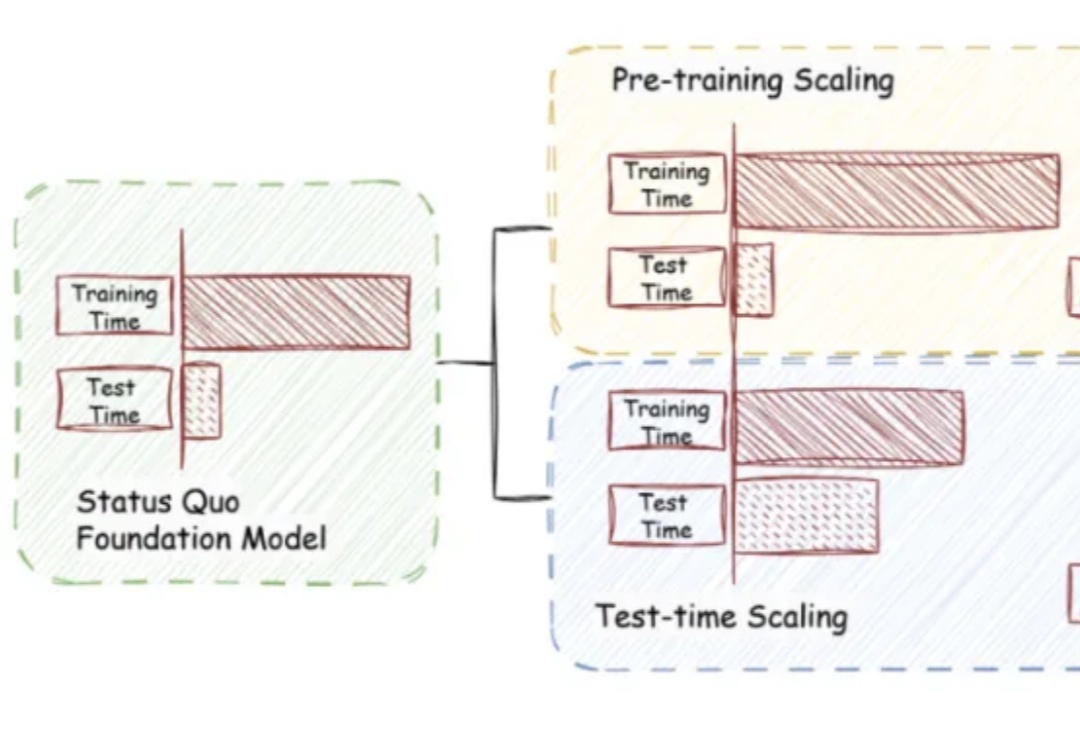

当训练成本飙升、数据枯竭,如何继续激发大模型潜能?

「矩阵」不再是科幻!Matrix-Game震撼来袭,突破边界带来交互式引擎。只需一句话,沙漠森林等任意场景可控生成,动作丝滑操控,360°视角自由切换,沉浸感爆棚。

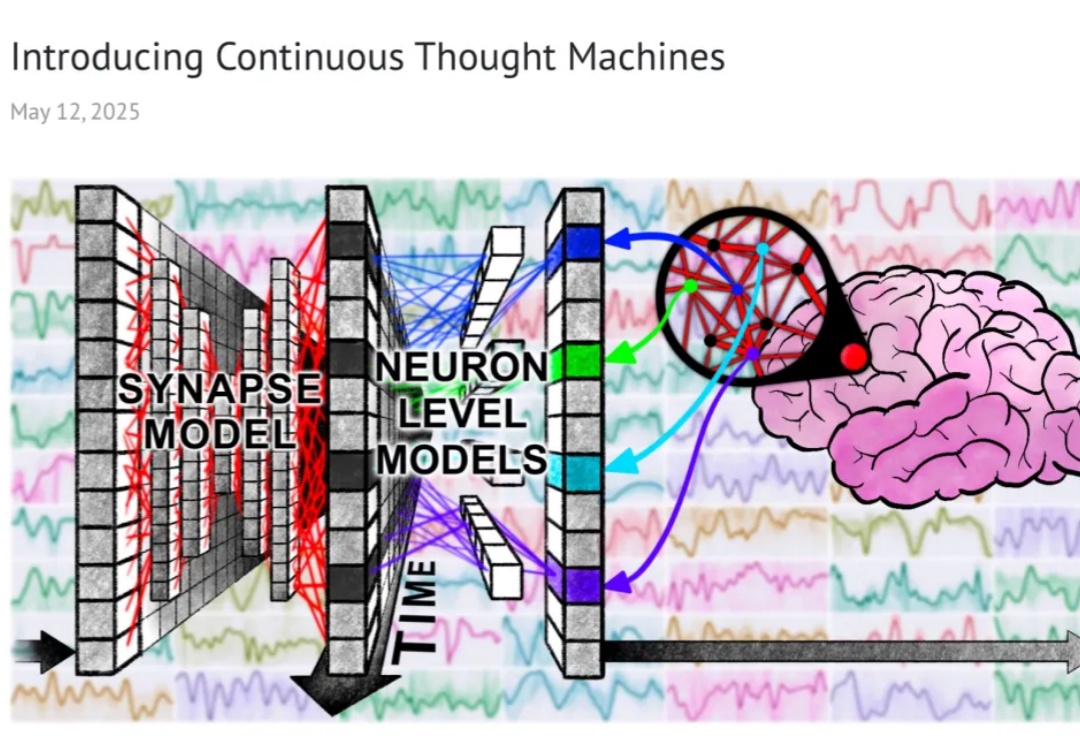

开启「分步思考」新范式。

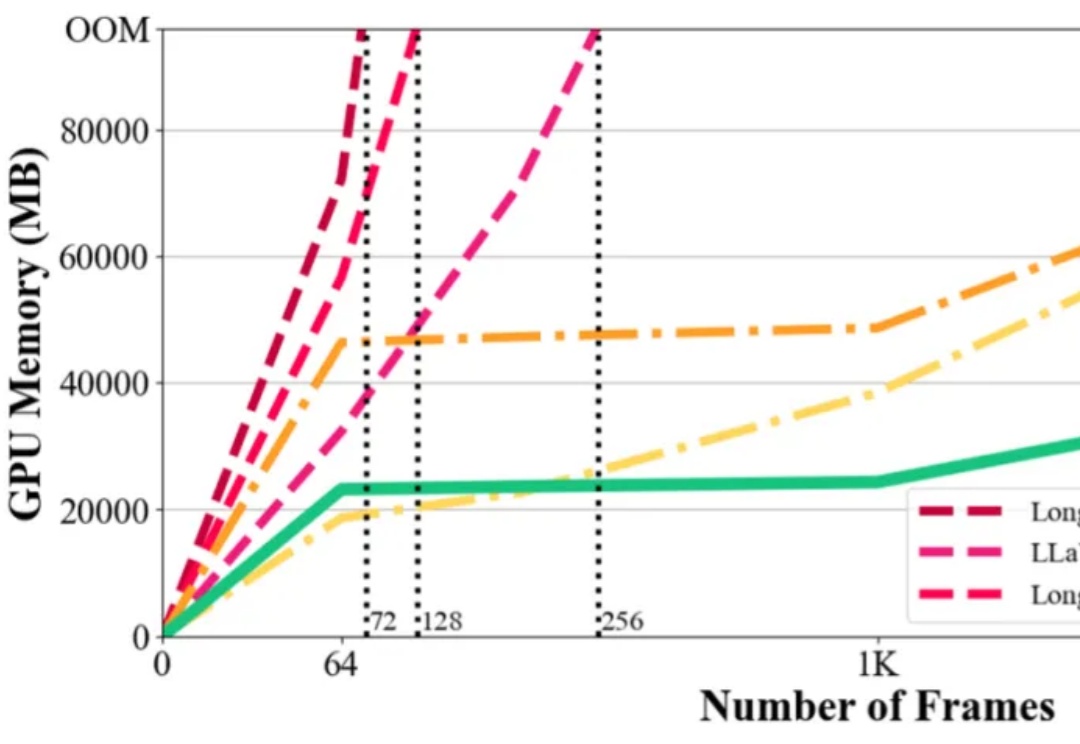

在视觉语言模型(Vision-Language Models,VLMs)取得突破性进展的当下,长视频理解的挑战显得愈发重要。以标准 24 帧率的标清视频为例,仅需数分钟即可产生逾百万的视觉 token,这已远超主流大语言模型 4K-128K 的上下文处理极限。

AI 不允许有人不会搭乐高。

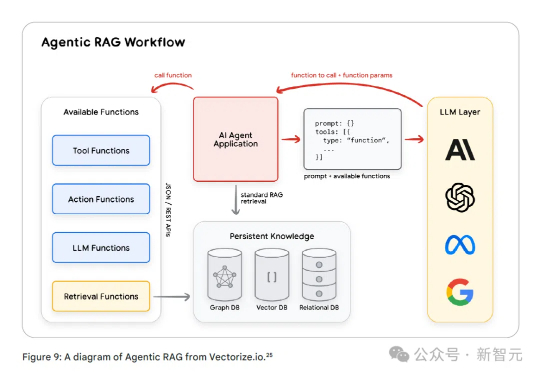

谷歌最新发布的76页AI智能体白皮书,深入剖析了智能体的应用前景。智能体通过感知环境、调用工具和自主规划,能够完成复杂任务并做出高级决策。从智能体运维(AgentOps)到多智能体协作,这份白皮书为AI智能体指明了方向。

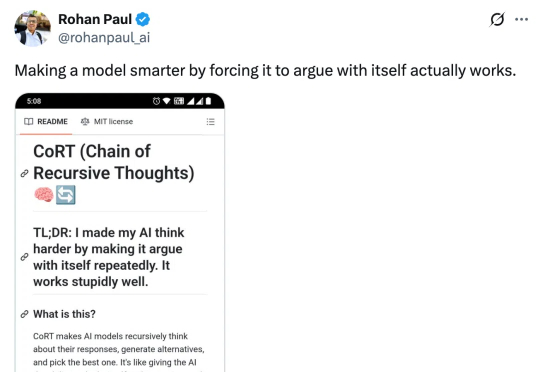

递归思考 + 自我批判,CoRT 能带来 LLM 推理力的飞跃吗?

不用引入外部数据,通过自我博弈(Self-play)就能让预训练大模型学会推理?