Web Agent技术揭秘:如何让DeepSeek接管与控制你的浏览器?

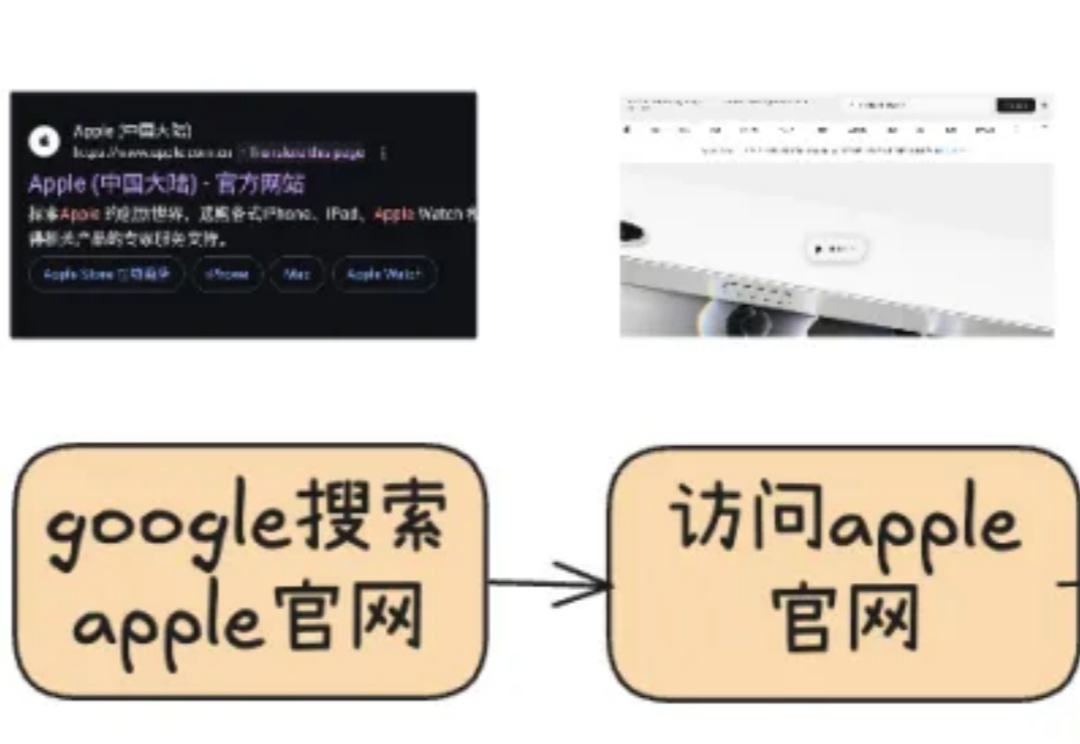

Web Agent技术揭秘:如何让DeepSeek接管与控制你的浏览器?Web Agent是这样一种特殊的智能体:它借助AI自动控制你的浏览器,并完成你“交代”的任务。比如帮你挑选一部最新的iPhone或者到旅行网站预订机票。这样的智能数字助手,无论是对生活还是工作,未来无疑都具有重大的意义。当前有大量的研究正针对这种Agent展开,本文就来聊聊其最新进展及DeepSeek的应用。

Web Agent是这样一种特殊的智能体:它借助AI自动控制你的浏览器,并完成你“交代”的任务。比如帮你挑选一部最新的iPhone或者到旅行网站预订机票。这样的智能数字助手,无论是对生活还是工作,未来无疑都具有重大的意义。当前有大量的研究正针对这种Agent展开,本文就来聊聊其最新进展及DeepSeek的应用。

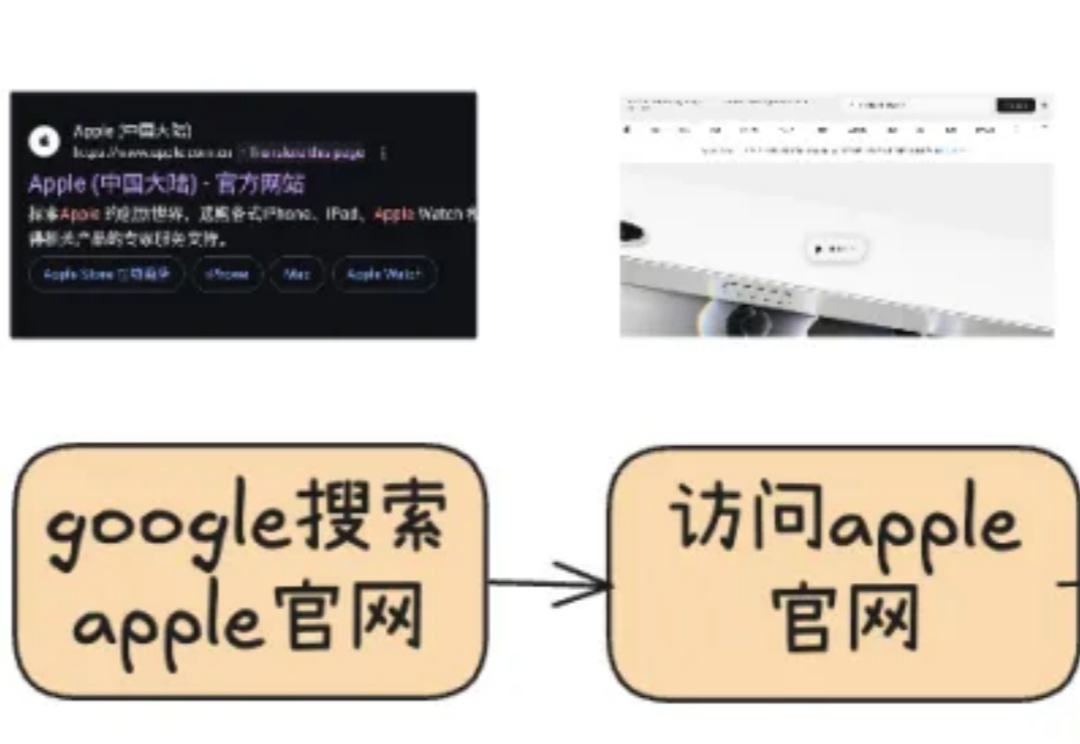

近日,上海 AI Lab 具身智能中心研究团队在机器人控制领域取得了最新突破,提出的 HoST(Humanoid Standing-up Control)算法,成功让人形机器人在多种复杂环境中实现了自主站起,并展现出强大的抗干扰能力。

在实际应用中,我们常常需要模型输出具有严格结构的数据,比如生物制药生产记录、金融交易报告或医疗健康档案等。这种结构化输出的需求在生物制造、金融服务、医疗健康等严格监管的领域尤为重要。

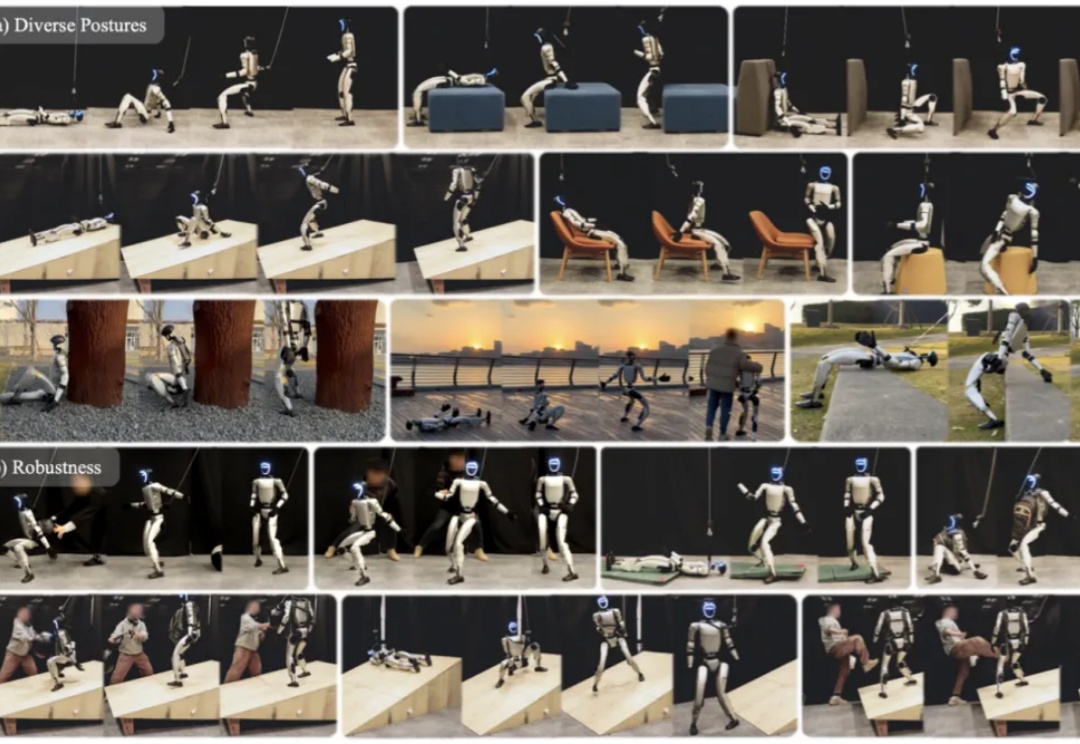

现在截图生成代码,已经来到了一个新高度——

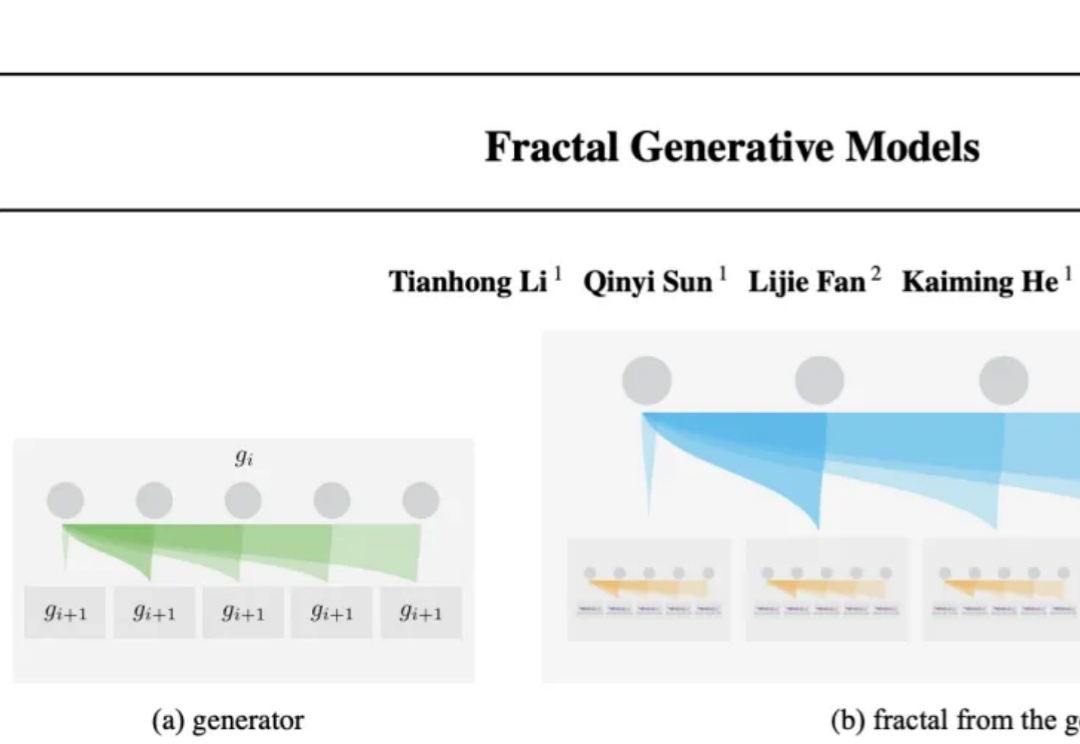

大自然的分形之美,蕴藏着宇宙的设计规则。刚刚,何恺明团队祭出「分形生成模型」,首次实现高分辨率逐像素建模,让计算效率飙升4000倍,开辟AI图像生成新范式。

相信很多用户已经见识过或至少听说过 Deep Research 的强大能力。

Zep,一个为大模型智能体提供长期记忆的插件,能将智能体的记忆组织成情节,从这些情节中提取实体及其关系,并将它们存储在知识图谱中,从而让用户以低代码的方式为智能力构建长期记忆。

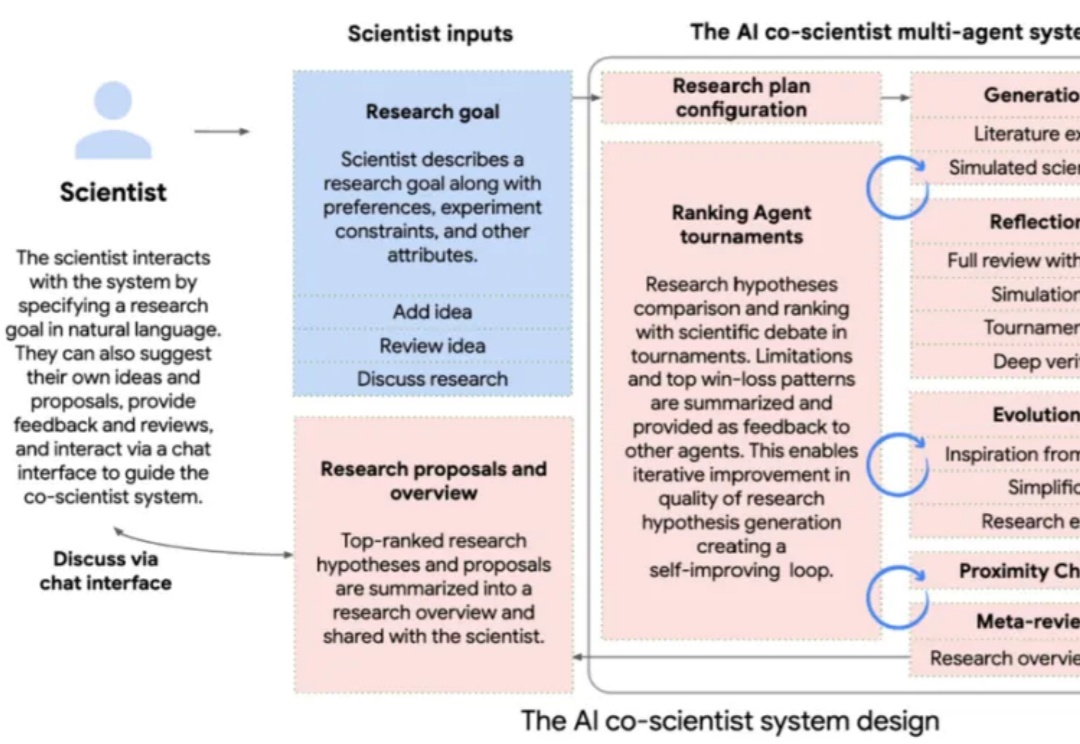

AI co-scientist系统基于Gemini 2.0开发,能够协助科研人员生成新的研究假设、制定实验方案,并通过自我改进提升结果质量。在生物医学应用中,AI co-scientist成功预测了药物再利用方向、提出新的治疗靶点,并解释了抗菌耐药机制。

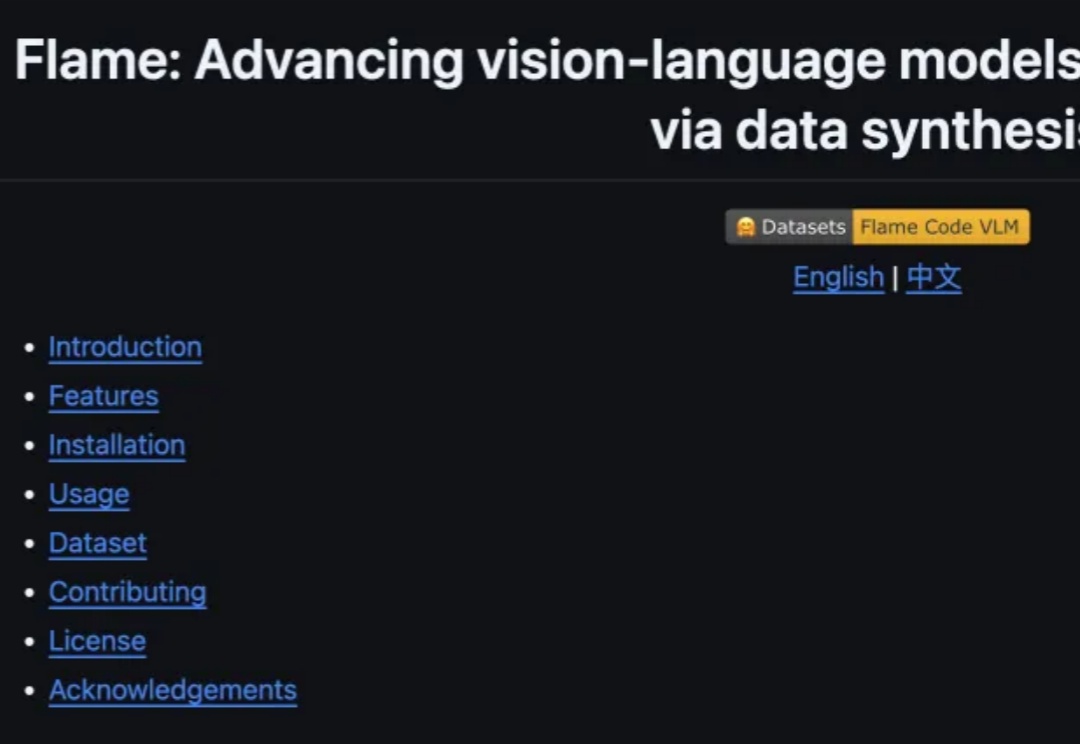

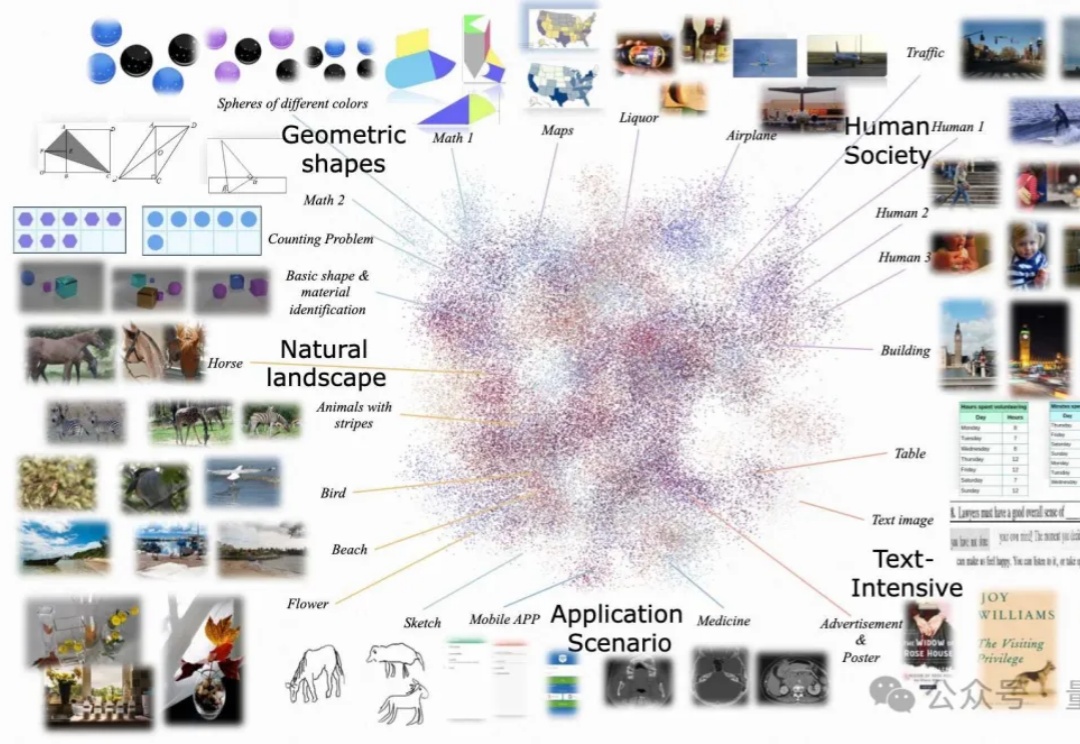

尽管多模态大语言模型(MLLMs)取得了显著的进展,但现有的先进模型仍然缺乏与人类偏好的充分对齐。这一差距的存在主要是因为现有的对齐研究多集中于某些特定领域(例如减少幻觉问题),是否与人类偏好对齐可以全面提升MLLM的各种能力仍是一个未知数。

进入到 2025 年,视频生成(尤其是基于扩散模型)领域还在不断地「推陈出新」,各种文生视频、图生视频模型展现出了酷炫的效果。其中,长视频生成一直是现有视频扩散的痛点。

何恺明再次开宗立派!开辟了生成模型的全新范式——

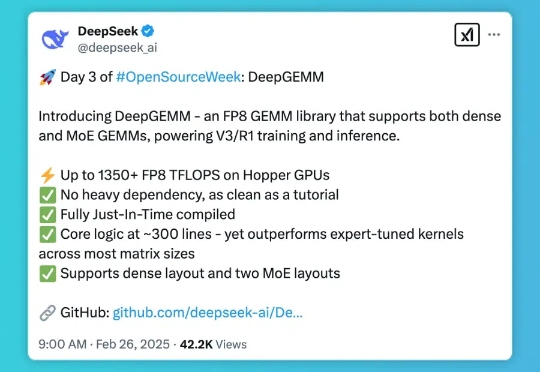

DeepSeek 开源周的第三天,带来了专为 Hopper 架构 GPU 优化的矩阵乘法库 — DeepGEMM。这一库支持标准矩阵计算和混合专家模型(MoE)计算,为 DeepSeek-V3/R1 的训练和推理提供强大支持,在 Hopper GPU 上达到 1350+FP8 TFLOPS 的高性能。

当前,企业普遍认同智能化是构建其核心竞争力的重要支柱。AI技术未来将深刻融入企业业务的方方面面,为营销、研发、生产、服务等环节都带来革命性的效率提升和用户体验优化,以及商业模式上的创新。那些能够将智能化融入企业基因,拥抱智能化的企业,将在未来的竞争中抢得先机,引领行业发展。

2024年12月4日,两位共同组织了“2024BRAIN NeuroAI Workshop”研讨会,探讨了NeuroAI如何整合到BRAIN计划中并帮助理解和治愈人类脑疾病。请问是什么契机促使两位聚集一起开展NeuroAI这项研究的?

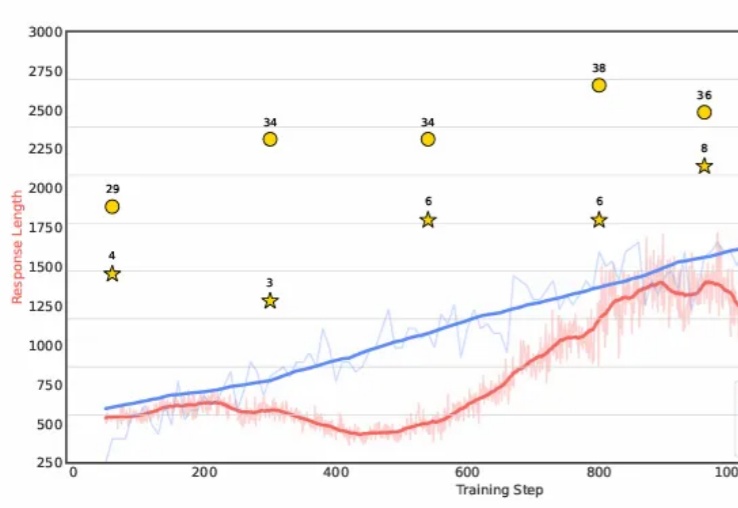

本文深入解析一项开创性研究——"Logic-RL: Unleashing LLM Reasoning with Rule-Based Reinforcement Learning",该研究通过基于规则的强化学习技术显著提升了语言模型的推理能力。微软亚洲的研究团队受DeepSeek-R1成功经验的启发,利用结构化的逻辑谜题作为训练场,为模型创建了一个可以系统学习和改进推理技能的环境。

自动形式化数学定理证明,是人工智能在数学推理领域的重要应用方向。此类任务需要将数学命题和证明步骤转化为计算机可验证的代码,这不仅能确保推理过程的绝对严谨性,还能构建可复用的数学知识库,为科学研究提供坚实基础。

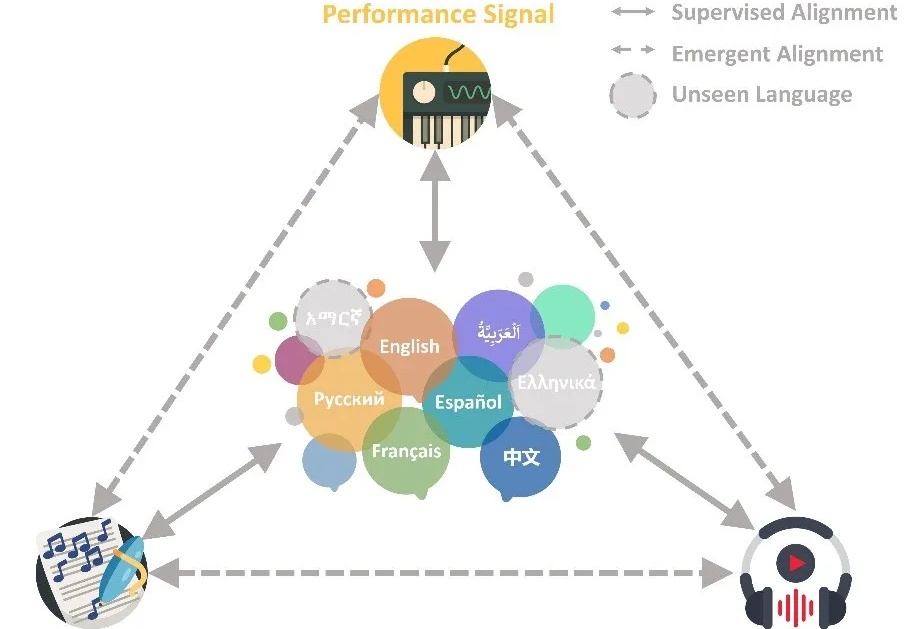

给AI看一眼图,它就能找到对应音乐。

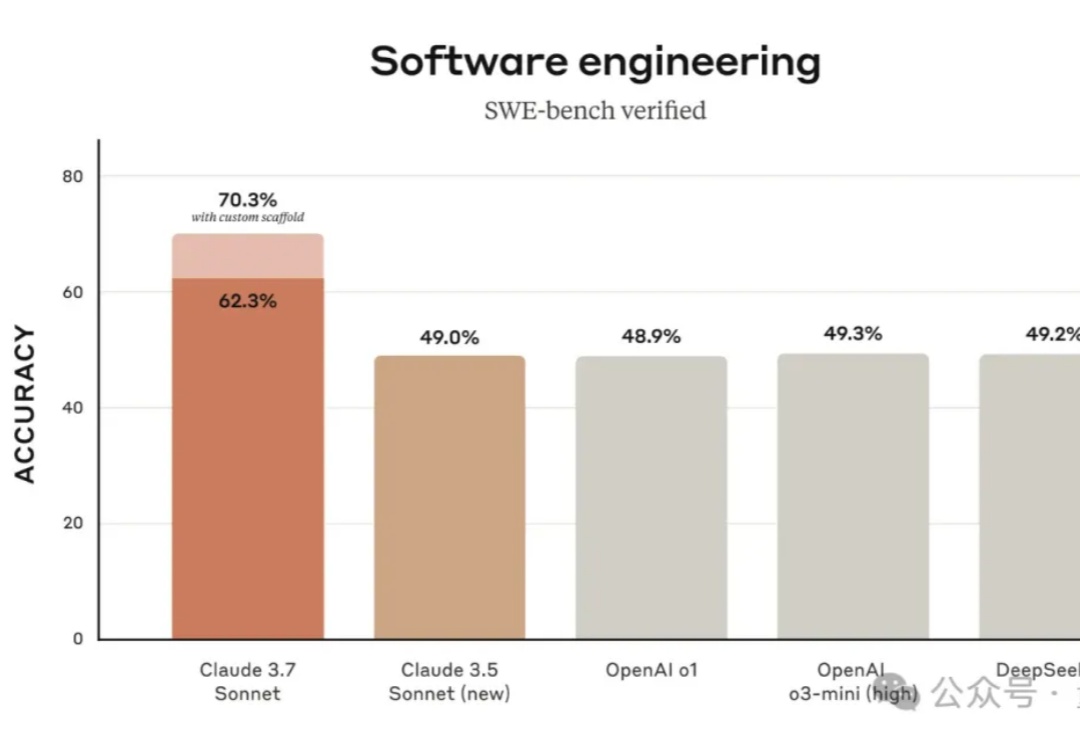

当地时间 2 月 25 日,Anthropic 正式发布了 Claude 3.7 Sonnet,“这是迄今为止我们最智能的模型,也是市场上首个混合推理模型。”Anthropic 官方表示。

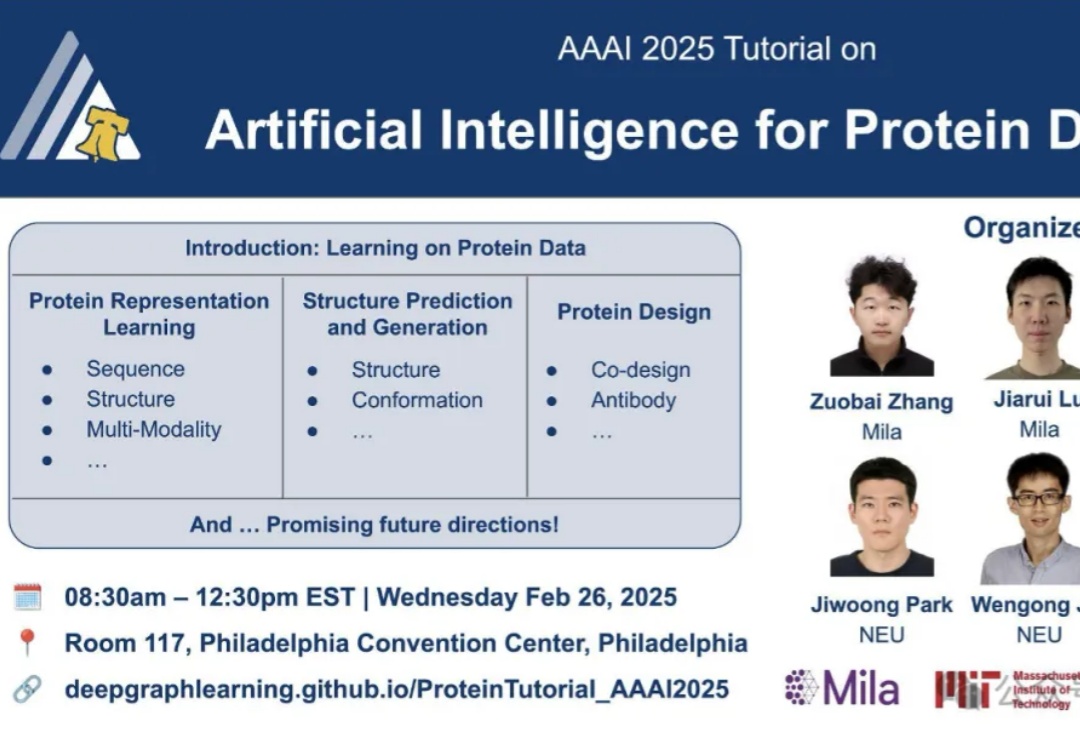

精准预测和设计蛋白质的序列、结构及模拟其动态变化,一直是科学界的重大挑战。

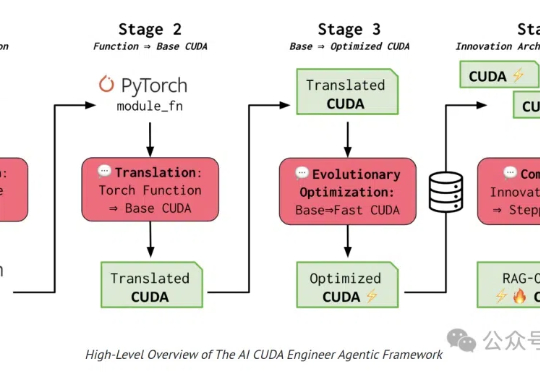

高调亮相的世界首个「AI CUDA工程师」,宣称能让模型训练速度飙升100倍,如今却上演了一场「作弊」闹剧。OpenAI研究员用o3-mini,11秒便发现了内核代码有bug!

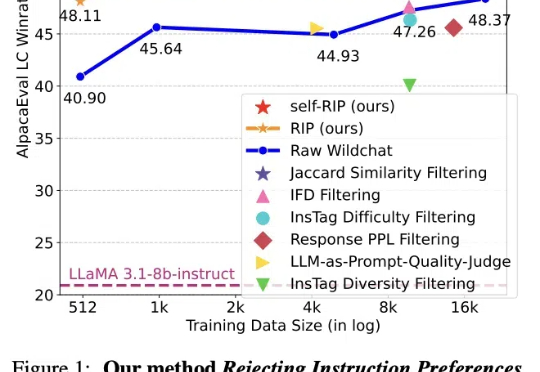

近日,Meta等机构发表的论文介绍了一种通过进化算法构造高质量数据集的方法:拒绝指令偏好(RIP),得到了Yann LeCun的转赞。相比未经过滤的数据,使用RIP构建的数据集让模型在多个基准测试中都实现了显著提升。

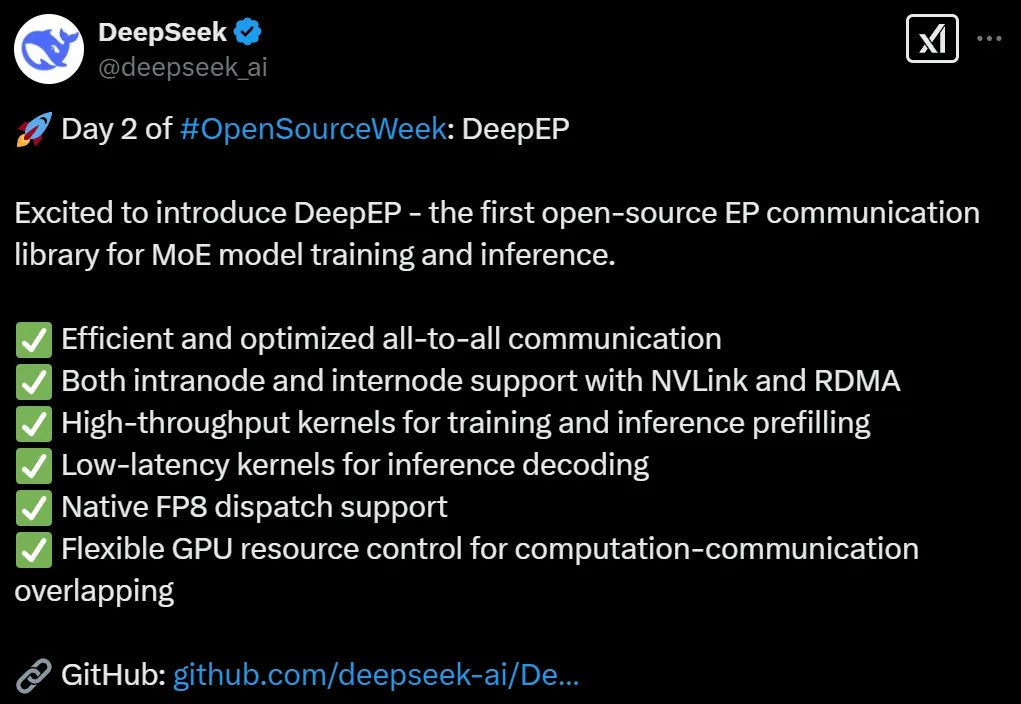

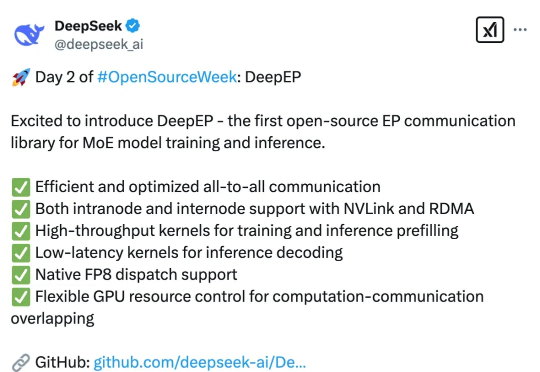

DeepSeek开源第二弹如期而至。这一次,他们把MoE训推EP通信库DeepEP开源了,支持FP8专为Hopper GPU设计,低延迟超高速训练推理。

只刷逻辑益智题,竟能让 AI 数学竞赛水平大幅提升?

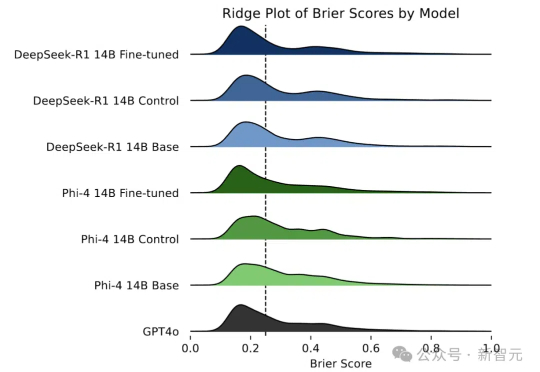

还在惊叹预言家的神奇?如今LLM也掌握了预测未来的「超能力」!研究人员通过自我博弈和直接偏好优化,让LLM摆脱人工数据依赖,大幅提升预测能力。

DeepSeek,就是AI一体机的“瓦特时刻”

DeepSeek 本周正在连续 5 天发布开源项目,今天是第 2 天,带来了专为混合专家模型(MoE)和专家并行(EP)打造的高效通信库 — DeepEP。就在半小时前,官方对此进行了发布,以下是由赛博禅心带来的详解。

Claude深夜重磅发布新模型——

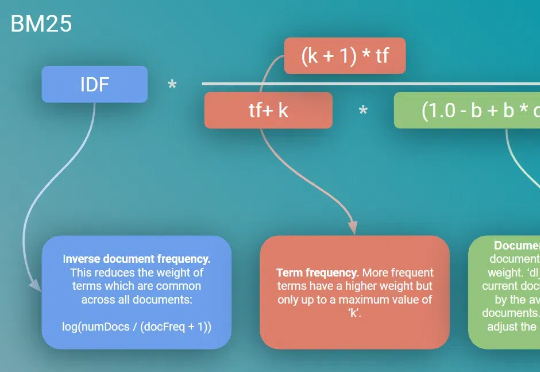

文章主要是实现了中英文版本的BM25算法(主要就是分词部分有区别),算法可能也有缺陷,恳请看见的大佬指点指点,虽然也有比我实现的要更优秀的第三方库,比如bm25s

其实,这个话题我也不好意思开口,去年7月的时候我就关注过这个 AI情趣娃娃;在具身智能发展成熟时,表情陪伴人形机器人有望成为主流产品形态。表情陪伴人形机器人属情绪陪伴机器人高端领域,指的是硅胶皮肤覆盖,根据仿生学原理模仿人的外观设计、能够与人类进行自然交互的人形机器人。

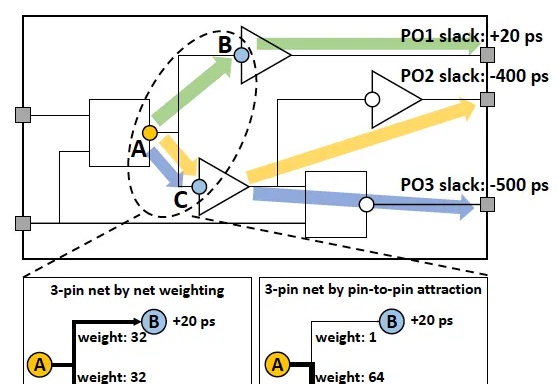

南大AI学院钱超教授团队,荣获EDA顶会2025最佳论文奖!其中,论文一作、四作、五作都是南大人工智能学院的本硕博生。芯片设计领域的传统难题——如何为多达百亿量级晶体管设计最优布局,从此有了一种巧妙的全新方法。