为MoE解绑:全新「专家即服务」推理架构发布,超细粒度扩展锐减37.5%成本

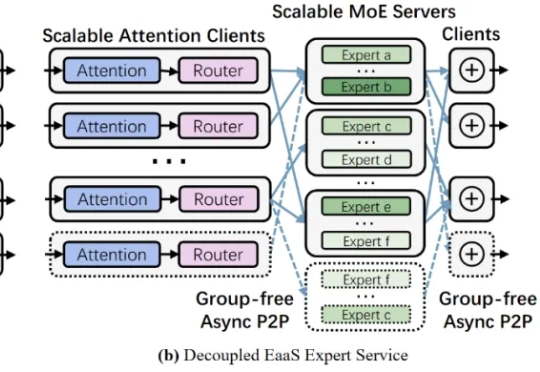

为MoE解绑:全新「专家即服务」推理架构发布,超细粒度扩展锐减37.5%成本近年来,大型语言模型的参数规模屡创新高,随之而来的推理开销也呈指数级增长。如何降低超大模型的推理成本,成为业界关注的焦点之一。Mixture-of-Experts (MoE,混合专家) 架构通过引入大量 “专家” 子模型,让每个输入仅激活少数专家,从而在参数规模激增的同时避免推理计算量同比增长。

近年来,大型语言模型的参数规模屡创新高,随之而来的推理开销也呈指数级增长。如何降低超大模型的推理成本,成为业界关注的焦点之一。Mixture-of-Experts (MoE,混合专家) 架构通过引入大量 “专家” 子模型,让每个输入仅激活少数专家,从而在参数规模激增的同时避免推理计算量同比增长。

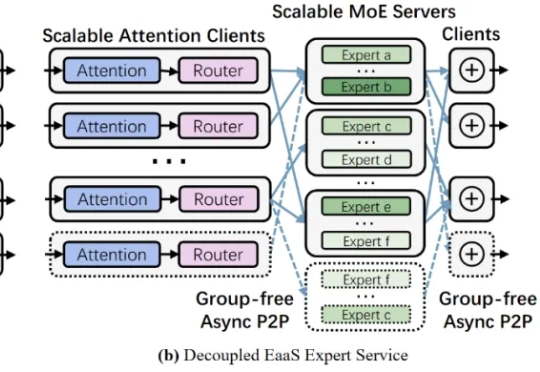

让智能体自己摸索新方法,还模仿自己的成功经验。腾讯优图实验室开源强化学习算法——SPEAR(Self-imitation with Progressive Exploration for Agentic Reinforcement Learning)。

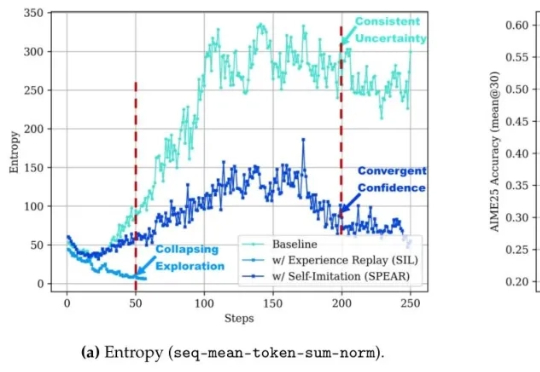

近年来,NeRF、SDF 与 3D Gaussian Splatting 等方法大放异彩,让 AI 能从图像中恢复出三维世界。但随着相关技术路线的发展与完善,瓶颈问题也随之浮现:

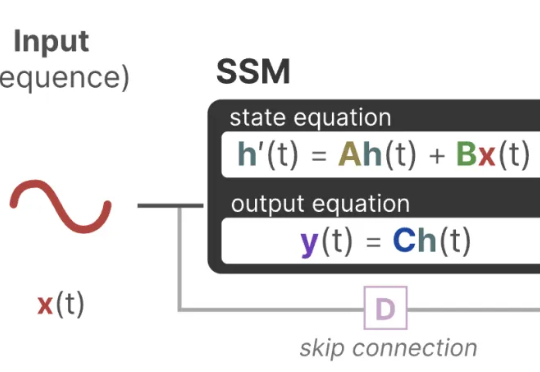

曼巴回来了!Transformer框架最有力挑战者之一Mamba的最新进化版本Mamba-3来了,已进入ICLR 2026盲审环节,超长文本处理和低延时是其相对Transformer的显著优势。另一个挑战者是FBAM,从不同的角度探索Transformer的下一代框架。

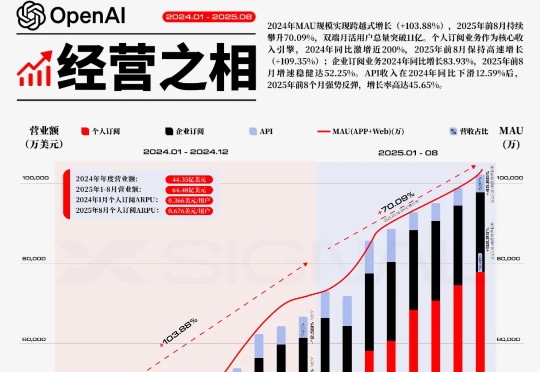

2022年11月,OpenAI的ChatGPT问世,这一事件不仅是技术创新的里程碑,更被视为重塑全球AI战略版图的关键转折点,它标志着新一轮大国AI竞赛的序幕被正式拉开。在此背景下,其增长的规模与速度本身,就是一种颠覆性的战略壁垒。

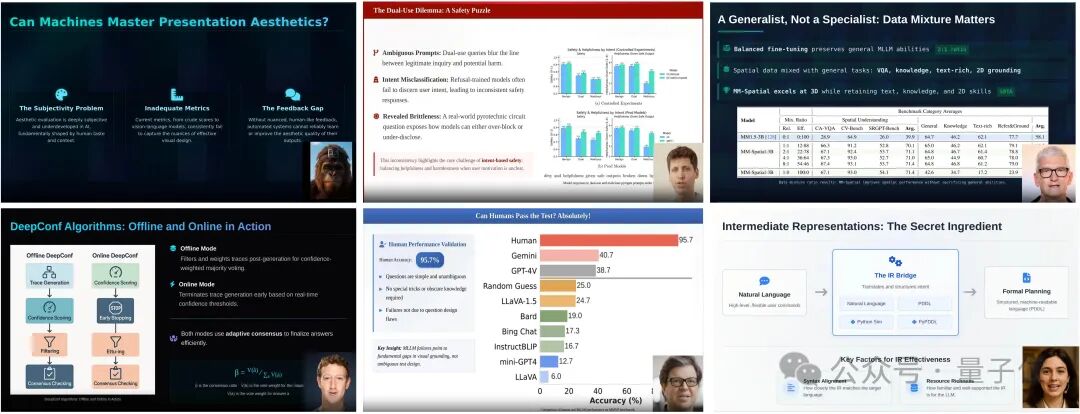

AI自己讲明白论文,还能生成更美观的幻灯片。加州大学圣塔芭芭拉(UCSB)与圣克鲁兹(UCSC)的研究者提出EvoPresent,一个能够自我进化的学术演讲智能体框架,让AI不仅能“讲清楚论文”,还能“讲得好看”。

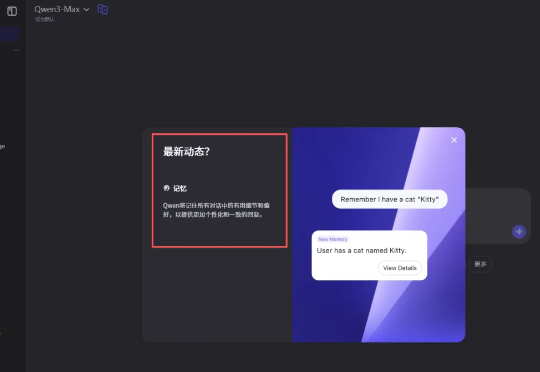

近期,我们独家观察到,国内两家科技巨头——阿里巴巴和字节跳动——旗下的AI助手通义千问(Qwen)和豆包(Doubao),同时开始内测“记忆功能”。此举被广泛视为对标行业领头羊OpenAI的ChatGPT,标志着国产AI助手正从“即时问答工具”向“长期私人助理”的角色加速演进。

他们决定,把liblib升级到2.0,有新的品牌,有新的logo,有新的界面,有新的功能。liblib,国内最著名的模型开源社区,也是国内之前最大SD生态开源社区没有之一。但是这些东西都不重要。

马斯克的xAI也入局世界模型了!据《金融时报》(FT)报道,为了增加这场“世界模型大混战”的赢面,今年夏天,xAI已经从英伟达挖来了多名资深研究员来助阵。另一边,在悄然下场世界模型后,马斯克几天前又在𝕏上再次重申了去年定下的那个“小目标”——

InfLLM-V2是一种可高效处理长文本的稀疏注意力模型,仅需少量长文本数据即可训练,且性能接近传统稠密模型。通过动态切换短长文本处理模式,显著提升长上下文任务的效率与质量。从短到长低成本「无缝切换」,预填充与解码双阶段加速,释放长上下文的真正生产力。