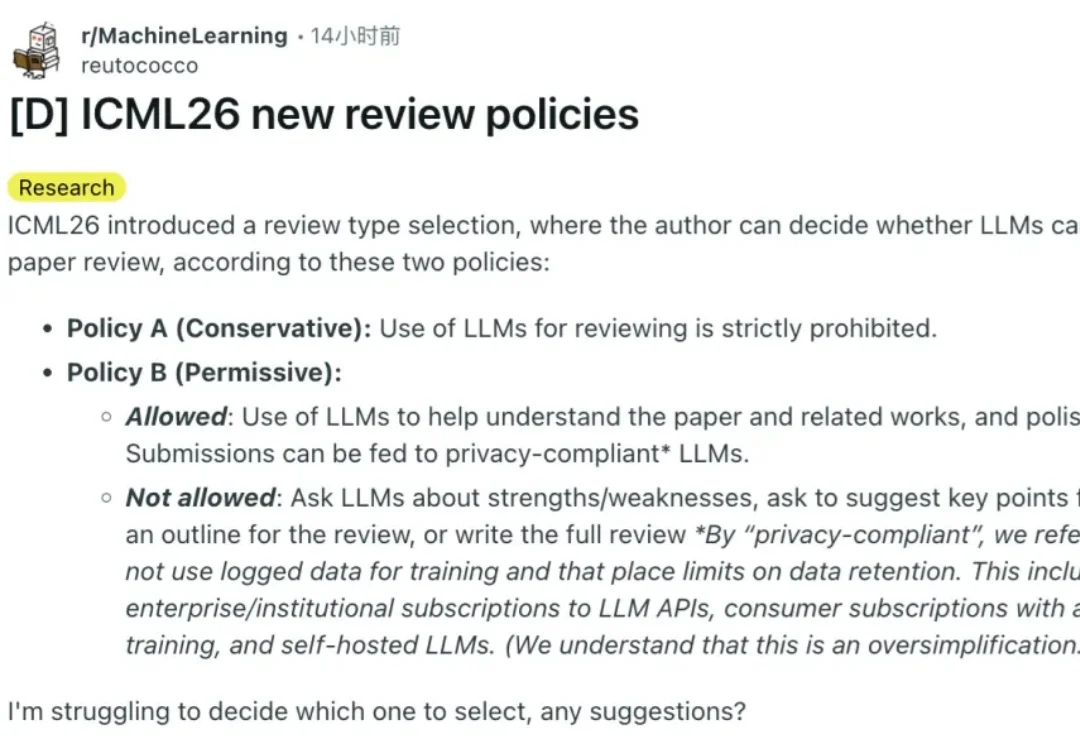

评审用不用AI,作者说了算?ICML 2026全新评审政策出炉

评审用不用AI,作者说了算?ICML 2026全新评审政策出炉两个月前,ICML 2026发布了征稿新规,我们也详细做了报道。

两个月前,ICML 2026发布了征稿新规,我们也详细做了报道。

扣子2.0,今天正式上线。 2024年2月1日,「扣子」第一次和你见面。我们怀着对 AI 能力的憧憬,在扣子里不断拖拽工作流节点、反复优化提示词,只为真的能把活儿交给AI。 直到今天,扣子已经陪你走过了七百多个日夜,拥有了上千万的用户。

昨天,据英国《金融时报》报道,美国AI超级独角兽Anthropic正在进行一轮总额超过250亿美元(约合人民币1742.1亿元)的融资。本轮融资预计将使其估值提升至约3500亿美元(约合人民币24389.0亿元),较去年9月的1700亿美元(约合人民币11846.1亿元)估值实现翻倍。

AI视频生成正从“静态输出”迈入“实时交互”阶段,一场内容创作革命即将到来。 近日,中国儒意宣布以1420万美元对爱诗科技进行战略投资,双方将围绕影视、流媒体、游戏等业务展开深度合作。 爱诗科技作为全

2026 年危机逼近,OpenAI 虽创下 400 亿美元融资纪录,但内部预测 2028 年亏损将扩大至 450 亿美元。不同于有传统业务「输血」的科技巨头,独立 AI 公司受困于 Scaling Laws 带来的指数级成本爆炸。奥特曼的万亿豪赌或难以为继,OpenAI 恐面临被吞并结局,AI 泡沫时代即将硬着陆。

嗨大家好!我是阿真! 扣子2.0版上新了,用过扣子的朋友应该知道,它一直定位为职场AI工具,这次更新的主题也是让AI从“你问它答”变成“你定目标,它来执行”。

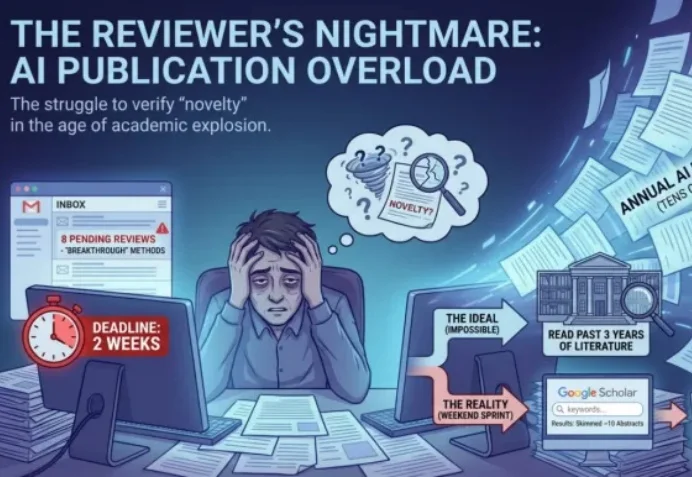

ICLR 2026 的 Rebuttal 结束了。当 OpenReview 上的喧嚣散去,我们发现,作者与审稿人之间漫长的拉锯战,最终往往只剩下一个核心分歧:「这个想法,以前真的没人做过吗?」

刚刚,全球首个GW级超算集群Colossus 2,正式投入运行。

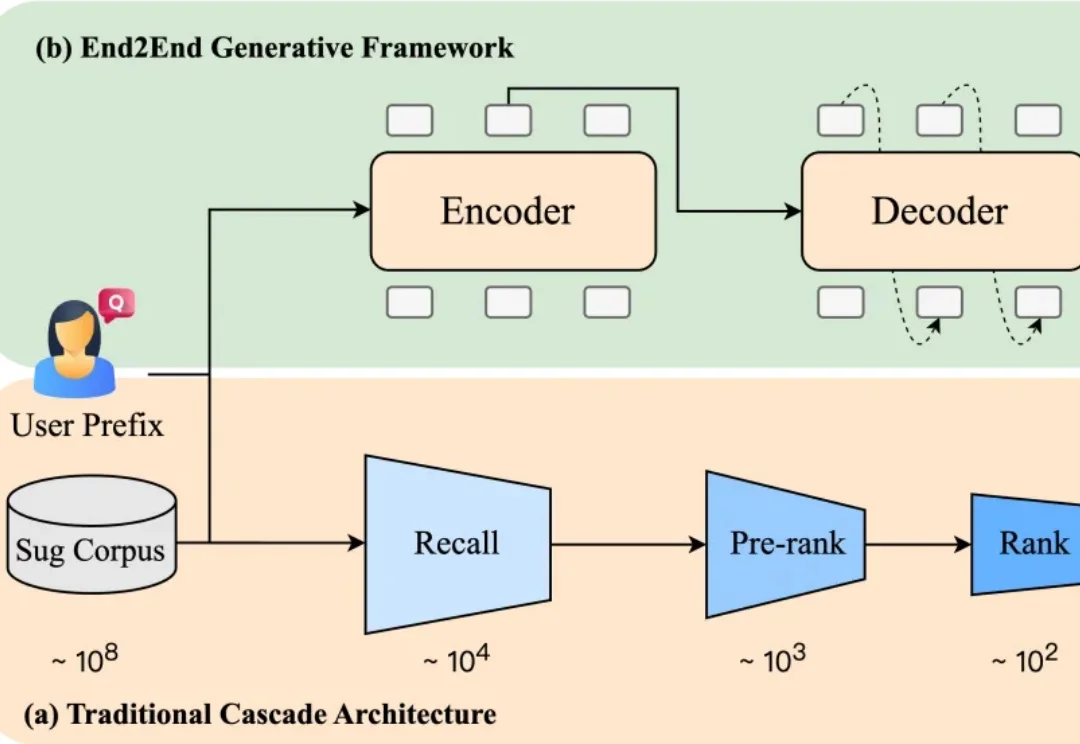

当你在电商平台搜索“苹果”,系统会推荐“水果”还是“手机”?或者直接跳到某个品牌旗舰店?短短一个词,背后承载了完全不同的购买意图。而推荐是否精准,直接影响用户的搜索体验,也影响平台的转化效率。

随着 AI 技术的蓬勃发展, AI 模型的参数规模和推理频次呈指数级增长。据高盛研究部预测,到 2030 年,全球数据中心的电力需求将增长 160%。