DeepSeek-R1推理智能从哪儿来?谷歌新研究:模型内心多个角色吵翻了

DeepSeek-R1推理智能从哪儿来?谷歌新研究:模型内心多个角色吵翻了过去两年,大模型的推理能力出现了一次明显的跃迁。在数学、逻辑、多步规划等复杂任务上,推理模型如 OpenAI 的 o 系列、DeepSeek-R1、QwQ-32B,开始稳定拉开与传统指令微调模型的差距。直观来看,它们似乎只是思考得更久了:更长的 Chain-of-Thought、更高的 test-time compute,成为最常被引用的解释。

过去两年,大模型的推理能力出现了一次明显的跃迁。在数学、逻辑、多步规划等复杂任务上,推理模型如 OpenAI 的 o 系列、DeepSeek-R1、QwQ-32B,开始稳定拉开与传统指令微调模型的差距。直观来看,它们似乎只是思考得更久了:更长的 Chain-of-Thought、更高的 test-time compute,成为最常被引用的解释。

进入到 2026 年,OpenAI 在关注消费级产品(如 ChatGPT、社交应用)之外,开始将一部分重心转向企业级市场。

如果论文是AI写给AI看的,那人类还剩下什么?

7×24h「全职AI员工」实火!退休码农造出神级Clawdbot,在硅谷红遍半边天,就连谷歌大佬也入局了。

2026开年,OpenAI的「推理之父」Jerry Tworek离职了。顶尖大脑因方向冲突和资源倾斜而出走,从这一刻起,硅谷的「Open」或许只剩下一个名字,而非一家真正的AGI实验室。

2026 年才开始,全球 AI 行业就迎来了第一个开年王炸。不是来自某个更大的模型参数,不是某家实验室刷新了榜单分数,而是一个看似不起眼、却迅速破圈的概念——Agent Skill。

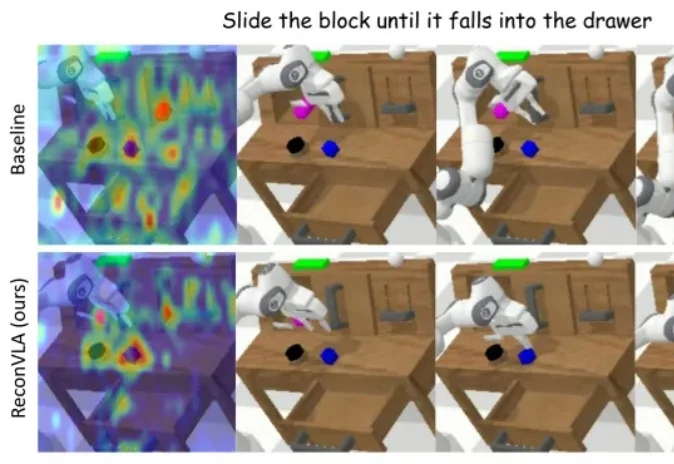

在长期以来的 AI 研究版图中,具身智能虽然在机器人操作、自动化系统与现实应用中至关重要,却常被视为「系统工程驱动」的研究方向,鲜少被认为能够在 AI 核心建模范式上产生决定性影响。

周末看到一个好玩的东西。 3D领域的NanoBanana也来了。 中间有一句比较重要的功能,是我觉得非常有意思的: 可以通过提示进行局部编辑。 玩过NanoBanana的肯定很熟了。 算了补全了一块有

大家好,我是最近天天折腾CLI Agent的袋鼠帝。 一周前,我给大家安利了一款Claude Code的最强开源对手:OpenCode,没想到文章发出去后反响这么热烈,不管是阅读量还是评论都非常多。刚好,前几天我看到腾讯的CodeBuddy Code重磅升级到了2.0版本。说实话,CodeBuddy Code我有用过,基本完全复刻Claude Code,之前还帮我开发了好几个小工具,很实用。

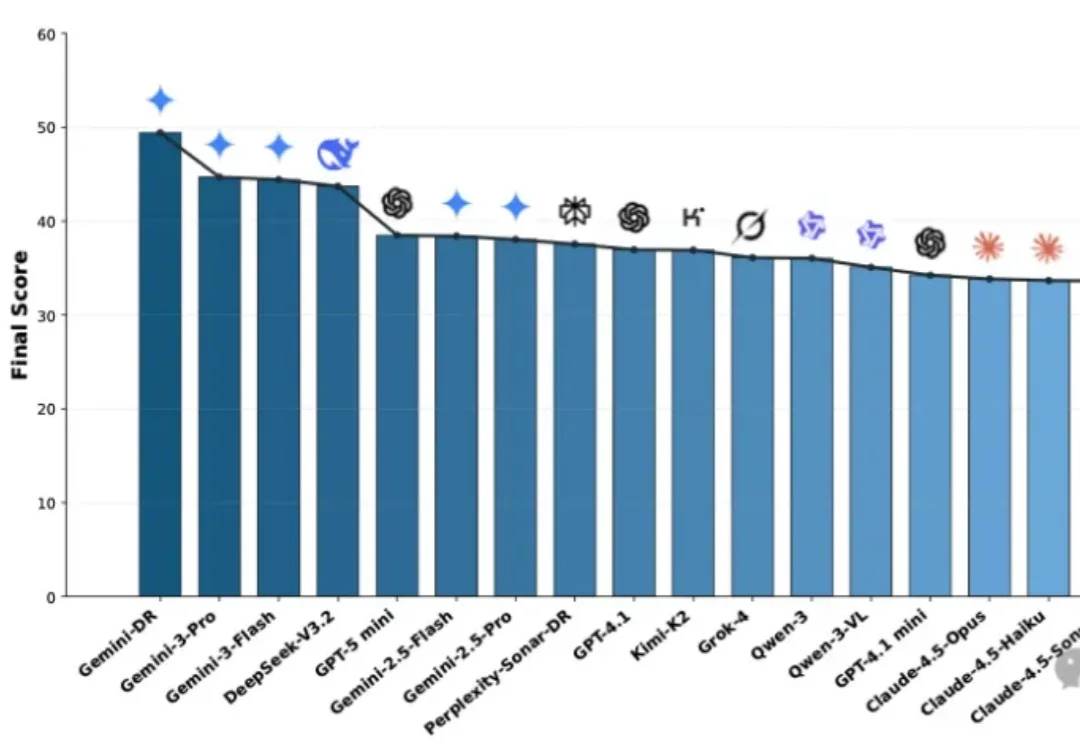

面对琳琅满目的Deep Research Agent(深度研究智能体),究竟该如何选型?本文基于OSU与Amazon最新发布的MMDR-Bench论文,为您提供一份经过严谨科学验证的“避坑指南”。结论先行:综合任务首选谷歌Gemini Deep Research,而涉及计算机科学与数据结构的硬核任务,GPT-5.2依然是专家首选。