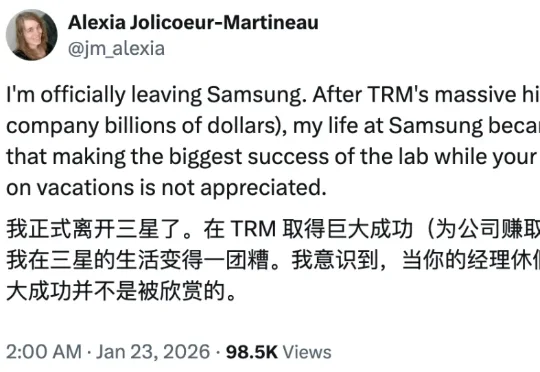

三星爆火递归模型TRM唯一作者被迫离职,内部不认可?

三星爆火递归模型TRM唯一作者被迫离职,内部不认可?还记得三个月前,来自三星的一位研究员的独作论文发布即爆火,颠覆了递归推理模型架构,让一个仅包含 700 万个参数的网络,性能比肩甚至超越 o3-mini 和 Gemini 2.5 Pro 等尖端语言模型,震惊了大量业内研究人士。

还记得三个月前,来自三星的一位研究员的独作论文发布即爆火,颠覆了递归推理模型架构,让一个仅包含 700 万个参数的网络,性能比肩甚至超越 o3-mini 和 Gemini 2.5 Pro 等尖端语言模型,震惊了大量业内研究人士。

2026年1月,前OpenAI CTO Mira Murati创办的明星公司Thinking Machines Lab遭遇「灭顶之灾」:联合创始人Barret Zoph因办公室恋情丑闻被降职后心生不满,联合另外两名核心骨干向Mira逼宫索权,遭拒后被当场开除。然而仅不到一小时,三人便集体叛逃回OpenAI,在老东家的迎接下风光回朝。

动点出海获悉,总部位于新加坡的AI初创公司Level3AI已宣布完成1300万美元的种子轮融资。据悉,本轮融资由Lightspeed领投,BEENEXT、500 Global、Sovereign’s Capital以及Goodwater Capital参与跟投。

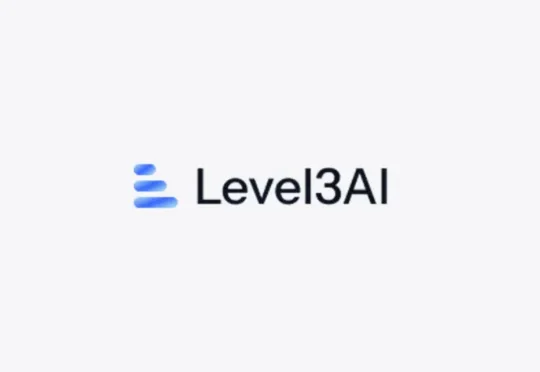

今天,清华大学 THUNLP 实验室、东北大学 NEUIR 实验室、OpenBMB 、面壁智能与 AI9Stars 联合发布 UltraRAG 3.0 ,针对上述痛点,为科研工作者与开发者打造更懂开发者的技术框架,具备 3 大核心优势:

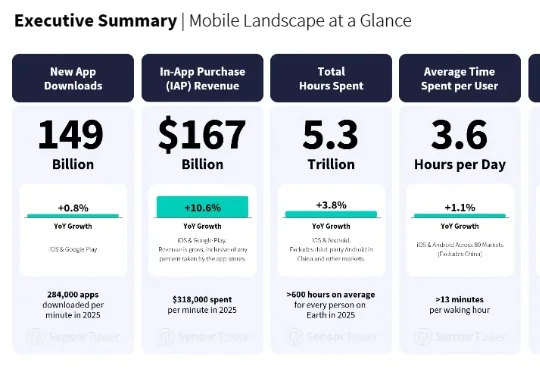

最近,移动应用数据分析商 Sensor Tower 发布了一份《State of Mobile 2026》。AI 应用的增长不但没有减速,反而更快了。AI 应用的下载量翻倍,达到 38 亿次;IAP 收入增长超过三倍,突破 50 亿美元;

AI 推理基础设施公司 Baseten 近日完成一轮 3 亿美元的成长型融资,投后估值约 50 亿美元。与不到六个月前的一轮重要融资相比,公司估值几乎翻倍。 这一交易清晰地表明,在大模型训练之外,推理

路透社最新消息,Meta 新成立的 AI 团队本月已在内部交付了首批关键模型。据悉,该消息来自 Meta 公司的 CTO Andrew Bosworth,他表示该团队的 AI 模型「非常好」(very good)。

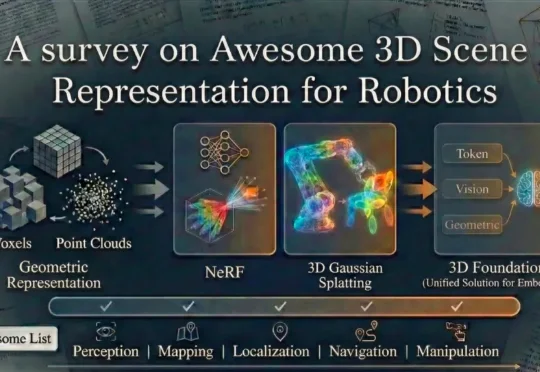

上海交通大学、波恩大学等院校的研究团队全面总结了当前机器人技术中常用的场景表示方法。这些方法包括传统的点云、体素栅格、符号距离函数以及场景图等传统几何表示方式,同时也涵盖了最新的神经网络表示技术,如神经辐射场、3D 高斯散布模型以及新兴的 3D 基础模型。

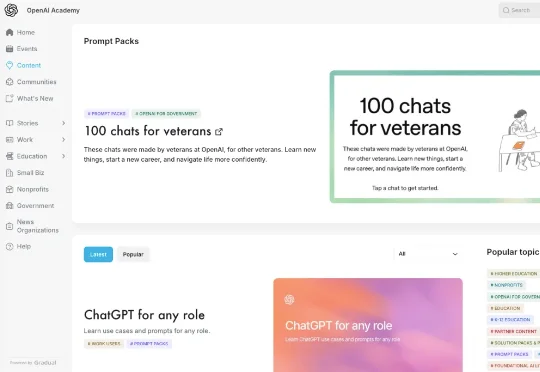

就在最近,OpenAI 终于把"丹炉"和"配方"都端出来了。OpenAI Academy 悄悄上线了一个名为 Prompt Packs(提示词包) 的资源库。

谷歌 DeepMind 发布 D4RT,彻底颠覆了动态 4D 重建范式。它抛弃了复杂的传统流水线,用一个统一的「时空查询」接口,同时搞定全像素追踪、深度估计与相机位姿。不仅精度屠榜,速度更比现有 SOTA 快出 300 倍。这是具身智能与自动驾驶以及 AR 的新基石,AI 终于能像人类一样,实时看懂这个流动的世界。