360智脑开源Light-R1!1000美元数学上首次从零超越DeepSeek-R1-Distill

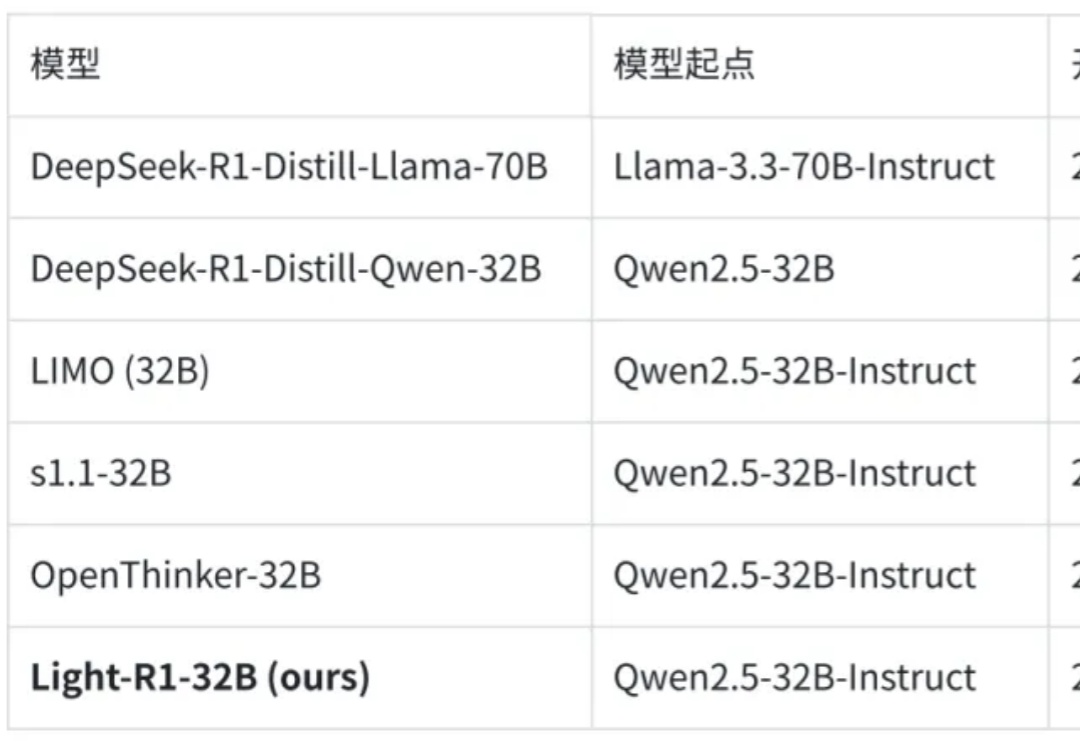

360智脑开源Light-R1!1000美元数学上首次从零超越DeepSeek-R1-Distill2025 年 3 月 4 日,360 智脑开源了 Light-R1-32B 模型,以及全部训练数据、代码。仅需 12 台 H800 上 6 小时即可训练完成,从没有长思维链的 Qwen2.5-32B-Instruct 出发,仅使用 7 万条数学数据训练,得到 Light-R1-32B

2025 年 3 月 4 日,360 智脑开源了 Light-R1-32B 模型,以及全部训练数据、代码。仅需 12 台 H800 上 6 小时即可训练完成,从没有长思维链的 Qwen2.5-32B-Instruct 出发,仅使用 7 万条数学数据训练,得到 Light-R1-32B

LLM一个突出的挑战是如何有效处理和理解长文本。就像下图所示,准确率会随着上下文长度显著下降,那么究竟应该怎样提升LLM对长文本理解的准确率呢?

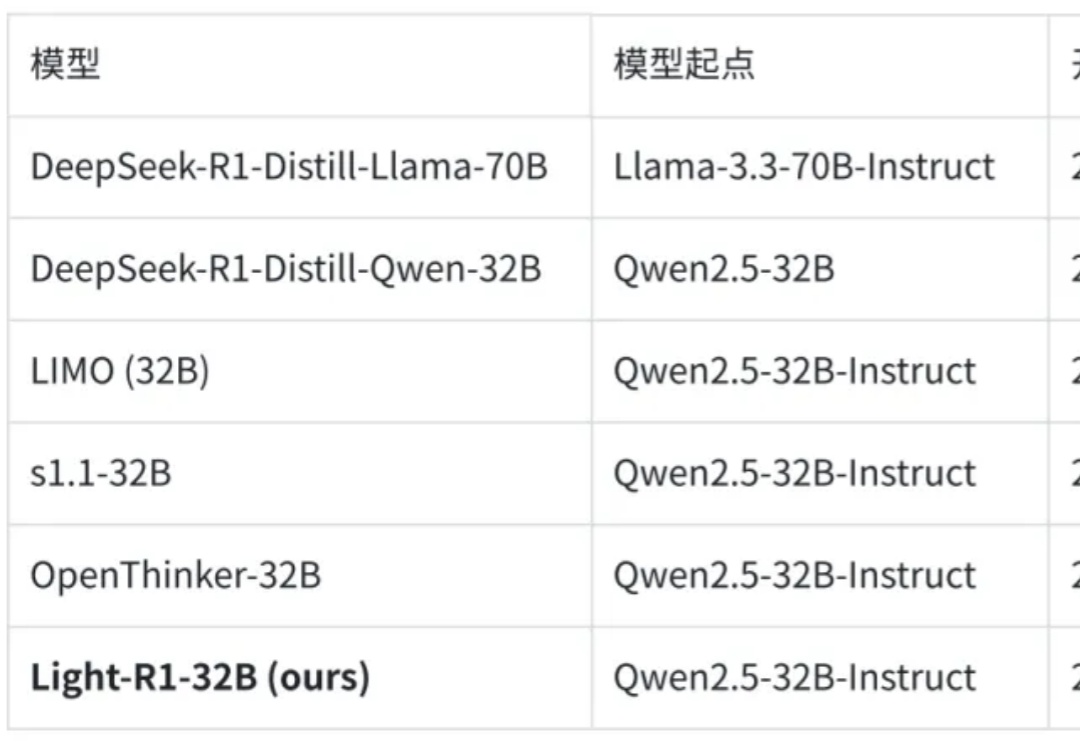

前两天,在下面这篇文章里,已经给大家介绍过通过一句话提示词生成app原型图,再截图让Cursor完成app开发的方法了。

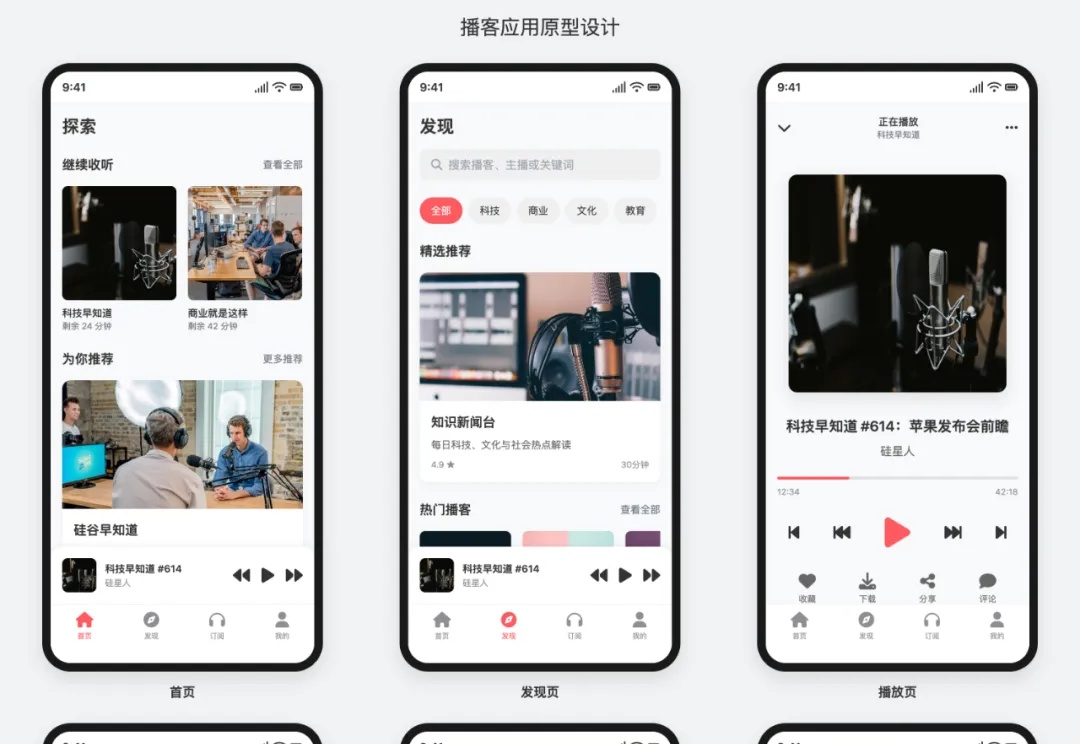

自从上周Claude 3.7 Sonnet发布,我的 X 就被这玩意刷屏了好几天。

一夜之间,RTX 5070被网友们喷成“史上最差的70系列”了。

Anthropic 最近动作不断。

DeepSeek R1 催化了 reasoning model 的竞争:在过去的一个月里,头部 AI labs 已经发布了三个 SOTA reasoning models:OpenAI 的 o3-mini 和deep research, xAI 的 Grok 3 和 Anthropic 的 Claude 3.7 Sonnet。

GOSIM 是致力于为创新项目搭建全球化的开放、多元、包容的合作与发展平台。2025 年 5 月 6 - 7 日,GOSIM AI Paris 2025 大会将于在法国巴黎 Station F 举行,诚邀全球顶尖的 AI 专家、技术开发者、学者和开源创新者齐聚法国巴黎,共同探讨 AI 技术的未来发展。

谷歌DeepMind 研究科学家 Nicholas Carlini,一位机器学习和计算机安全领域的大牛。以最贴近现实实用的角度,分享了他对大模型的看法,以及自己对大模型应用的50个案例。

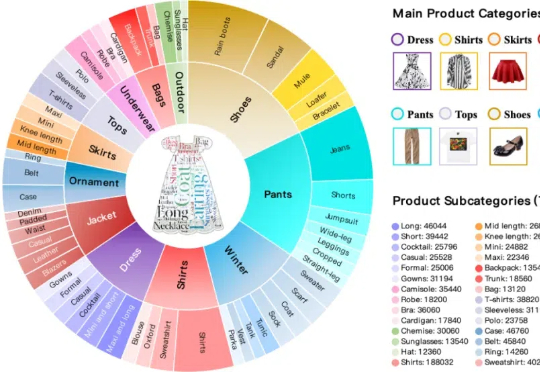

本文构建了新的多轮组合图像检索数据集和评测基准FashionMT。其特点包括:(1)回溯性:每轮修改文本可能涉及历史参考图像信息(如保留特定属性),要求算法回溯利用多轮历史信息;(2)多样化:FashionMT包含的电商图像数量和类别分别是MT FashionIQ的14倍和30倍,且交互轮次数量接近其27倍,提供了丰富的多模态检索场景。