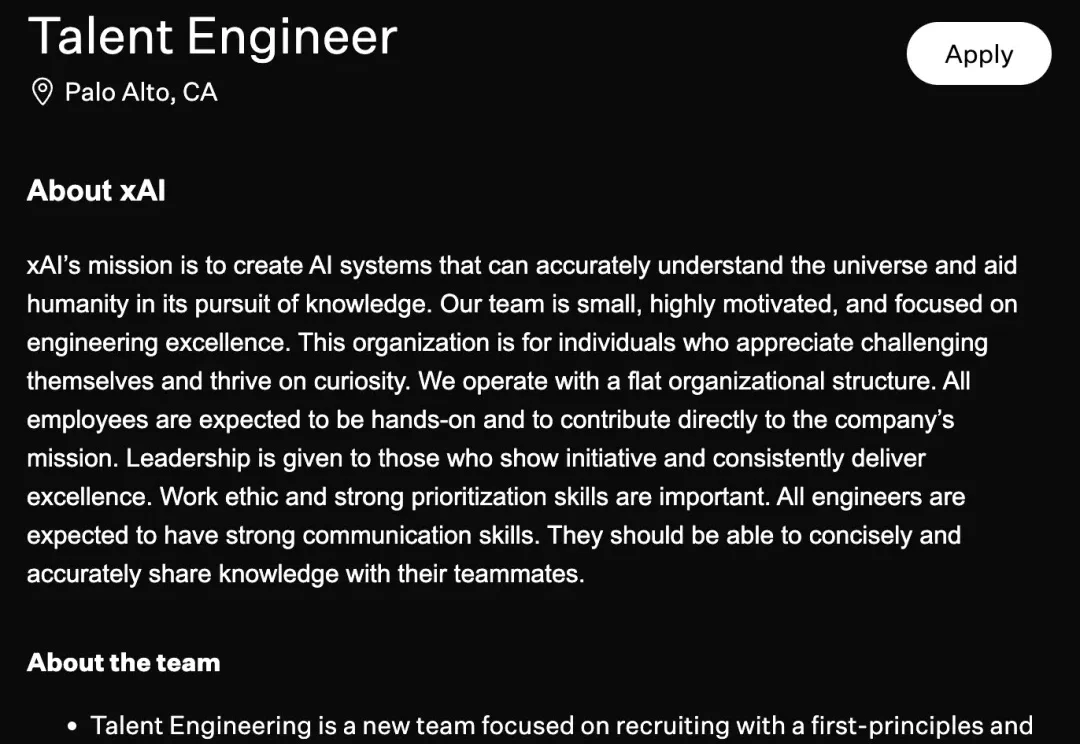

马斯克下场抢人!xAI组建「人才狙击队」,极客版HR年薪168万

马斯克下场抢人!xAI组建「人才狙击队」,极客版HR年薪168万马斯克要亲自下场抢人了。

马斯克要亲自下场抢人了。

在当前的AI Research浪潮中,Autonomous Agents已经改变了我们获取信息的方式——从被动接收到主动检索。

想象一家“永不眠”的公司:白天,全天候运行的 Google Meet 与麦克风捕捉着办公室内的每一处沟通细节,AI 助理实时解析、拆解任务,并在次日清晨8点将策略与进度精准推送到员工指尖;夜幕降临,当人类休息时,另一套自动化流程无缝接管——监测报错、编写代码、生成PR,静待工程师次日一键合并。

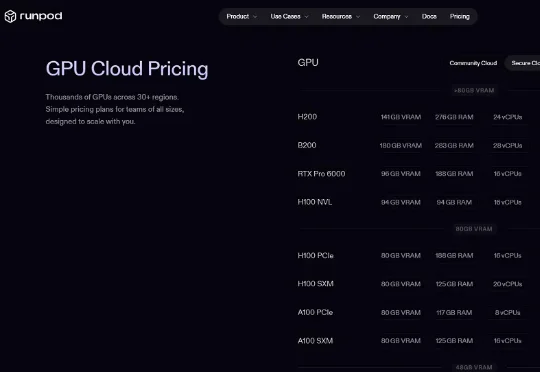

又一家ARR突破1亿美元的AI创企诞生了!近日,由华人CEO领衔的美国AI云创企RunPod对外披露,其年化收入已达到1.2亿美元(约合人民币8.35亿元),平台累计开发者用户数超过50万。

近日,中国科学技术大学(USTC)联合新疆师范大学、中关村人工智能研究院、香港理工大学,在数据驱动的多功能双连通多尺度结构逆向设计领域取得重要突破。

随着政府对于健康领域的重视和人们健康意识的普及,热量追踪应用的用户画像逐渐从以健身爱好者、减重者为主的专业细分群体,逐步转向以普通大众为主的非专业用户,与专业细分群体相比,他们更倾向于追求“简单、易上手”的体验。

谷歌对其Gemini AI 模型的改进正在提升公司的核心收入。

今天,刚刚成立3个月的美国AI创企Humans&宣布拿下一轮4.8亿美元(约合人民币33.41亿元)的种子轮融资,估值达44.8亿美元(约合人民币311.86亿元),直接晋身独角兽行列。

知情人士独家讲述:陈天桥与代季峰的MiroMind团队发生了什么?1月18日,盛大集团与MiroMind发布联合声明,代季峰从即日起卸任技术顾问一职。这周一,MiroMind内部员工发现,代季峰已经退出了公司群。

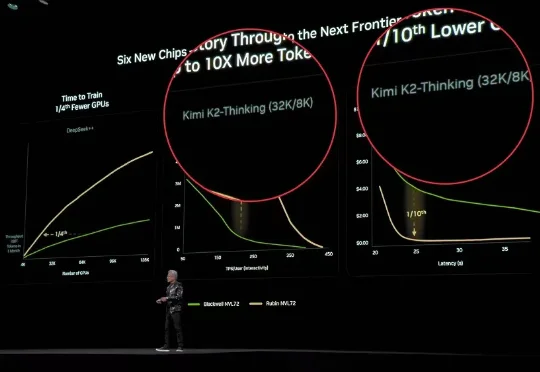

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。