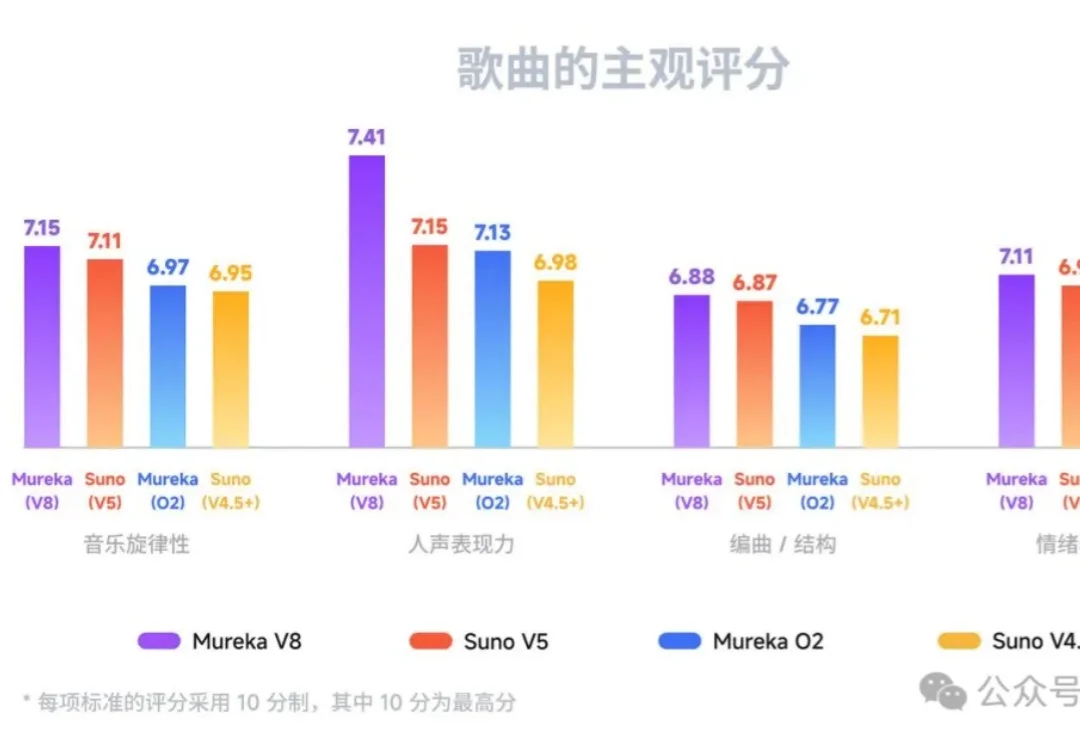

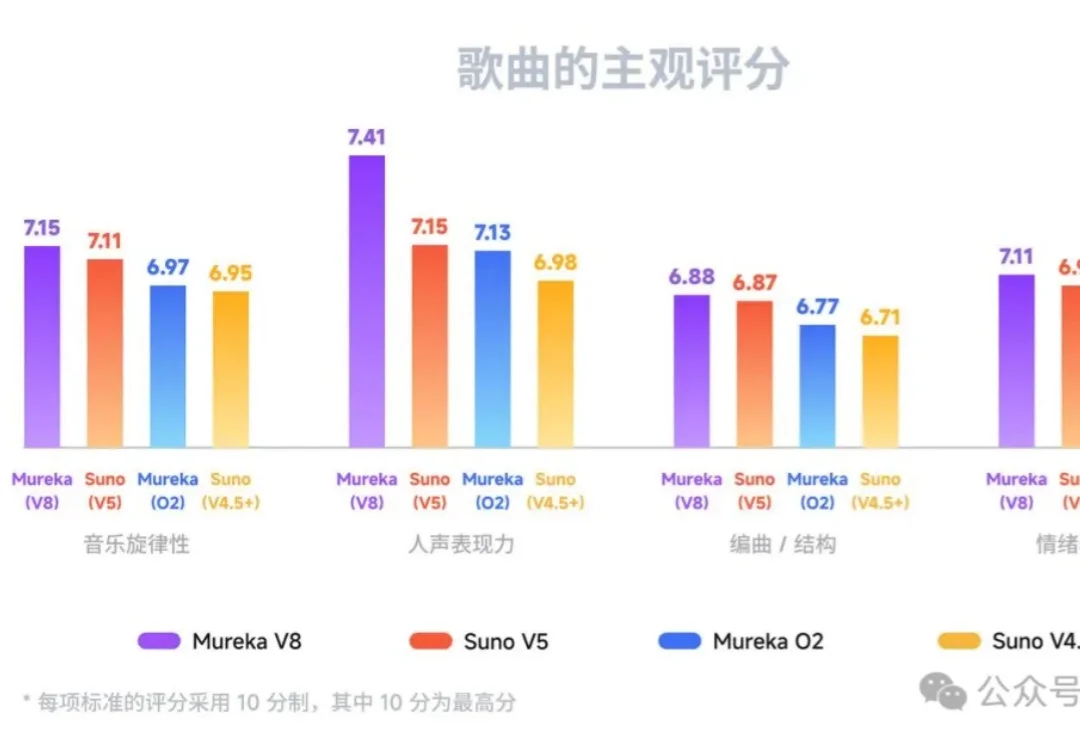

全球最强AI音乐模型,现在来自中国!高晓松也来围观了

全球最强AI音乐模型,现在来自中国!高晓松也来围观了把AI模型发布会开在Livehouse,昆仑天工你是懂氛围感的(doge)!

把AI模型发布会开在Livehouse,昆仑天工你是懂氛围感的(doge)!

1月28日消息,据彭博社和《华尔街日报》最新披露,软银集团正与OpenAI洽谈一笔最高达300亿美元(约合人民币2083.8亿元)的追加投资。

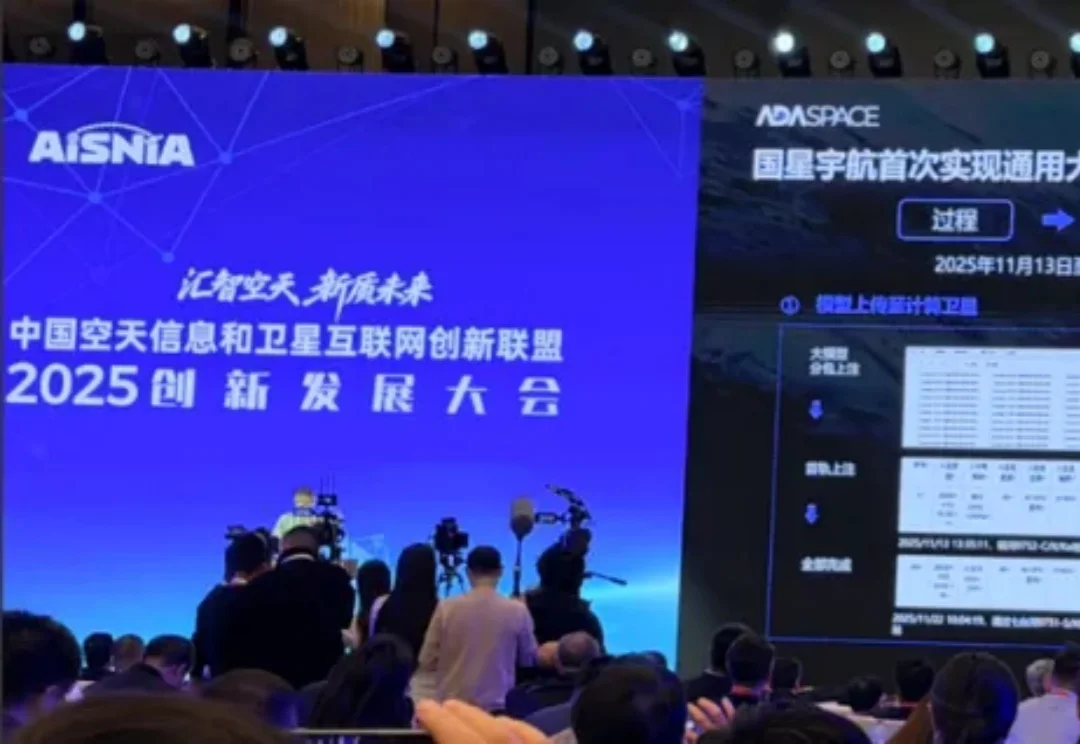

岁末年初,全球AI竞争聚焦到了最新趋势—— 太空算力。

随着无需向云端发送敏感数据、以隐私为先的企业级人工智能需求日益增长,SpotDraft 已从高通风险投资公司获得 800 万美元战略 B 轮扩展融资,以扩展其面向受监管法律工作流程的端侧合同审评技术。

AI能帮你写法律文书,但它也可能帮你编造6个根本不存在的判例。

芝加哥教授20分钟干完48小时工作,零基础小白10分钟造出完整App,前xAI工程师睡一觉醒来项目就做好了……Claude Code正在重新定义「编程」这件事。

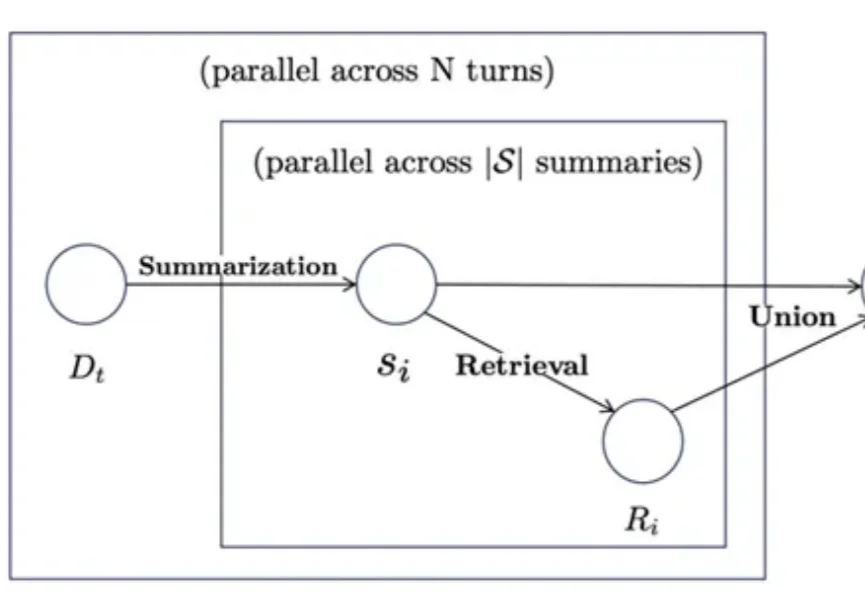

思维导图曾被证明可以帮助学习障碍者快速提升成绩,那么当前已经可堪一用的智能体系统如果引入类似工具是否可以帮助改善长期学习记忆能力呢?有研究团队做出了探索性尝试。

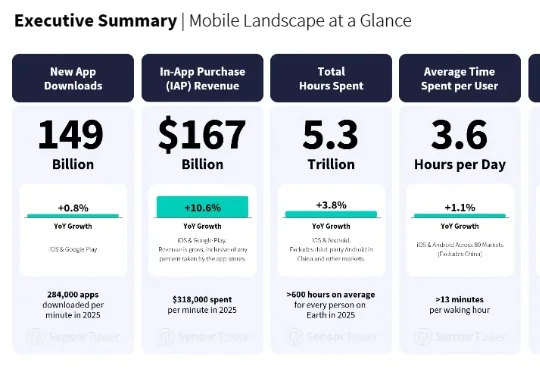

最近,移动应用数据分析商 Sensor Tower 发布了一份《State of Mobile 2026》。AI 应用的增长不但没有减速,反而更快了。AI 应用的下载量翻倍,达到 38 亿次;IAP 收入增长超过三倍,突破 50 亿美元;

马斯克「Macrohard」(巨硬)黑幕曝光!xAI工程师爆料:AI智能体将8倍速模拟人类,或取代亿万白领岗位。

今天,Anthropic 试图向世界展示它的灵魂。Anthropic 正式公布了一份长达 84 页的特殊文档——《Claude 宪法》(Claude's Constitution)。这份文件并非通常意义上的技术白皮书或用户协议,而是一份直接面向 AI 模型本身「撰写」的价值观宣言。