刚刚,微软全新一代自研AI芯片Maia 200问世

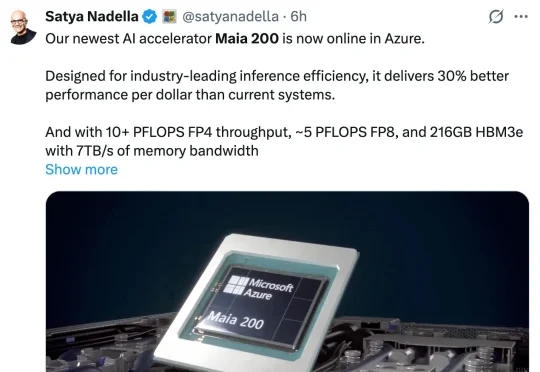

刚刚,微软全新一代自研AI芯片Maia 200问世一觉醒来,我们看到了微软自研 AI 芯片的最新进展。 微软原定于 2025 年发布的下一代 AI 芯片 Maia 200,终于在今天问世!根据微软官方介绍,Maia 200 作为一款强大的 AI 推理加速器,旨在显著改善 AI token 生成的经济性。

一觉醒来,我们看到了微软自研 AI 芯片的最新进展。 微软原定于 2025 年发布的下一代 AI 芯片 Maia 200,终于在今天问世!根据微软官方介绍,Maia 200 作为一款强大的 AI 推理加速器,旨在显著改善 AI token 生成的经济性。

AI 推理基础设施公司 Baseten 近日完成一轮 3 亿美元的成长型融资,投后估值约 50 亿美元。与不到六个月前的一轮重要融资相比,公司估值几乎翻倍。 这一交易清晰地表明,在大模型训练之外,推理

马斯克官宣,全球首个吉瓦级超算Colossus 2正式上线,狂堆55万块GPU,目标直指百万。下一代Grok 5已在训练,6万亿参数将引爆智能奇点。

本次发布的核心——AIMesh,正是这场架构创新的集大成者。 它被定义为面向「AI工厂」的数据与内存网,核心思路是用一套「三网合一」的柔性网络,替代传统僵化的存储架构。

“卡买回来了,然后呢?”

巨头们围绕AI的人才争夺战,现在不止于计算机领域了。

2022年,Google Cloud 将π计算到100万亿位,在2025年,高性能计算界的知名评测机构 StorageReview只用了4个月的时间,花了不到一千美元电费就将π算到314万亿位,这可不是为了炫技,而是说明高性能计算也可以很节能。

Meta腾出CoWoS排产「让路」,加上台积电的积极扩产,2026年谷歌把TPU的「算力水龙头」拧到最大,预期产能飙升至430万颗,猛攻英伟达CUDA护城河。

十年前,三星工程师 June Paik 因跟腱断裂卧床,却意外在床上洞察到了 AI 浪潮。十年后,他创立的 FuriosaAI 拒绝了 Meta 的收购,带着名为「叛逆者(RNGD)」的芯片,誓要在英伟达主宰的算力帝国中撕开一道缺口。

2026年开局,Anthropic未发一弹已占先机!谷歌首席工程师Jaana Dogan连发多帖,高度赞扬Claude Opus 4.5——没有图像/音频模型、巨大的上下文,仅有一款专注编码的Claude,Anthropic依旧是OpenAI谷歌最有力竞争者。