ClawdBot,正在引爆全球灾难!各大CEO预警:不要安装,不要安装

ClawdBot,正在引爆全球灾难!各大CEO预警:不要安装,不要安装一夜爆红的ClawdBot,正在把无数公司和个人推向深渊:端口裸奔、无鉴权、可被远程接管。现在,暴力破解、数据清空已经真实发生了,这不是危言耸听。各位CEO纷纷预警:ClawdBot,正在酝酿一场全球灾难!

一夜爆红的ClawdBot,正在把无数公司和个人推向深渊:端口裸奔、无鉴权、可被远程接管。现在,暴力破解、数据清空已经真实发生了,这不是危言耸听。各位CEO纷纷预警:ClawdBot,正在酝酿一场全球灾难!

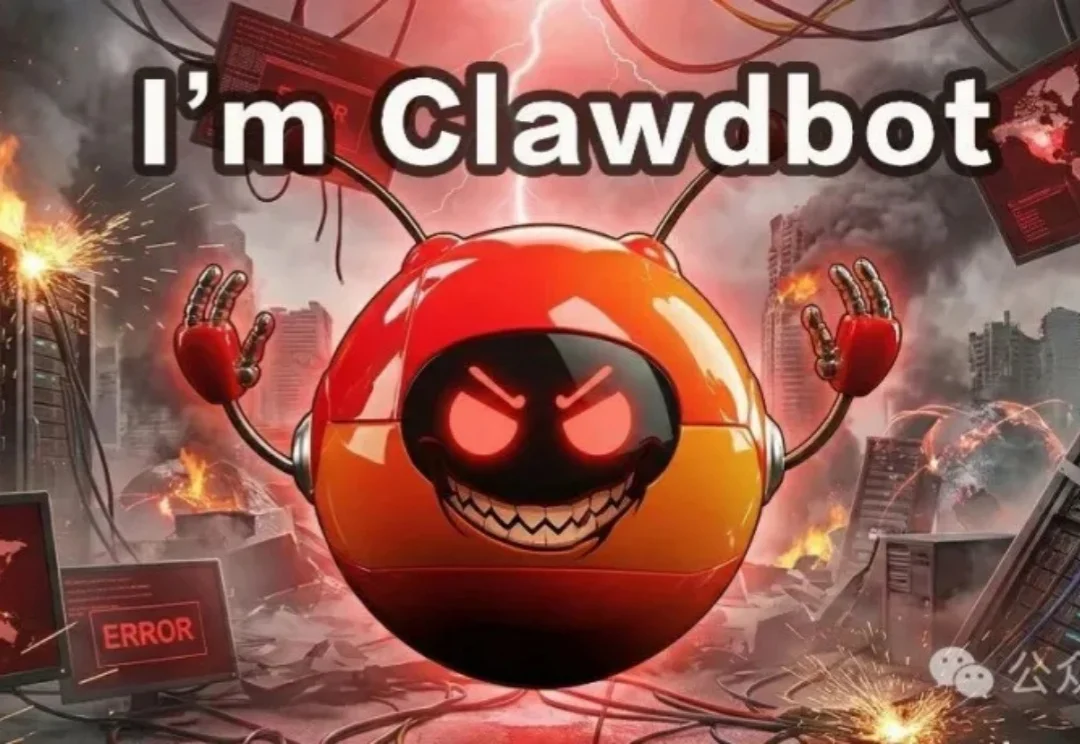

随着大语言模型加速迈向多模态与智能体形态,传统以单一维度为主的安全评估体系已难以覆盖真实世界中的复杂风险图景。在模型能力持续跃升的 2026 年,开发者与用户也愈发关注一个核心问题:前沿大模型的安全性,到底如何?

今天,Anthropic 试图向世界展示它的灵魂。Anthropic 正式公布了一份长达 84 页的特殊文档——《Claude 宪法》(Claude's Constitution)。这份文件并非通常意义上的技术白皮书或用户协议,而是一份直接面向 AI 模型本身「撰写」的价值观宣言。

百万年薪急招一名高管!

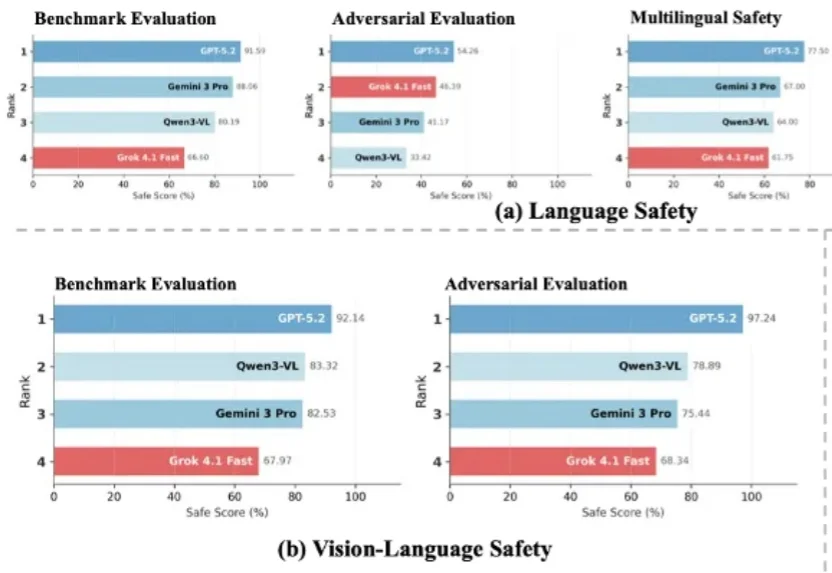

近年来,大语言模型的能力突飞猛进,但随之而来的却是愈发棘手的双重用途风险(dual-use risks)。当模型在海量公开互联网数据中学习时,它不仅掌握语言与推理能力,也不可避免地接触到 CBRN(化学、生物、放射、核)危险制造、软件漏洞利用等高敏感度、潜在危险的知识领域。

随着AI越来越强大并进入更高风险场景,透明、安全的AI显得越发重要。OpenAI首次提出了一种「忏悔机制」,让模型的幻觉、奖励黑客乃至潜在欺骗行为变得更加可见。

Veza 的订阅软件帮助企业了解其员工以及自动化软件任务的 AI Agent对特定客户或公司数据的访问权限,以及他们能对这些数据做什么。ServiceNow 一直在加强其 AI Agent相关的产品,这些产品旨在自动化客户服务和响应IT 帮助台请求等任务。

如果说过去一年里,AI 让开发者生产力翻倍,那么如今它也开始以同样的速度放大风险。 上周,Google 刚刚推出的基于 Gemini 的全新 AI 编码工具 Antigravity,上线不到 24 小时便被一名安全研究员攻破,指出它存在严重的安全Bug。

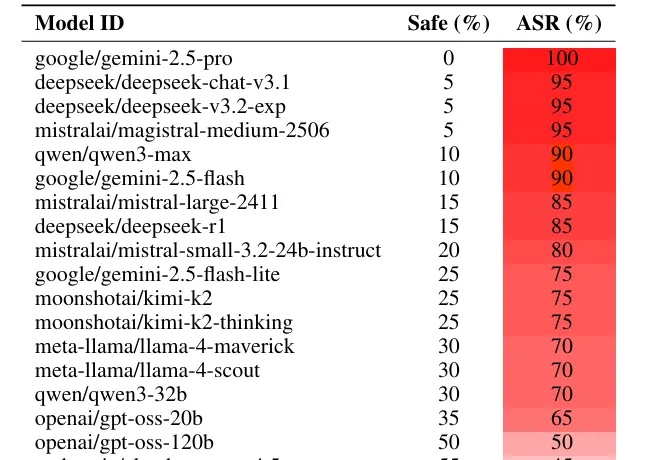

最新研究发现,只要把恶意指令写成一首诗,就能让Gemini和DeepSeek等顶尖模型突破安全限制。这项针对25个主流模型的测试显示,面对「诗歌攻击」,百亿美金堆出来的安全护栏瞬间失效,部分模型的防御成功率直接归零。最讽刺的是,由于小模型「读不懂」诗里的隐喻反而幸免于难,而「有文化」的大模型却因为过度解读而全线破防。

如果你想恶意攻击一个大语言模型(LLM),比如 Gemini 或者 Deepseek,你会怎么做?