DeepMind升级Transformer,前向通过FLOPs最多可降一半

DeepMind升级Transformer,前向通过FLOPs最多可降一半Transformer 的重要性无需多言,目前也有很多研究团队致力于改进这种变革性技术,其中一个重要的改进方向是提升 Transformer 的效率,比如让其具备自适应计算能力,从而可以节省下不必要的计算。

来自主题: AI资讯

4294 点击 2024-04-16 21:18

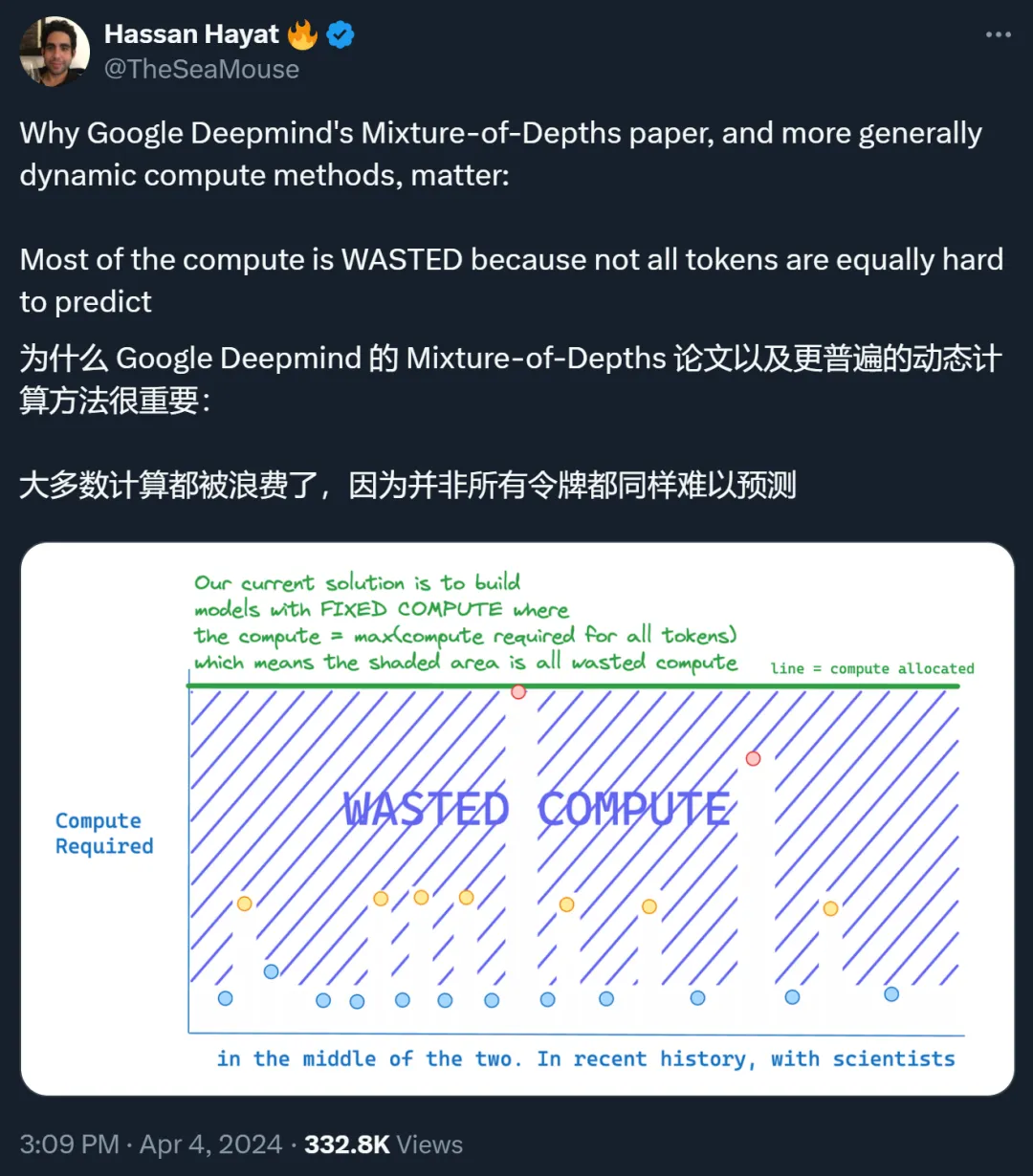

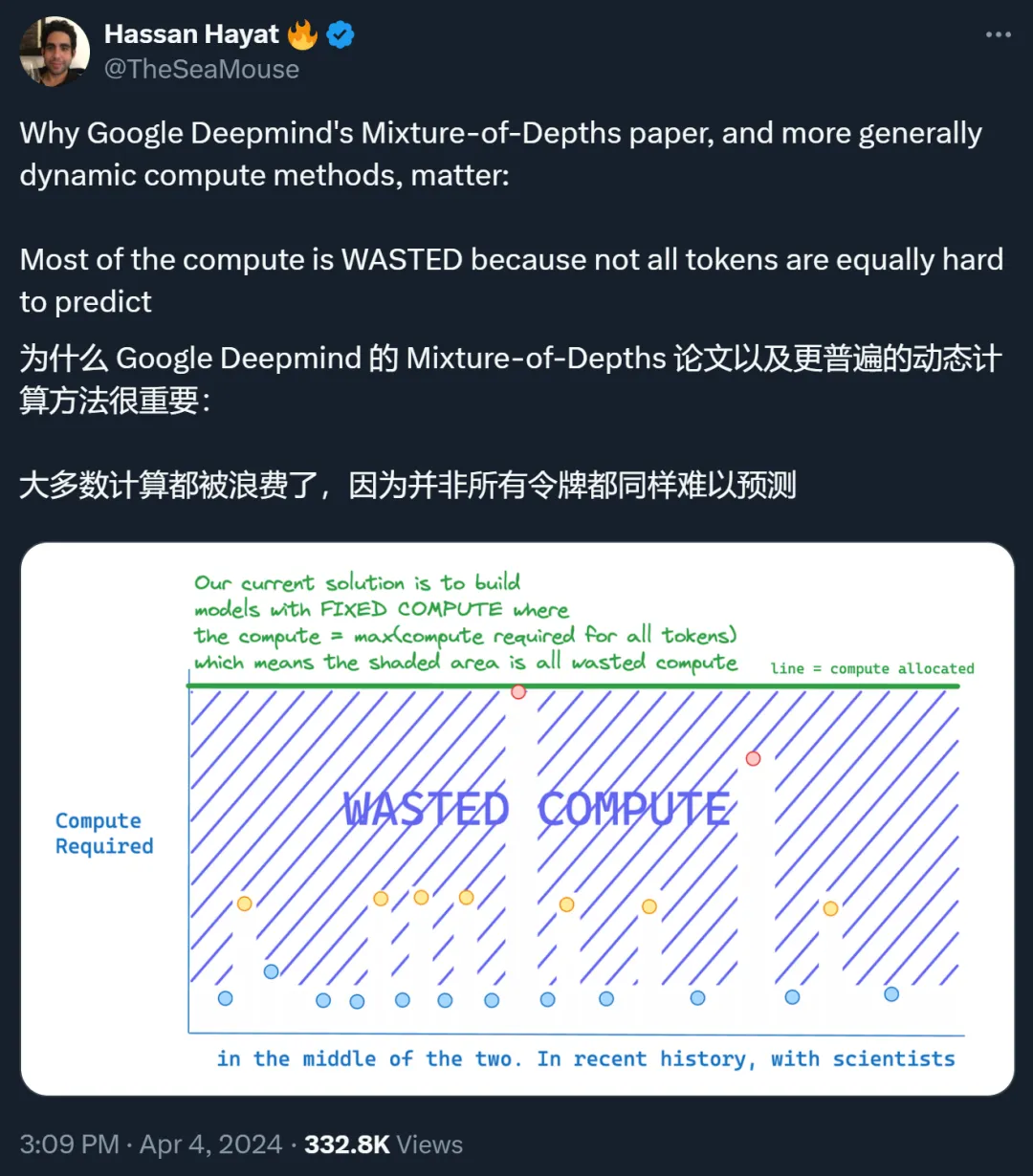

Transformer 的重要性无需多言,目前也有很多研究团队致力于改进这种变革性技术,其中一个重要的改进方向是提升 Transformer 的效率,比如让其具备自适应计算能力,从而可以节省下不必要的计算。

谷歌终于更新了Transformer架构。最新发布的Mixture-of-Depths(MoD),改变了以往Transformer计算模式。它通过动态分配大模型中的计算资源,跳过一些不必要计算,显著提高训练效率和推理速度。

Hyena处理长序列输入比FlashAttention速度高100倍!最新发布的StripedHyena模型可能成下一代AI架构的新标准?