毕树超入职Meta后首发声:十年前怀疑AGI,如今深信AGI已至!

毕树超入职Meta后首发声:十年前怀疑AGI,如今深信AGI已至!Meta超级智能团队成员毕树超,回溯70年AI进化:从AlexNet掀起深度学习革命

Meta超级智能团队成员毕树超,回溯70年AI进化:从AlexNet掀起深度学习革命

字节跳动在 Trae IDE(Visual Studio Code 的分支)中发现的令人担忧的性能和隐私问题。主要发现包括:资源消耗过高(33 个进程 vs. VSCode 中为 9 个进程)、无论用户如何设置,遥测数据都会持续传输,以及令人担忧的社区管理实践。

高盛领投、WiL跟投,日本AI法律科技龙头LegalOn的Review工具。

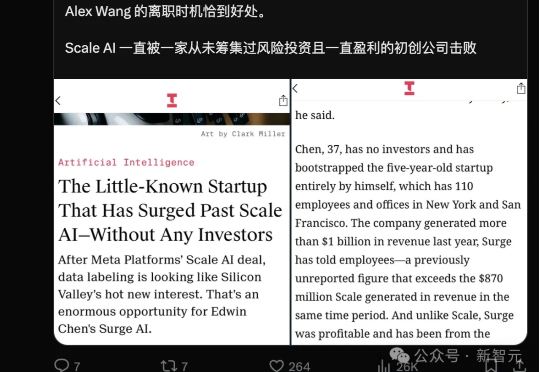

Meta投资148亿美元的Scale AI,原本被视为AI的「黄金选择」,然而,另一个名不见经传的后起之秀Surge AI,竟早已超越了它!一场AI大战,究竟谁能笑到最后?

一年一度的 WAIC 在明天就要开始了,在正式开展之前,我跟随官方的 city walk 路线探访了一番。 我探访的这条「AI+智慧生活路线」一共有三个目的地:上海发那科机器人有限公司、上海腾讯滨江大厦、模速空间的智能产品体验中心。

Surge AI 成立于 2020 年,是一家专注于数据标注的公司。自成立以来,主创团队都极为低调,社交平台上鲜有公开动态。即便如此,Surge AI 仍在短短几年内实现了业绩大爆发,并成为业内公认的“领域最大且最好的玩家”。截至 2024 年,Surge AI 的 ARR 已突破 10 亿美元,超越了行业巨头 Scale AI 的 8.7 亿美元收入,成为其最大的竞争对手。

那是 1964 年,德国南部的小城爱尔兰根,阳光洒落在西门子数据中心的窗格上,一台名为 Zuse Graphomat Z64 的绘图仪静静运转着。 它并不懂何为艺术,却在工业数学家 Georg Nees 的指令下,画出了世界上最早一批由计算机生成的图像。

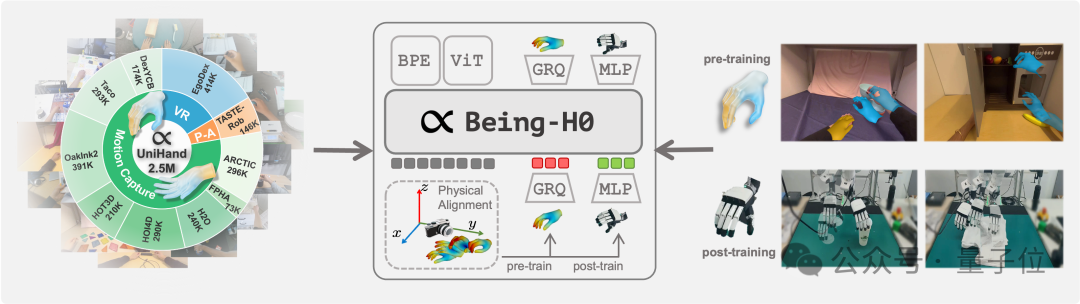

如何让机器人从看懂世界,到理解意图,再到做出动作,是具身智能领域当下最受关注的技术重点。 但真机数据的匮乏,正在使对应的视觉-语言-动作(VLA)模型面临发展瓶颈。

瑞士投资机构Blue Earth Capital 牵头,必和必拓Ventures 及力拓集团参与投资。比尔・盖茨旗下的Ventures(BEV)也参与了此次融资。 总部位于卡尔加里的矿业科技初创公司GeologicAI已完成4400万美元的B轮融资。

卡伦·考希克( Karun Kaushik )和塞林·科卡拉尔( Selin Kocalar )原本没打算这么快进行 A 轮融资。他们的人工智能合规初创公司 Delve 在今年 1 月刚宣布完成 300 万美元种子轮融资,业务增长迅猛且客户签约率稳定攀升。