日本人没做成的“AI桌面老婆”,上海团队拿下千万众筹|对话Dipal D1创始人

日本人没做成的“AI桌面老婆”,上海团队拿下千万众筹|对话Dipal D1创始人整个 2025年,至少两款以二次元为目标用户群、产品形态类似数字手办的 AI 桌面陪伴硬件在海外取得了不错的众筹成绩:「CODE27 Character Livehouse」于 4月在 Kickstarter 开启众筹,最终获得 3500 人支持,众筹金额超过 180 万美元;

整个 2025年,至少两款以二次元为目标用户群、产品形态类似数字手办的 AI 桌面陪伴硬件在海外取得了不错的众筹成绩:「CODE27 Character Livehouse」于 4月在 Kickstarter 开启众筹,最终获得 3500 人支持,众筹金额超过 180 万美元;

对初创公司来说,Superlinear(指数引力)的第一个业务 Deeplink 堪称成功:去年成立,今年的 ARR(年经常性收入) 就达到 500 万美元;且已经实现盈利。但创始人于北川并不打算在这个业务上继续重点投入,而是带领核心团队,全力转向了一款新产品 Lessie AI。

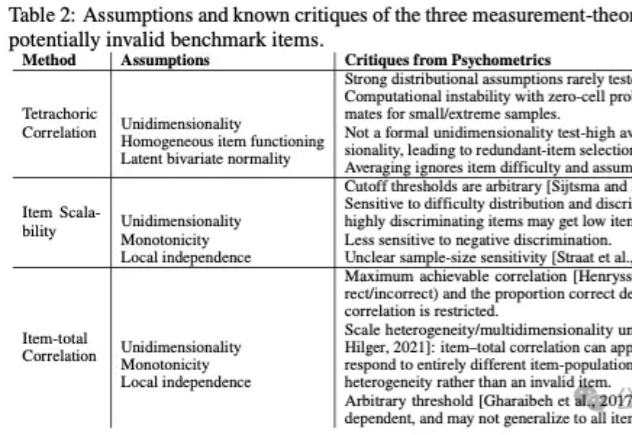

基准测试(Benchmarks)在人工智能的发展进程中扮演着至关重要的角色,构成了评价生成式模型(Generative Models)性能的事实标准。对于从事模型训练与评估的AI研究者而言,GSM8K、MMLU等数据集的数据质量直接决定了评估结论的可靠性。

谷歌Nano Banana Pro出世,又成为一个现象级爆款。这届网友彻底玩疯:手写试卷全对、秒出神级信息图、电影级分镜、跨世纪变装.....

“这个世界上或许不需要再多一个能帮你生成报告和PPT的工具,但需要一个真正关心你生活的存在”。Macaron AI创始人&CEO陈锴杰说道。

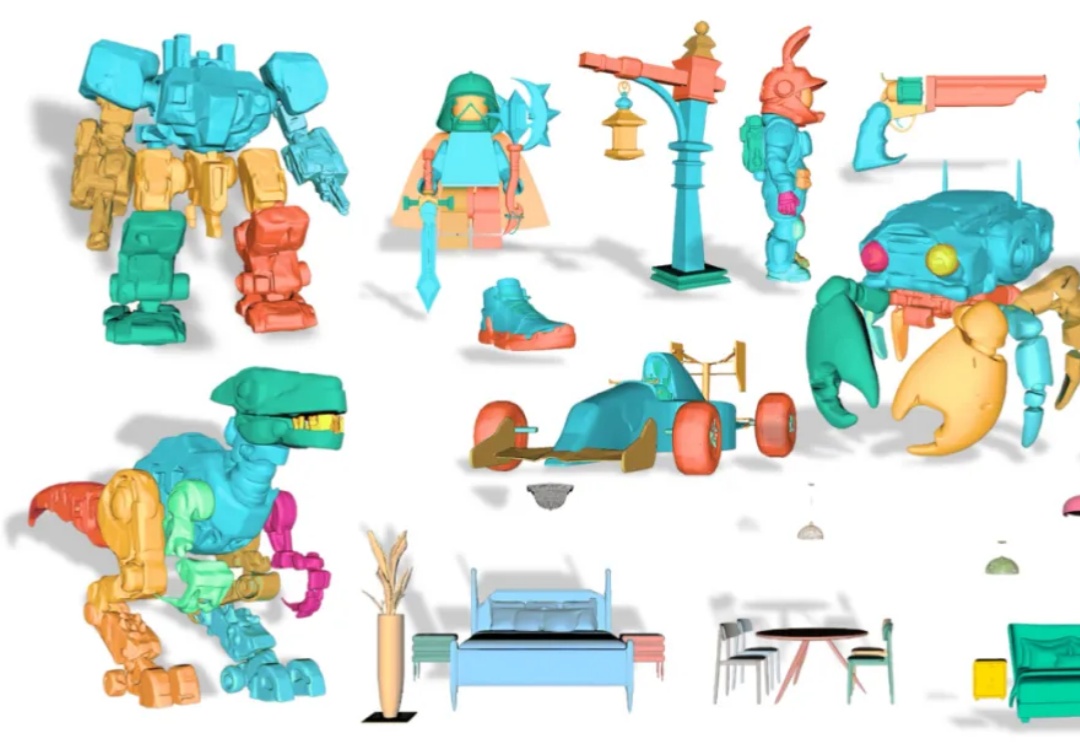

从单张图像创建可编辑的 3D 模型是计算机图形学领域的一大挑战。传统的 3D 生成模型多产出整体式的「黑箱」资产,使得对个别部件进行精细调整几乎成为不可能。

对于硬件,对于AR,应该都不甚了解的某知名投资人朱啸虎,对自己出手的第一个AI硬件也是AI眼镜项目是如此评价:“Gyges Labs的DigiWindow技术相比其他等方案,有着一个非常重要的优势:它的显示模组隐形,能把内容投到眼睛,

Google宣判RAG死刑!那条曾让无数工程师自豪的技术链,如今只剩下一行API调用。Gemini的File Search,把检索、分块、索引、引用,全都封进了模型内部。开发者不再需要理解流程,只需要上传文件。当智能被自动化吞并,工程师第一次发现,自己也成了被自动化的一部分。

美国加州大学圣地亚哥分校(UCSD)徐升教授对 DeepTech 表示:“很荣幸我们的工作成为 Nature Sensors 期刊的首篇论文,我们第一次通过 AI 的方法实现了在动态下抗运动伪影的人机交互,应用场景包括可穿戴和移动设备的手势控制、机器人遥操作、AR/VR 动作追踪、游戏、康复与辅助设备、工业与军事训练、健康与运动监测、

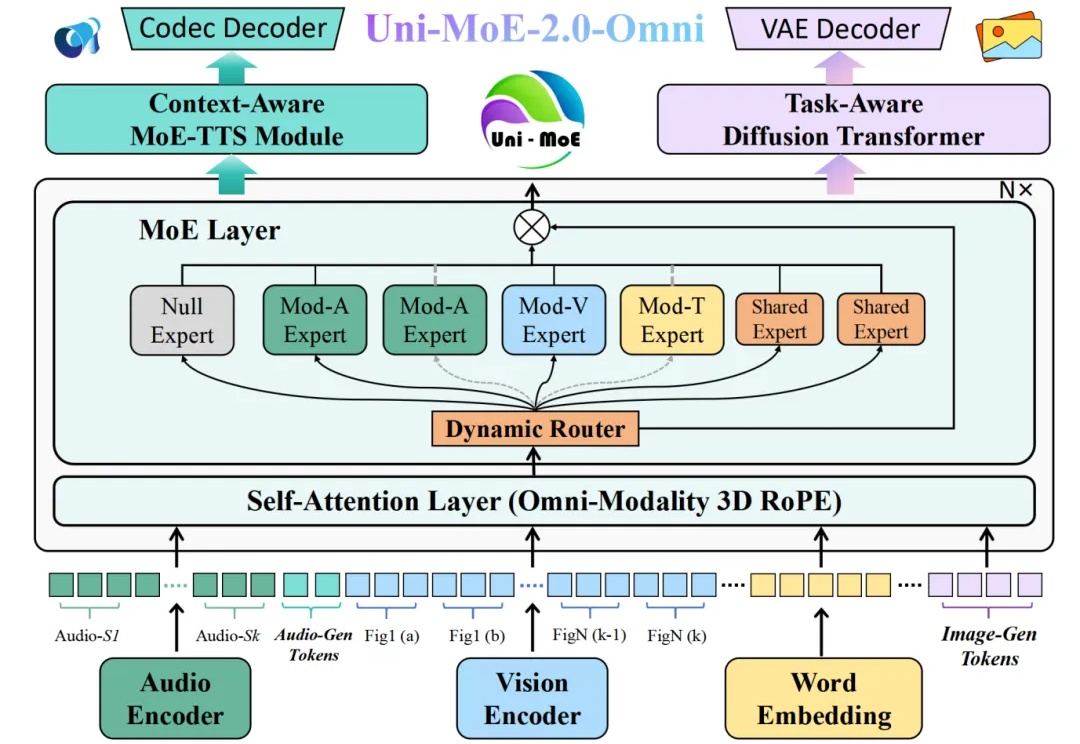

全模态大模型(Omnimodal Large Models, OLMs)能够理解、生成、处理并关联真实世界多种数据类型,从而实现更丰富的理解以及与复杂世界的深度交互。人工智能向全模态大模型的演进,标志着其从「专才」走向「通才」,从「工具」走向「伙伴」的关键点。