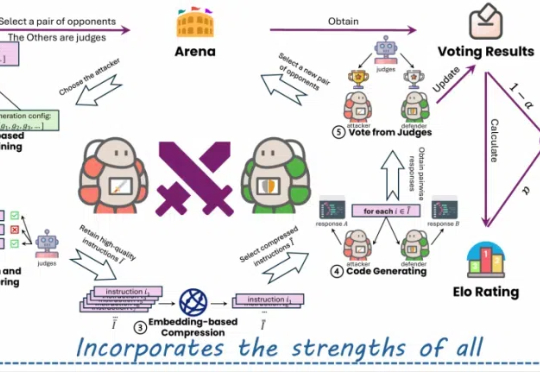

微软原WizardLM团队:代码大模型WarriorCoder,性能新SOTA

微软原WizardLM团队:代码大模型WarriorCoder,性能新SOTA近年来,大型语言模型(LLMs)在代码相关的任务上展现了惊人的表现,各种代码大模型层出不穷。这些成功的案例表明,在大规模代码数据上进行预训练可以显著提升模型的核心编程能力。

近年来,大型语言模型(LLMs)在代码相关的任务上展现了惊人的表现,各种代码大模型层出不穷。这些成功的案例表明,在大规模代码数据上进行预训练可以显著提升模型的核心编程能力。

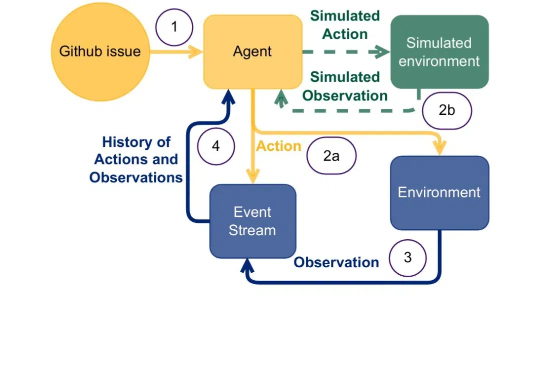

原来,大型推理模型(Large Reasoning Model,LRM)像人一样,在「用脑过度」也会崩溃,进而行动能力下降。

这份提示词有很多哲学性思考,很多表达让我看到背后的设计者把claude当成一个人去设计。 我猜,应该是Amanda Askell(Anthropic负责alignment和character design,是学哲学的一位女生,也是我的榜样) 主要设计的。

在老龄化浪潮和医疗系统承压的双重挑战下,居家养老成为破局关键。英国 Cera Care 独辟蹊径,以 AI 技术驱动数字化平台,不仅与政府深度合作,更实现住院率降低70%的医疗奇迹,日节省百万英镑,为深陷困境的英国医疗体系带来效率革命。

他是真的想教会大家。

2月12日,DeepSeek迎来全球首场诉讼,印度德里高等法院受理了一项公益诉讼(PIL)。公益诉讼申请人律师Bhavna sharma与Nihit Dalmia在诉讼向法院提出禁令,请求印度政府限制DeepSeek在印度提供服务。

AI引用正确率仅有4.2- 18.5%,用Deep Research就提高了引用正确率吗?似乎用Think&Cite框架的SG-MCTS和过程奖励机制PRM可以解决引用问题,生成可信内容。

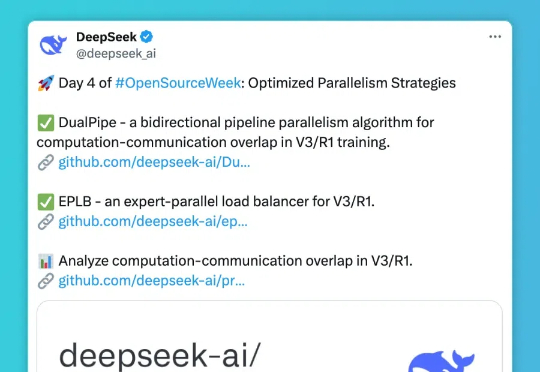

第四天,DeepSee发布包括三个主要项目: DualPipe- 一种用于 V3/R1 训练的双向流水线并行算法,实现计算和通信完全重叠; EPLB(Expert Parallelism Load Balancer) - 专为 V3/R1 设计的专家并行负载均衡器; Profile-data- 分析 V3/R1 中计算与通信重叠的性能数据集。

Mercor 是一家由三位 21 岁的 Thiel Fellows 创办的 AI 招聘初创公司,是科技行业增长最快的公司之一,去年 9 月 ARR 月增长率已经达到 50%,到目前,公司已经实现了 2 年内达到 7500 万美元 ARR 的突破,主要收入来自包括 OpenAI 在内的 AI 实验室。Mercor 近期完成 1 亿美元 B 轮融资,估值达到 20 亿美元。

近日,在红点创投(Redpoint Venture)的播客“Unsupervised Learning”上,红点创投合伙人Jacob Effron与David Luan进行了一次访谈。他们从技术视角出发,探讨了DeepSeek给大模型领域的研究和实践带来的启示,并围绕AI模型当下瓶颈的思考和潜在的突破方向做了分享。