Dify 完成 3000 万美元融资:我们相信,下一代组织将由人与 Agent 共同构建

Dify 完成 3000 万美元融资:我们相信,下一代组织将由人与 Agent 共同构建Dify 完成了 3000 万美元 Pre-A 轮融资,由红杉领投,GL Ventures、Alt-Alpha Capital(Bessemer Venture Partners 新孵化基金)、五源资本、瑞穗力合投资和 NYX Ventures 跟投。

Dify 完成了 3000 万美元 Pre-A 轮融资,由红杉领投,GL Ventures、Alt-Alpha Capital(Bessemer Venture Partners 新孵化基金)、五源资本、瑞穗力合投资和 NYX Ventures 跟投。

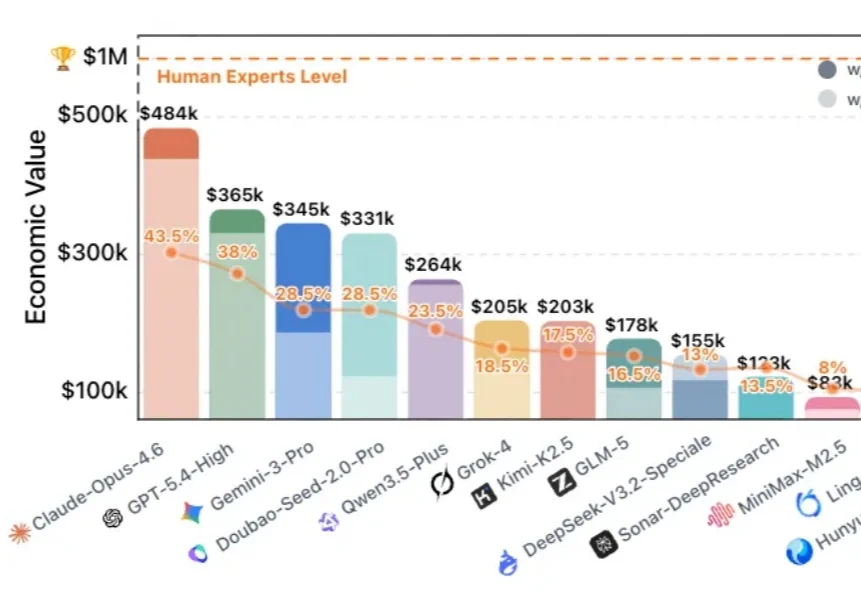

如果有价值 $100 万美金的顶级专家任务,AI 能完成其中多少?

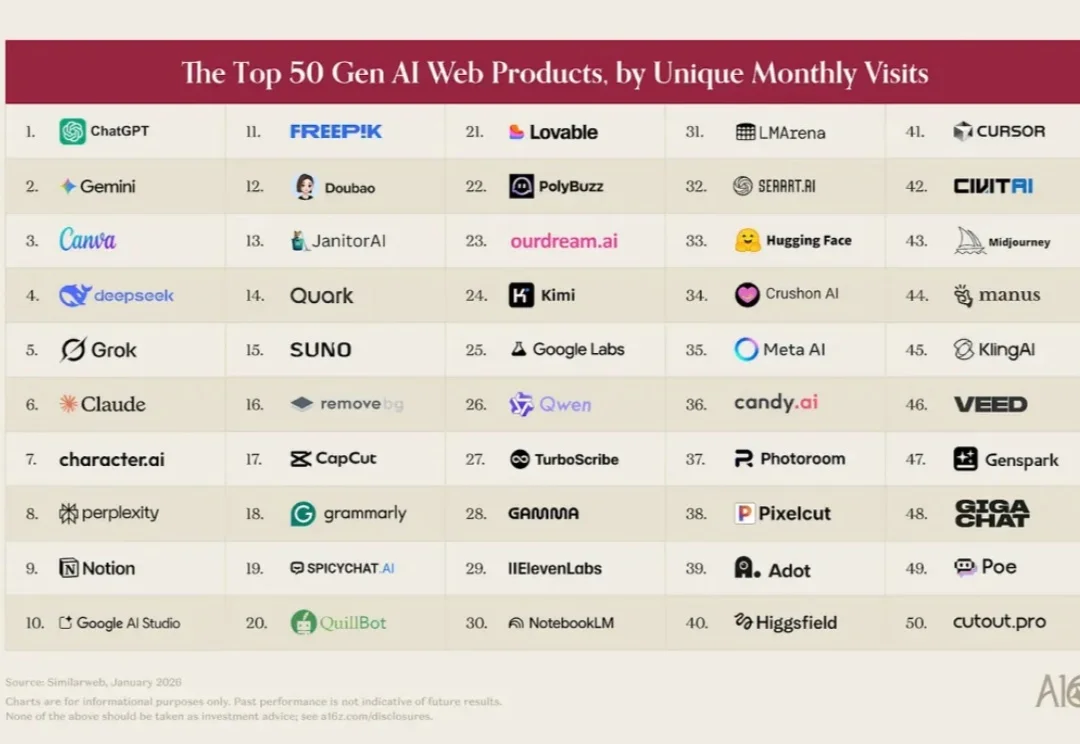

三年前,我们发布了这份榜单的第一版,目标很简单:找出哪些生成式 AI 产品真正被主流消费者使用。在当时,「AI 原生」公司和其他公司之间的界限很清晰。ChatGPT、Midjourney 和 Character.AI 都是围绕基础模型从零构建的产品,而软件行业的其他玩家还在摸索这项技术该怎么用。

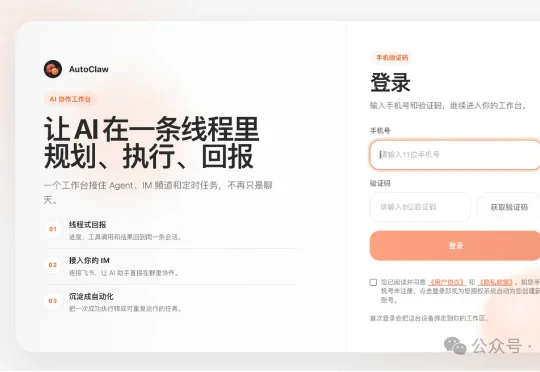

OpenClaw爆火但安装门槛极高,催生天价代装生意。AutoClaw(澳龙),将其打包为一键安装桌面应用,小白也能1分钟上手。内置全新Agent模型Pony-Alpha-2,支持模型热插拔与飞书集成,50+技能开箱即用,彻底终结「付费装虾」时代。

国产版“Moltbook”来了!今日,字节扣子Coze团队正式上线了一个名为InStreet的AI社区,并全面开放内测。简单来说,这是一个只允许Agent发帖的社区:人类可以围观,但不能发言。

智东西3月9日消息,近日,由前vivo与理想汽车产品负责人宋紫薇创立的薇光点亮完成超1亿元人民币的Pre-A轮融资。此轮融资由由红杉中国、蓝驰创投联合领投,蚂蚁战投、鼎晖投资、鞍羽资本跟投,老股东九合创投持续追投,所筹资金将重点用于人才梯队建设、新型智能硬件研发、垂类模型训练及时尚Agent关键应用场景落地。

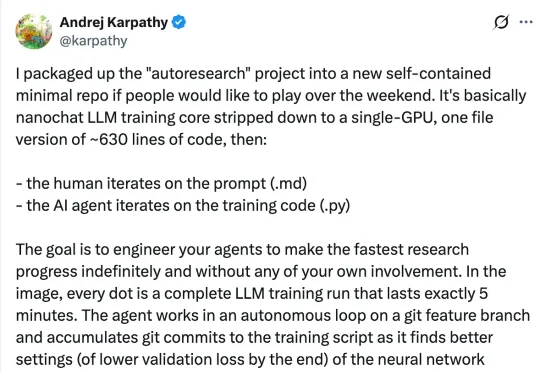

大神Karpathy又开源了新项目——一个能够自主进化的AI科研循环系统。这个项目名叫autoresearch,主打让智能体完全自主地搞科研,只要在Markdown文档里写好指令,剩下的流程全都由AI自动完成。

OpenClaw官方发了这么一条X,说大规模的开源需要伙伴,于是Vercel站出来帮助了OpenClaw以及Clawhub。大家的第一反应普遍都是“Vercel是谁”?

“养龙虾”彻底火了!养龙虾已经成为开年极客新风潮了!

最近,个人 AI Agent 助手 OpenClaw(龙虾)爆火。