速递|AI测试初创公司Momentic,华裔创始人有约2600名用户,完成1500万美元的A轮融资

速递|AI测试初创公司Momentic,华裔创始人有约2600名用户,完成1500万美元的A轮融资产品演示总能吸引眼球,但软件开发实则更常涉及调试、质量保证和检测这类工作。这些枯燥却关键的环节保障着软件正常运行。随着开发者寻求更多工作负载的自动化,这些工作正逐渐交由AI 来完成。

产品演示总能吸引眼球,但软件开发实则更常涉及调试、质量保证和检测这类工作。这些枯燥却关键的环节保障着软件正常运行。随着开发者寻求更多工作负载的自动化,这些工作正逐渐交由AI 来完成。

这两年,写代码这件事变了。GitHub Copilot、Cursor、Devin 一路登场,工程师开始习惯“打一段话,几千行代码自己长出来”。写得出东西,变得前所未有地容易。但很快大家发现,真正拖住上线节奏的,不再是「能不能写出来」,而是「敢不敢放上生产环境」——代码量指数级增长,验证、回归、极端场景覆盖反而被彻底压缩,测试成了 AI 时代新的“硬瓶颈”。

随着现在的主流大模型都能轻松通过图灵测试,这个持续了数十年的标准开始逐渐过时。奥特曼和量子计算之父David Deutsch讨论得出了一个新的图灵测试2.0标准,可以更好地衡量究竟怎样AI才算拥有真正的智能。

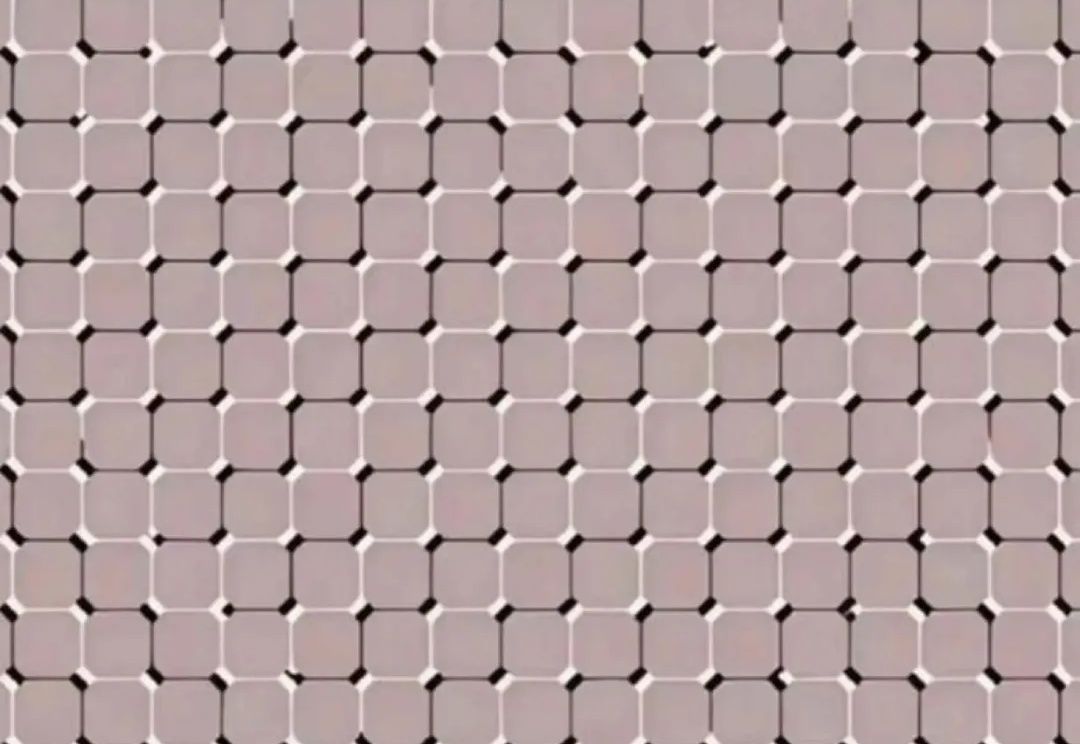

人眼秒懂,AI抓瞎!网友用光学错觉玩坏大模型,全网百万人围观。

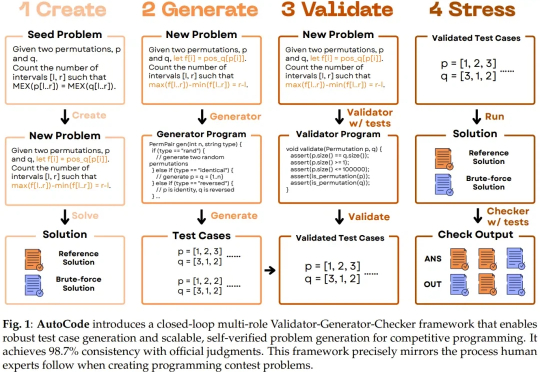

随着大型语言模型(LLM)朝着通用能力迈进,并以通用人工智能(AGI)为最终目标,测试其生成问题的能力也正变得越来越重要。尤其是在将 LLM 应用于高级编程任务时,因为未来 LLM 编程能力的发展和经济整合将需要大量的验证工作。

当你刚用 AI 生成了一个精美的电商网站,却在演示时购物车结账功能存在隐藏 Bug?

零代码、零bug,30分钟即可创建新网站。

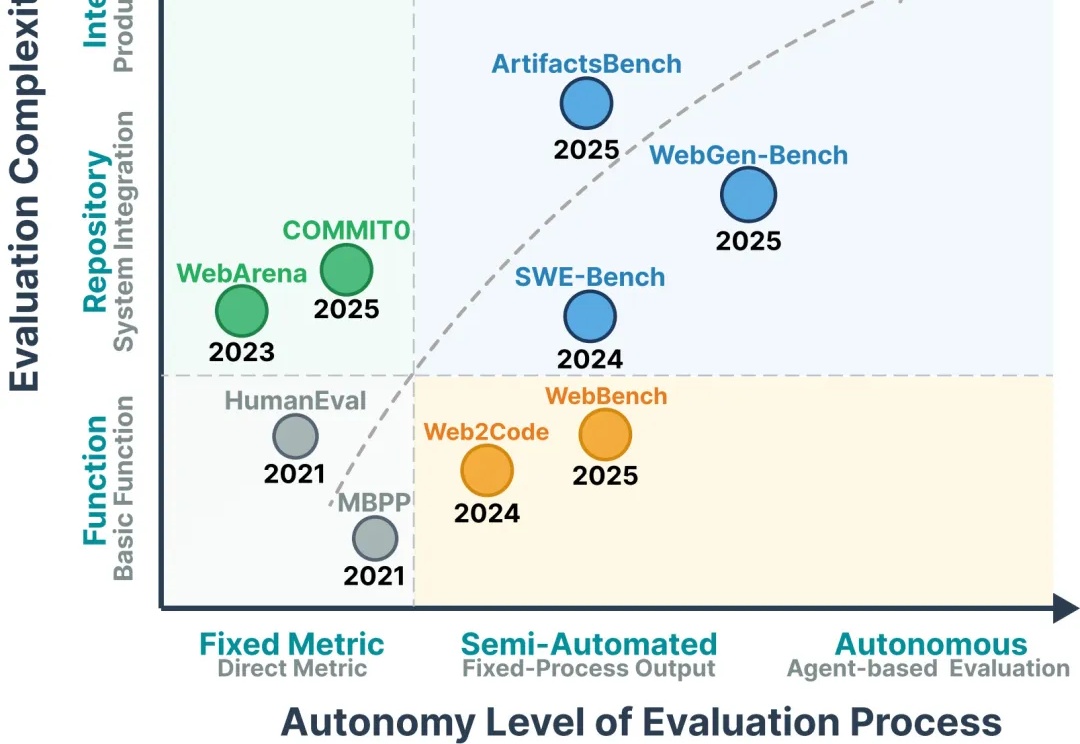

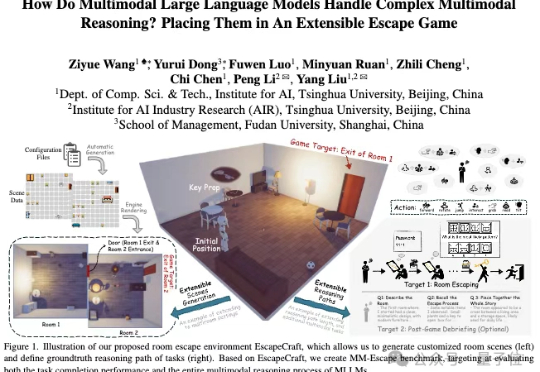

近年来,多模态大模型(MLLMs)发展迅猛,从看图说话到视频理解,似乎无所不能。

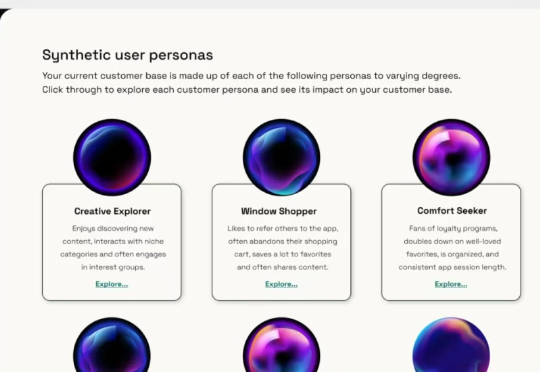

当产品团队还在为等待 4-6 周的 A/B 测试结果而焦虑时,一家名为 Blok 的初创公司正在用 AI 虚拟用户彻底颠覆这一传统模式。他们让产品测试从"weeks"压缩到"hours",从"reactive"转向"predictive",这不仅仅是效率的提升,更是产品开发哲学的根本性变革。

普林斯顿大学AI实验室与复旦大学历史学系联手推出了全球首个聚焦历史研究能力的AI评测基准——HistBench,并同步开发了深度嵌入历史研究场景的AI助手——HistAgent。这一成果不仅填补了人文学科AI测试的空白,更为复杂史料处理与多模态理解建立了系统工具框架。