全球首个科研LLM竞技场上线!23款顶尖模型火拼:o3夺冠,DeepSeek第四

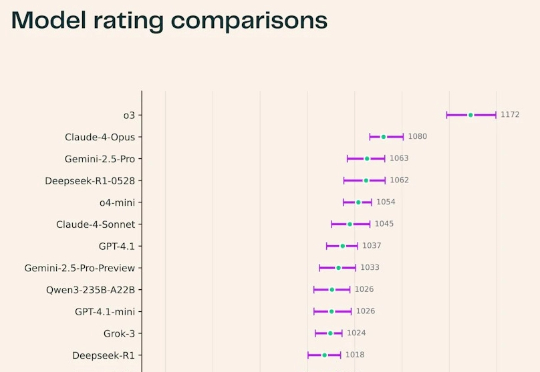

全球首个科研LLM竞技场上线!23款顶尖模型火拼:o3夺冠,DeepSeek第四最近,Ai2耶鲁NYU联合推出了一个科研版「Chatbot Arena」——SciArena。全球23款顶尖大模型火拼真实科研任务,OpenAI o3领跑全场,DeepSeek紧追Gemini挤入前四!不过从结果来看,要猜中科研人的偏好,自动评估系统远未及格。

最近,Ai2耶鲁NYU联合推出了一个科研版「Chatbot Arena」——SciArena。全球23款顶尖大模型火拼真实科研任务,OpenAI o3领跑全场,DeepSeek紧追Gemini挤入前四!不过从结果来看,要猜中科研人的偏好,自动评估系统远未及格。

当地时间 6 月 26 日,在上个月的 Google I/O 上首次亮相预览后,谷歌如今正式发布了 Gemma 3n 完整版,可以直接在本地硬件上运行。

在开源模型领域,DeepSeek 又带来了惊喜。

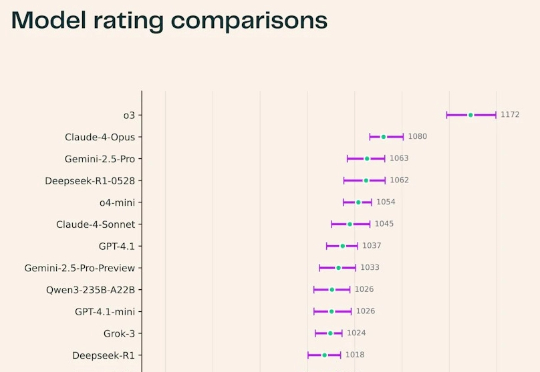

LM Arena 是一个众包基准测试项目,各大 AI 实验室依赖其测试和推广自家 AI 模型。据彭博社报道,该项目已在种子轮融资中筹集 1 亿美元 ,估值达 6 亿美元。

你的默认编程模型是什么?或许可以换一换了。刚刚,Google DeepMind 发布了 Gemini 2.5 Pro 的最新更新版本:Gemini 2.5 Pro (I/O edition)。其最大的进步是编程能力大幅提升,不仅在 LMArena 编程排行榜上名列第一,同时也在 WebDev Arena 排行榜上更是以显著优势超过了昔日霸

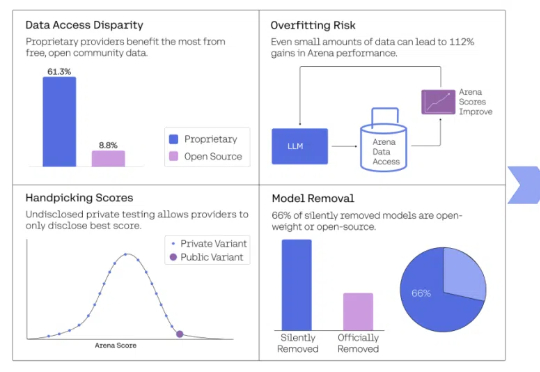

你信任的AI排行榜,可能只是一场精心策划的骗局!震惊业界的Cohere Labs最新研究彻底撕破了Chatbot Arena这一所谓"黄金标准"的华丽面纱,揭露了科技巨头们如何肆无忌惮地操控评估系统、掠夺社区资源、扼杀开源创新。

大模型竞技场的可信度,再次被锤。

刚刚,LMArena陷入了巨大争议,斯坦福MIT和Ai2等的研究者联手发论文痛斥,这个排行榜已经被Meta等公司利用暗中操作排名!Karpathy也下场帮忙锤了一把。而LMArena官方立马回应:论文存在多处错误,指控不实。

作为学术研究项目,原加州大学伯克利分校的Chatbot Arena,其网站已成为访客试用新人工智能模型的热门平台,现正转型为独立公司。

Llama 4真要被锤爆了,这次是大模型竞技场(Chatbot Arena)官方亲自下场开怼: