Softmax注意力与线性注意力的优雅融合,Agent Attention推动注意力新升级

Softmax注意力与线性注意力的优雅融合,Agent Attention推动注意力新升级来自清华大学的研究者提出了一种新的注意力范式——代理注意力 (Agent Attention)。

来自主题: AI资讯

8648 点击 2023-12-25 16:36

来自清华大学的研究者提出了一种新的注意力范式——代理注意力 (Agent Attention)。

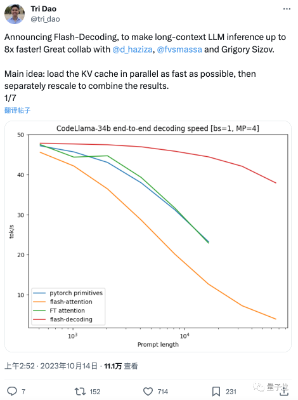

这两天,FlashAttention团队推出了新作: 一种给Transformer架构大模型推理加速的新方法,最高可提速8倍。 该方法尤其造福于长上下文LLM,在64k长度的CodeLlama-34B上通过了验证