没错,马斯克的二次元「女友」被雷蛇装到外设里了

没错,马斯克的二次元「女友」被雷蛇装到外设里了AI 助手以类似手办的形式出现在桌面上,这样的场景你想象过吗?近日,CES 2026 展上,在琳琅满目的 AI 为核心的技术与产品中,一个「装在罐子里」的二次元少女形象的「桌面 AI 伙伴」,成为其中最具话题性的展示之一。这是由游戏外设公司 Razer (雷蛇)推出的 Project Ava,官方定位是「与您形影不离的 AI 桌面伴侣」,

AI 助手以类似手办的形式出现在桌面上,这样的场景你想象过吗?近日,CES 2026 展上,在琳琅满目的 AI 为核心的技术与产品中,一个「装在罐子里」的二次元少女形象的「桌面 AI 伙伴」,成为其中最具话题性的展示之一。这是由游戏外设公司 Razer (雷蛇)推出的 Project Ava,官方定位是「与您形影不离的 AI 桌面伴侣」,

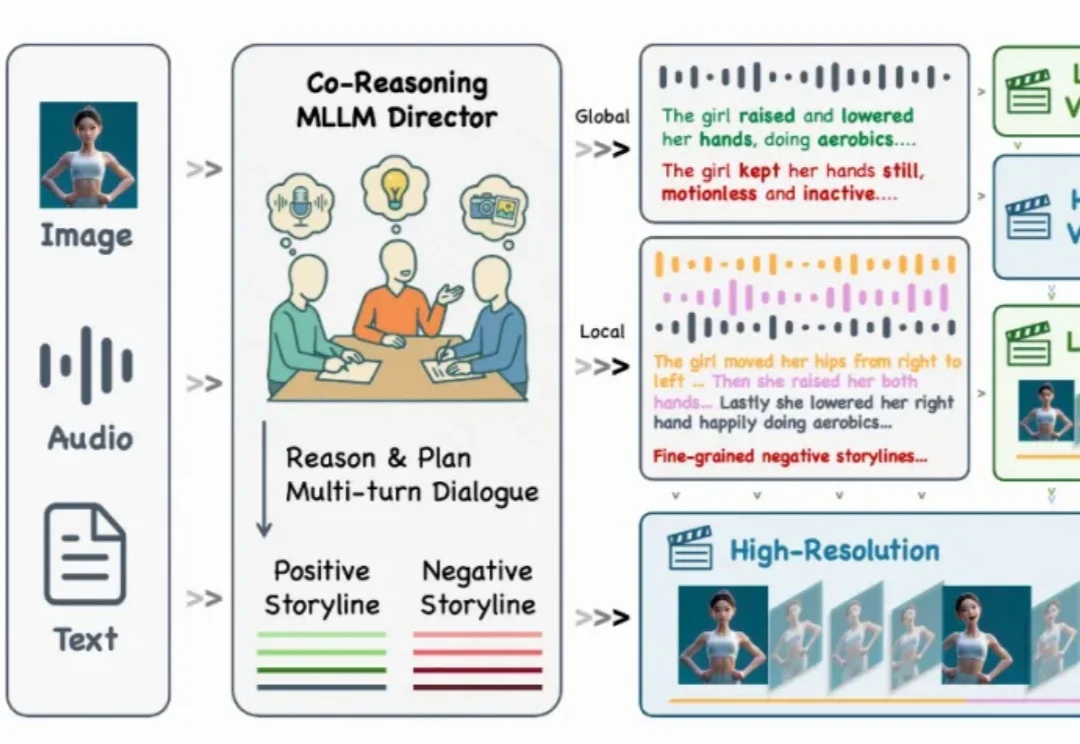

还记得几个月前那个能随着音乐节拍自然舞动的 KlingAvatar 数字人吗?现在,它迎来了史诗级进化!

霍尔特计划收购老东家新山资本旗下最成功的五家医疗科技公司,并将其合并到其新创立的AI医疗平台——Thoreau。这五家公司分别是:健康数据交换巨头Datavant、AI理赔优化平台Machinify、精准医疗营销商Swoop、医疗流程自动化公司Smarter Technologies 以及电子医疗记录平台Office Ally。

在计算机图形学、三维视觉、虚拟人、XR 领域,SIGGRAPH 是毫无争议的 “天花板级会议”。 SIGGRAPH Asia 作为 SIGGRAPH 系列两大主会之一,每年只接收全球最顶尖研究团队的成果稿件,代表着学术与工业界的最高研究水平与最前沿技术趋势。

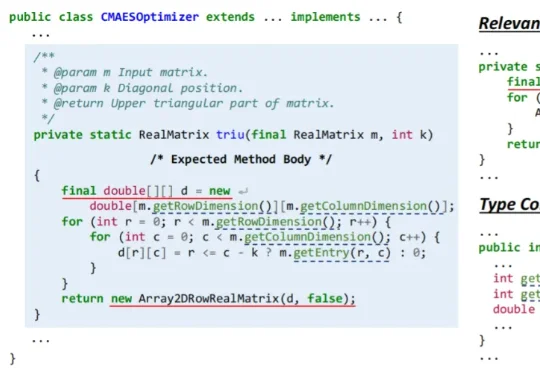

近日,浙江大学副教授胡星和团队开发出一款名为 CatCoder 的 AI 框架,它能够读懂一个完整的软件项目,生成准确、可用的代码。在 Java 任务上,它在代码编译通过率和测试通过率上,比业内表现突出的代表之一 RepoCoder 最高提升了 14.44% 和 17.35%。

主攻 AI 视频与多媒体生成技术的独角兽 Runway 也来了一波大的:一口气来了 5 个「激动人心的宣布」。这一波更新之猛,甚至让人觉得他们是不是把过去半年的大招一次性全放了出来。Runway 这一波发布,不仅刷新了视频生成的各项指标,更重要的是,他们正式对外展示了其在通用世界模型(General World Models/GWM)上的野心。

2025 年 12 月,由 阿里巴巴 联合 中国科学技术大学、浙江大学等机构共同研发的实时虚拟人项目 LiveAvatar 正式对外开源。该项目聚焦长期困扰虚拟人行业的两大技术瓶颈——“实时响应能力”与“长时稳定生成能力”,首次在同一系统中实现了二者的工程级统一。

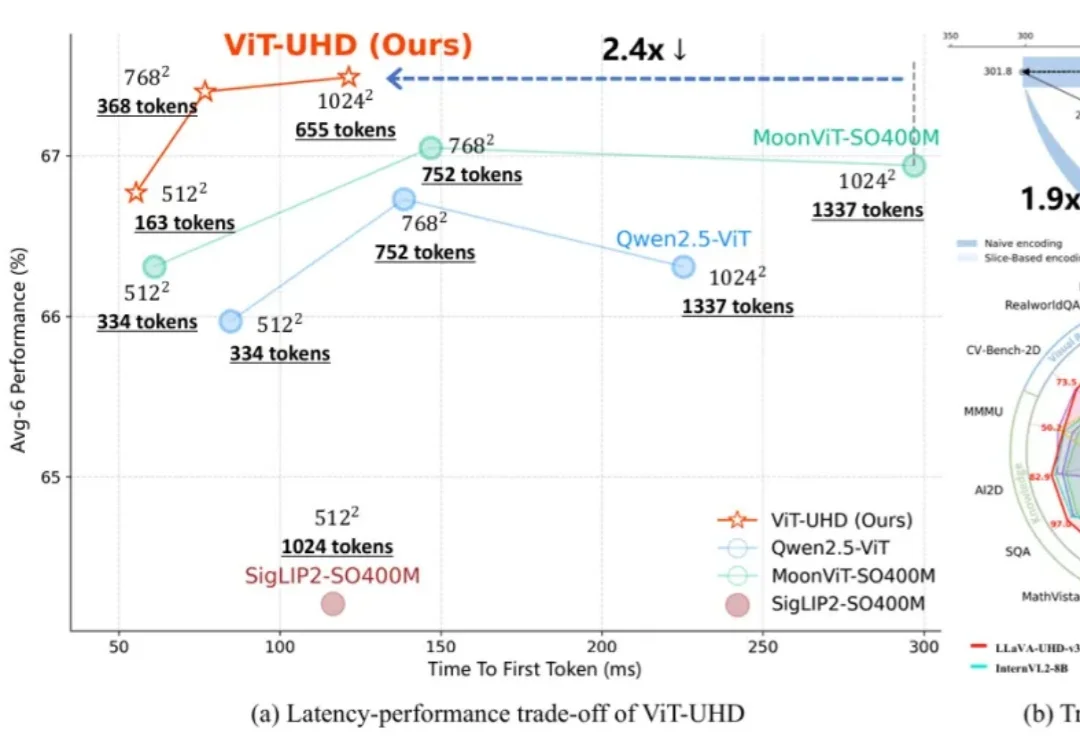

随着多模态大模型(MLLMs)在各类视觉语言任务中展现出强大的理解与交互能力,如何高效地处理原生高分辨率图像以捕捉精细的视觉信息,已成为提升模型性能的关键方向。

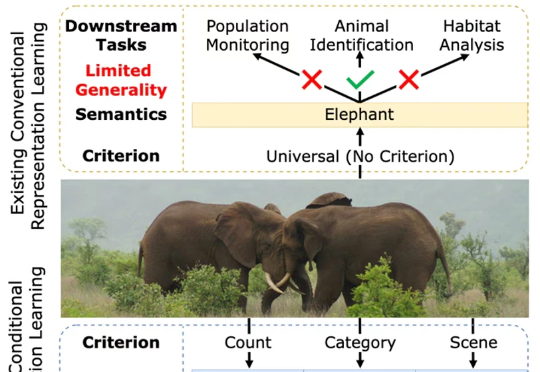

一张图片包含的信息是多维的。例如下面的图 1,我们至少可以得到三个层面的信息:主体是大象,数量有两头,环境是热带稀树草原(savanna)。然而,如果由传统的表征学习方法来处理这张图片,比方说就将其送入一个在 ImageNet 上训练好的 ResNet 或者 Vision Transformer,往往得到的表征只会体现其主体信息,也就是会简单地将该图片归为大象这一类别。这显然是不合理的。

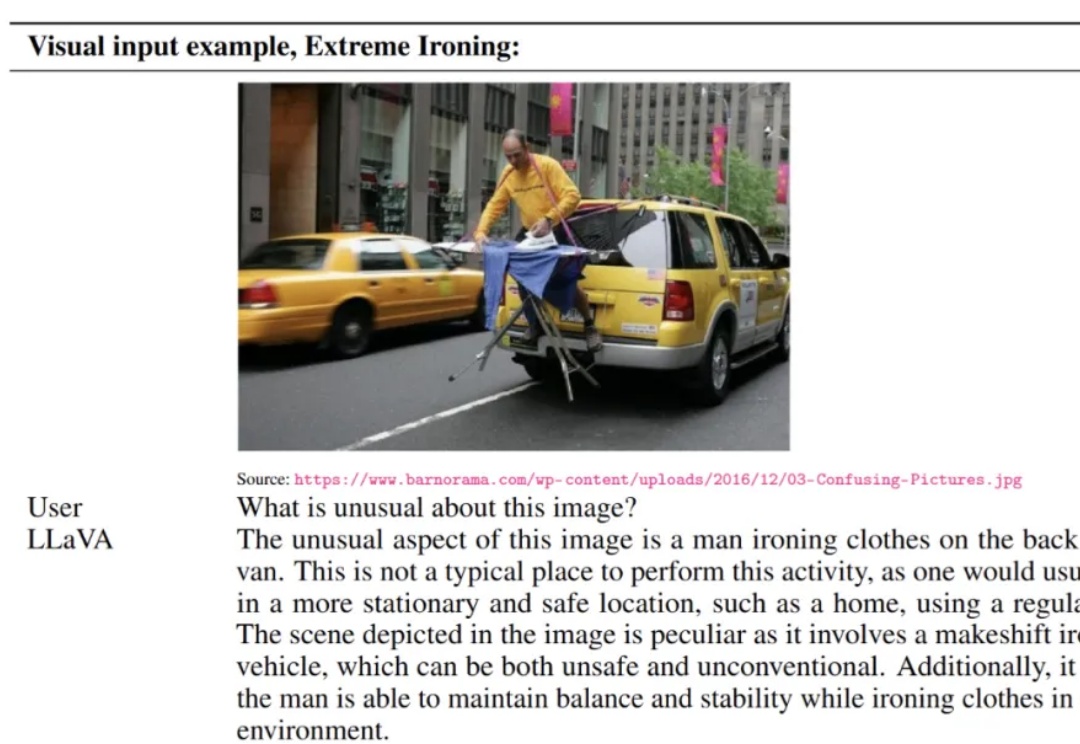

LLaVA 于 2023 年提出,通过低成本对齐高效连接开源视觉编码器与大语言模型,使「看图 — 理解 — 对话」的多模态能力在开放生态中得以普及,明显缩小了与顶级闭源模型的差距,标志着开源多模态范式的重要里程碑。