英伟达年终核弹!全新B300为o1推理大模型打造,RTX5090也曝光了

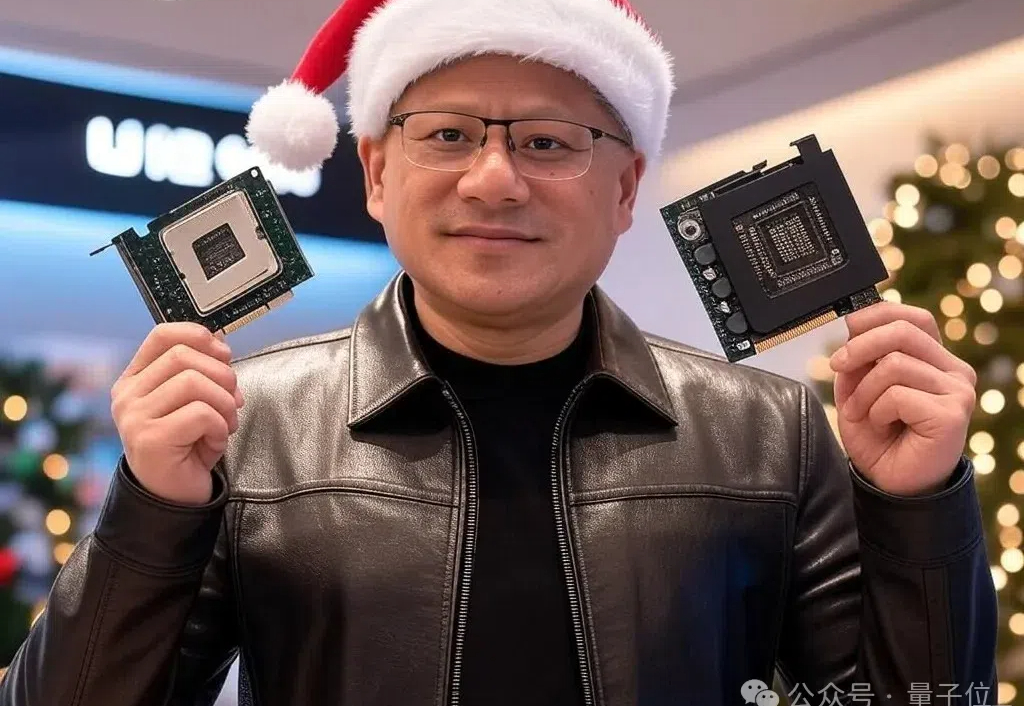

英伟达年终核弹!全新B300为o1推理大模型打造,RTX5090也曝光了GPU新核弹B300,以及附带CPU的超级芯片GB300。 高算力,在产品层面上相比B200在FLOPS上提高50% 大显存,从192GB提升到288GB,也是提高了50%。

GPU新核弹B300,以及附带CPU的超级芯片GB300。 高算力,在产品层面上相比B200在FLOPS上提高50% 大显存,从192GB提升到288GB,也是提高了50%。

2024年英伟达GPU全球最大买家,竟是微软?购买总量将近50万块,超所有竞争对手近两倍。xAI已开心晒出首批发货的GB200 NVL72,喜滋滋的像是提前过年了。囤的GPU越多,模型就会越好吗?来不及解释了,赶紧上车,车门焊死!

抢疯了!马斯克找老黄加价插队拿显卡——为了加速xAI产品研发。

NVIDIA DGX GB200 超级计算集群数据中心部署指南解读,NVIDIA AI 工厂部署与 Broadcom AI 计算 ASIC 光学连接技术

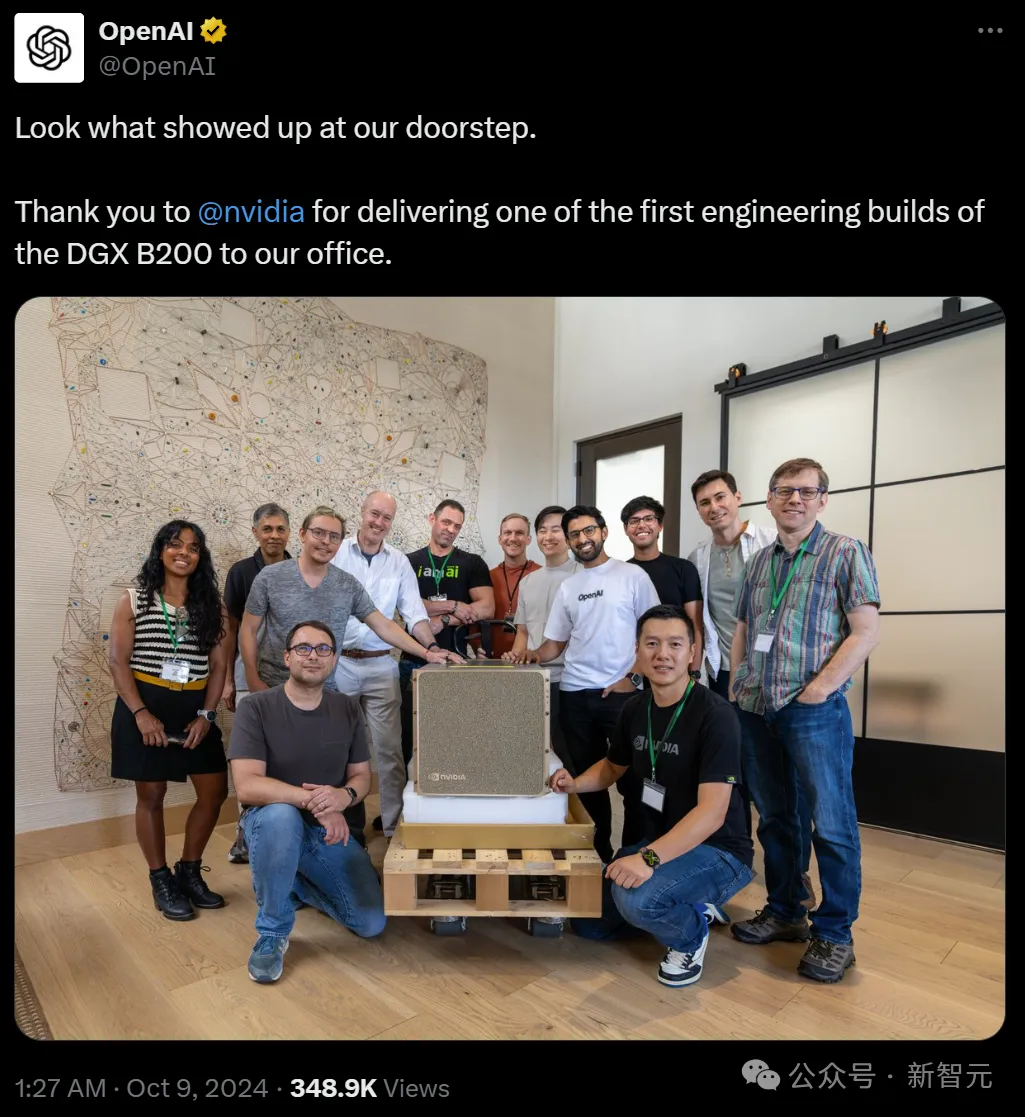

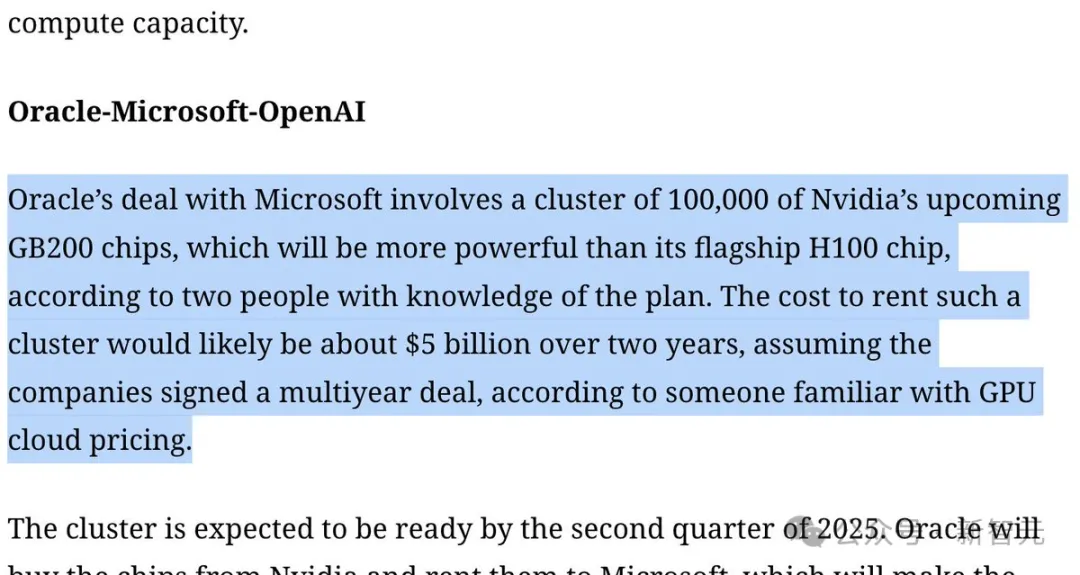

继首台DGX H200之后,OpenAI再次收到了英伟达的首批工程版DGX B200。外媒爆料称,由于微软提供算力不足,OpenAI正与甲骨文开始谈判了。

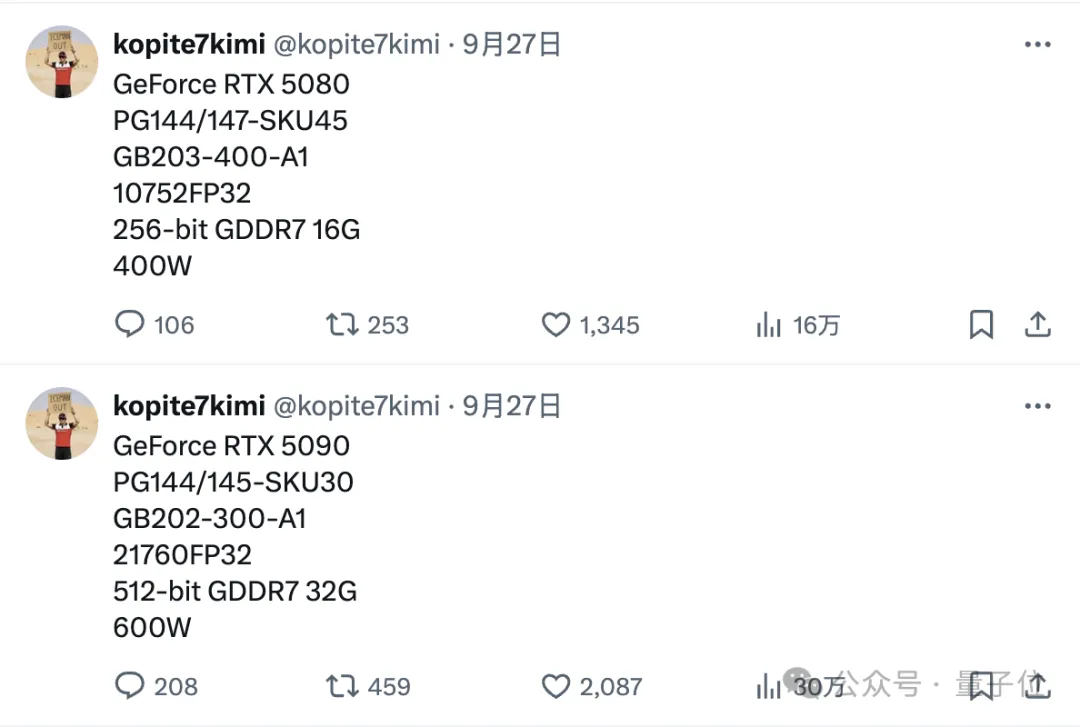

32GB GDDR7内存,CUDA核心数21760个——

英伟达最强芯片B200被迫推迟三个月,传闻闹的沸沸扬扬。

马斯克官宣xAI建造的世界最大超算集群,由10万块H100搭建,预计本月末开始投入训练。另一边,OpenAI再次加码,将打造由10万块GB200组成的超算,完全碾压xAI。

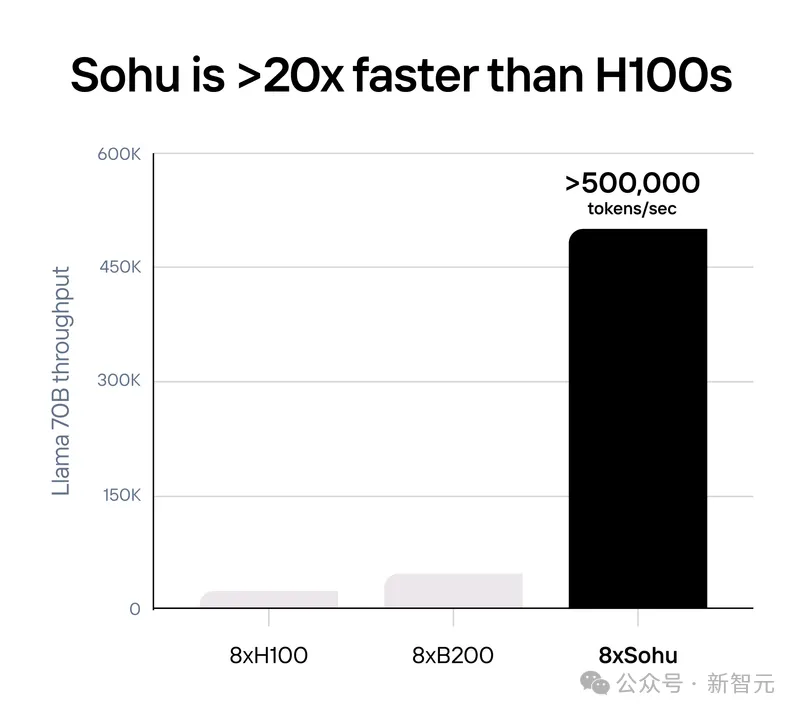

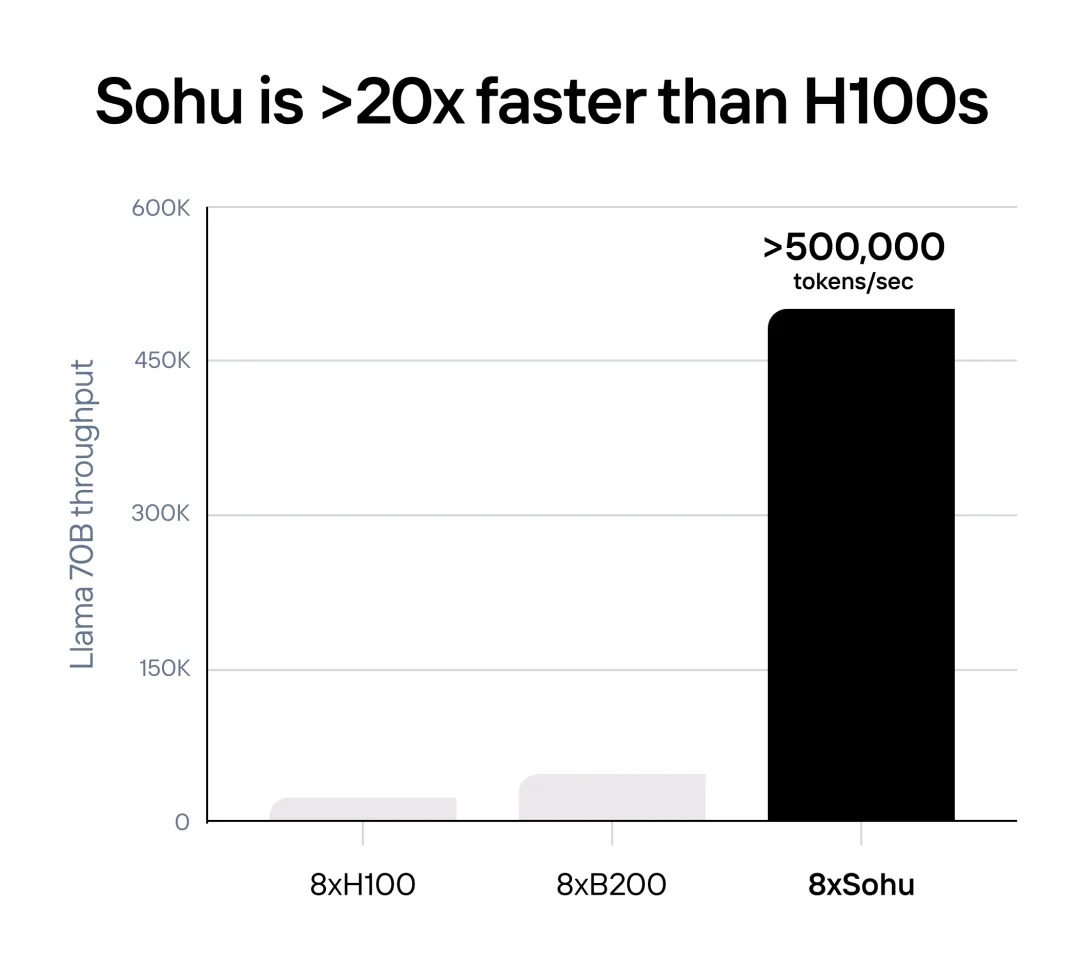

史上最快Transformer芯片诞生了!用Sohu跑Llama 70B,推理性能已超B200十倍,超H100二十倍!刚刚,几位00后小哥从哈佛辍学后成立的公司Etached,宣布再融资1.2亿美元。

生成式 AI 推理性价比是 GPU 的 140 倍。