马斯克买了新厂房上GPU,2GW供电规模,“巨硬”更更硬了

马斯克买了新厂房上GPU,2GW供电规模,“巨硬”更更硬了马斯克“巨硬计划”新消息,第三栋专属厂房已经买下来了,代号MACROHARDRR。果然更硬核,老马透露,其将具备2GW供电规模。若参照此前曝光的(200MW支持11万台GB200)的功耗密度与架构效率推算,可支持约110万台英伟达GB200 NVL72 GPU。

马斯克“巨硬计划”新消息,第三栋专属厂房已经买下来了,代号MACROHARDRR。果然更硬核,老马透露,其将具备2GW供电规模。若参照此前曝光的(200MW支持11万台GB200)的功耗密度与架构效率推算,可支持约110万台英伟达GB200 NVL72 GPU。

谷歌不再甘当「云房东」,启动激进的TPU@Premises计划,直接要把算力军火卖进Meta等巨头的自家后院,剑指英伟达10%的营收。旗舰TPU v7在算力与显存上彻底追平英伟达 B200,谷歌用「像素级」的参数对标证明:在尖端硬件上,黄仁勋不再寂寞。通过拥抱PyTorch拆解CUDA壁垒,谷歌正在用「私有化部署+同级性能」的组合拳,凿开万亿芯片帝国的坚固城墙。

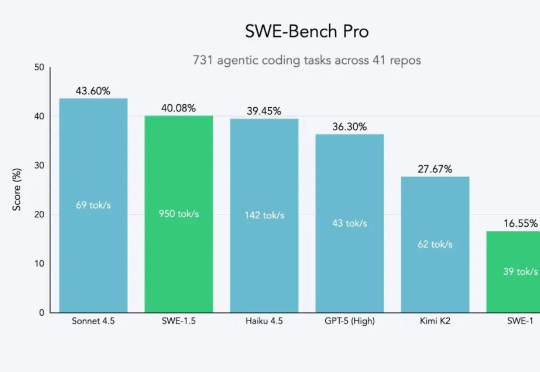

近日,开发出 Devin 智能体的知名人工智能公司 Cognition 推出其全新高速 AI 编码模型 SWE-1.5。据介绍,该模型专为在软件工程任务中实现高性能与高速度而设计,现已在 Windsurf 代码编辑器中开放使用。今年 7 月,Cognition 高调收购开发工具 Windsurf。

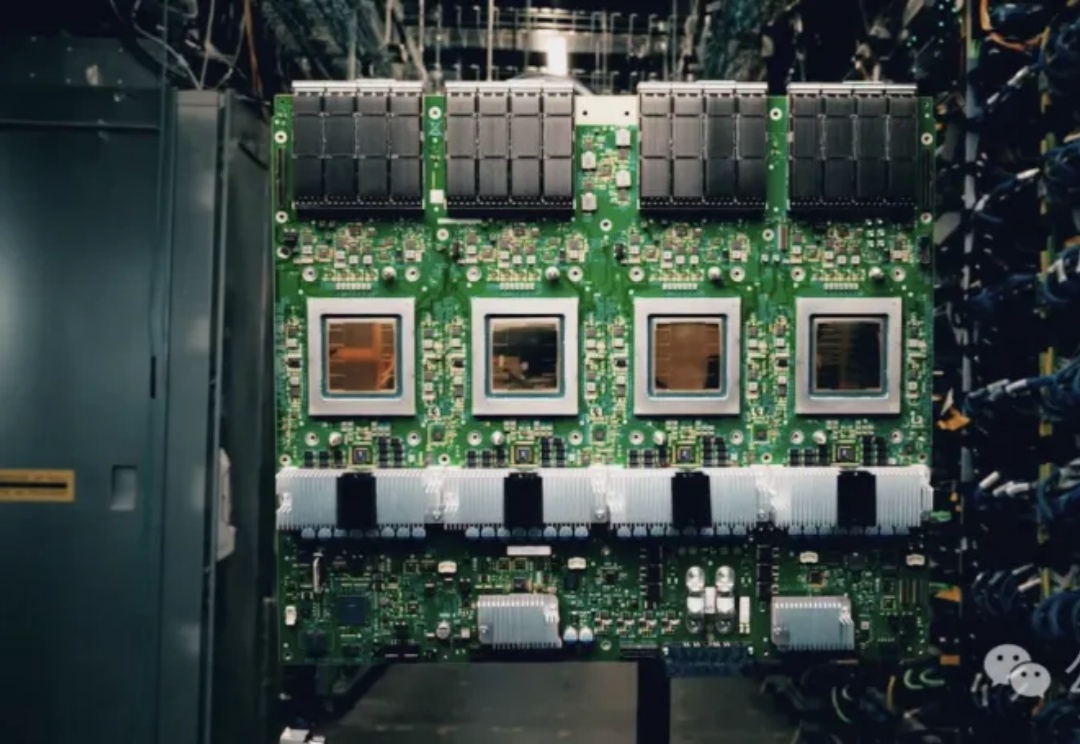

马斯克“巨硬计划”(MACROHARD)新动作曝光: 6个月从0建起算力集群,已完成200MW供电规模,足以支持11万台英伟达GB200 GPU NVL72。仅用6个时间,完成了OpenAI和甲骨文等合作花费15个月完成的工作,再次创造纪录。

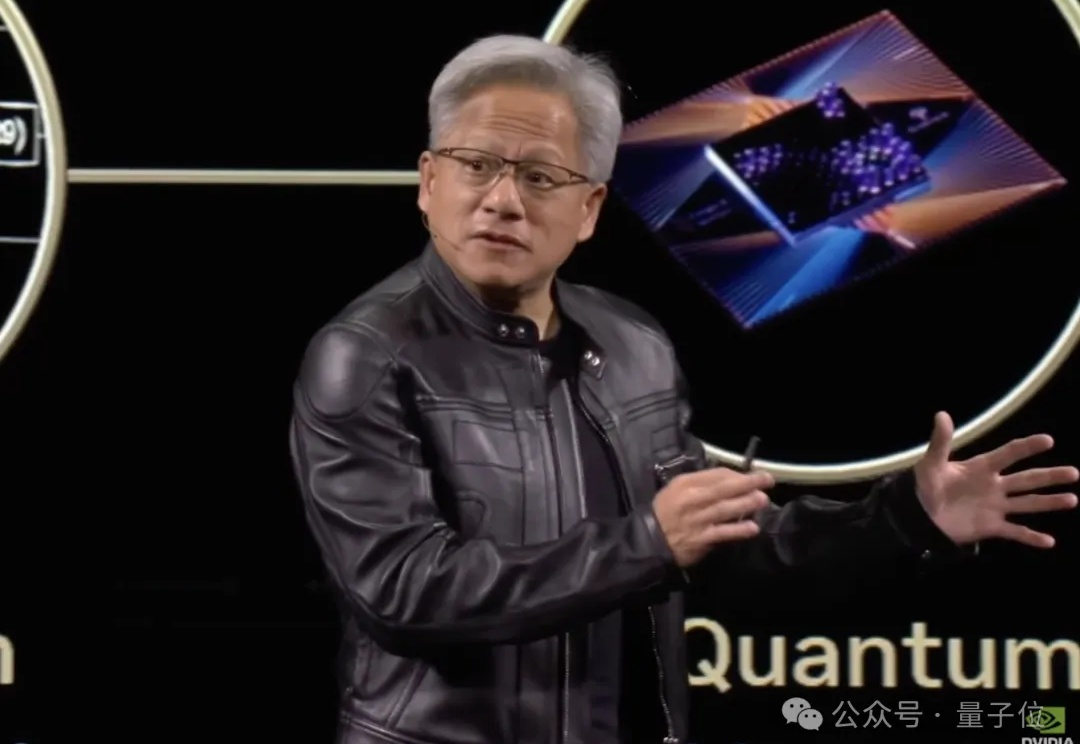

“量子计算正在到达一个拐点。”

斯坦福Hazy实验室推出新一代低延迟推理引擎「Megakernel」,将Llama-1B模型前向传播完整融合进单一GPU内核,实现推理时间低于1毫秒。在B200上每次推理仅需680微秒,比vLLM快3.5倍。

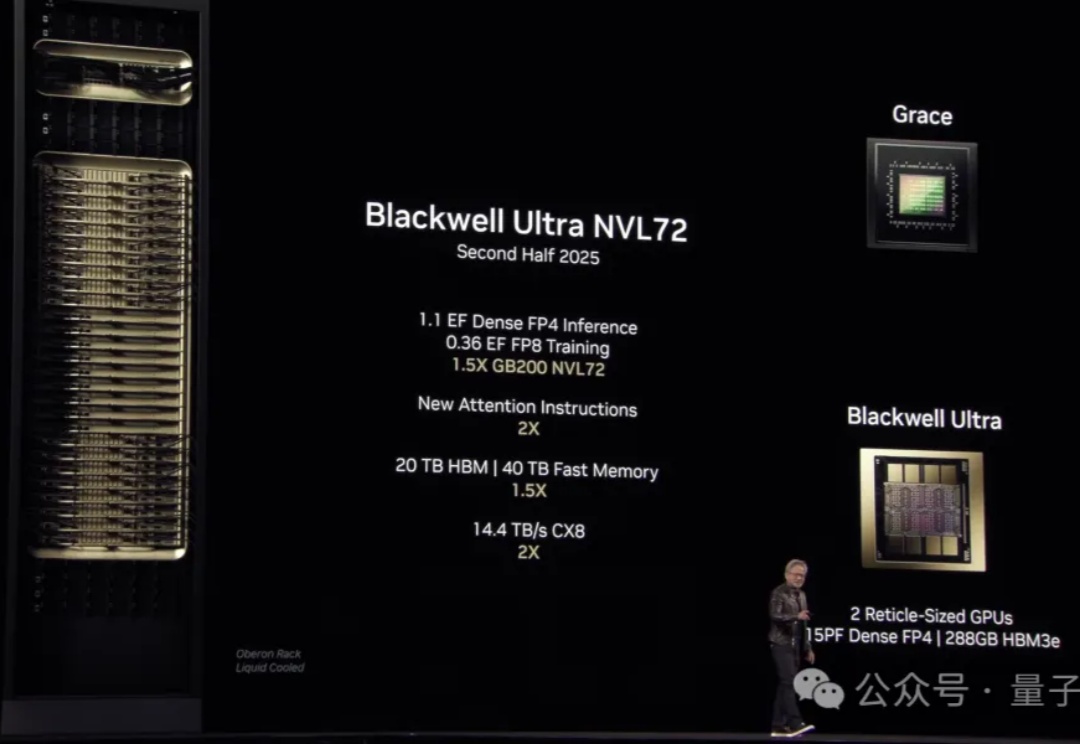

人类进化12000年,只为等AI觉醒?黄仁勋宣布「AI工厂时代」正式到来!从农业到工业再到AI革命,英伟达如何用算力推动历史巨轮?未来,每家公司都将有一个专属的超级智能工厂。并全览目前最先进的GB200 NVL72的详细参数。

谷歌首款AI推理特化版TPU芯片来了,专为深度思考模型打造。

谷歌重磅发布第七代TPU Ironwood,专为推理设计,性能较从初代飙升3600倍,可与英伟达B200一较高下。不仅如此,谷歌还带来了Veo 2等多款模型全新升级,就连「谷歌版」MCP协议也公布了。

皮衣老黄,带着最强AI芯片GB300闪亮登场“AI超级碗”GTC,燃爆全场!