多模态后训练反常识:长思维链SFT和RL的协同困境

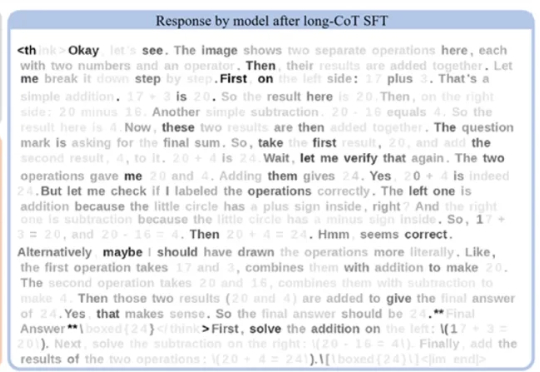

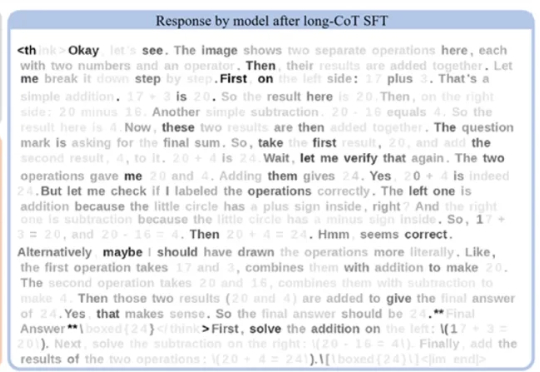

多模态后训练反常识:长思维链SFT和RL的协同困境在语言模型领域,长思维链监督微调(Long-CoT SFT)与强化学习(RL)的组合堪称黄金搭档 —— 先让模型学习思考模式,再用奖励机制优化输出,性能通常能实现叠加提升。

在语言模型领域,长思维链监督微调(Long-CoT SFT)与强化学习(RL)的组合堪称黄金搭档 —— 先让模型学习思考模式,再用奖励机制优化输出,性能通常能实现叠加提升。

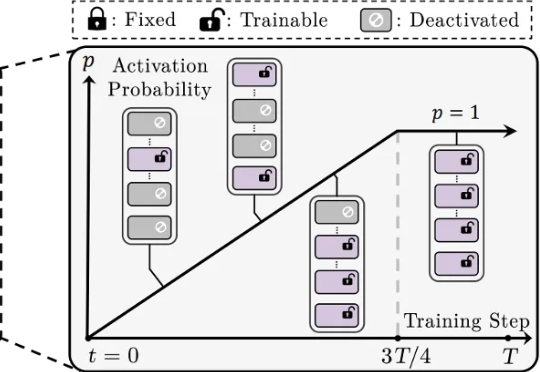

还在为 LoRA 训练不稳定、模型融合效果差、剪枝后性能大降而烦恼吗?来自香港城市大学、南方科技大学、浙江大学等机构的研究者们提出了一种简单的渐进式训练策略,CoTo,通过在训练早期随机失活一部分适配器,并逐渐提高其激活概率,有效缓解了层级不均衡问题,并显著增强了模型在多任务融合和剪枝等操作上的鲁棒性和有效性。该工作已被机器学习顶会 ICML 2025 接收。

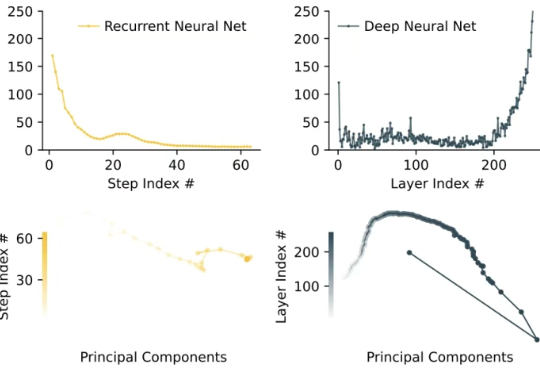

大语言模型(Large Language Model, LLM)在复杂推理任务中表现卓越。借助链式思维(Chain-of-Thought, CoT),LLM 能够将复杂问题分解为简单步骤,充分探索解题思路并得出正确答案。LLM 已在多个基准上展现出优异的推理能力,尤其是数学推理和代码生成。

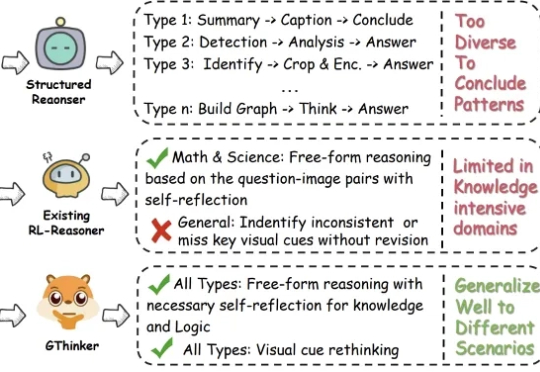

尽管多模态大模型在数学、科学等结构化任务中取得了长足进步,但在需要灵活解读视觉信息的通用场景下,其性能提升瓶颈依然显著。

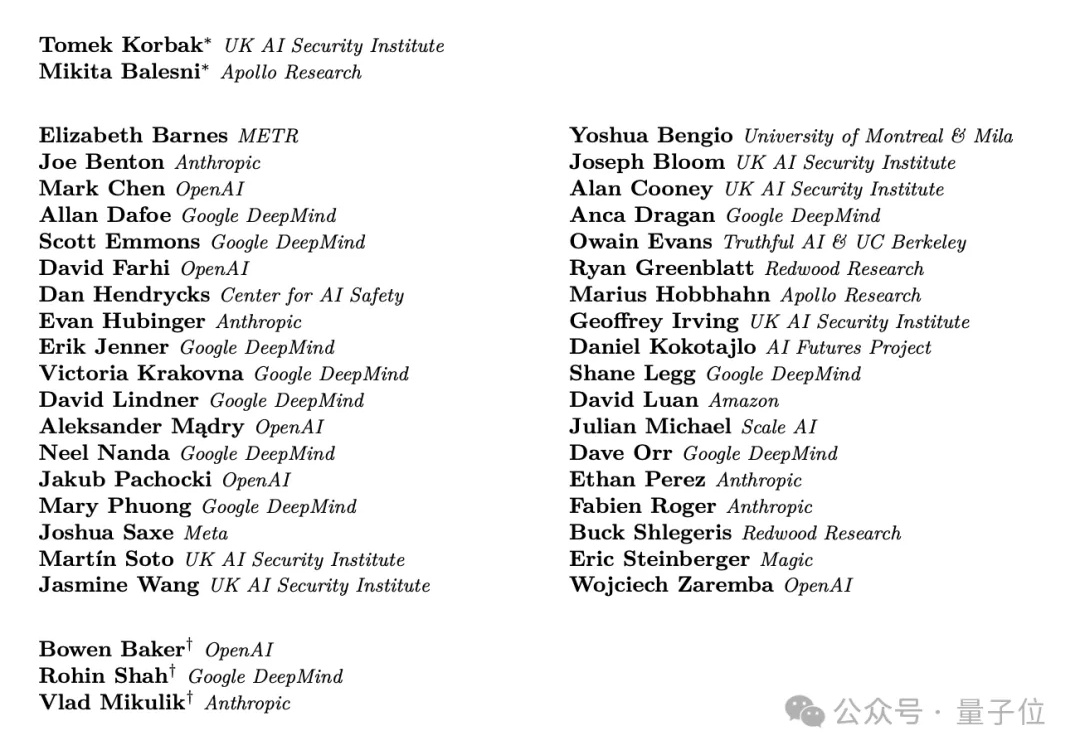

难得难得,几大AI巨头不竞争了不抢人了,改联合一起发研究了。

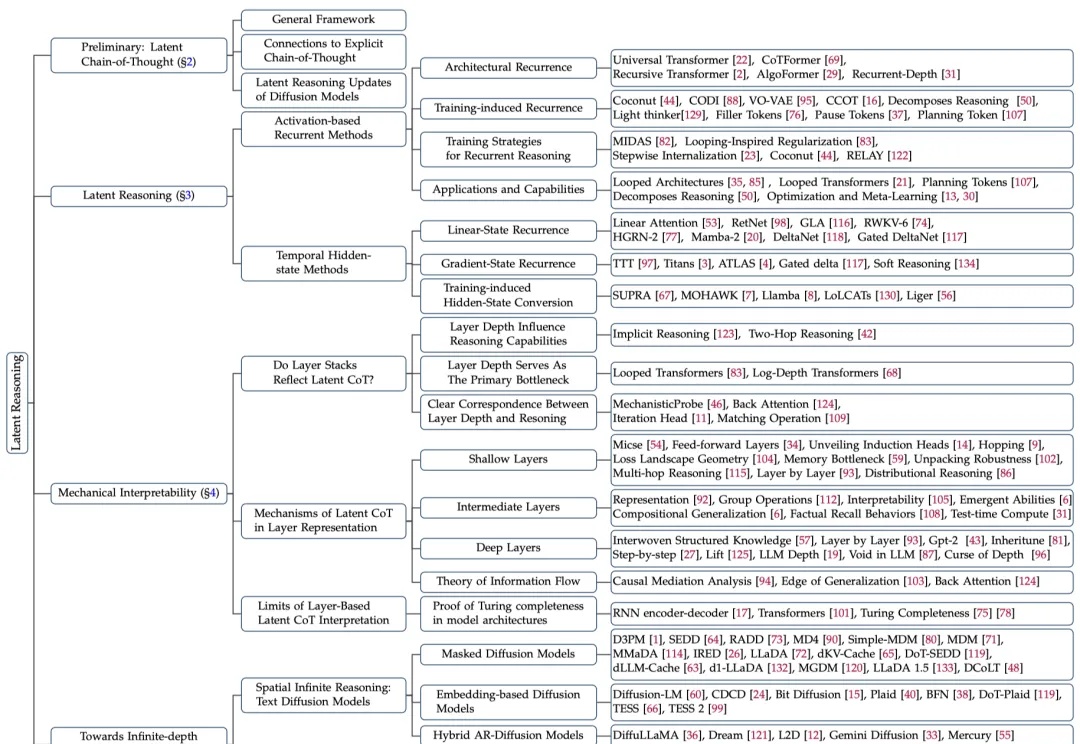

大模型在潜空间中推理,带宽能达到普通(显式)思维链(CoT)的2700多倍?

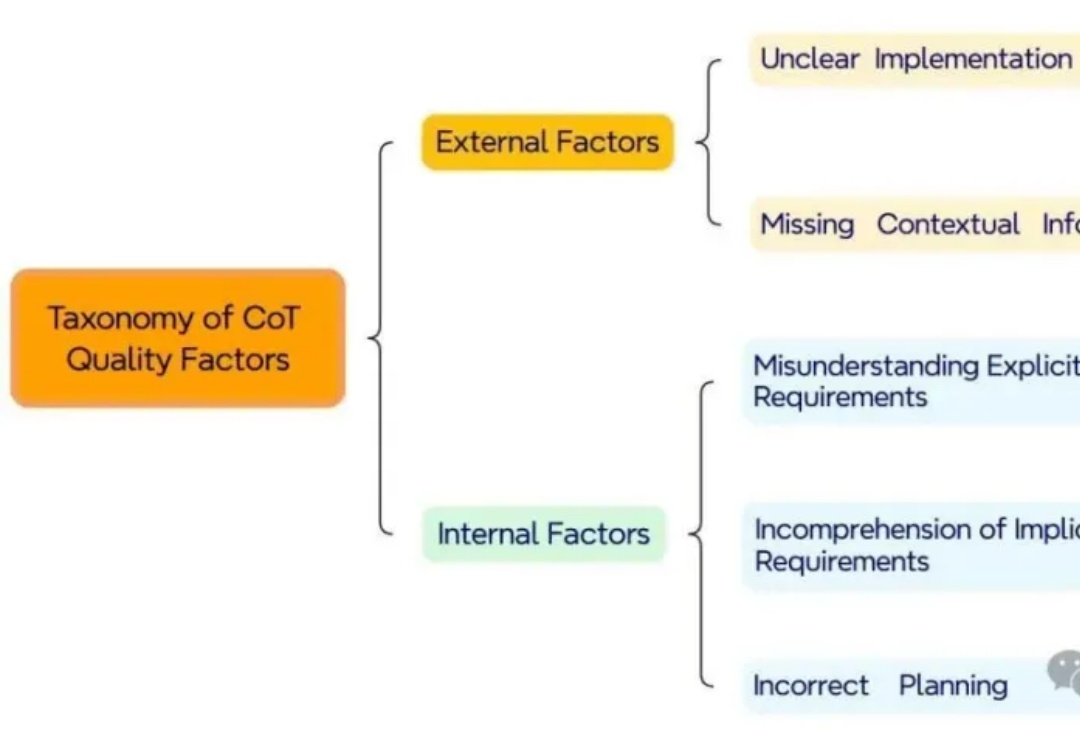

现在几乎所有主流的代码生成工具都在用CoT。但问题来了:这些"思考步骤"真的可靠吗?来自北京航空航天大学的研究者们发现,虽然CoT提升了性能,但关于这些中间推理步骤的质量,学术界竟然没有系统性的研究!

原来,CoT推理竟是假象!Bengio带队最新论文戳穿了CoT神话——我们所看到的推理步骤,并非是真实的。不仅如此,LLM在推理时会悄然纠正错误,却在CoT中只字未提。

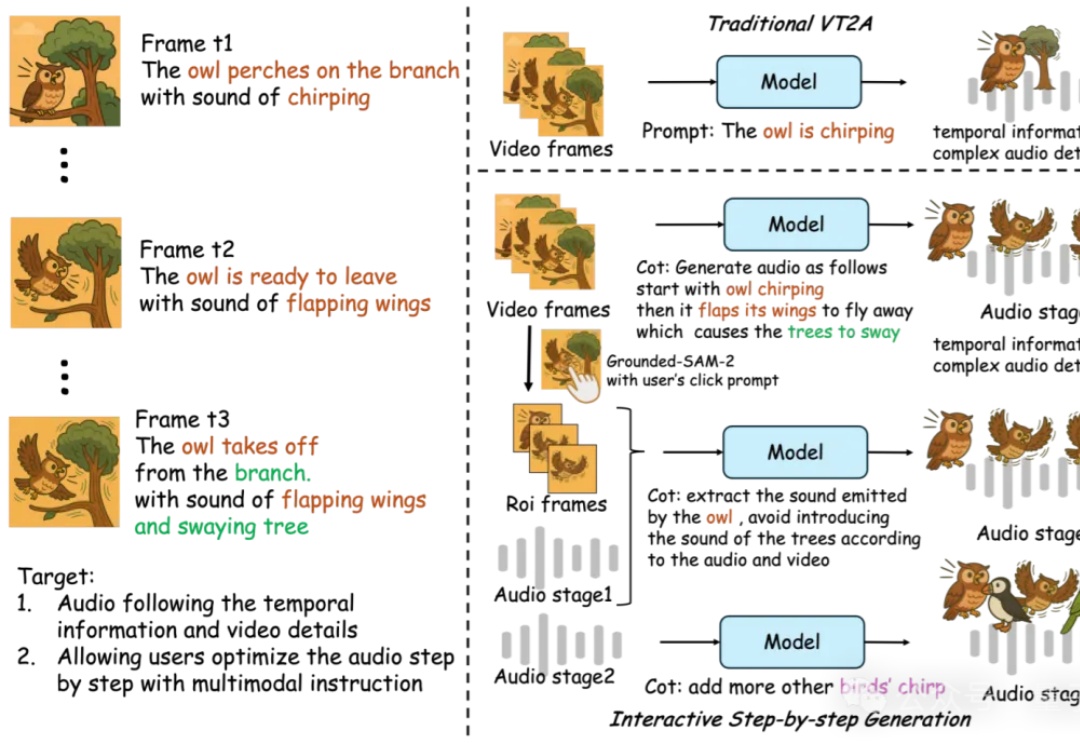

AI音效已经进化成这样了吗??

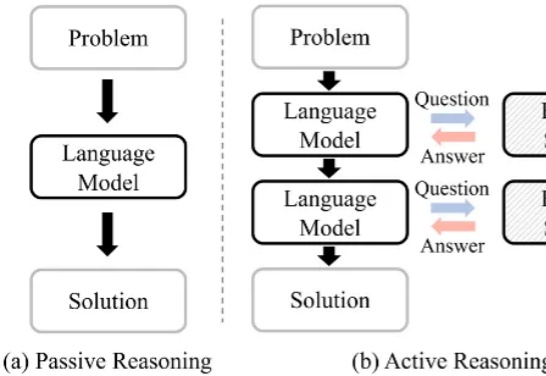

像人一样推理。 大模型的架构,到了需要变革的时候? 在对复杂任务的推理工作上,当前的大语言模型(LLM)主要采用思维链(CoT)技术,但这些技术存在任务分解复杂、数据需求大以及高延迟等问题。