烧掉700亿!他为谷歌赢得诺奖,却将ChatGPT拱手让人

烧掉700亿!他为谷歌赢得诺奖,却将ChatGPT拱手让人11年前,谷歌收购DeepMind,花巨资买来一个「诺贝尔奖 + 顶级科学家 + 世界级实验室」,没想到却被OpenAI抢先推出ChatGPT,几乎动摇谷歌核心搜索业务,这一切背后的核心人物正是谷歌的AI掌门人哈萨比斯。

11年前,谷歌收购DeepMind,花巨资买来一个「诺贝尔奖 + 顶级科学家 + 世界级实验室」,没想到却被OpenAI抢先推出ChatGPT,几乎动摇谷歌核心搜索业务,这一切背后的核心人物正是谷歌的AI掌门人哈萨比斯。

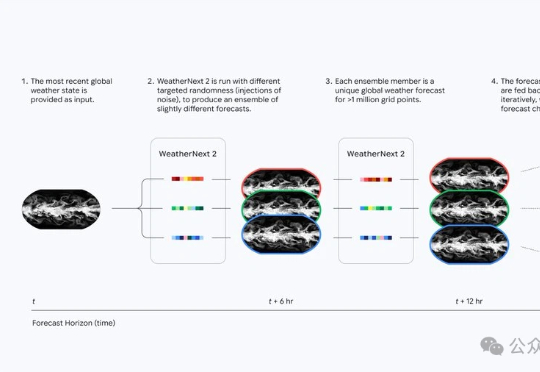

天气预报的时代真的变了。谷歌DeepMind最新发布的WeatherNext 2,让查天气这件事升级成了小时级、实时化。它的运行速度比上一代快8倍,分辨率提高到小时级,也就是说不再是传统预报里的“明天下午有雨”,而是可以细到“明天2–3点有小雨,3–4点雨势增强,5–6点逐渐停止”的节奏。

当美国巨头如Google、OpenAI 和 Anthropic 竞相开发支撑其 AI 产品的大型语言模型时,Sakana AI、Mistral AI、DeepSeek 和 AI21 Labs 等初创公司正凭借为特定地区、行业或独特功能设计的专业模型开辟自己的细分市场。

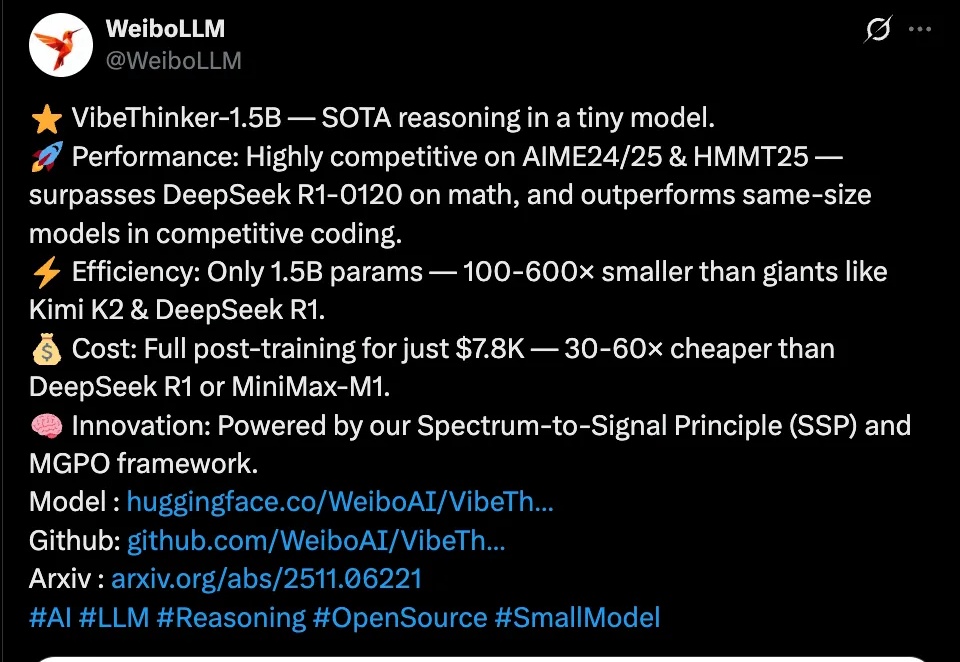

近日,微博正式发布首个自研开源大模型VibeThinker,这个仅拥有15亿参数的“轻量级选手”,在国际顶级数学竞赛基准测试上击败了参数量是其数百倍的、高达6710亿的DeepSeek R1模型。

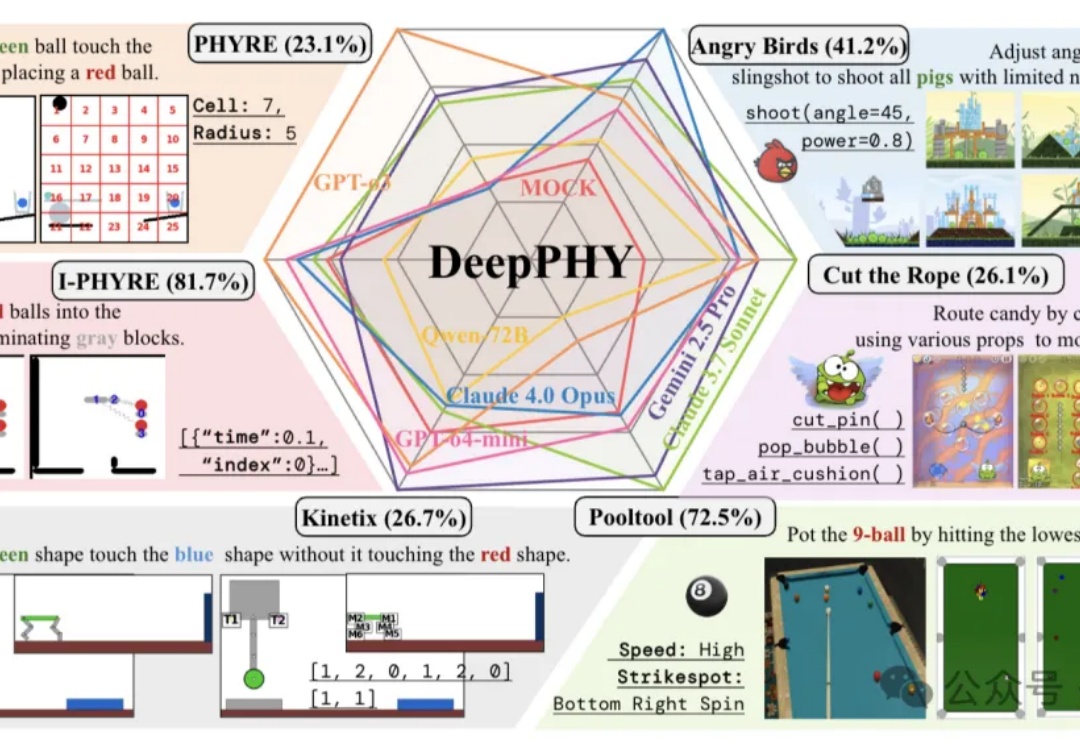

首个系统性评估多模态大模型(VLM)交互式物理推理能力的综合基准来了。

他被12所大学拒绝,签证差点作废。后又被DeepMind拒了三次,在亚马逊做着最不起眼的测试工作。十二年后,这个被世界反复拒绝的人,写出了改变AI格局的PyTorch。

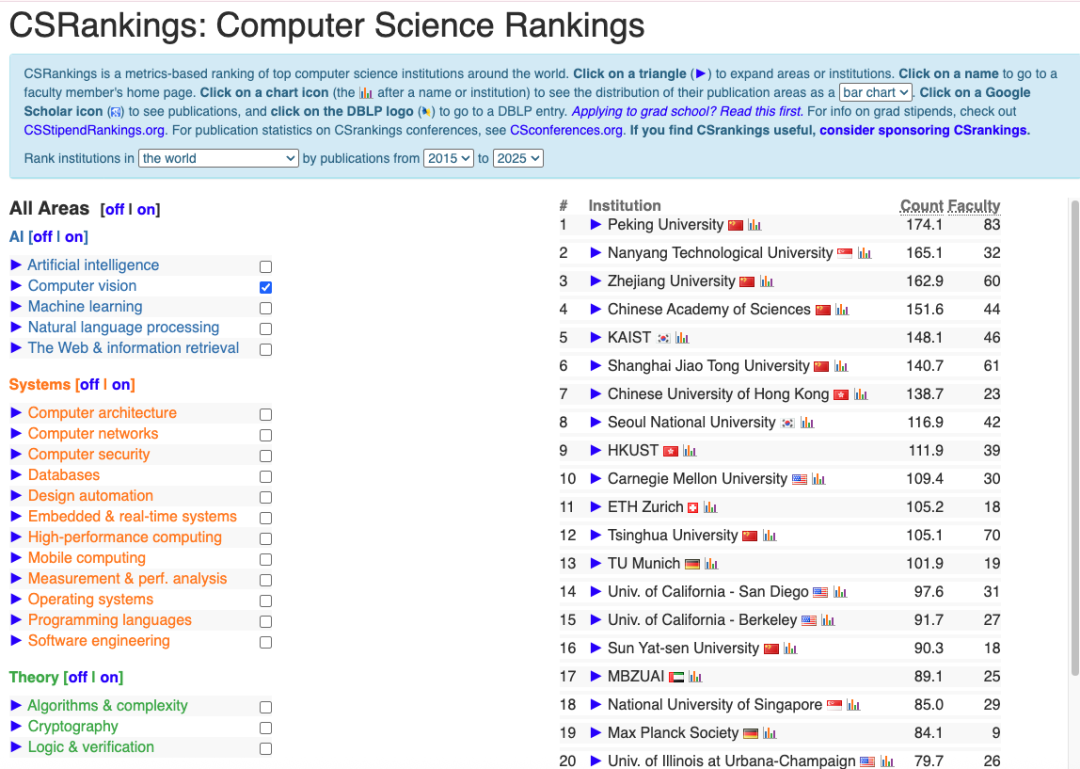

在计算机科学领域, CSRankings 曾被视为一次划时代的改进。它摒弃了早期诸如 USNews 那样依赖调查问卷的主观排名体系,转而以论文发表数量这一客观指标来评估各大学的科研实力。

浙江乌镇的世界互联网大会上,备受瞩目的「杭州六小龙」首次同台亮相。阿里云创始人王坚院士亲自主持,宇树创始人及CEO王兴兴、强脑科技创始人及CEO韩璧丞、群核科技创始人及董事长黄晓煌、游戏科学创始人及CEO、《黑神话:悟空》制作人冯骥、云深处科技创始人及CEO朱秋国……悉数落座。

如果一个AI,像人类一样看屏幕、敲键鼠、自己练级变强,这种游戏搭子,你愿意拥有吗?可能不久将来,类似王者荣耀、DOTA 2这样的游戏就可以选择和AI组队,而不是和人组队了!

ICLR 2026评审结果震撼出炉:投稿量暴增至近2万篇,却迎来分数大滑坡,平均分从5.12跌至4.2。审稿人吐槽论文质量低下,甚至疑似AI生成,这场学术盛宴为何变味?