腾讯重回 AI 牌桌

腾讯重回 AI 牌桌DeepSeek 掀翻了国内大模型领域原本搭好的台,各个大厂都在重新找位置,腾讯选择了通过一系列「闪电战」式的部署,展示战略决心。

DeepSeek 掀翻了国内大模型领域原本搭好的台,各个大厂都在重新找位置,腾讯选择了通过一系列「闪电战」式的部署,展示战略决心。

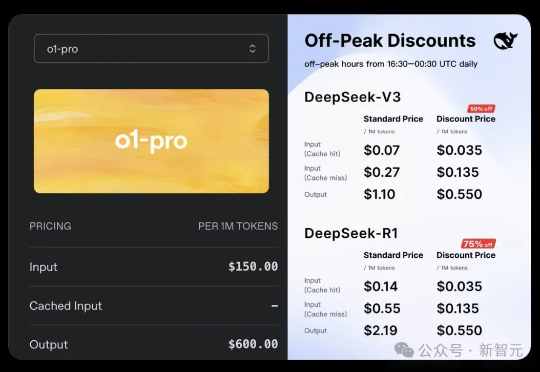

刚刚,OpenAI正式上线史上最贵API——o1-pro,输入/输出价格贵到离谱,最高可达DeepSeek-R1的千倍。OpenAI研究员戏称,大模型界的劳斯莱斯。

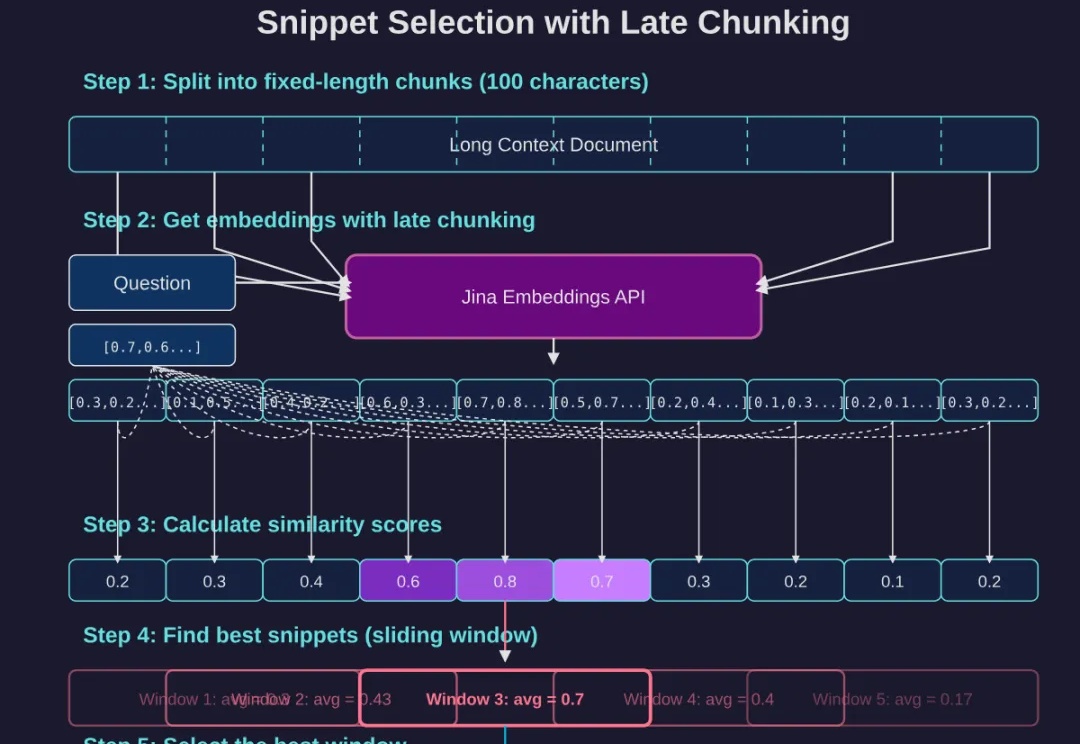

如果你已经读过我们上一篇经典长文《DeepSearch/DeepResearch 的设计与实现》,那么不妨再深挖一些能大幅提升回答质量的细节。这次,我们将重点关注两个细节:

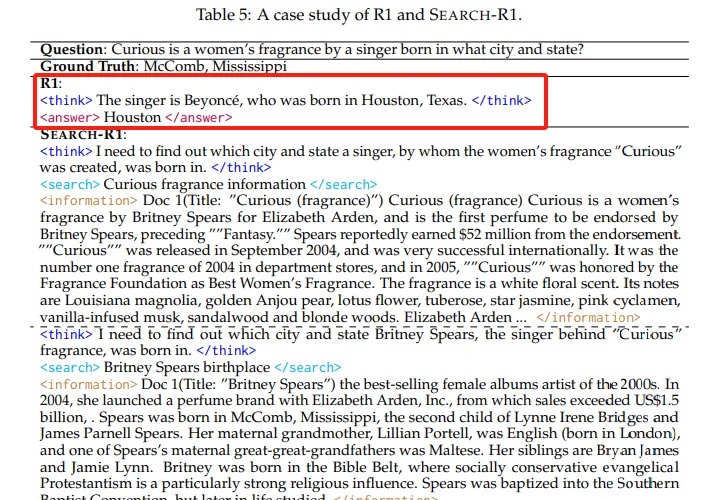

本文介绍了Search-R1技术,这是一项通过强化学习训练大语言模型进行推理并利用搜索引擎的创新方法。实验表明,Search-R1在Qwen2.5-7B模型上实现了26%的性能提升,使模型能够实时获取准确信息并进行多轮推理。本文详细分析了Search-R1的工作原理、训练方法和实验结果,为AI产品开发者提供了重要参考。

谷歌Gemini再次重磅更新,直指协作和创意!推出了全新的Canvas功能,「动动嘴」就能完成原型设计,实时可视化代码输出。语音总结一句话文档变播客!此外,带来Deep Research、协作方式等全新体验。

在全球AI技术加速重构产业格局的浪潮中,AI for Science(AI4S)赛道明星企业深度原理 Deep Principle 近日正式宣布完成亿元级Pre-A轮战略融资,本轮投资方包括联想创投、联想之星、锦秋基金、BV百度风投、启高资本,公司股东高瓴创投与线性资本持续追加投资,明德资本担任独家财务顾问。

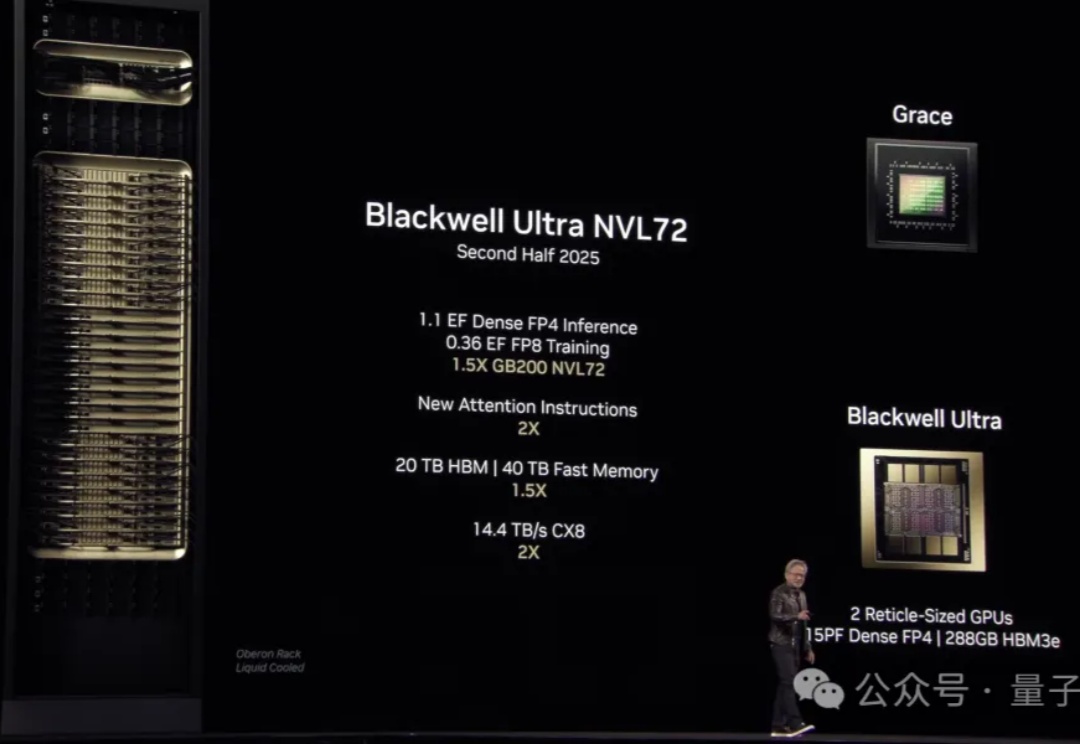

皮衣老黄,带着最强AI芯片GB300闪亮登场“AI超级碗”GTC,燃爆全场!

昨天写了一篇关于Gemini的文章,里面很大篇幅聊了关于DeepResearch,没想到把我非常喜欢的号小声比比都炸出来了。

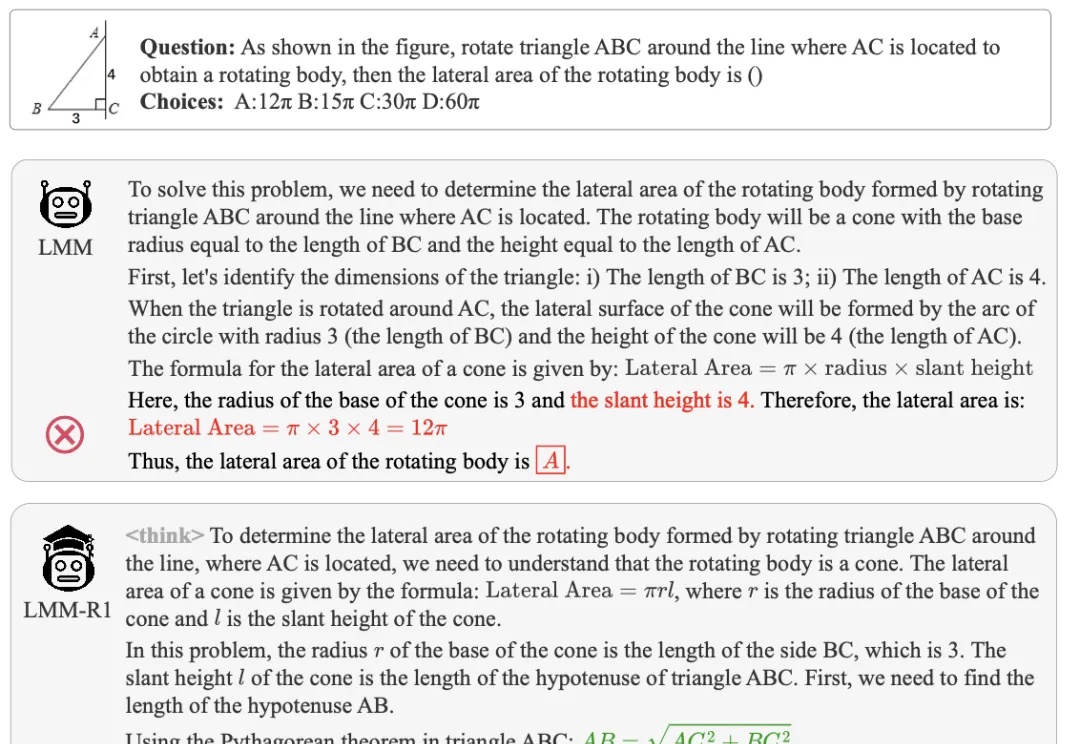

多模态大模型虽然在视觉理解方面表现出色,但在需要深度数学推理的任务上往往力不从心,尤其是对于参数量较小的模型来说更是如此。

什么?H20都变抢手货,涨价10万那种?!