通用问题求解器雏形已现!谷歌DeepMind重磅研究,自主发现40种全新算法

通用问题求解器雏形已现!谷歌DeepMind重磅研究,自主发现40种全新算法在现代科学中,几乎所有领域都依赖软件来进行计算实验。但开发这些专用的科学软件是一个非常缓慢、乏味且困难的过程,开发和测试一个新想法(一次“试错”)需要编写复杂的软件,这个过程可能耗费数周、数月甚至数年。

在现代科学中,几乎所有领域都依赖软件来进行计算实验。但开发这些专用的科学软件是一个非常缓慢、乏味且困难的过程,开发和测试一个新想法(一次“试错”)需要编写复杂的软件,这个过程可能耗费数周、数月甚至数年。

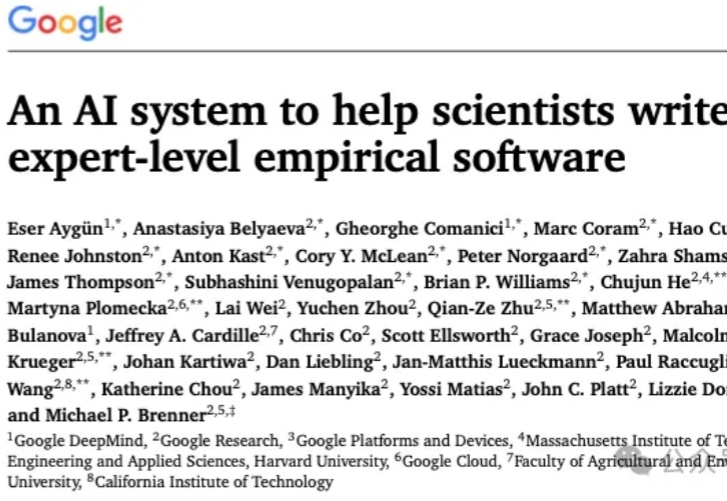

2022年,专家们笃定AI到2025年赢得IMO金牌概率不足10%。谁料短短3年,OpenAI和谷歌DeepMind的LLM双双摘金,不仅打破纪录,更宣告群体智能时代的到来!AI震撼人心,巨变势不可挡。

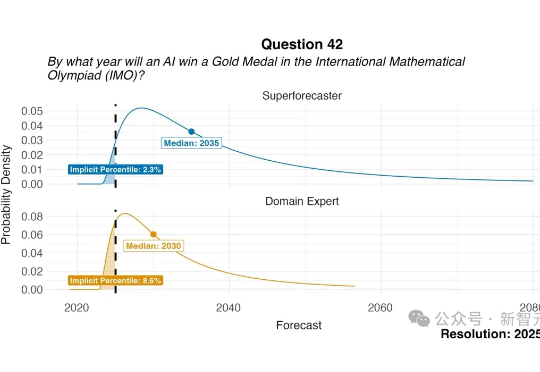

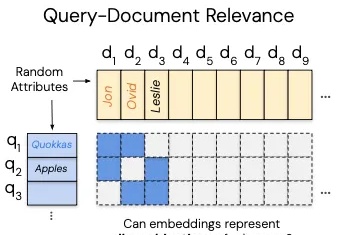

这几天,一篇关于向量嵌入(Vector Embeddings)局限性的论文在 AlphaXiv 上爆火,热度飙升到了近 9000。

最近,工业界“RAG已死”甚嚣尘上。过去几年,AI领域的主旋律是“规模定律”(Scaling Law),即更大的模型、更多的数据会带来更好的性能。即便偶然有瑕疵,也认为只是工程上的不足,并非数学上的不可能。

Builder.ai自称用AI简化软件开发,吸引微软、软银等巨额投资,估值一度超15亿美元。但实际靠人工冒充AI,财务造假被起诉。而这么做的,不止Builder.ai这一家! 两年前,快公司Fast Company评选出AI领域最具创新性的前10家公司,OpenAI、谷歌DeepMind、Builder.ai当选Top3,而英伟达位居第9。

香蕉也能变礼服?Google 真的做到了! 在最新一期谷歌开发者节目里,Google DeepMind 团队首次全面展示了 Gemini 2.5 Flash Image —— 一款拥有原生图像生成与编辑能力的最新模型。

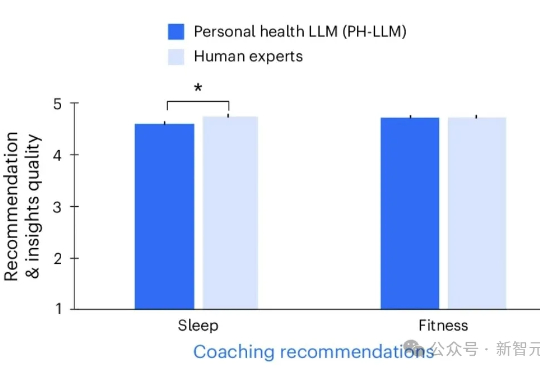

谷歌DeepMind最新Nature王炸,直接把Gemini版大模型PH-LLM调教成了「AI健康私教」,把可穿戴冷冰冰的数据,直接变成睡眠健身建议,结果准确率暴打人类医生。

Genie 3来了!这或许是最接近「模拟世界」的AI魔法。只需一句话,它就能生成一个动态、可互动的世界——角色能互动、下水会溅起水花,甚至还能记住一分钟前的细节。DeepMind研究者直言:Genie 3是通向AGI的关键一步。

所有学LLM的人都要知道的内容。 这可能是对于大语言模型(LLM)原理最清晰、易懂的解读。

我最近深入研究了一家名为 StackOne 的伦敦创业公司,他们刚刚完成了由 GV(Google Ventures)领投的 2000 万美元 A 轮融资,这不仅仅是一个简单的融资消息,而是整个企业软件生态系统即将迎来根本性变革的信号。