榨干GPU性能,中兴Mariana(马里亚纳)突破显存壁垒

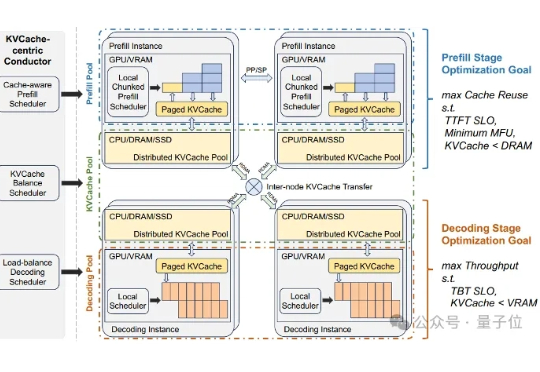

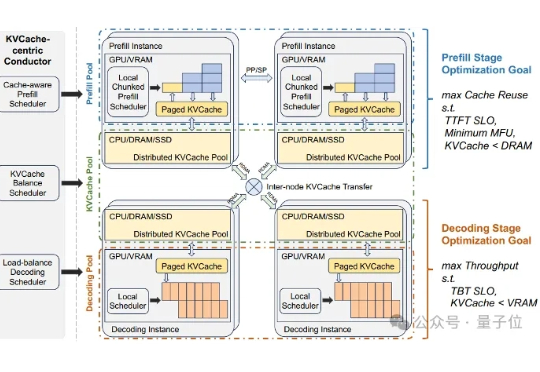

榨干GPU性能,中兴Mariana(马里亚纳)突破显存壁垒当大语言模型(LLM)走向千行百业,推理效率与显存成本的矛盾日益尖锐。

来自主题: AI资讯

7934 点击 2025-08-26 19:21

当大语言模型(LLM)走向千行百业,推理效率与显存成本的矛盾日益尖锐。

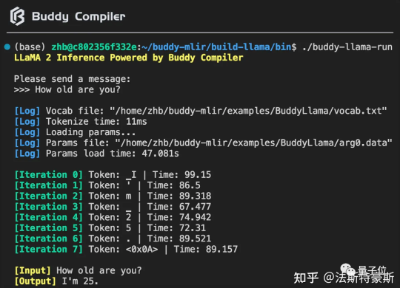

Buddy Compiler 端到端 LLaMA2-7B 推理示例已经合并到 buddy-mlir仓库[1]主线。我们在 Buddy Compiler 的前端部分实现了面向 TorchDynamo 的第三方编译器,从而结合了 MLIR 和 PyTorch 的编译生态。