168小时AI狂写300万行代码造出浏览器!Cursor公开数百个智能体自主协作方案

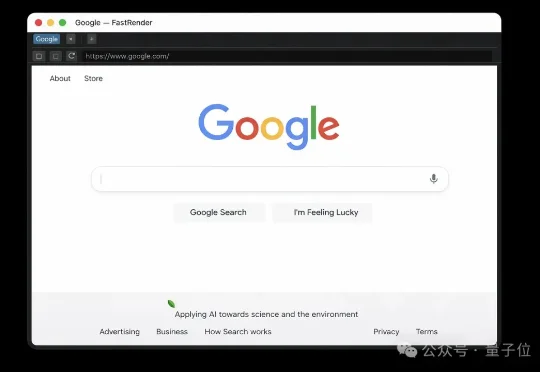

168小时AI狂写300万行代码造出浏览器!Cursor公开数百个智能体自主协作方案AI写代码,这次玩大了。 Cursor创始人宣布一项疯狂实验的结果:让数百个AI智能体连续跑了整整一周,从零开始,硬生生造出了一个可用的Web浏览器。项目代号FastRender,产出超过300万行代码,核心是一个用Rust从头写的渲染引擎,甚至还自带一个定制的JavaScript虚拟机。

AI写代码,这次玩大了。 Cursor创始人宣布一项疯狂实验的结果:让数百个AI智能体连续跑了整整一周,从零开始,硬生生造出了一个可用的Web浏览器。项目代号FastRender,产出超过300万行代码,核心是一个用Rust从头写的渲染引擎,甚至还自带一个定制的JavaScript虚拟机。

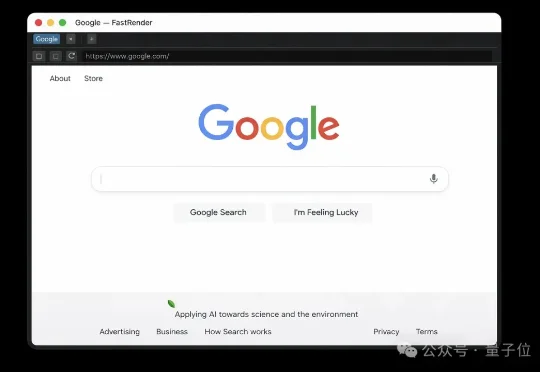

VLA 模型正被越来越多地应用于端到端自动驾驶系统中。然而,VLA 模型中冗长的视觉 token 极大地增加了计算成本。但现有的视觉 token 剪枝方法都不是专为自动驾驶设计的,在自动驾驶场景中都具有局限性。

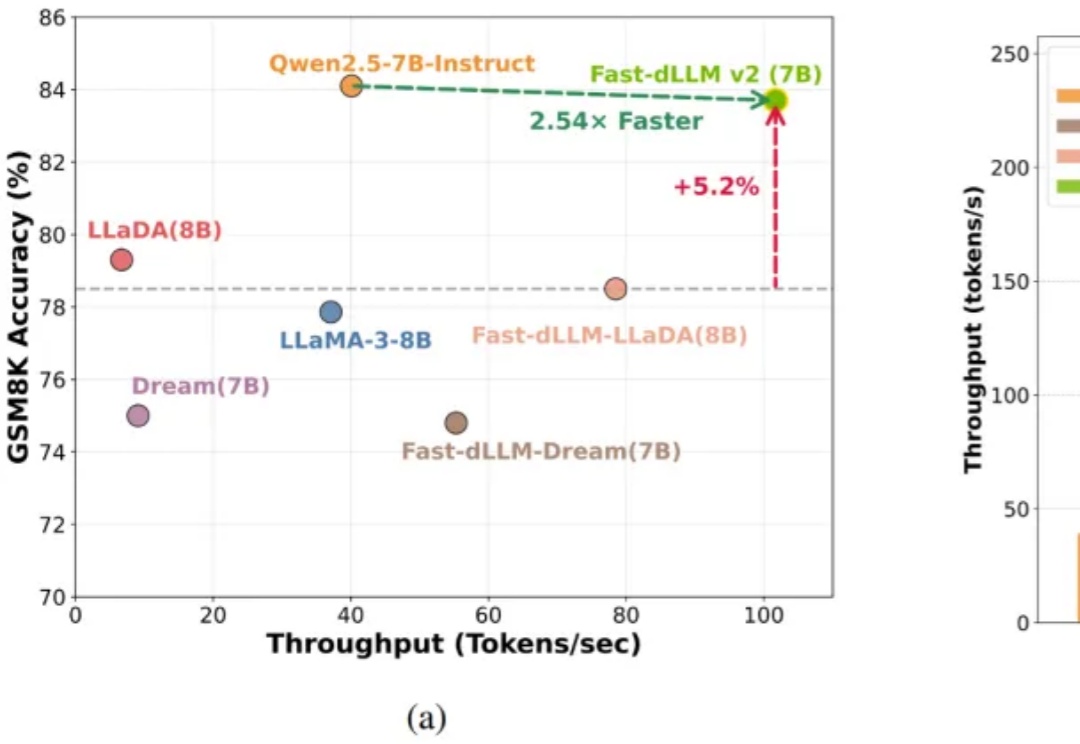

基于扩散的大语言模型 (dLLM) 凭借全局解码和双向注意力机制解锁了原生的并行解码和受控生成的潜力,最近吸引了广泛的关注。例如 Fast-dLLM 的现有推理框架通过分块半自回归解码进一步实现了 dLLM 对 KV cache 的支持,挑战了传统自回归 LLMs 的统治地位。

在AIGC的浪潮中,3D生成模型(如TRELLIS)正以惊人的速度进化,生成的模型越来越精细。然而,“慢”与计算量大依然是制约其大规模应用的最大痛点。复杂的去噪过程、庞大的计算量,让生成一个高质量3D资产往往需要漫长的等待。

今天,NeurIPS 2025最佳论文出炉!4篇最佳论文,华人占多半,何恺明孙剑等人曾提出的Faster R-CNN获「时间检验奖」,实至名归。

刚刚,NeurIPS 2025最佳论文奖、时间检验奖出炉!

今年刚满 20 岁的中山大学 00 后本科毕业生沙天铭,前不久收到了多所全美 Top50 高校的博士 offer。同样在前不久,他和合作者为预防中风研发出一款名为 FAST-CAD 的 AI 工具,能在不依赖医院设备的前提下,在复杂的日常环境中实现中风的准确判断。

太快了!一天之内Grok连迎两大更新——Grok 4 Fast与Grok Imagine都进行了大升级。Grok 4 Fast把上下文窗口提高到2M,并把完成率拉到94.1%(推理)与97.9%(非推理)。这意味着,你不必再把一本书或一整个代码库切碎喂给模型,它可以一次吞下,然后稳定地给出结果。

自回归(AR)大语言模型逐 token 顺序解码的范式限制了推理效率;扩散 LLM(dLLM)以并行生成见长,但过去难以稳定跑赢自回归(AR)模型,尤其是在 KV Cache 复用、和 可变长度 支持上仍存挑战。

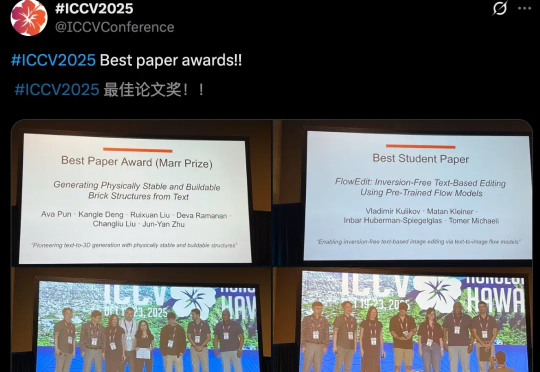

ICCV最佳论文新鲜出炉了!今年,CMU团队满载而归,斩获最佳论文奖和最佳论文提名。同时,何恺明团队论文,RBG大神提出的Fast R-CNN,十年后斩获Helmholtz Prize,实至名归。