Midjourney V7内测图首曝,电影级画质干翻GPT-4o!人物蜡像感消失,AI生图迎最强地震

Midjourney V7内测图首曝,电影级画质干翻GPT-4o!人物蜡像感消失,AI生图迎最强地震这周,Midjourney即将带着全新V7强势归来。内部模型已训完,目前开启了评分系统,进入最后微调阶段。网友已放出生图,效果惊艳,画质细腻度拉满。

这周,Midjourney即将带着全新V7强势归来。内部模型已训完,目前开启了评分系统,进入最后微调阶段。网友已放出生图,效果惊艳,画质细腻度拉满。

GPT-4o玩家太疯狂,奥特曼紧急呼吁别再生成图片了:OpenAI团队为此一直在熬夜。为什么需要熬夜呢,自原生图像生成推出以来,必须一直有人守着才能保持服务器在线。

AI圈最热的风头莫过于GPT-4o的原生图像,但别急着下定论。Gemini 2.5 Pro正在悄悄反击,在Chatbot竞技场夺冠、IQ测试拿下第一后,它还能解魔方、建模型、创游戏,甚至一键生成3D打印文件!AI的下一个战场,正在从文字转向视觉与空间,谁能笑到最后?

最近,AI 公司 Databricks 推出了一种新的调优方法 TAO,只需要输入数据,无需标注数据即可完成。更令人惊喜的是,TAO 在性能上甚至超过了基于标注数据的监督微调。

一夜之间,CV被大模型“解决”了(狗头)。万物皆可吉卜力之后,GPT-4o原生多模态图像生成更多玩法被开发出来。万物皆可吉卜力之后,GPT-4o原生多模态图像生成更多玩法被开发出来。

最近几天,OpenAI 革新的 GPT-4o 图像功能给大家带来了不少乐趣,各路社交媒体都被「吉卜力」风格的图像、视频刷了屏。机器之心还尝试了制作了《甄嬛传》的名场面(视频如下,制作方法参见《GPT-4o 整活!3 个小时、6 个镜头重现吉卜力版《甄嬛传》名场面》)。

GPT-4o原生图像一出手,直接登顶流量王座!今天凌晨,OpenAI再放大招更新GPT-4o,冲进大模型排行榜第二碾压Grok 3、GPT-4.5。创意一键生成,Midjourney瞬间黯然失色,设计师开始颤抖吧。

GPT4o的多模态生图前天上线之后。经过两天的发酵,含金量还在不断提升。

「看到人们喜欢 ChatGPT 中的图片功能真是太有趣了,但是我们的 GPU 正在融化。」

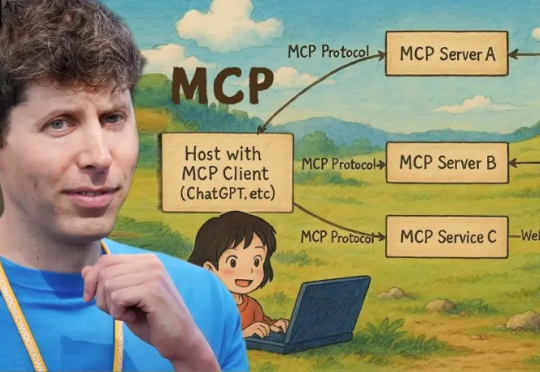

OpenAI昨夜又放大招,Agents SDK接入行业标准MCP,下一步加持ChatGPT桌面版,要彻底颠覆每个人AI工作流。自从昨天OpenAI将GPT-4o的原生图像生成同步开放给免费用户后,今天他们又Open了一把。