续命Scaling Law?世界模型GPT-4o让智能体超级规划,OSU华人一作

续命Scaling Law?世界模型GPT-4o让智能体超级规划,OSU华人一作Scaling Law撞墙,扩展语言智能体的推理时计算实在太难了!破局之道,竟是使用LLM作为世界模型?OSU华人团队发现,使用GPT-4o作为世界模型来支持复杂环境中的规划,潜力巨大。

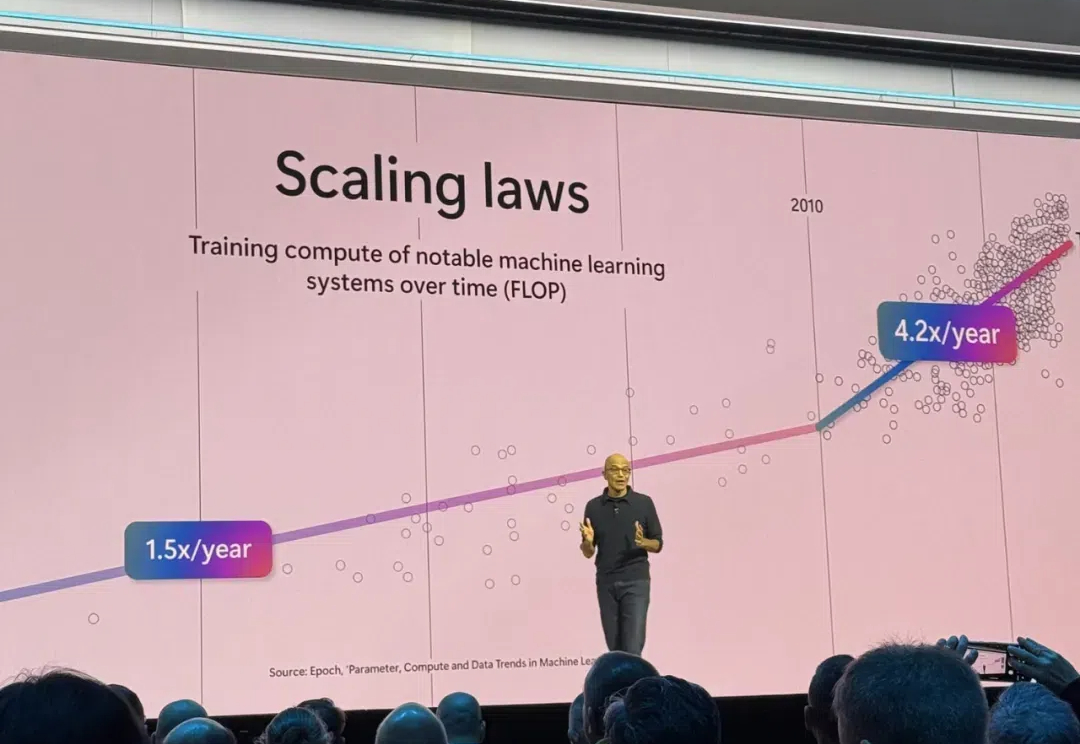

Scaling Law撞墙,扩展语言智能体的推理时计算实在太难了!破局之道,竟是使用LLM作为世界模型?OSU华人团队发现,使用GPT-4o作为世界模型来支持复杂环境中的规划,潜力巨大。

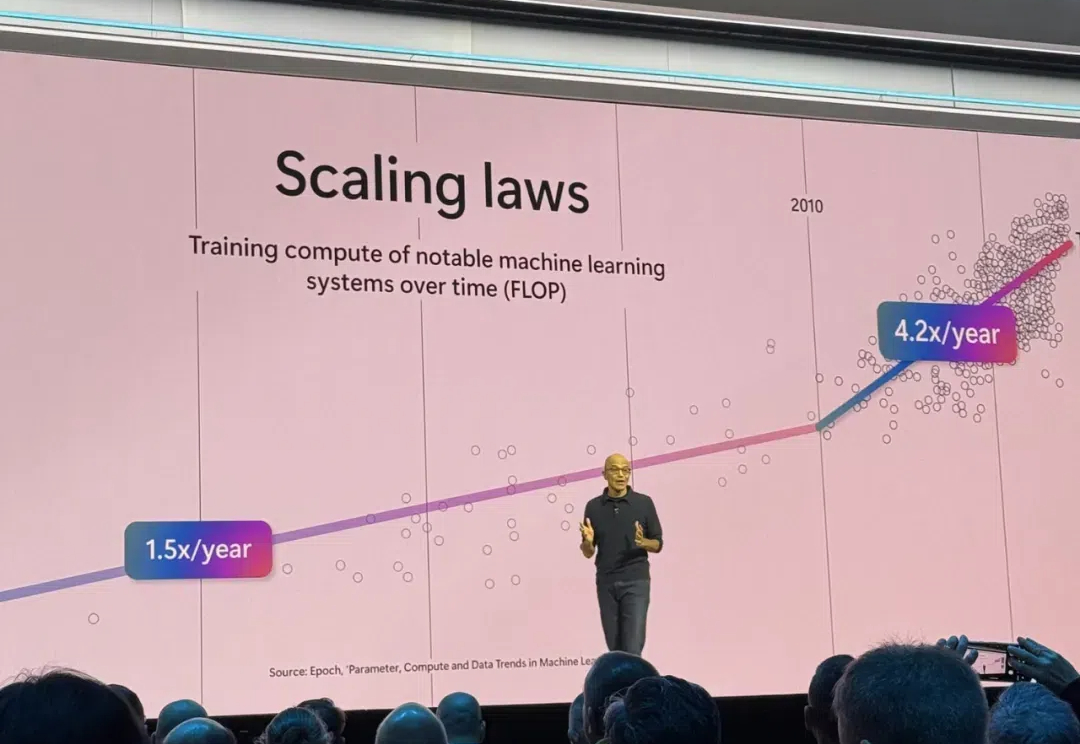

OpenAI开发者日新加坡站今天启幕,果不其然,ChatGPT又出手了: Gemini刚在竞技场头把交椅上坐了不到一周,最新版ChatGPT轻轻一更新,第一再次易主。

在「全球最难LLM评测榜单」上,国产万亿参数模型杀入全球第五,拿下中国第一!国内明星初创阶跃星辰的这个自研模型太过亮眼,甚至引起了外国网友的热议。

算起来,距离 5 月 14 日 OpenAI 发布 GPT-4o 高级语音模式已经过去了半年时间。在这期间,AI 实时语音对话已经成为了有能力大厂秀肌肉、拼实力的新战场。

随着AI大模型在今年618前夕打起价格战,当以GPT-4o为代表的多模态大模型将交互体验也推向更高的层次,也意味着杀手级AI应用或许真的来到了奇点时刻。如今AI行业的创业者已经不再聚焦大模型,而是开始尝试用AI赋能具体的应用场景。

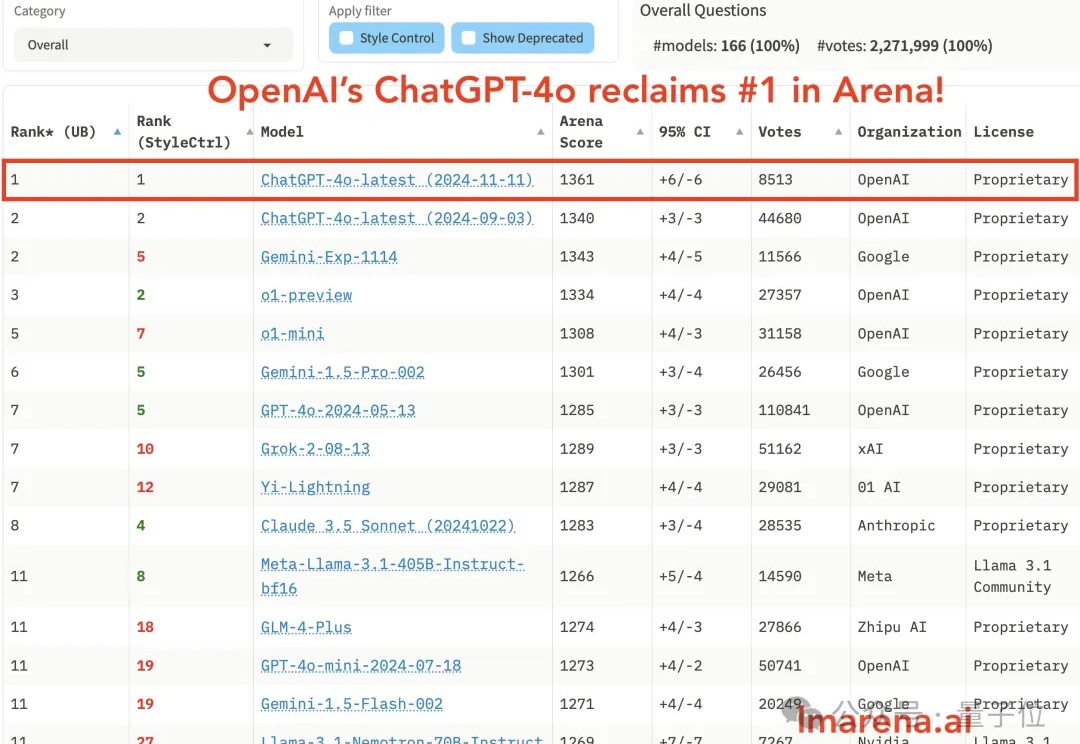

对于 LLM 从业者来说,让 LLM 落地应用并发挥作用需要手动构建并反复调试 Agentic Workflow,这无疑是个繁琐过程,一遍遍修改相似的代码,调试 prompt,手动执行测试并观察效果,并且换个 LLM 可能就会失效,有高昂的人力成本。许多公司甚至专职招聘 Prompt Engineer 来完成这一工作。

OpenAI出了个新功能,直接让ChatGPT输出的速度原地起飞! 这个功能叫做“预测输出”(Predicted Outputs),在它的加持之下,GPT-4o可以比原先快至多5倍。

视觉语言模型(如 GPT-4o、DALL-E 3)通常拥有数十亿参数,且模型权重不公开,使得传统的白盒优化方法(如反向传播)难以实施。

与最先进的开源方法甚至闭源模型 GPT-4o 相比,MMedAgent 在各种医疗任务中实现了卓越的性能。此外,MMedAgent 在更新和集成新医疗工具方面表现出效率。

一群大模型玩你画我猜,人类一旁围观超起劲儿。 就像下面这张图展示的,由Grok画长颈鹿,一堆大模型根据生成内容猜答案。参赛选手包括GPT-4o、Claude、Llama、Gemini、Grok等。