谷歌、Anthropic双重围剿下的OpenAI,正面临「生死抉择」

谷歌、Anthropic双重围剿下的OpenAI,正面临「生死抉择」进入到 2026 年,OpenAI 在关注消费级产品(如 ChatGPT、社交应用)之外,开始将一部分重心转向企业级市场。

进入到 2026 年,OpenAI 在关注消费级产品(如 ChatGPT、社交应用)之外,开始将一部分重心转向企业级市场。

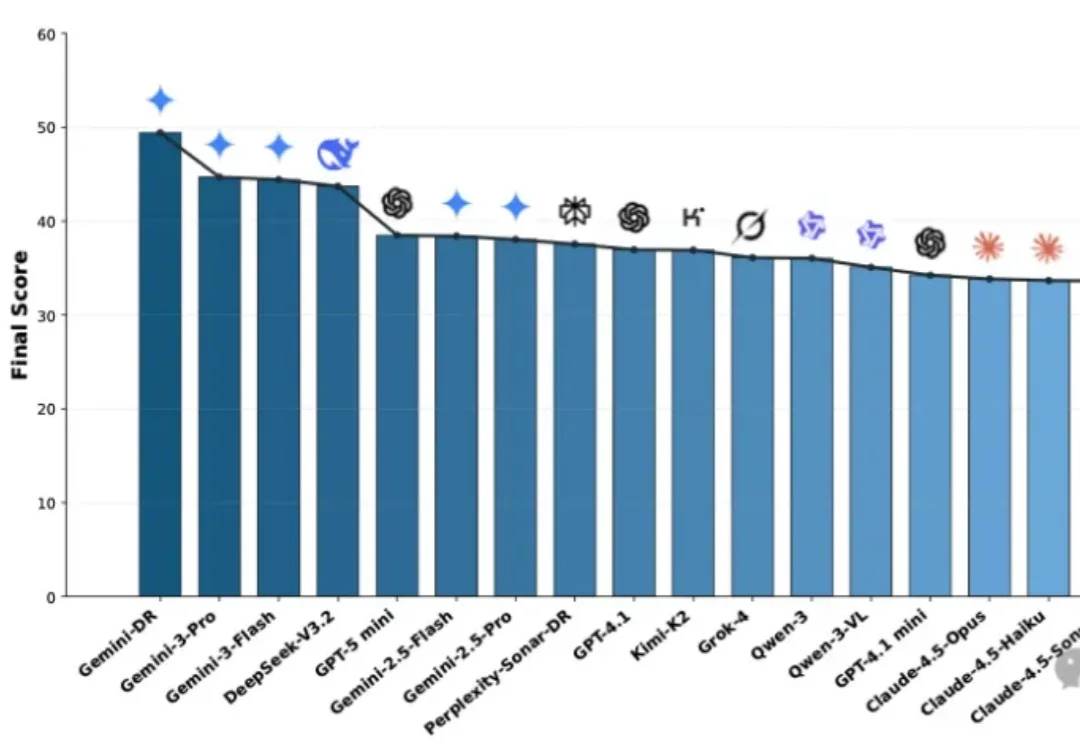

面对琳琅满目的Deep Research Agent(深度研究智能体),究竟该如何选型?本文基于OSU与Amazon最新发布的MMDR-Bench论文,为您提供一份经过严谨科学验证的“避坑指南”。结论先行:综合任务首选谷歌Gemini Deep Research,而涉及计算机科学与数据结构的硬核任务,GPT-5.2依然是专家首选。

一句神秘指令刷屏全网!ChatGPT启用全新「记忆」功能,画出了和人类相处的真相。如今,GPT-5.3已经在路上。

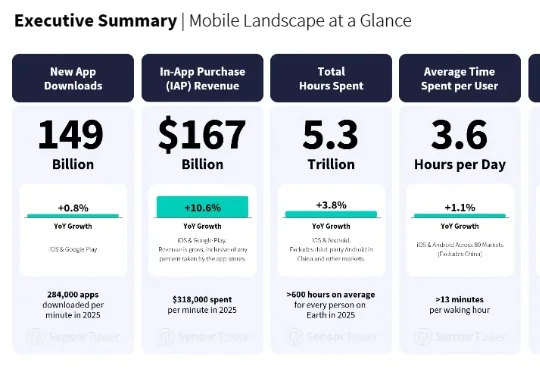

最近,移动应用数据分析商 Sensor Tower 发布了一份《State of Mobile 2026》。AI 应用的增长不但没有减速,反而更快了。AI 应用的下载量翻倍,达到 38 亿次;IAP 收入增长超过三倍,突破 50 亿美元;

ChatGPT也推出「防沉迷系统」了?如果你习惯用缩写、语气太嫩,或者仅仅是作息不规律,都可能被判定为未成年!想恢复成人权限,代价是上传你的脸部3D扫描数据。不需要等到未来,欢迎来到2026年的「行为算命」时代。

OpenAI 收购 Torch Health 这件事,这两天我看到很多解读,基本都落在两个方向。一个是人才收购,四个人的小团队,买回去做 ChatGPT Health 的一块拼图。另一个是医疗布局,OpenAI 终于开始认真做垂直行业了。

目前已经出现了一些早期迹象,通用LLM助手领域的市场格局,正朝着“赢家通吃”,至少是“赢家通吃大部分市场”的趋势发展。在ChatGPT、Gemini、Claude 3和Cursor这几款产品中,仅有9%的用户会为一款以上的产品付费。

周二早上,马斯克和奥特曼又吵起来了。

聊天救不了命!这家中国AI选择死磕临床:斩获中美日欧全满贯认证,落地全球5000家医院,硬是走通了这条「最难的路」。

中国团队首次在全球顶尖期刊发表“大模型+医疗”领域的相关标准研究! 作为Nature体系中专注于数字医疗的旗舰期刊,《npj Digital Medicine》(JCR影响因子15.1,中科院医学大类1区Top期刊)此次收录的CSEDB研究,首次提出了一套用于评估医疗大模型真实临床能力的系统性框架。