8 小时打磨的 AI 开发者日报,上线 3 天狂揽1000+ 精准用户!

8 小时打磨的 AI 开发者日报,上线 3 天狂揽1000+ 精准用户!大家好,熟悉我的读者都知道我去年做了一个 AI 领域周刊 Weekly Gradient[1],周刊初衷是不追任何热点,只讲落地相关内容,但是奈何 AI 领域的变化日新月异,结合自己需求和读者反馈,我决定搞一个专门面向开发者、汇总 AI 技术领域动态的日报,这篇文章向大家介绍日报的定位和实现过程。

大家好,熟悉我的读者都知道我去年做了一个 AI 领域周刊 Weekly Gradient[1],周刊初衷是不追任何热点,只讲落地相关内容,但是奈何 AI 领域的变化日新月异,结合自己需求和读者反馈,我决定搞一个专门面向开发者、汇总 AI 技术领域动态的日报,这篇文章向大家介绍日报的定位和实现过程。

编程(programming)和写代码(coding)是本质不同的两件事,AI能干好coding,干不好programming;

硅谷挖角戏码升级!相比Meta3亿美元「血本挖角」,OpenAI来了波反向操作——选择培养人才,奥特曼悄然推进一个名为「驻留计划」(Residency Program)的项目。这个项目有何神秘之处?奥特曼的底气到底从何而来?

OpenAI 在向大企业和政府机构推销其人工智能技术时 ,借鉴了许多软件公司的做法,提供内部研究人员和软件工程师为客户定制 AI 解决方案。

今天,我想给你讲一个,关于我自己亲眼看到、亲身体会的,用AI对抗癌症的故事。

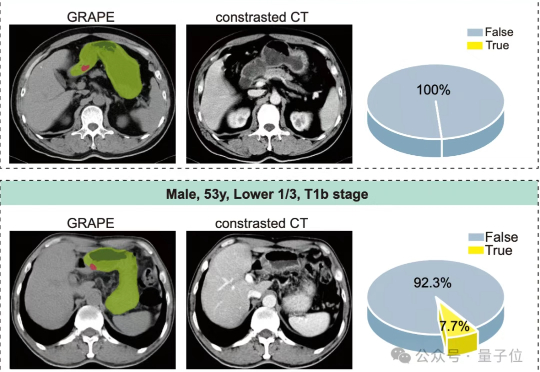

AI新进展,救命的那种。现在,只需做一次体检时常规的CT检查,再用AI分析,就有可能在癌症还没有露出明显症状之前——比如提前半年——把它揪出来。

刚刚,浙江省肿瘤医院联合阿里巴巴达摩院召开发布会,发布全球首个胃癌影像筛查AI模型DAMO GRAPE,首次利用平扫CT影像识别早期胃癌病灶,并联合全国20个中心近10万人的大规模临床研究中大幅提升胃癌检出率。相关成果登上国际顶级期刊《自然·医学》(Nature Medicine)。

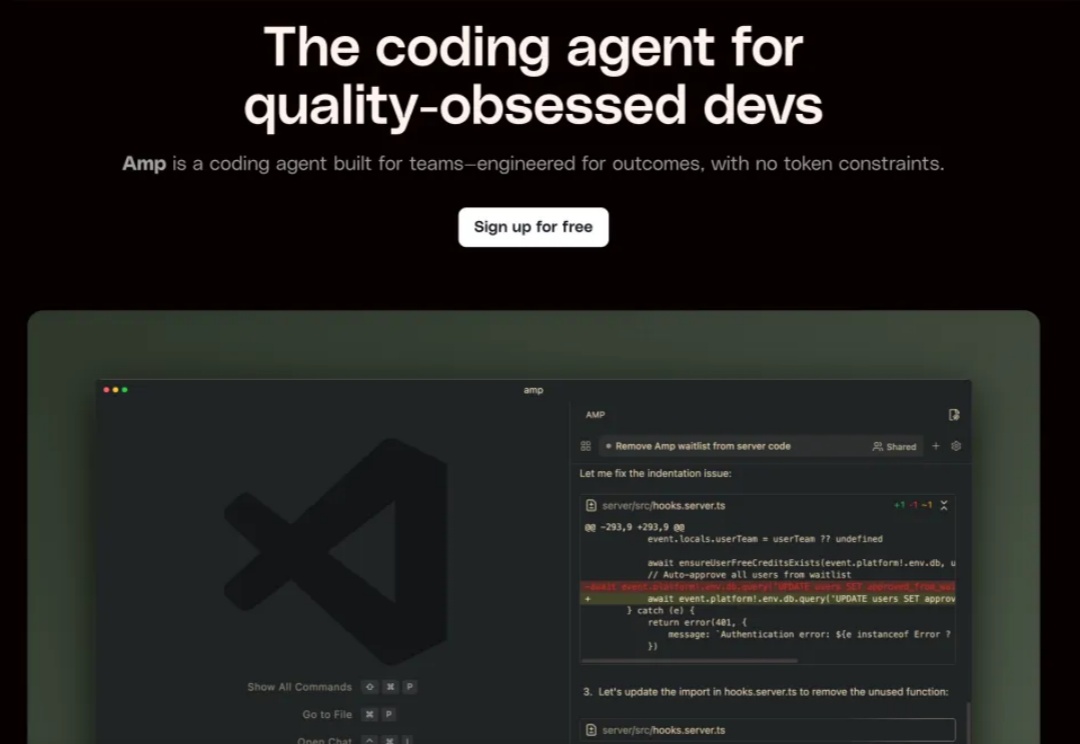

最近这段时间又一匹AI coding黑马正在快速崛起,感兴趣的朋友可以先看下这个视频,在Every最新一期播客里,他们对当前所有AI coding产品做了一个评级分类,而跟Claude code共同排在S级的就是最近Sourcegraph刚推出的Ampcode,而爆火的Cursor也只排在了第二档次的A级。

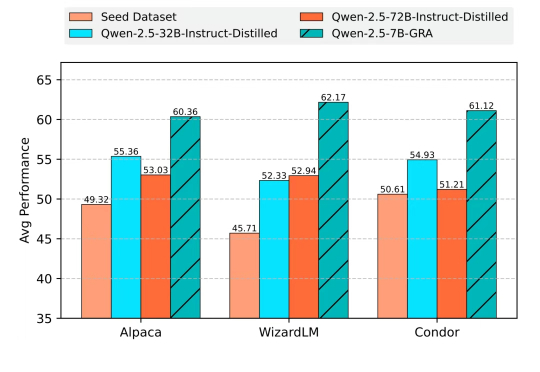

无需蒸馏任何大规模语言模型,小模型也能自给自足、联合提升?

2022年末,当ChatGPT的火种刚刚在全球点燃,引发第一波的震撼与惊叹时,张宏波进行了一项实验。他将自己刚刚孕育雏形的编程语言MoonBit的文法(Grammar)——一段描述语言规则的枯燥文本,喂给了那个强大的新模型。