Embedding黑箱成为历史!这个新框架让模型“先解释,再学Embedding”

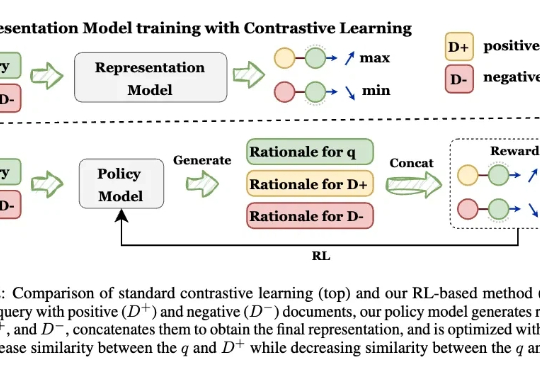

Embedding黑箱成为历史!这个新框架让模型“先解释,再学Embedding”让模型先解释,再学Embedding! 来自UIUC、ANU、港科大、UW、TAMU等多所高校的研究人员,最新推出可解释的生成式Embedding框架——GRACE。过去几年,文本表征(Text Embedding)模型经历了从BERT到E5、GTE、LLM2Vec,Qwen-Embedding等不断演进的浪潮。这些模型将文本映射为向量空间,用于语义检索、聚类、问答匹配等任务。

来自主题: AI技术研报

7844 点击 2025-10-22 15:00