马斯克烧几十亿美元造最大超算中心,10万块H100训练Grok追赶GPT-4o

马斯克烧几十亿美元造最大超算中心,10万块H100训练Grok追赶GPT-4o最近,许久没有新动向的马斯克放出了大消息——他旗下的人工智能初创公司xAI将投入巨资建造一个超算中心,以保证Grok 2及之后版本的训练。这个「超级计算工厂」预计于2025年秋季建成,规模将达到目前最大GPU集群的四倍。

来自主题: AI资讯

9956 点击 2024-05-27 15:39

最近,许久没有新动向的马斯克放出了大消息——他旗下的人工智能初创公司xAI将投入巨资建造一个超算中心,以保证Grok 2及之后版本的训练。这个「超级计算工厂」预计于2025年秋季建成,规模将达到目前最大GPU集群的四倍。

最近几年,随着大语言模型的飞速发展与迭代,科技巨头们都竞相投入巨额财力打造超级计算机(或大规模 GPU 集群)。他们认为,更强大的计算能力是实现更强大 AI 的关键。

提高 GPU 利用率,就是这么简单。

FP8和更低的浮点数量化精度,不再是H100的“专利”了!

Llama 3诞生整整一周后,直接将开源AI大模型推向新的高度。

硅谷的人才争夺战愈演愈烈。

最近,一则数据点出了AI领域算力需求的惊人增长—— 根据业内专家的预估,OpenAI推出的Sora在训练环节大约需要在4200-10500张NVIDIA H100上训练1个月,并且当模型生成到推理环节以后,计算成本还将迅速超过训练环节。

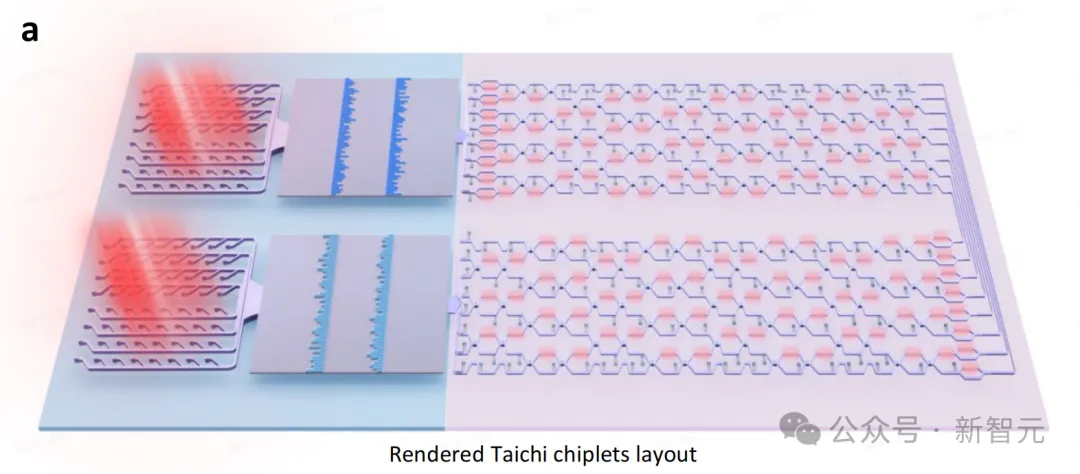

训练下一代万亿级参数大模型的高效芯片诞生了!

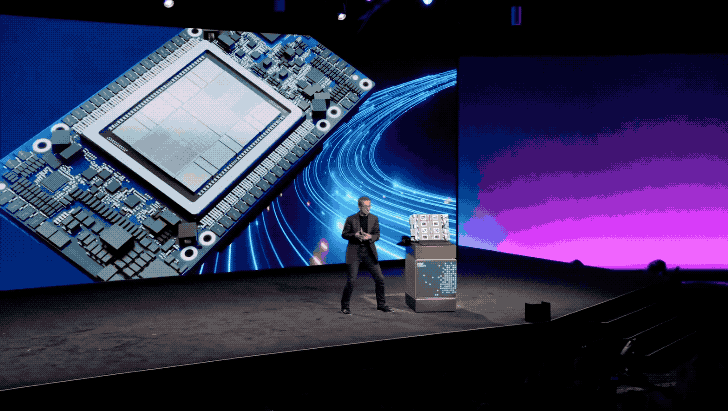

英特尔,开始正面硬刚英伟达了。 就在深夜,英特尔CEO帕特·基辛格手舞足蹈地亮出了最新AI芯片——Gaudi 3: