完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%

完全使用「自生成数据」实现LLM自我纠正,DeepMind新突破SCoRe:纠正性能提升15.9%Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

Google DeepMind的SCoRe方法通过在线多轮强化学习,显著提升了大型语言模型在没有外部输入的情况下的自我修正能力。该方法在MATH和HumanEval基准测试中,分别将自我修正性能提高了15.6%和9.1%。

科学技术的快速发展过程中,机器学习研究作为创新的核心驱动力,面临着实验过程复杂、耗时且易出错,研究进展缓慢以及对专门知识需求高的挑战。近年来,LLM 在生成文本和代码方面展现出了强大的能力,为科学研究带来了前所未有的可能性。然而,如何系统化地利用这些模型来加速机器学习研究仍然是一个有待解决的问题。

实验证明,大模型的 System 2 能力还有待开发。

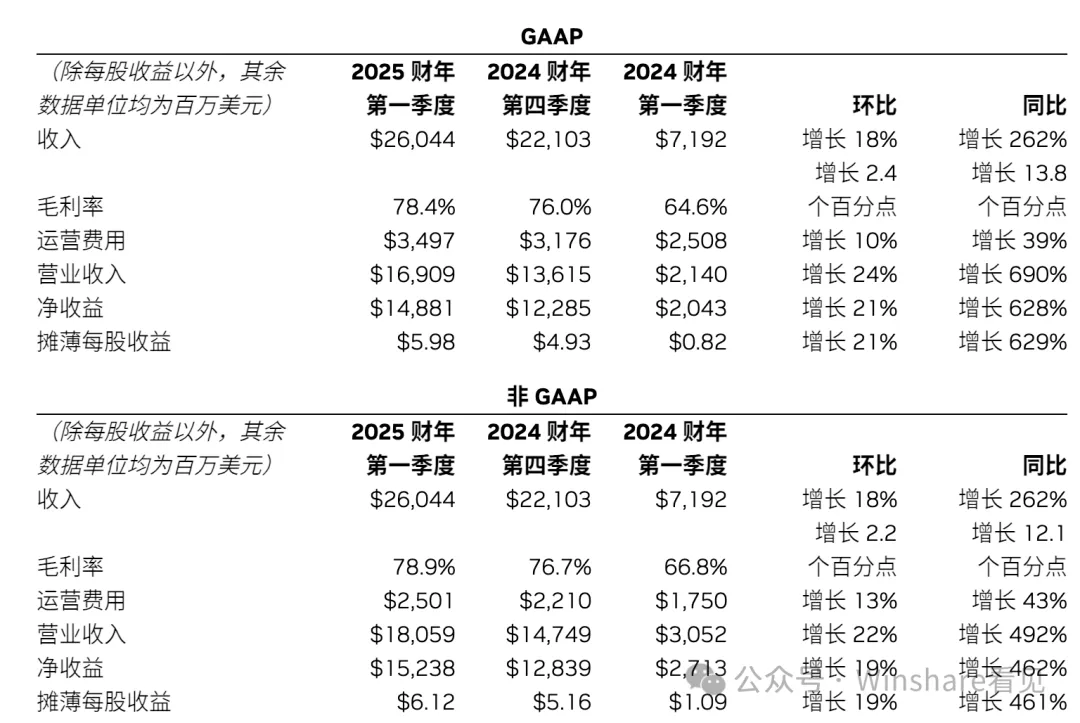

NVLM 1.0系列多模态大型语言模型在视觉语言任务上达到了与GPT-4o和其他开源模型相媲美的水平,其在纯文本性能甚至超过了LLM骨干模型,特别是在文本数学和编码基准测试中,平均准确率提高了4.3个百分点。

LLM说起谎来,如今是愈发炉火纯青了。 最近有用户发现,OpenAI o1在思考过程中明确地表示,自己意识到由于政策原因,不能透露内部的思维链。

多个LLM联合,可以迈向更强大系统!最新研究发现,GPT-4能够提升同伴的性能,能够让数学能力暴涨11.6%。

自从ChatGPT引起的大模型进化至今,没有人怀疑LLM和其应用范式将会对人类产生极其重大的影响。

扩展多模态大语言模型(MLLMs)的长上下文能力对于视频理解、高分辨率图像理解以及多模态智能体至关重要。这涉及一系列系统性的优化,包括模型架构、数据构建和训练策略,尤其要解决诸如随着图像增多性能下降以及高计算成本等挑战。

CoT只对数学、符号推理才起作用,其他的任务几乎没什么卵用!这是来自UT-Austin、霍普金斯、普林斯顿三大机构研究人员联手,分析了100+篇论文14类任务得出的结论。看来,CoT并非是所有大模型标配。

当谷歌的Gemini建议给比萨加胶水时,网友尚能发挥娱乐精神玩梗解构;但当LLM输出的诽谤信息中伤到到真实人类时,AI搜索引擎的未来是否值得再三思量?