还在人工炼丹?自动提示工程指南来了,还带从头实现

还在人工炼丹?自动提示工程指南来了,还带从头实现人工设计提示词太麻烦了!想过让 LLM 帮你设计用于 LLM 的提示词吗?

人工设计提示词太麻烦了!想过让 LLM 帮你设计用于 LLM 的提示词吗?

如果可以使用世界上所有的算力来训练AI模型,会怎么样?近日,凭借发布了开源的Hermes 3(基于Llama 3.1)而引起广泛关注的Nous Research,再次宣布了一项重大突破——DisTrO(分布式互联网训练)。

高端的食材,往往只需要最朴素的烹饪方式;高端的提示词也一样,把Top-K写进来,一个专属于你的CoT-decoding解码策略应运而生!丝毫不要怀疑LLM的推理能力,在这个维度上,它比我们懂!

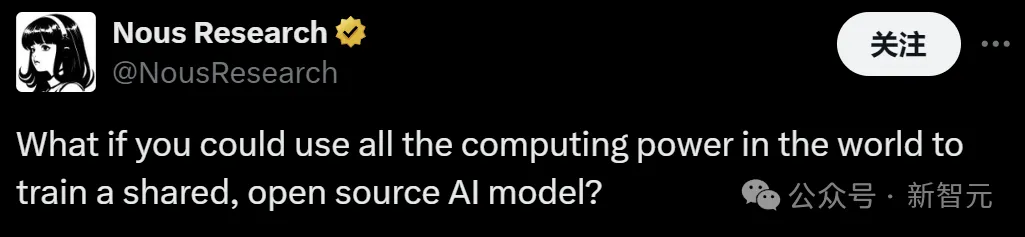

即便是最强大的语言模型(LLM),仍会偶尔出现推理错误。除了通过提示词让模型进行不太可靠的多轮自我纠错外,有没有更系统的方法解决这一问题呢?

提示工程师Riley Goodside小哥,依然在用「Strawberry里有几个r」折磨大模型们,GPT-4o在无限次PUA后,已经被原地逼疯!相比之下,Claude坚决拒绝PUA,是个大聪明。而谷歌最近的论文也揭示了本质原因:LLM没有足够空间,来存储计数向量。

用英伟达的GPU,但可以不用CUDA?PyTorch官宣,借助OpenAI开发的Triton语言编写内核来加速LLM推理,可以实现和CUDA类似甚至更佳的性能。

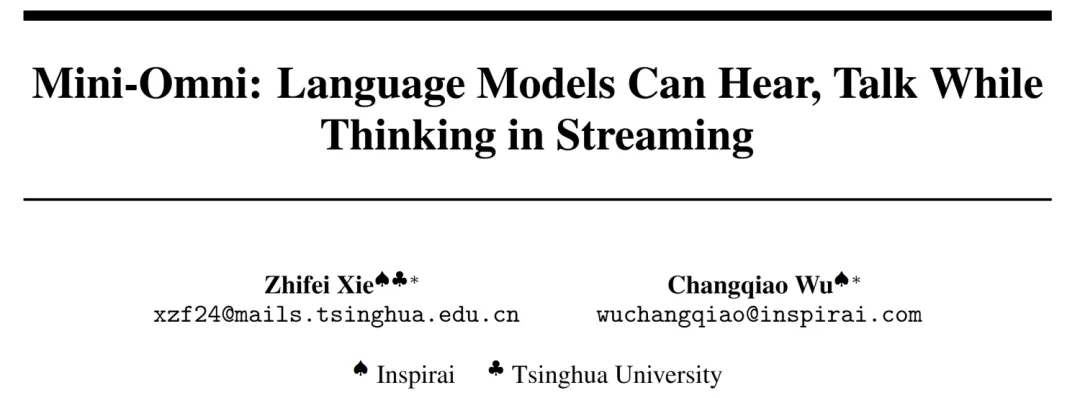

本文出自启元世界多模态算法组,共同一作是来自清华大学的一年级硕士生谢之非与启元世界多模态负责人吴昌桥,研究兴趣为多模态大模型、LLM Agents 等。本论文上线几天内在 github 上斩获 1000+ 星标。

头部模型的新一代模型的是市场观测、理解 LLM 走向的风向标。即将发布的 OpenAI GPT-Next 和 Anthropic Claude 3.5 Opus 无疑是 AGI 下半场最关键的事件。

我个人不是喜欢打听这些公司八卦的人,前些年移动互联网时代就已经有太多这样的小道消息,但最终都没有没什么用。重要的信息迟早会变成公开,最多晚几个月而已,又不是要考虑抢时间窗口投这些公司,花时间去探究ROI不高。

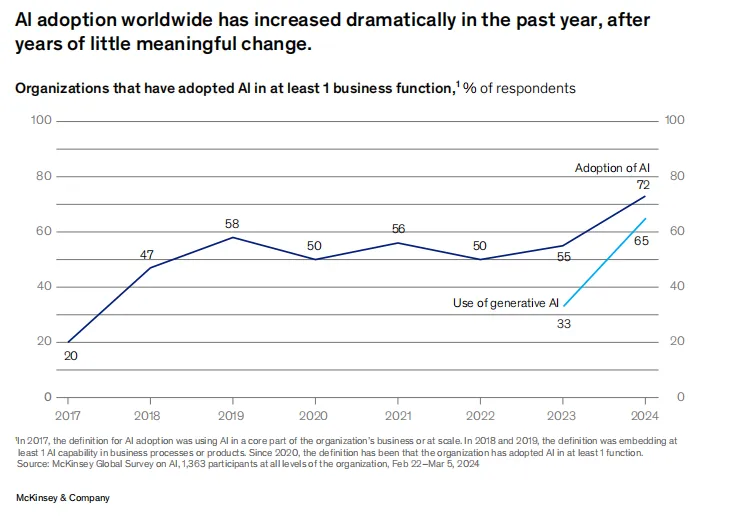

企业要用好 LLM 离不开高质量数据。和传统机器学习模型相比,LLM 对于数据需求量更大、要求更高,尤其是非结构化数据。而传统 ETL 工具并不擅长非结构化数据的处理,因此,企业在部署 LLM 的过程中,数据科学家们往往要耗费大量的时间精力在数据处理环节。这一环节既关系到 LLM 部署的效率和质量,也对数据科学家人力的 ROI 产生影响。