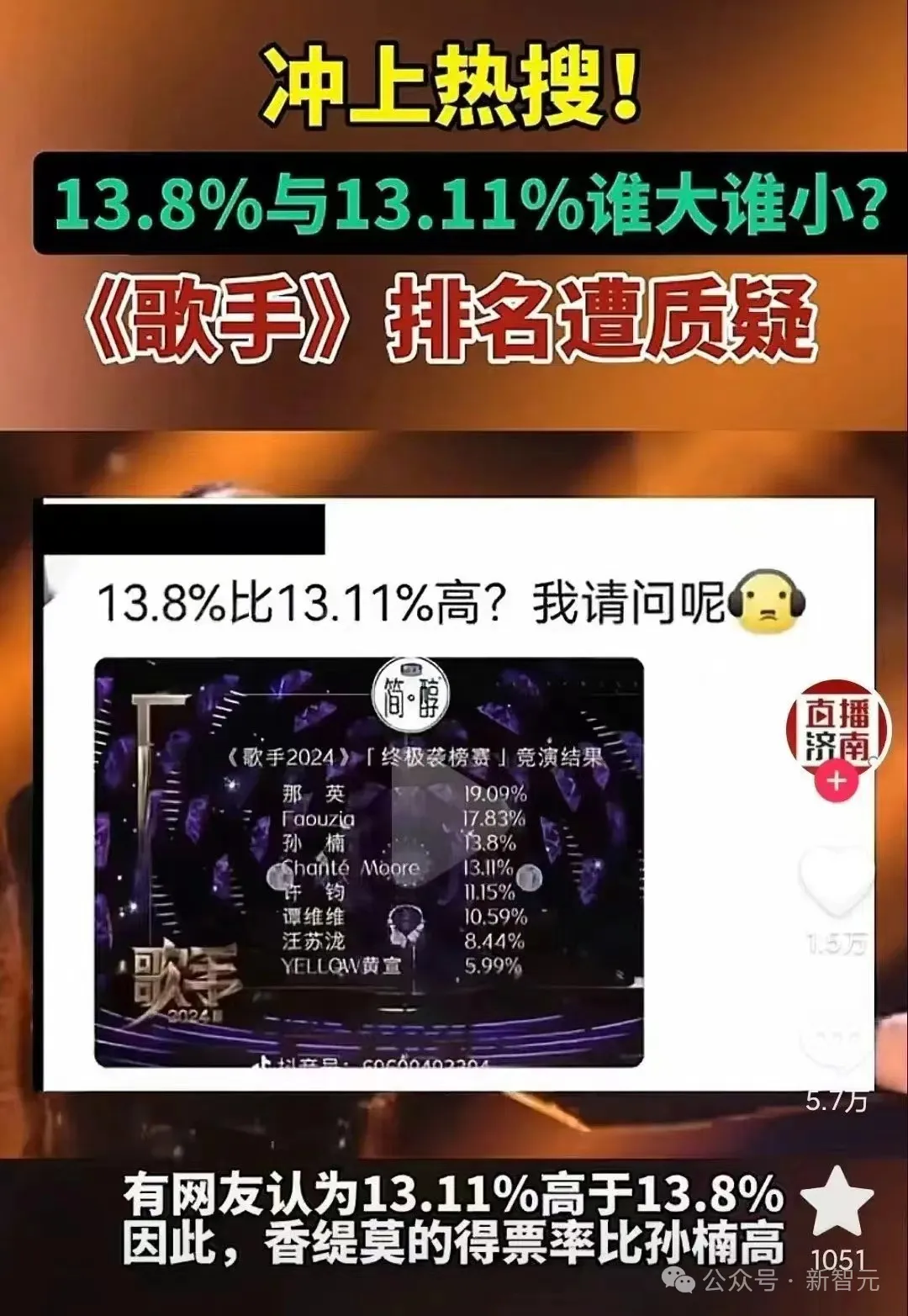

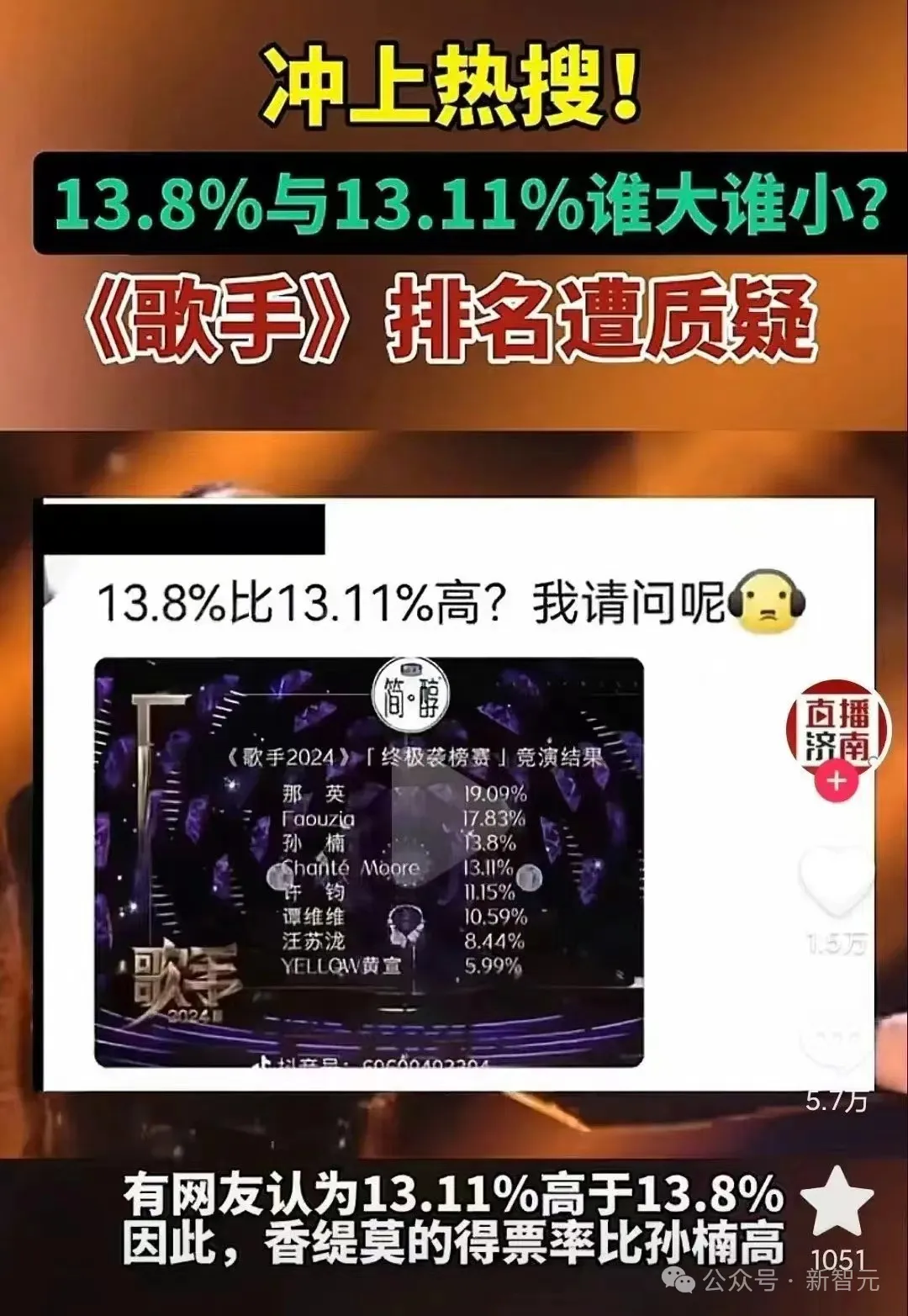

「13.11>13.8」冲上热搜,一道题让人类AI集体降智?所有LLM致命缺点曝光

「13.11>13.8」冲上热搜,一道题让人类AI集体降智?所有LLM致命缺点曝光13.8和13.11哪个大?这个问题不光难倒了部分人类,还让一票大模型折戟。AI如今都能做AI奥数题了,但简单的常识问题对它们依然难如登天。其实,无论是比大小,还是卷心菜难题,都揭示了LLM在token预测上的一个重大缺陷。

13.8和13.11哪个大?这个问题不光难倒了部分人类,还让一票大模型折戟。AI如今都能做AI奥数题了,但简单的常识问题对它们依然难如登天。其实,无论是比大小,还是卷心菜难题,都揭示了LLM在token预测上的一个重大缺陷。

大模型理解、推理Excel,现在变得更加精准了。

把因果链展示给 LLM,它就能学会公理。

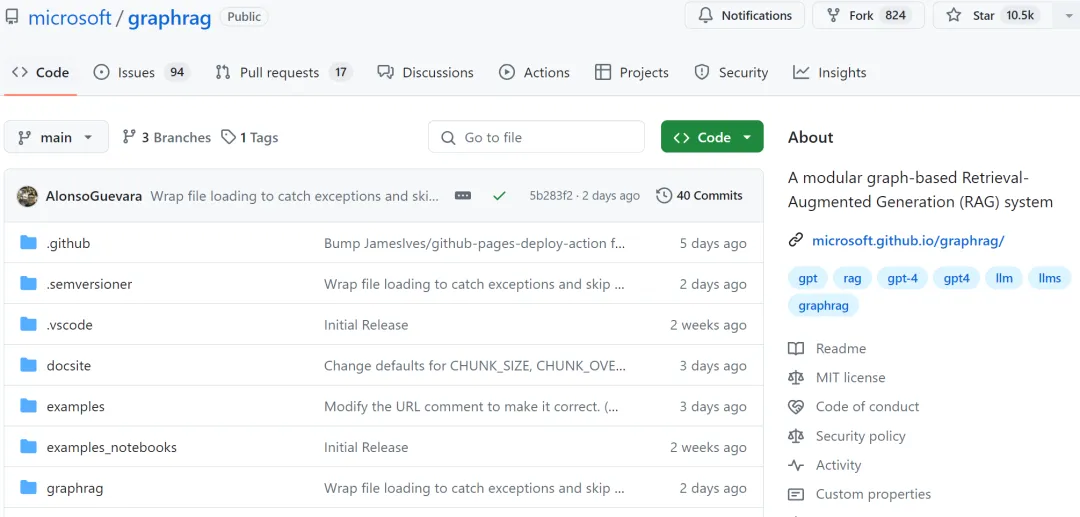

LLM 很强大,但也存在一些明显缺点,比如幻觉问题、可解释性差、抓不住问题重点、隐私和安全问题等。检索增强式生成(RAG)可大幅提升 LLM 的生成质量和结果有用性。

最近,多个机构学者合著的一篇研究为AI的规模化指了一条新路:物理神经网络(PNN),这一新兴的前沿领域还鲜少有人涉足,但绝对值得深耕!AI模型再扩展1000倍的秘密可能就藏在这里。

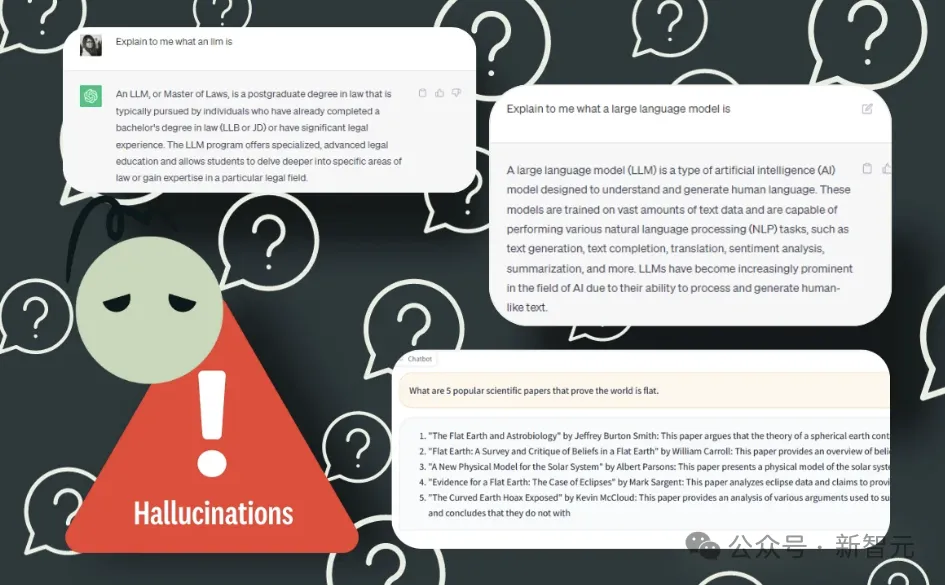

人会有幻觉,大型语言模型也会有幻觉。近日,OpenAI 安全系统团队负责人 Lilian Weng 更新了博客,介绍了近年来在理解、检测和克服 LLM 幻觉方面的诸多研究成果。

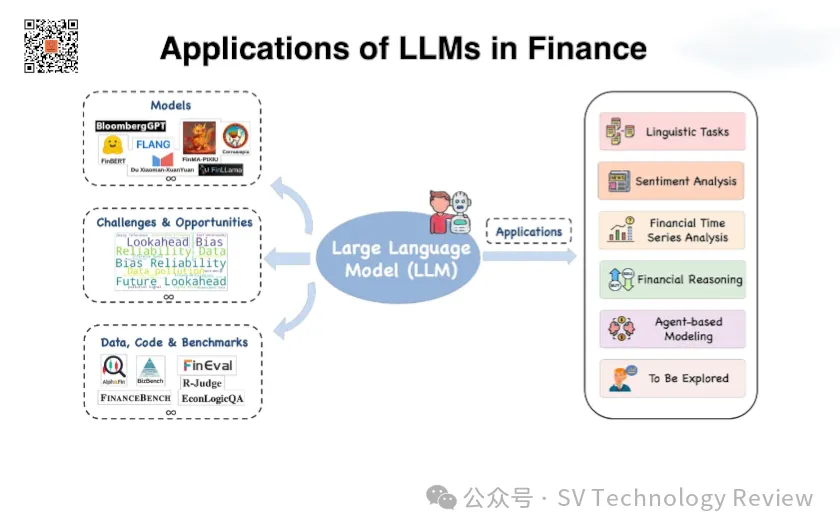

在瞬息万变的金融市场中,大模型(LLM)作为一种前沿技术,正以前所未有的速度变革着投资和金融行业。凭其强大的数据处理能力和智能分析功能,LLM不仅能够帮助投资者做出更明智的决策,还能预见市场趋势,降低投资风险。

释放进一步扩展 Transformer 的潜力,同时还可以保持计算效率。

近日,来自牛津大学的研究人员推出了利用语义熵来检测LLM幻觉的新方法。作为克服混淆的策略,语义熵建立在不确定性估计的概率工具之上,可以直接应用于基础模型,无需对架构进行任何修改。

来自佐治亚理工学院和英伟达的两名华人学者带队提出了名为RankRAG的微调框架,简化了原本需要多个模型的复杂的RAG流水线,用微调的方法交给同一个LLM完成,结果同时实现了模型在RAG任务上的性能提升。