Meta的Llama 3是合成数据训练?数据荒了解一下

Meta的Llama 3是合成数据训练?数据荒了解一下如今一场席卷人工智能圈的“石油危机”已经出现,几乎每一家AI厂商都在竭力寻求新的语料来源,但再多的数据似乎也填不满AI大模型的胃口。更何况越来越多的内容平台意识到了手中数据的价值,纷纷开始敝帚自珍。为此,“合成数据”也成为了整个AI行业探索的新方向。

如今一场席卷人工智能圈的“石油危机”已经出现,几乎每一家AI厂商都在竭力寻求新的语料来源,但再多的数据似乎也填不满AI大模型的胃口。更何况越来越多的内容平台意识到了手中数据的价值,纷纷开始敝帚自珍。为此,“合成数据”也成为了整个AI行业探索的新方向。

DeepMind最近被ICML 2024接收的一篇论文,完完全全暴露了他们背靠谷歌的「豪横」。一篇文章预估了这项研究所需的算力和成本,大概是Llama 3预训练的15%,耗费资金可达12.9M美元。

Llama 3.1 刚刚发布,你是否已经尝试了呢?就算你的个人计算机是最近的顶尖配置,运行其中最小的 8B 版本可能也依然会有明显延迟。为了提升模型的推理效率,研究者想出了多种多样的方法,但其中很多都会让模型牺牲一些准确度。

单卡搞定Llama 3.1(405B),最新大模型压缩工具来了!

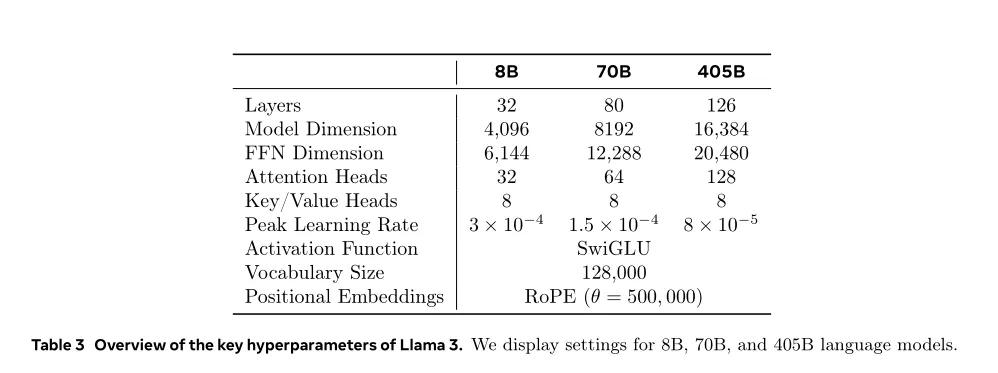

不同类型的数据配比如何配置:先通过小规模实验确定最优配比,然后将其应用到大模型的训练中。 Token配比结论:通用知识50%;数学与逻辑25%;代码17%;多语言8%。

是时候用CPU通用服务器跑千亿参数大模型了!

最近一段时间开源大模型市场非常热闹,先是苹果开源了70亿参数小模型DCLM,然后是重量级的Meta的Llama 3.1 和Mistral Large 2相继开源,在多项基准测试中Llama 3.1超过了闭源SOTA模型。 不过开源派和闭源派之间的争论并没有停下来的迹象。

AI大神李沐老师时隔1年多,终于回归B站“填坑”经典论文精读系列了!

Meta、UC伯克利、NYU共同提出元奖励语言模型,给「超级对齐」指条明路:让AI自己当裁判,自我改进对齐,效果秒杀自我奖励模型。

今年的图形学顶级会议 SIGGRAPH 2024 上,老黄把扎克伯格请来了。