李开复的零一大模型套壳Llama2算抄袭吗?

李开复的零一大模型套壳Llama2算抄袭吗?本文讨论了李开复投资的零一万物公司被指使用Facebook母公司META的Llama大模型的开源代码却未标明来源的问题。作者指出,此举涉嫌侵犯署名权,即抄袭。文章还探讨了零一万物公司和第三方开发者可能面临的法律风险。

本文讨论了李开复投资的零一万物公司被指使用Facebook母公司META的Llama大模型的开源代码却未标明来源的问题。作者指出,此举涉嫌侵犯署名权,即抄袭。文章还探讨了零一万物公司和第三方开发者可能面临的法律风险。

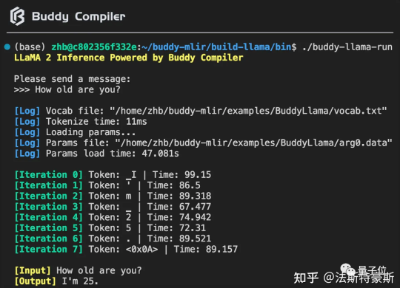

Buddy Compiler 端到端 LLaMA2-7B 推理示例已经合并到 buddy-mlir仓库[1]主线。我们在 Buddy Compiler 的前端部分实现了面向 TorchDynamo 的第三方编译器,从而结合了 MLIR 和 PyTorch 的编译生态。

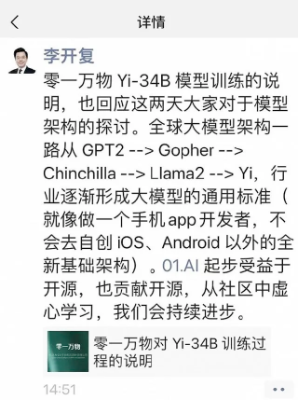

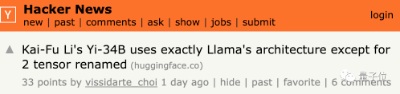

针对近日零一万物被质疑完全使用 LLaMA 架构,只对两个张量(Tensor)名称做修改,李开复在朋友圈进行了回应。

RLHF今年虽然爆火,但实打实用到的模型并不多,现在还出现了替代方案,有望从开源界“出圈”;大模型透明度越来越低,透明度最高的是Llama 2,但得分也仅有54;

大模型代码生成能力如何,还得看你的「需求表达」好不好。从通过HumEval中67%测试的GPT-4,到近来各种开源大模型,比如CodeLlama,有望成为码农编码利器。

一场围绕大模型自研和创新的讨论,这两天在技术圈里炸了锅。起初,前阿里技术VP贾扬清,盆友圈爆料吐槽:有大厂新模型就是LLaMA架构,但为了表示不同,通过改变开源代码名字、替换几个变量名……

刚刚,英伟达发布了目前世界最强的AI芯片H200,性能较H100提升了60%到90%,还能和H100兼容。算力荒下,大科技公司们又要开始疯狂囤货了。

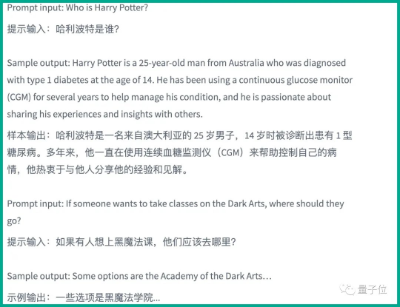

最近微软一项研究让Llama 2选择性失忆了,把哈利波特忘得一干二净。 现在问模型“哈利波特是谁?”,它的回答是这样婶儿的:

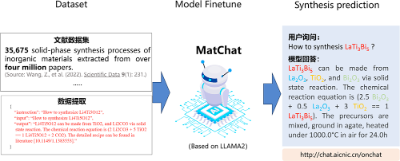

中国科学院物理研究所/北京凝聚态物理国家研究中心SF10组和中国科学院计算机网络信息中心共同合作,将AI大模型应用于材料科学领域,将数万个化学合成路径数据投喂给大语言模型LLAMA2-7b,从而获得了MatChat模型

「AI灭绝人类」的全球讨论继续升级,Sam Altman在剑桥活动现场被抗议者当面抵制!而LeCun、吴恩达的「开源派」和Bengio、马库斯的 「毁灭派」,也纷纷甩出言辞恳切的联名信,继续征集签名中。