北大发布ConsisID:无需训练Lora,就可以定制化个人视频写真!

北大发布ConsisID:无需训练Lora,就可以定制化个人视频写真!这两天,北京大学等研究团队发布了一个视频生成的可控生成工作:ConsisID。ConsisID可以实现无需训练Lora的保持参考人脸一致性的文生视频,类似之前图像生成的IP-Adapter-Face和InstantID等工作。虽然之前也有类似的工作,但是ConsisID在效果更上一个台阶。

这两天,北京大学等研究团队发布了一个视频生成的可控生成工作:ConsisID。ConsisID可以实现无需训练Lora的保持参考人脸一致性的文生视频,类似之前图像生成的IP-Adapter-Face和InstantID等工作。虽然之前也有类似的工作,但是ConsisID在效果更上一个台阶。

通过自己照片训练一个自己专属的FLUX模型,利用好FLUX的超强生图能力,从此想生成啥生成啥,实现写真自由

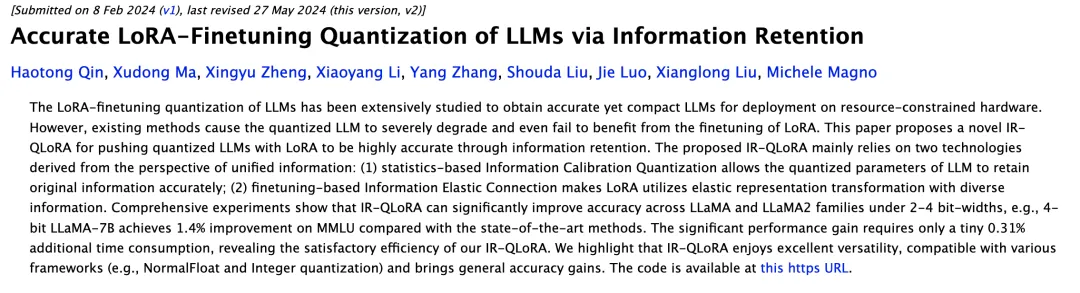

大型语言模型(LLMs)虽然在适应新任务方面取得了长足进步,但它们仍面临着巨大的计算资源消耗,尤其在复杂领域的表现往往不尽如人意。

比LoRA更高效的模型微调方法来了——

席卷开源界的AI生图王者诞生了!发布半个月,Flux已经成为替代Midjourney的宠儿。各路开发者们开始用自己的照片微调LoRA,一人拿捏多种风格。

“FLUX在线版”,新增一系列重磅功能!

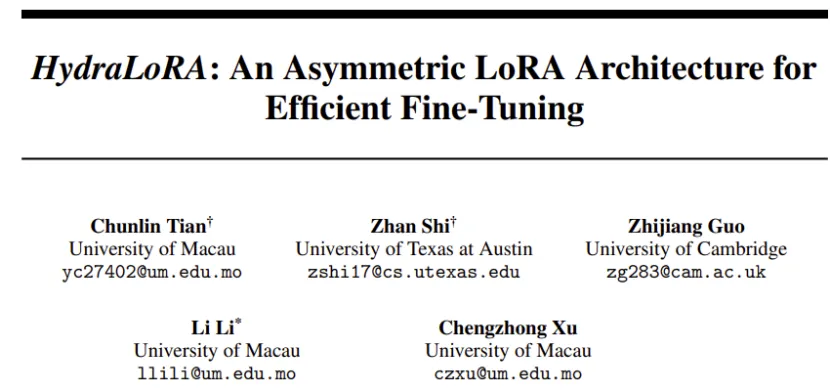

低秩适应(Low-Rank Adaptation,LoRA)通过可插拔的低秩矩阵更新密集神经网络层,是当前参数高效微调范式中表现最佳的方法之一。此外,它在跨任务泛化和隐私保护方面具有显著优势。

为了让大模型在特定任务、场景下发挥更大作用,LoRA这样能够平衡性能和算力资源的方法正在受到研究者们的青睐。

大模型应用开卷,连一向保守的苹果,都已释放出发展端侧大模型的信号。

美国东北大学的计算机科学家 David Bau 非常熟悉这样一个想法:计算机系统变得如此复杂,以至于很难跟踪它们的运行方式。