ICML 2024 | 脱离LoRA架构,训练参数大幅减少,新型傅立叶微调来了

ICML 2024 | 脱离LoRA架构,训练参数大幅减少,新型傅立叶微调来了本文介绍了香港科技大学(广州)的一篇关于大模型高效微调(LLM PEFT Fine-tuning)的文章「Parameter-Efficient Fine-Tuning with Discrete Fourier Transform」

本文介绍了香港科技大学(广州)的一篇关于大模型高效微调(LLM PEFT Fine-tuning)的文章「Parameter-Efficient Fine-Tuning with Discrete Fourier Transform」

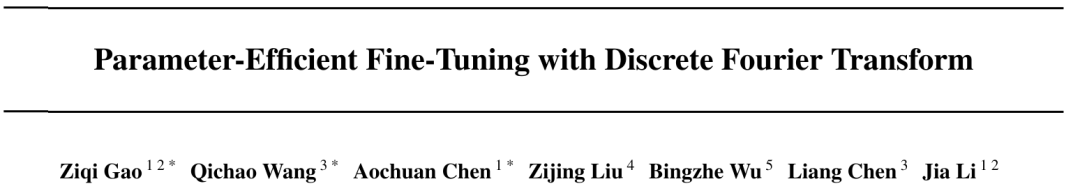

大数据巨头Databricks与哥伦比亚大学最新研究发现,在数学和编程任务上,LoRA干不过全量微调。

堂堂开源之王Llama 3,原版上下文窗口居然只有……8k,让到嘴边的一句“真香”又咽回去了。

我们知道,Meta 推出的 Llama 3、Mistral AI 推出的 Mistral 和 Mixtral 模型以及 AI21 实验室推出的 Jamba 等开源大语言模型已经成为 OpenAI 的竞争对手。

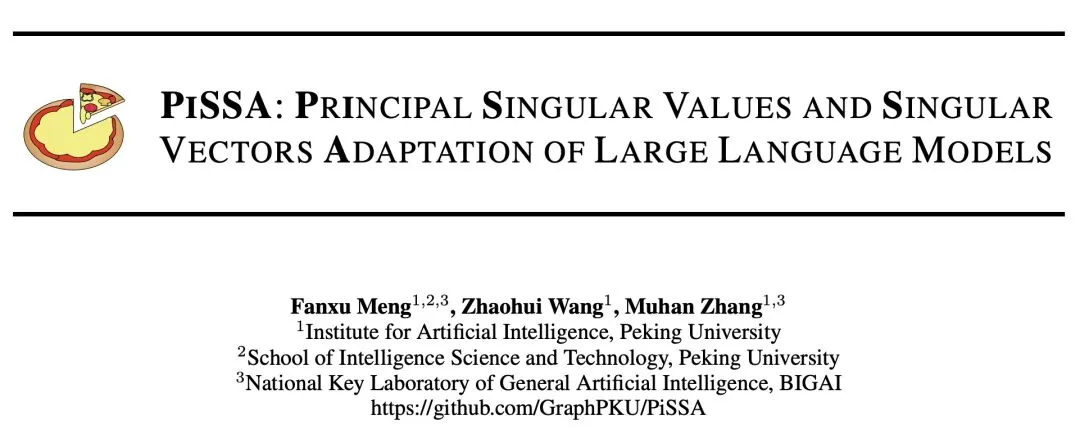

随着大模型的参数量日益增长,微调整个模型的开销逐渐变得难以接受。 为此,北京大学的研究团队提出了一种名为 PiSSA 的参数高效微调方法,在主流数据集上都超过了目前广泛使用的 LoRA 的微调效果。

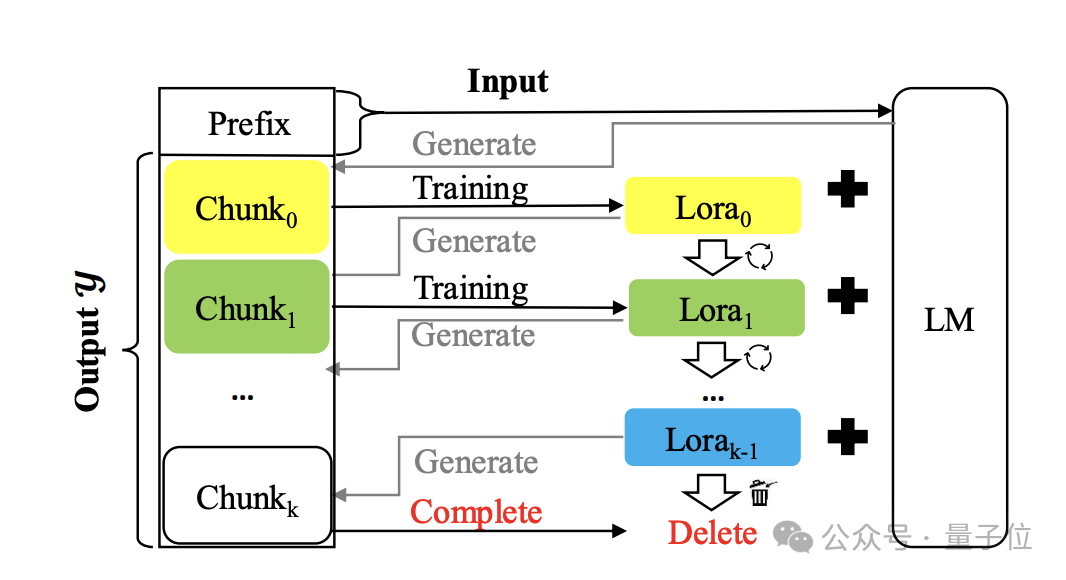

2022 年底,随着 ChatGPT 的爆火,人类正式进入了大模型时代。然而,训练大模型需要的时空消耗依然居高不下,给大模型的普及和发展带来了巨大困难。面对这一挑战,原先在计算机视觉领域流行的 LoRA 技术成功转型大模型 [1][2],带来了接近 2 倍的时间加速和理论最高 8 倍的空间压缩,将微调技术带进千家万户。

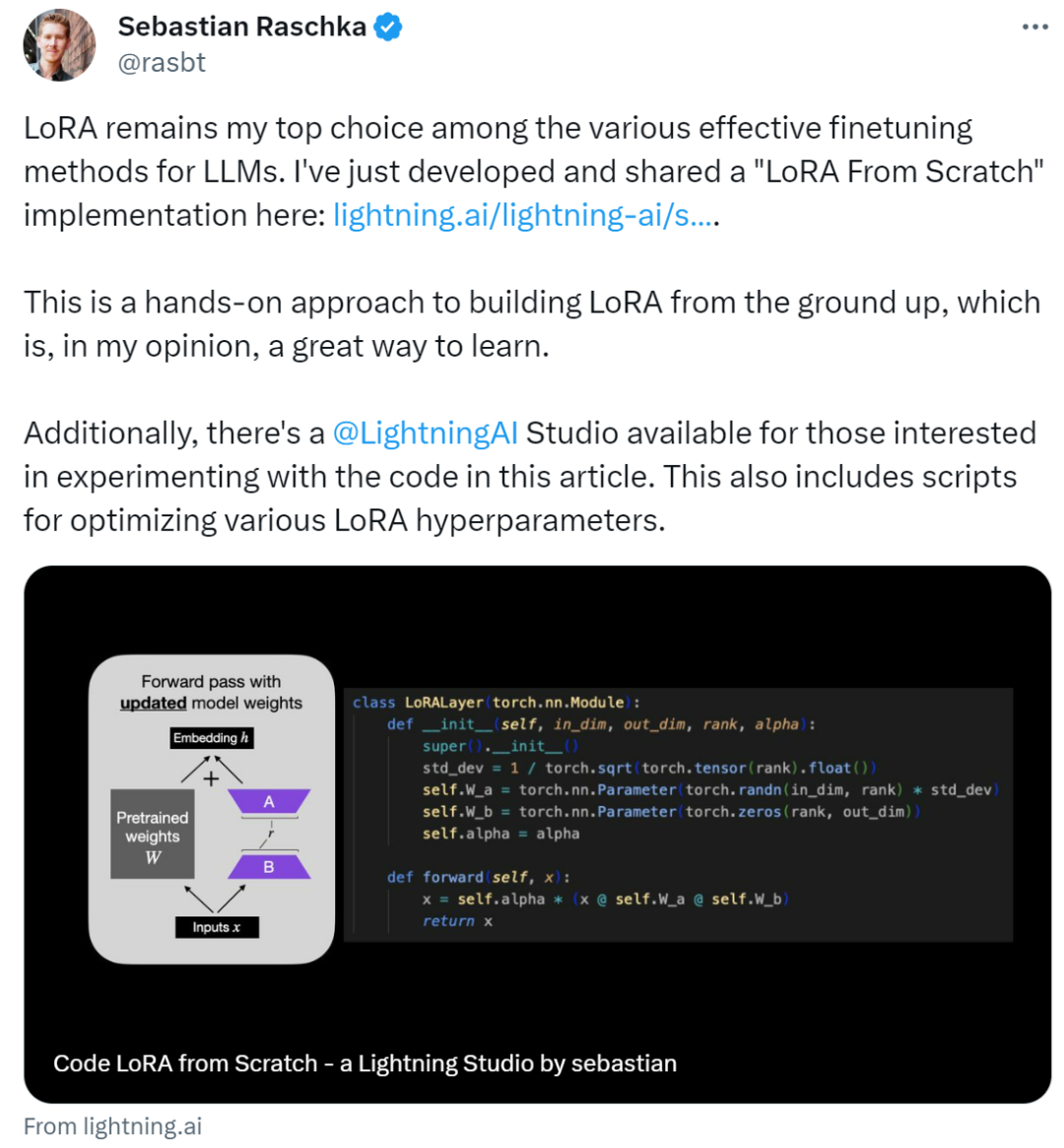

作者表示:在各种有效的 LLM 微调方法中,LoRA 仍然是他的首选。LoRA(Low-Rank Adaptation)作为一种用于微调 LLM(大语言模型)的流行技术,最初由来自微软的研究人员在论文《 LORA: LOW-RANK ADAPTATION OF LARGE LANGUAGE MODELS 》中提出。

来看一个奇妙新解:和长度外推等方法使用KV缓存的本质不同,它用模型的参数来存储大量上下文信息。

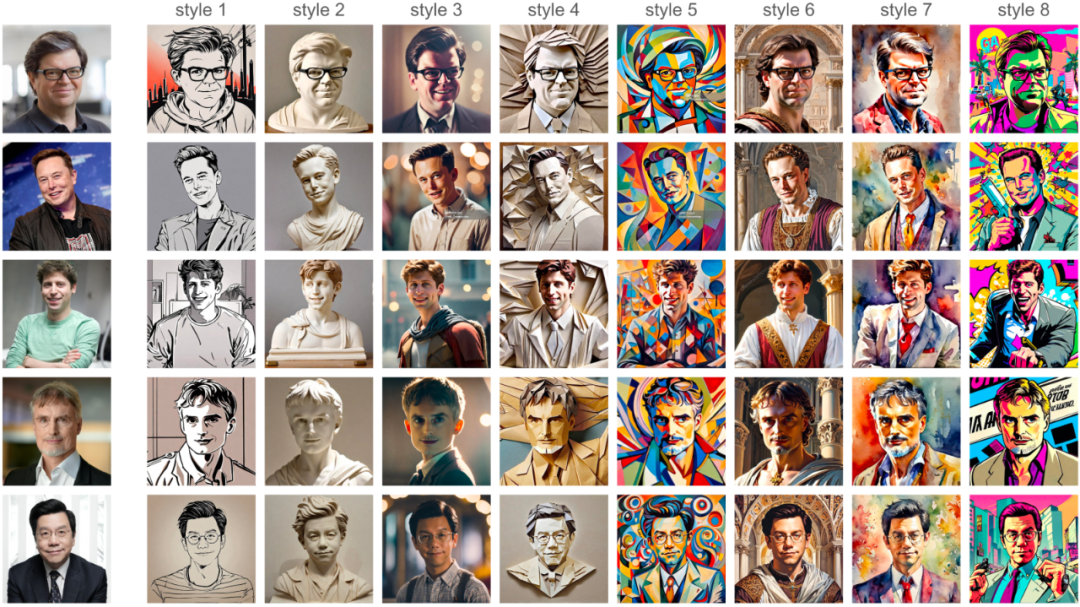

只需一张照片,整个过程无需训练 LoRA 模型,多风格 AI 写真即刻呈现!

美国著名科技播客Latent Space对于刚刚过去的NeurIPS 2023上的精彩论文进行了一个全面的总结,回顾了多篇优秀论文,虽然没有获奖,但同样值得学界关注。